RDN

- Residual Dense Network

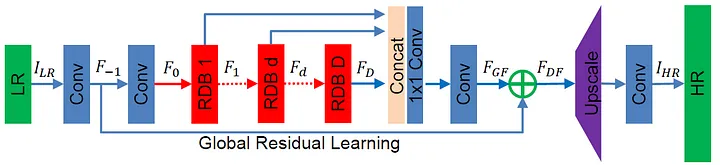

- 크게 네 파트로 구성되어있다.

1. shallow feature extraction net (SFENet)- residual dense blocks(RDBs)

- dense feature fusion (DFF)

- up-sampling net(UPNet)

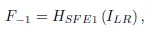

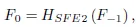

SFENet

-

Two Conv layer가 shallow features를 extract하는데 사용된다.

-

The first Conv layer로부터 LR input으로부터의 F-1을 extract

-

F-1은 shallow featrue extraction과 global residual learning에 사용된다. + second conv layer로부터 f0가 applied

RDBs

- D residual dense blocks를 갖고 있을 때 d깊이의 RDB의 output인 Fd가 얻어진다.

Contiguous Memory(CM)

- RDB contains dense connected layers, local feature fusion(LFF) and local residual learning

- activation function denotes ReLU

Local Feature Fusion(LFF)

- inspired by MemNet, 1x1 convolutional layer is introduced to output information

- 1x1 convolution layer는 크고 깊은 dense network에서 train을 쉽게 만든다.

Local Residual Learning(LRL)

- information flow를 improve하기 위해 RDB에서 제안된 개념

- LRL은 또한 network representation ability, resulting performance를 개선

DFF

- Fuses features which include global feature fusion and global residual learning. DFF는 preceding layers로부터 full use of features를 생성

Global Feature Fusion(GFF)

- GFF는 FGF를 RDBs로부터 extract

- 1x1 convolutional layer과 3x3 convolution으로 이루어진 HGFF

- 1x1 convolutional layer는 다른 level에서의 feature range에서 사용, 3x3 conv layer는 global residual learning을 위한 feature extraction에서 사용된다.

Global Residual Learning(GRL)

- GRL은 up-scaling 이전에 utilized to obtain feature-maps

- the other layers before Global feature fusion are fully utilized with the proposed RDBs

- RDBs는 multi-level local dense features를 제안

Up-Sampling Net(UPNet)

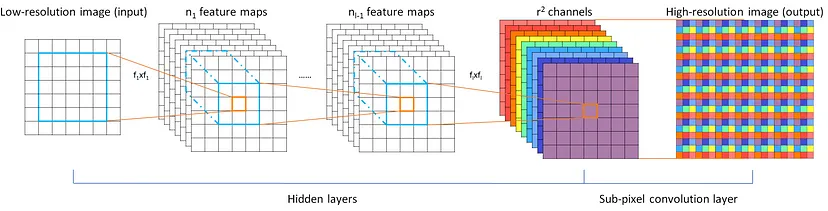

- ESPCN이 사용됨 ESPCN 논문 바로가기

- Efficient Sub-Pixel Convolutional Neural Network(ESPCN)

- L개의 layer가 있다고 가정할 때, l-1 layers input LR image는 flxfl convolution을 거쳐서 nl-1 feature maps을 생성

- last layer에서 efficient sub-pixel convolution이 HR image를 output으로 가져온다.

- Efficient Sub-Pixel Convolutional Neural Network(ESPCN)