Linear Regression

선형 회귀는 하나 이상의 독립 변수(입력 변수)와 종속 변수(결과 변수) 사이의 선형 관계를 모델링한다.

이러한 선형 회귀의 목적은 주어진 독립 변수의 값에 대해 <종속 변수의 값을 예측하거나, 변수 간의 관계를 이해하는 데 있다.

선형 회귀의 형태

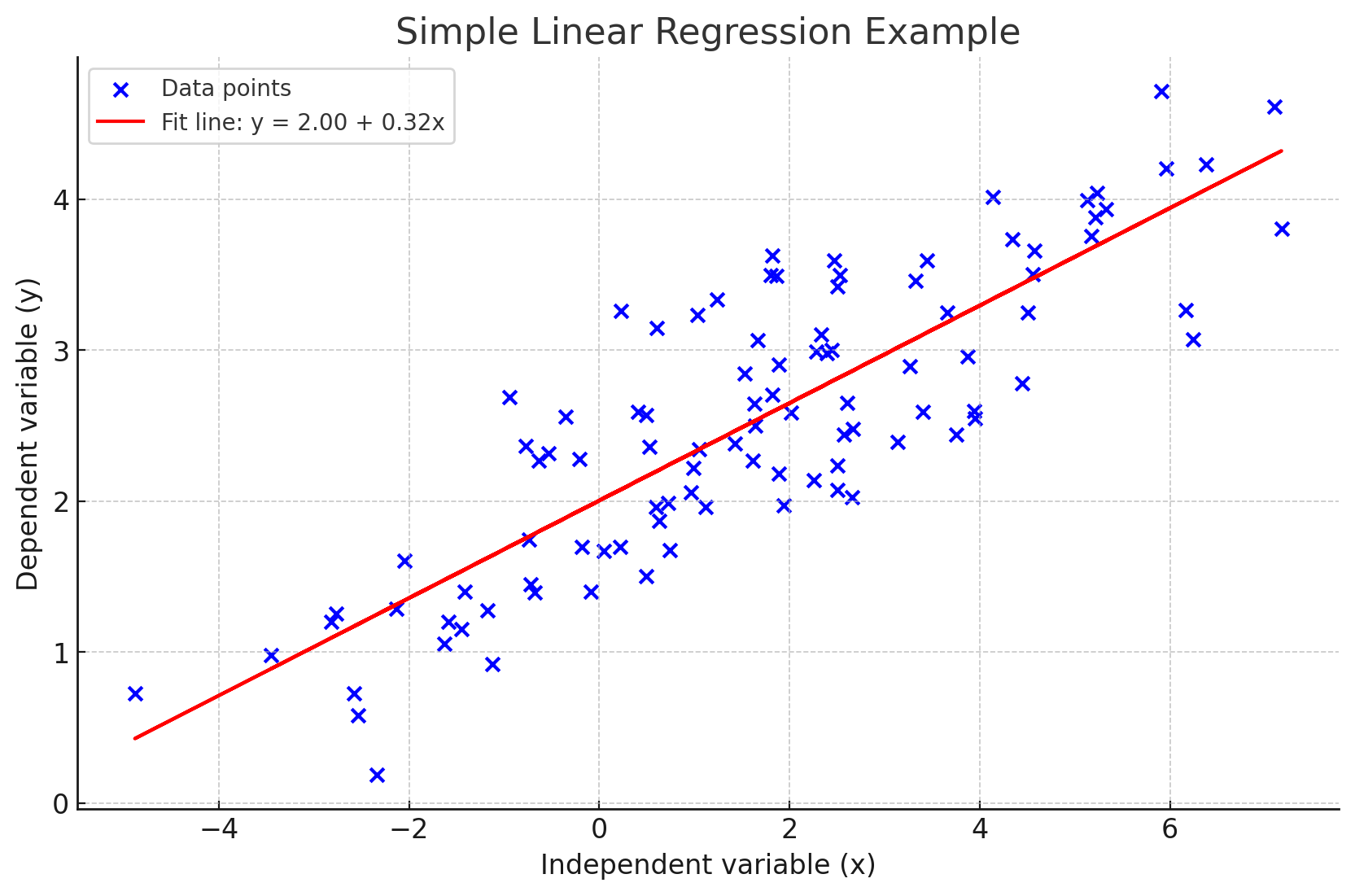

단순 선형 회귀 (Simple Linear Regression)

단순 선형 회귀는 한 개의 독립 변수(x)와 한 개의 종속 변수(y) 사이의 선형 관계를 분석/모델링 한다.

이 관계는 다음과 같은 수식을 갖는다.

는 bias(절편), 는 기울기(독립 변수의 영향력, 의 회귀 계수, 은 오차(error)항이다.

이 모델은 주로 독립 변수가 종속 변수에 미치는 직접적인 영향을 예측하는 데 사용된다.

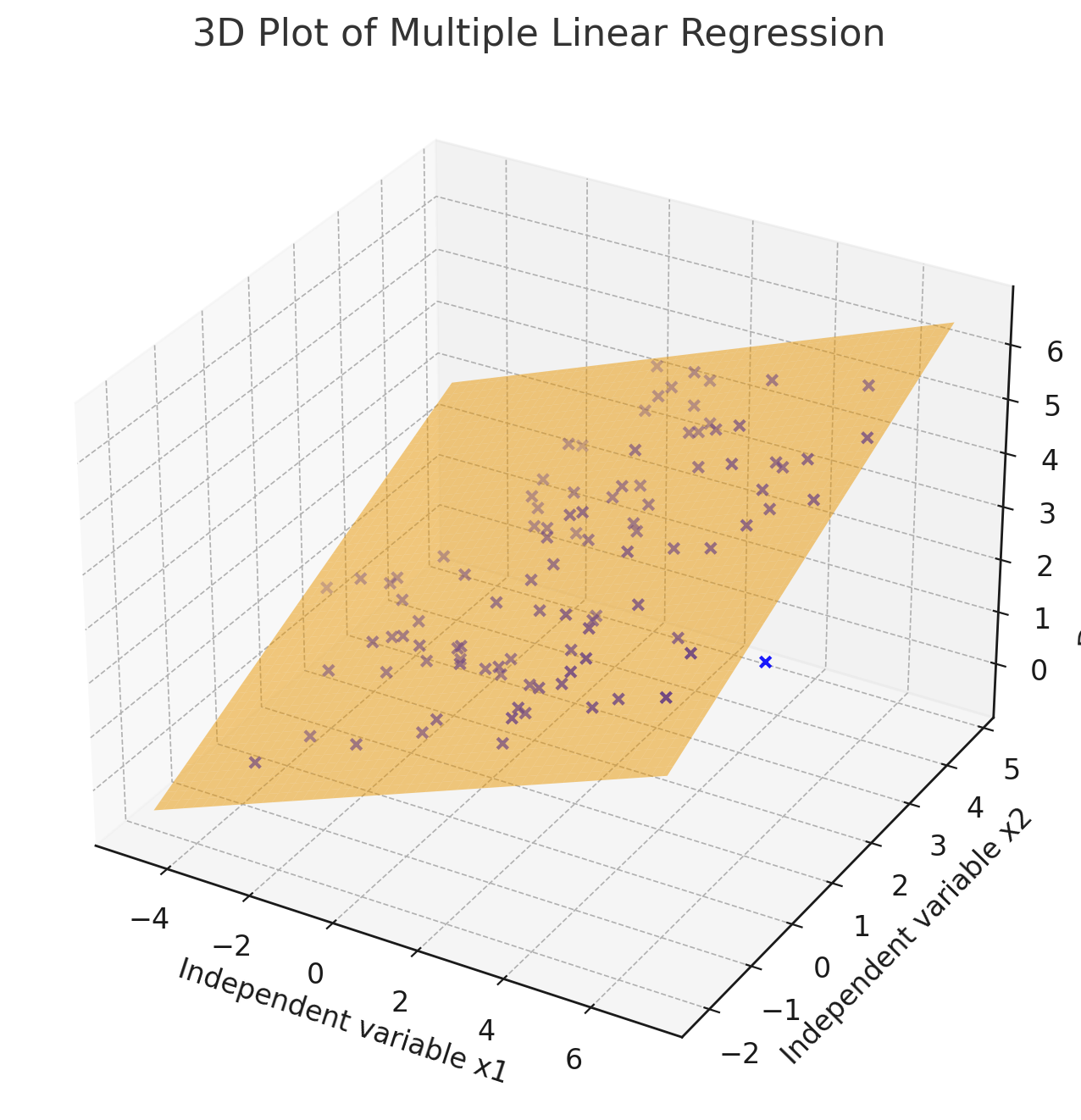

다중 선형 회귀 (Multiple Linear Regression)

다중 선형 회귀는 두 개 이상의 독립 변수를 사용하여 하나의 종속 변수를 예측하는 모델이다.

단순 선형 회귀를 확장한 형태로, 다음과 같은 수식을 갖는다.

이 모델은 복잡한 현실 세계의 데이터에서 여러 변수들이 어떻게 상호 작용하는지 이해하는 데 유용하다.

단변량 선형 회귀 (Univariate Linear Regression)

단변량 선형 회귀는 종속 변수가 하나인 선형 회귀 모델을 말한다.

이는 단순 선형 회귀와 다중 선형 회귀 모두를 포함할 수 있으며, 중요한 점은 하나의 모델이 하나의 종속 변수의 값을 예측하거나 설명한다는 것이다.

다변량 선형 회귀 (Multivariate Linear Regression)

다변량 선형 회귀는 두 개 이상의 종속 변수를 동시에 예측하기 위해 사용되는 모델로, 여러 개의 회귀 방정식으로 구성 된다.

이 모델은 각각의 종속 변수마다 하나의 방정식을 가지며, 각 방정식은 다수의 독립 변수들로 부터 영향을 받는다.

다변량 선형 회귀 모델의 일반적인 형태(수식)는 다음과 같다.

이러한 구조를 통해 다변량 선형 회귀는 복잡한 데이터 셋에서 여러 결과 변수(종속 변수)를 동시에 예측하고, 서로 다른 변수 간의 상호 작용을 이해하는데 유용하다.

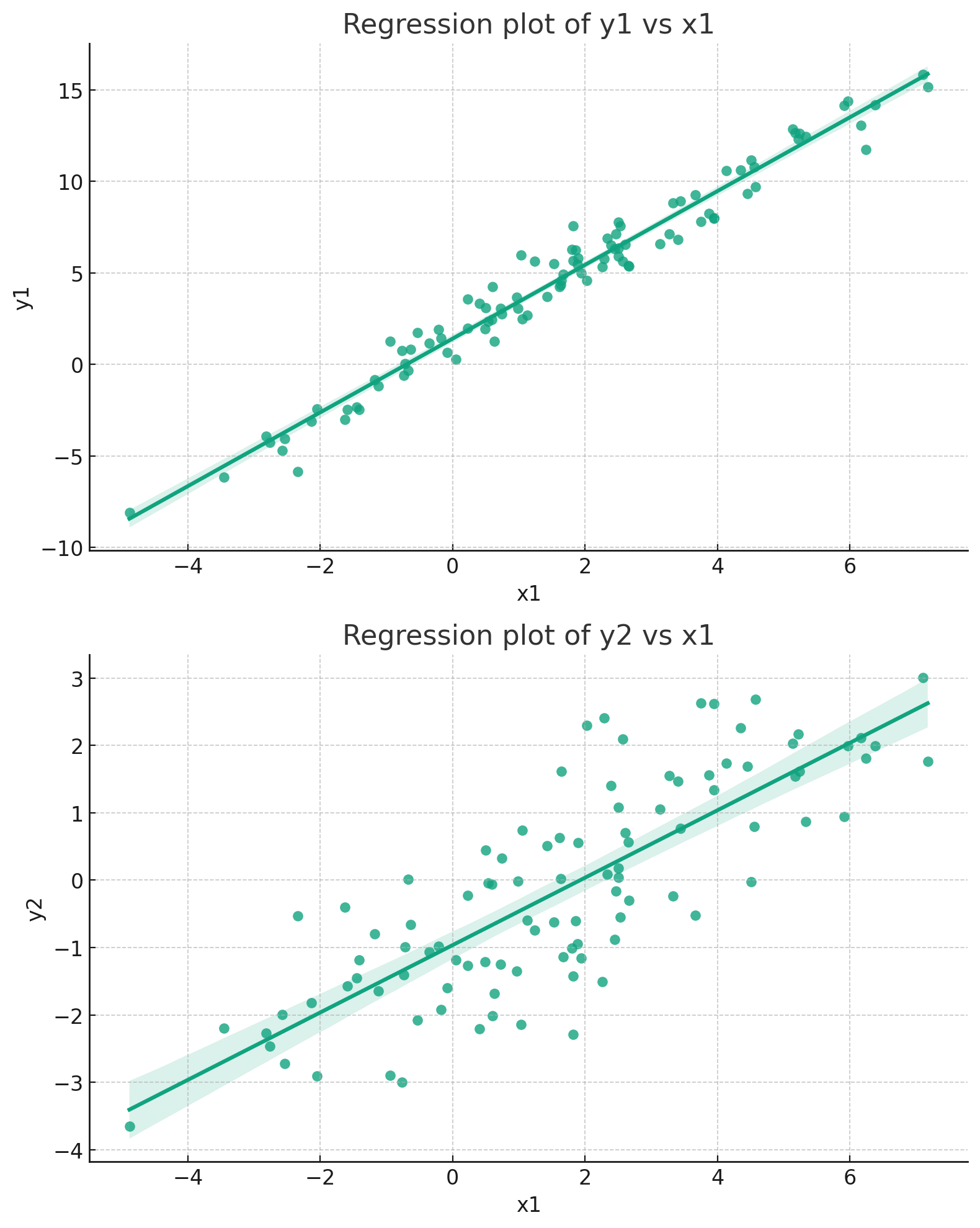

아래 예시는 한 개의 독립 변수 과 두 종속 변수 의 다변량 선형 회귀를 나타내는 그래프이다.

다변량 선형 회귀 모델은 두 개 이상의 종속 변수를 표현해야 하기 때문에, 한 평면에 표현하기가 복잡한 경향이 있다.

따라서 각 종속 변수에 대해 별도의 그래프를 생성하여, 해당 종속 변수와 모든 독립 변수 간의 관계를 표시한다.

개별 종속 변수 그래프에서 회귀선 주변의 음영은 회귀선의 신뢰 구간을 나타낸다.

이 음영은 데이터에 대한 회귀선의 불확실성을 표현하며, 일반적으로는 95% 신뢰 구간을 사용한다.

이는 회귀선이 실제로 위치할 가능성이 높은 구간을 시각적으로 보여준다.

즉, 이 음영 안에 실제 회귀선이 존재할 확률이 95%라는 의미이다.

데이터의 분산이 클 수록 음영이 넓어지며, 데이터가 회귀선을 잘 따르고 분산이 작을수록 음영이 좁아진다.

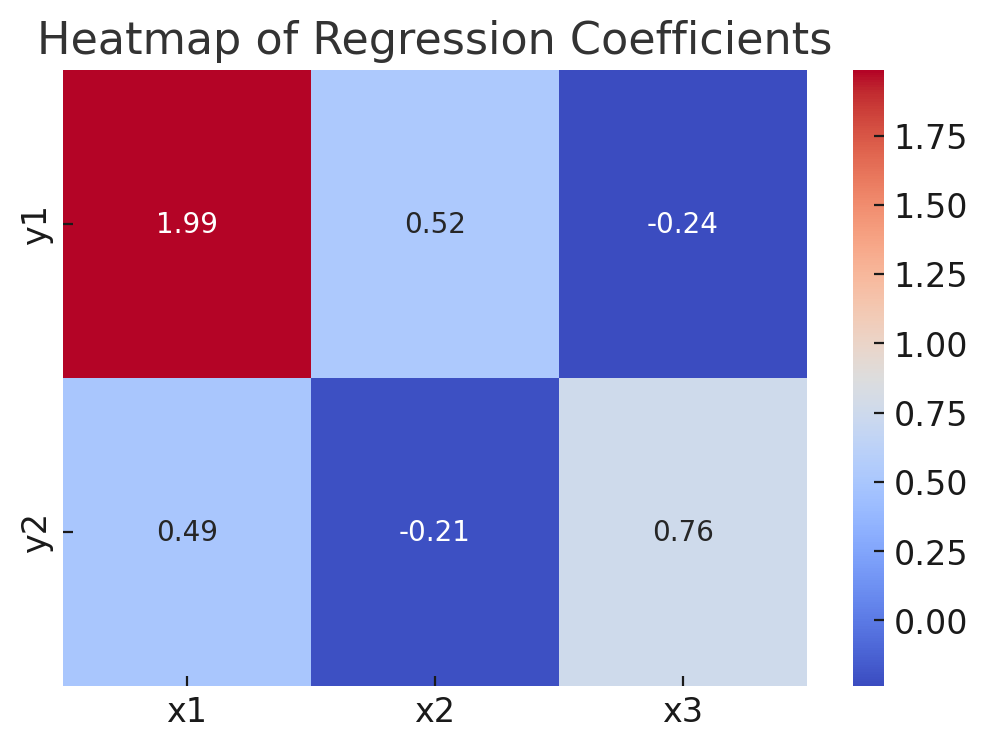

아래의 히트맵 예시는 세 개의 독립 변수 와 두 개의 종속 변수 간의 상관 계수를 나타낸다.

Regularization

회귀 모델에서 정규화(regularization) 는 overfitting(과적합)을 방지하고, 모델의 일반화 성능 향상을 위해 사용되는 기법이다.

fyi.

Overfitting(과적합) 은 모델이 훈련 데이터에 지나치게 잘 맞춰져 있어 새로운 데이터에 대한 예측 성능이 좋지 않은 현상을 말한다.

반대되는 개념으로 Underfitting(과소적합)이 있다.

이는 모델이 훈련 데이터의 패턴이나 구조를 충분히 학습하지 못해 데이터의 본질적인 관계를 반영하지 못하는 현상을 의미한다.

정규화에서는 모델의 복잡성에 대해 페널티를 부과하여 과적합을 방지한다.

모델의 복잡성의 페널티를 부과하는 방법 중 Ridge와 Lasso에 대해 알아보자.

Ridge Regression (L2 Regularization)

릿지 회귀는 선형 회귀의 일종으로, 과적합을 방지하기 위해 L2 정규화를 추가한 모델이다.

특히 이 방법은 독립 변수가 많거나, 일부 변수들이 강하게 상관관계를 가질 때 유용하다.

릿지 회귀는 회귀 계수의 크기를 축소하여 모델의 복잡성을 줄이고, 더 일반화된 모델을 만드는 데 도움을 준다.

기본 원리

릿지 회귀의 기본 아이디어는 회귀 계수의 제곱합에 페널티를 부여하여 계수 값을 감소시키는 것이다.

이 페널티 항은 모델의 복잡성을 줄이며, 데이터의 노이즈에 대한 민감도를 줄인다. (일반화 성능을 높인다는 얘기)

수학적 표현 (objective function / loss function)

- 는 잔차 제곱합(Residual Sum of Squares, RSS)으로, 모델의 오차를 나타낸다.

- 는 정규화 정도를 조절하는 하이퍼 파라미터로, 값에 따라 정규화 정도가 달라진다.

- 값이 크면, 로스 함수 내에서 정규화 영향이 커지고 계수의 크기가 크게 감소한다.

- 값이 작으면, 정규화 영향이 작아지고 계수의 크기가 작게 감소한다. - 는 회귀 계수의 제곱합으로, 정규화 항이다.

하이퍼 파라미터

릿지 회귀에서 는 매우 중요한 역할을 한다. 가 0에 가까우면 릿지 회귀는 일반 선형 회귀와 동일해지며,

가 매우 크면 모든 계수가 거의 0에 수렴하여 데이터의 변동을 설명하지 못하게 된다.

따라서 적절한 값을 선택하는 것이 중요하며, 이는 주로 교차 검증을 통해 최적화 한다.

장점

- 회귀 모델의 과적합 방지

- 회귀 모델의 일반화 성능 향상

- 변수간 상관관계가 높은 경우에도, 안정적인 계수 추정

단점

- 값의 설정 필요성과 이로 인한 추가 계산 필요

- 모든 변수를 사용하므로, 효율성이 떨어질 수 있음

Lasso Regression (L1 Regularization)

라쏘 회귀도 선형 회귀의 일종으로, 과적합을 방지하고 모델을 단순화 하기 위해 사용되는 정규화 기법이다.

"LASSO"는 "Least Absolute Shrinkage and Selection Operator"의 약자로, 하이퍼 파라미터를 사용하여 회귀 계수를 축소하는 것이 핵심이다.

기본 원리

라쏘 회귀의 기본 원리는 회귀 계수의 절대값을 페널티로 추가함으로써, 일부 회귀 계수를 정확히 0으로 만드는 것이다.

이 접근 방식은 불필요하거나 중요하지 않은 특성(독립 변수)의 계수를 제거함으로써 모델을 단순화하고, 결과적으로 더 나은 일반화 성능을 낸다.

수학적 표현 (objective function / loss function)

전체적인 식의 구조는 릿지와 비슷하지만 정규화 항이 로 회귀 계수의 절대값을 나타낸다.

하이퍼 파라미터

라쏘 회귀에서도 는 매우 중요한 하이퍼 파라미터로, 그 값에 따라 모델의 복잡성과 과적합 경향성이 달라진다.

릿지와 마찬가지로 가 0에 가까울수록 일반 선형 회귀와 같아지며, 가 매우 크면 많은 회귀 계수들이 0으로 수렴하여 모델이 너무 단순해질 수 있다. 따라서 교차 검증을 통한 적절한 값 선정이 중요하다.

장점

- 자동 변수 선택을 통핸 모델의 일반화 성능 향상

- 과적합 방지

- 모델 해석이 용이 (중요한 속성만 포함하고 있음)

단점

- 하이퍼 파라미터 에 의존하는 경향

- 그룹 효과 무시 (서로 관련 있는 변수가 있을 경우, 하나만 선택 후 나머지는 무시)

- 비선형 관계 처리 부족 (기본적으로 선형 관계를 모델링)