LLM

1.[paper-review] Language Models are Few-Shot Learners

GPT-3에 관한 논문이며"Few-shot"이 왜 중요한지에 대해 얘기한다수많은 라벨링 데이터가 필요하다Fine-tuning 과정에서 일반화가 불가능하다사람과의 능력 차이가 많이 난다Zero, One, Few-shot (In-context learning)추가적으로 모

2.[paper-review] Language Models as Zero-Shot Planners: Extracting Actionable Knowledge for Embodied Agents

Pre-Trained Causal LLM으로 Zero-shot 플래닝플래닝한 결과로 Pre-Trained Masked LLM에 넣고 적절한 동작 생성해당 동작을 Prompt에 추가하고 단계별로 Autoregressive 생성읽으면서 특이하다고 생각한 점이 있다.Acti

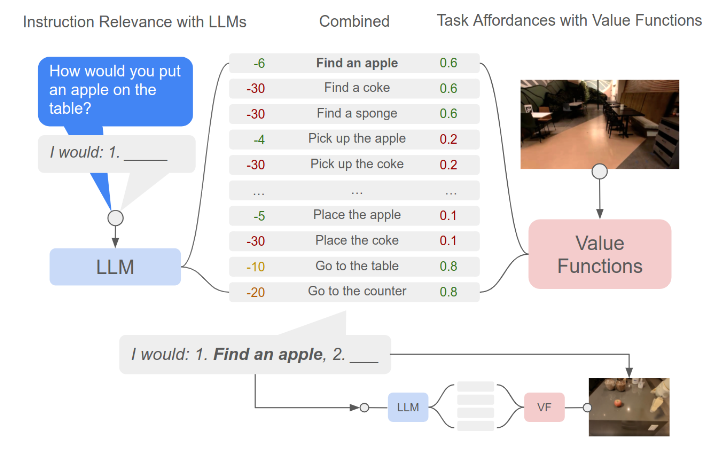

3.[paper-review] Do As I Can, Not As I Say : Grounding Language in Robotic Affordances

로봇이 손과 눈 역할을 하고 언어 모델이 높은 수준의 지식을 제공하는 아이디어즉, 로봇에게 사람과 같은 추론 능력을 부여하자Q) "어떻게 LLM을 물리적 Task 해결에 사용할 수 있을까?"A) LLM에서 High-level 지식을 이끌어내는 연구구현하기 위해서 지시

4.[paper-review] Code as Polices : Language Model Programs for Embodied Control

자연어 명령에 따라 로봇 행동에 맞는 코드를 생성주요 접근법은 계층적 코드 생성이다. (정의되지 않은 함수를 재귀적으로 정의)"기존에는 어휘 분석으로 의미론적 표현을 추출하거나 end-to-end로 학습하려 했지만.. 현실적 한계"Code-Writing LLM을 활

5.[paper-review] Inner Monologue : Embodied Reasoning through Planning with Language Models

Inner Monologue내적 독백이라는 말인데 이를 통해 환경(상황) 피드백을 진행한다.이전 논문들에서 환경에 대한 정보를 활용한 것은 없었다. (내가 읽은 논문에서)성공 여부, 장면 설명 등을 정보로 활용 즉, 사람들이 문제를 해결할 때 내적으로 단계적 해결법을

6.[paper-review] Open-Vocabulary Queryable Scene Representations for Real World Planning

주변 장면에 대한 인지 부족으로 인해 제대로 된 추론을 못하는 단점 \-> 해당 논문에서는 NLMap을 활용하여 이를 해결NLMap 먼저 VLM으로 장면 표현을 한다LLM 모듈에서는 지시문 분석을 하는 과정을 거친다 ※ 이때 의미론적 이해가 중요 => CLIP 모델이

7.[paper-review] Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

주요 아이디어LLM 출력 생성 시, Reasoning 과정을 같이 입력하면 결과가 좋다모델 사이즈를 키우는 것은 수학, 상식, Reasoning에서 상승 X큰 학습 데이터 없이 많은 Task를 수행할 수 있는 프롬프팅 접근목표LM에게 CoT 같은 능력을 부여CoT의 예

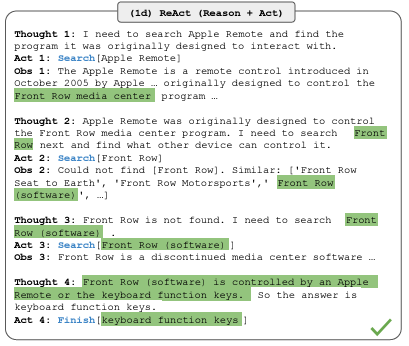

8.[paper-review] ReAct: Synergizing Reasoning and Acting in Language Models

LLM으로 추론, 구체적인 Task 행동들의 시너지를 높이는 방법추론 : Task 계획을 유도하고 예외처리하는데 도움Action : 추가 외부 정보를 수집하거나 다룰 수 있다문제 상황CoT는 내부적으로 사용하고 외부 환경에 대한 정보를 못 다룬다→ 블랙 박스 → 반응적

9.[paper-review] Least-to-Most Prompting enables complex reasoning in LLM

CoT는 제공된 예시 프롬프트보다 더 어려운 Task는 잘 못한다핵심 아이디어복잡한 Task를 간단한 하위 Task로 분해하여 해결복잡한 Task를 하위 Task로 분해순차적으로 하위 Task를 해결→ Few-shot prompting으로분해 : 분해할 특정 질문, 분

10.[paper-review] CLARA: Classifying and Disambiguating Users Commands for Reliable Interactive Robotic Agents

Interactive system 신뢰를 높이기 위해선 상황 인지 능력 필요상황, 장소 등 환경에 따라 다양한 의미를 가질 수 있기 때문이다목표모호한 명령에 대해서 LLM이랑 질문을 주고 받으며 사용자 명령이 명확한지, 모호한지, 실행 불가능한지 추론하는 것주요 타겟

11.[paper-review] Robots That Ask For Help: Uncertainty Alignment for Large Language Model Planners

Uncertainty정확하게 모델링, 계산하는 것은 오랫동안 해오던 과제→ 이를 '언어'로 해결해보고자 한다→ LLM을 사용하면 다양한 장점이 있지만 '환각'에 대한 문제가 있다 → 심지어 현실에서는 사람들의 말에 '모호함'도 많아서 이해를 잘 못할 수 있다방향성tas