Imbalanced Data

데이터의 불균형은 머신러닝과 딥러닝에서 해결해야 할 주요 문제로, 모델 성능의 저하를 방지하기 위한 다양한 접근 방법이 연구되었다. 주요해결방안과, 논문들에 대해서 알아보고자 한다.

해결 방안

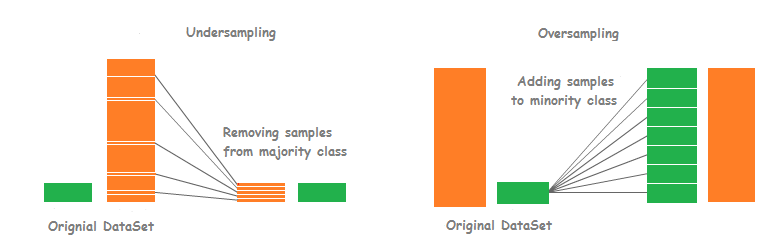

해결 방안은, 리샘플링방법으로 오버샘플링과 언더샘플링 방법이 있다. 오버새플링은 Major data만큼 Minor data를 증가시키는 것이고, 언더샘플링은 이와 반대로 Minor data에 Major data를 맞춰 감소시키는 것이다.

| 소수 집단에 속하는 데이터의 비율 | 불균형의 정도 |

|---|---|

| 데이터 세트의 20~40% | 약간 |

| 데이터 세트의 1~20% | 보통 |

| 데이터 세트의 1% 미만 | 익스트림 |

오버샘플링 기법

SMOTE (Synthetic Minority Oversampling Technique):

소수 클래스 데이터를 기존 데이터 포인트와 가까운 샘플 간 보간(interpolation)을 통해 새 샘플을 생성한다. 이는 소수 클래스의 데이터를 증가시키며 데이터 분포를 개선한다.

ADASYN (Adaptive Synthetic Sampling):

SMOTE와 유사하지만, 소수 클래스 중 학습이 어려운 데이터에 더 많은 샘플을 생성하여 효과적인 학습을 유도한다.

언더샘플링 기법

다수 클래스 데이터를 줄이는 방식으로, 대표적으로 Tomek Links와 Cluster Centroids가 사용된다. 이는 데이터 크기를 줄여 계산 효율성을 높이지만, 정보 손실 가능성이 있다.

혼합 기법

SMOTE-Tomek:

SMOTE로 소수 클래스를 증폭한 후, Tomek Links를 이용해 다수 클래스 중 결정 경계를 모호하게 만드는 데이터를 제거하여 데이터 균형을 맞춘다.

앙상블 기법

Under-Sampling 기반 앙상블 SVM:

데이터를 여러 하위 샘플로 나누어 각각의 모델을 학습시킨 뒤 결과를 결합한다. 이는 소수 클래스의 높은 예측 성능을 유지하면서 불균형 문제를 해결한다.

모델 기반 접근

LightGBM:

이 모델은 데이터 불균형에 대해 민감한 튜닝이 가능하며, 리프 와이즈 분할(leaf-wise)을 통해 작은 데이터셋에서도 높은 성능을 보인다.

추천 논문

"SMOTE: Synthetic Minority Over-sampling Technique" (Chawla et al., 2002)

- SMOTE 알고리즘의 기본 아이디어와 효과를 제시함.

"ADASYN: Adaptive Synthetic Sampling Approach for Imbalanced Learning" (He et al., 2008) - ADASYN 기법을 제안하며 SMOTE와의 차별점을 논의함.

Reference

[1] https://developers.google.com/machine-learning/crash-course/overfitting/imbalanced-datasets?hl=ko