Why?

신경망모델의 각 layer에서는 input 값과 W, b를 곱, 합연산을 통해 a=WX+b를 계산하고 마지막에 활성화 함수를 거쳐 f(a)를 출력한다. 이렇게 각 layer마다 sigmoid, softmax, relu 등.. 여러 활성화 함수를 이용하는데 그 이유가 뭘까?

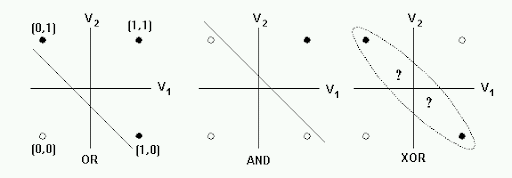

선형분류기의 한계

기존의 퍼셉트론은 AND와 OR 문제를 해결할 수 있지만 선형 분류기라는 XOR과 같은 non-linear한 문제를 해결할 수 없었다. 이를 해결하기 위해 hidden layer가 등장했지만 선형 분류기가 비선형 분류기로 바꿀 수 있는 것은 아니다. 즉, linear한 연산을 갖는 layer를 수십개 쌓아도 결국 이는 하나의 linear 연산으로 나타낼 수 있다.

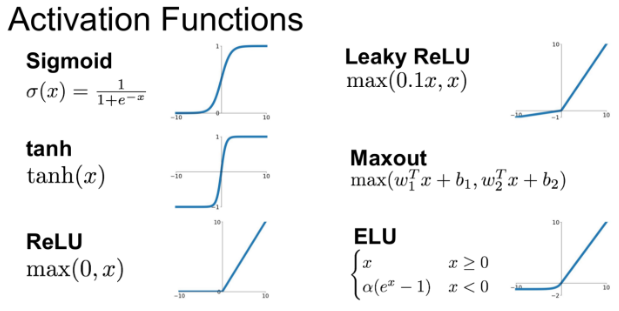

활성화 함수 (Activation function)

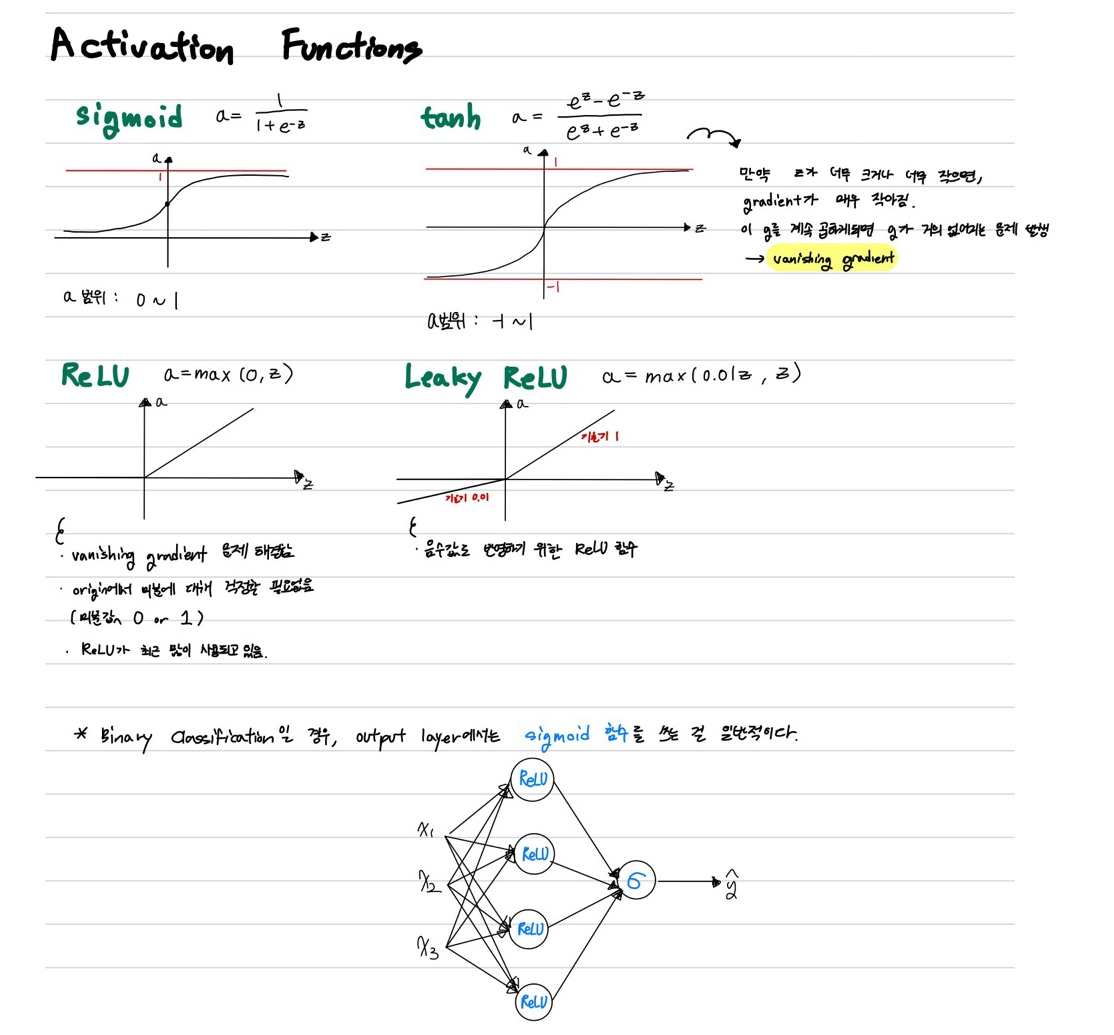

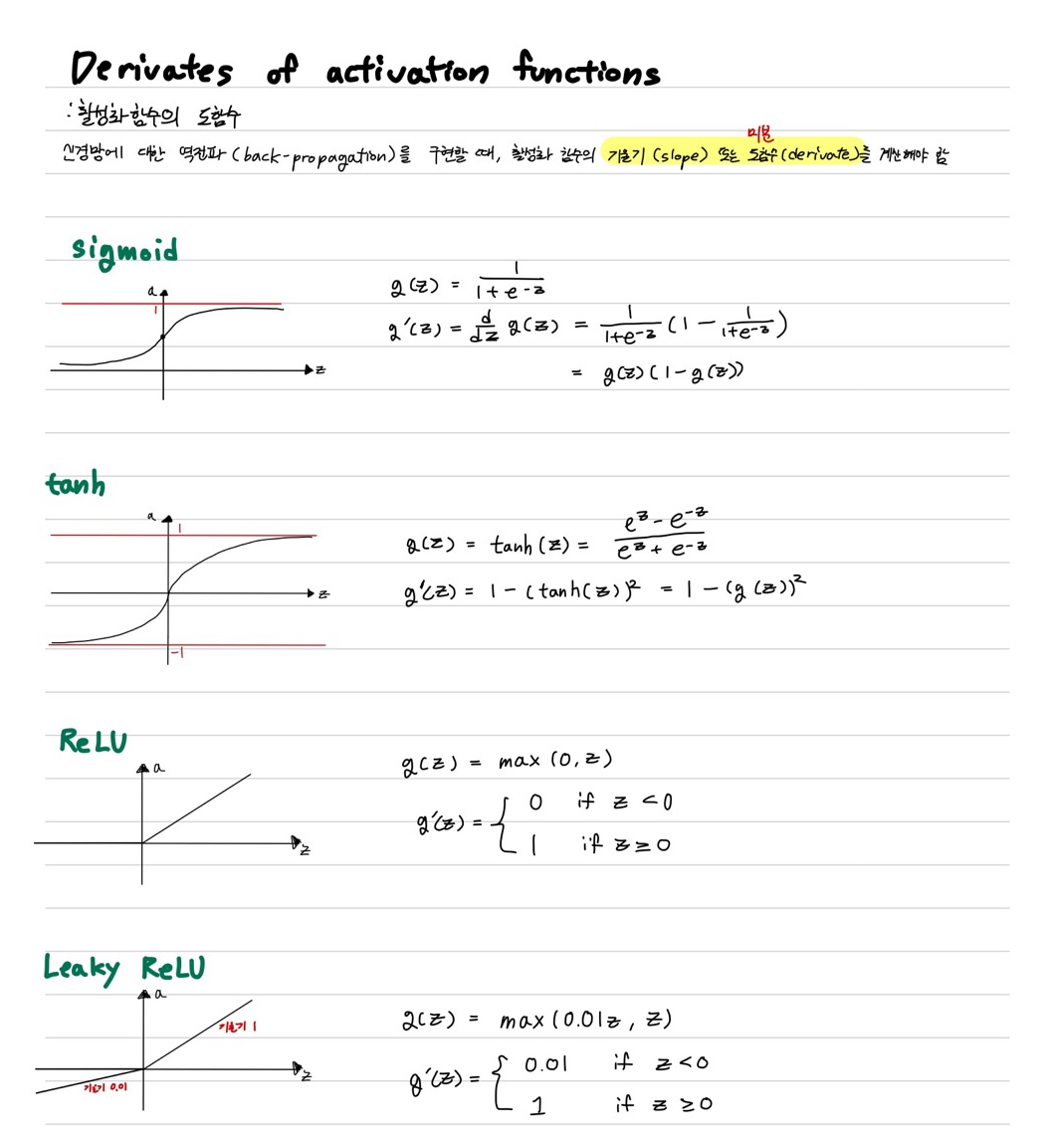

이에 대한 해결책이 활성화 함수이다. 활성화 함수를 사용하면 입력값에 대한 출력값이 linear하게 나오지 않으므로 선형 분류기를 비선형 분류기로 만들 수 있다. 다층 신경망은 단지 linear layer를 수십개 쌓는 게 아니라 활성화 함수를 이용한 non-linear 시스템을 여러 layer로 쌓는 개념이다. 결과적으로, 활성화 함수는 입력값을 non-linear한 방식으로 출력값을 도출하기 위해 사용한다.

✔ Goodnote 정리