Kullback–Leibler Divergence (KLD)는 두 확률분포의 차이를 계산하는 데에 사용하는 함수로, 한 분포를 근사하는 다른 분포를 사용해 샘플링을 한다면 발생할 수 있는 정보 엔트로피 차이를 계산한다. KLD는 비대칭으로, 두 값의 위치를 바꾸면 함수값도 달라진다.

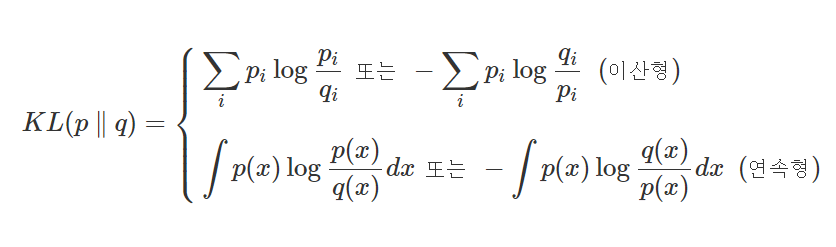

KLD의 식은 위와 같다. p, q는 두 확률분포의 확률 밀도 함수를 의미한다.

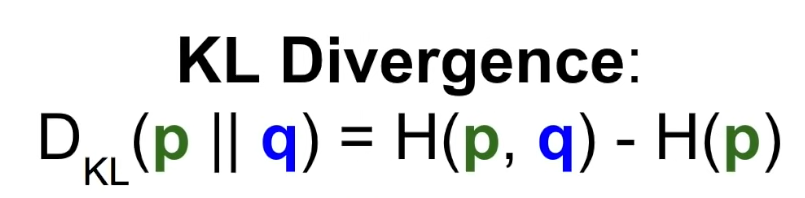

간단하게 KLD는 Cross-entropy Entropy이다.

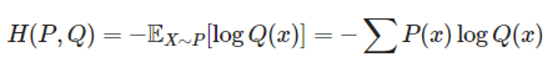

Cross-entropy

실제 확률 분포 (실제 데이터 Label)

모델이 예측한 확률 분포 (Softmax Probability)