일반적으로 엔트로피는 불확실성을 가르킨다. 확률이 낮을수록, 어떤 정보일지 불확실하다. 이때, ‘정보가 많다’, ‘엔트로피가 높다’라고 표현할 수 있다. 정보를 더 많이 알수록 새롭게 알 수 있는 정보는 적다. 반대로 사건이 불확실하다면, 그 사건이 일어났을 때 더 유용한 정보를 제공한다. 다시 말해, 정보량은 확률에 반비례한다. 예를 들어, 주사위 던지기가 동전 던지기보다 엔트로피가 더 크다고 할 수 있다.

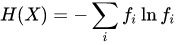

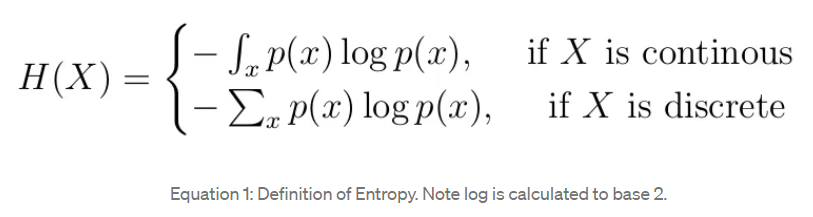

정보는 발생 가능한 사건의 확률분포의 음의 로그로 정의할 수 있다.

또한, 엔트로피를 정보를 표현하는데 필요한 최소 평균 자원량으로 볼 수 있다. 모든 정보는 비트(0/1)로 표현할 수 있다고 할 시, 확률이 높은 것에 적은 자원을 사용하고 확률이 낮은 것에 더 많은 비트를 사용해 표현하도록 할 수 있다. 비트 단위로 계산하므로 위의 식에서 를 사용해 표현한다.