학습 목표

후기

학습 내용

26. 활성화 함수의 이해

26.1. 활성화 함수

# 활성화 함수

노드에 입력으로 들어오는 값이 어떤 '임계치'를 넘어가면 "활성화(activated)"

- 들어온 신호가 특정 임계점을 넘으면 출력을 하고, 넘지 못하면 무시

- 딥러닝 모델의 표현력을 향상시킴

(표현력: representation capacity 또는 expressivity) - 신호를 '전달' 해주기 때문에 Transfer function이라고도 부름

- 표현에 따라 두 가지로 나뉨

- 선형 활성화 함수(Linear activation function)

- 비선형 활성화 함수(Non-linear activation function)

26.2. 퍼셉트론

여러 개의 층으로 이루어진 딥러닝 모델에서 하나의 층을 가져와 다시 쪼갠다면 보통 '노드'라고 불리는 것으로 쪼개지게 되는데, 이것이 바로 퍼셉트론(Perceptron)

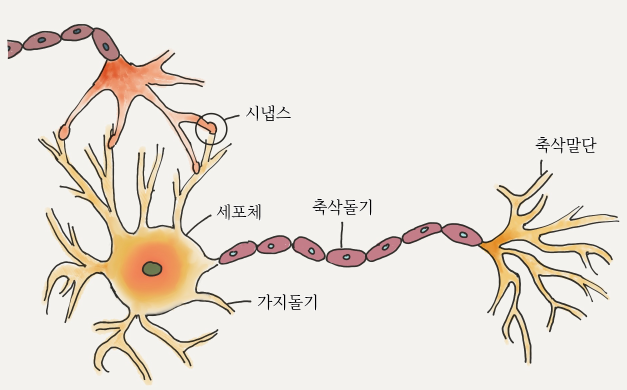

# 신경세포의 구조

- 신경세포(Nueron)

- 세포체(Soma), 가지돌기(Dendrite), 축삭돌기(Axon), 시냅스(Synapse)로 구성

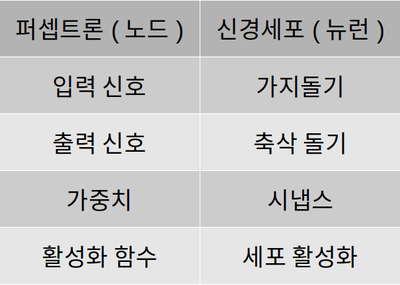

# 퍼셉트론의 구조

- 퍼셉트론과 신경세포의 비교

요즘 사용되는 퍼셉트론의 구조는 처음 발표된 것과 좀 달라졌지만 이름은 '퍼셉트론' 그대로 사용하고 있습니다.

26.3. 선형과 비선형

# 선형

- 선형 변환(linear transformation)

- '선형'이라는 규칙을 지키며 VV 공간상의 벡터를 WW 공간상의 벡터로 바꿔주는 역할

# 비선형

- 간히 말해, 선형이 아닌 함수

- 비선형 함수를 쓰는 이유

- 딥러닝 모델의 표현력을 향상시키기 위해

비선형 함수를 쓰는 이유

그렇다면..(비선형 함수를 쓴다면?)

활성화 함수의 종류

이진 계단 함수

이진 계단 함수의 한계

선형 활성화 함수

선형 활성화 함수의 한계

비선형 활성화 함수

시그모이드/로지스틱

하이퍼볼릭 탄젠트

ReLU

ReLU의 단점을 극복하기 위한 시도들