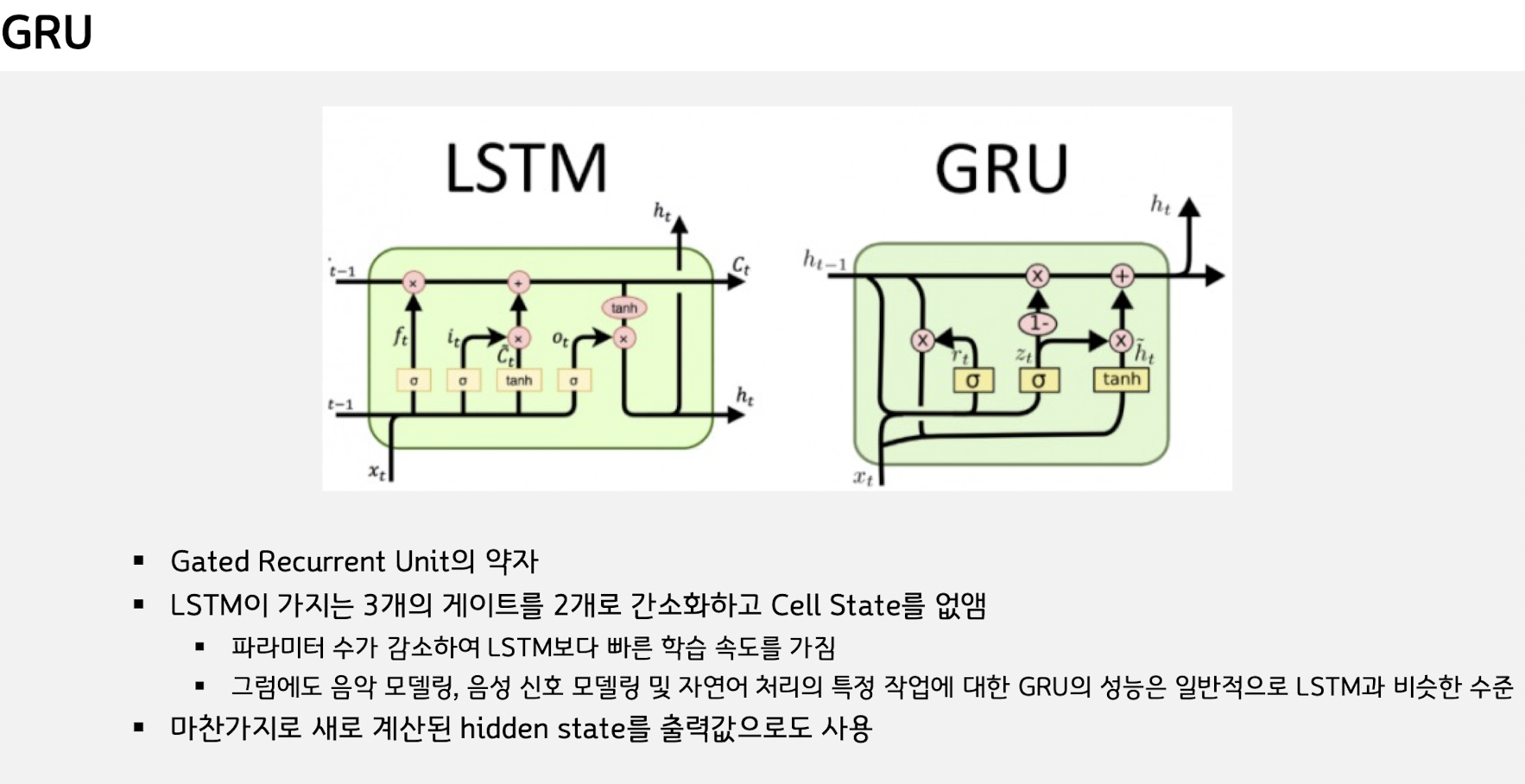

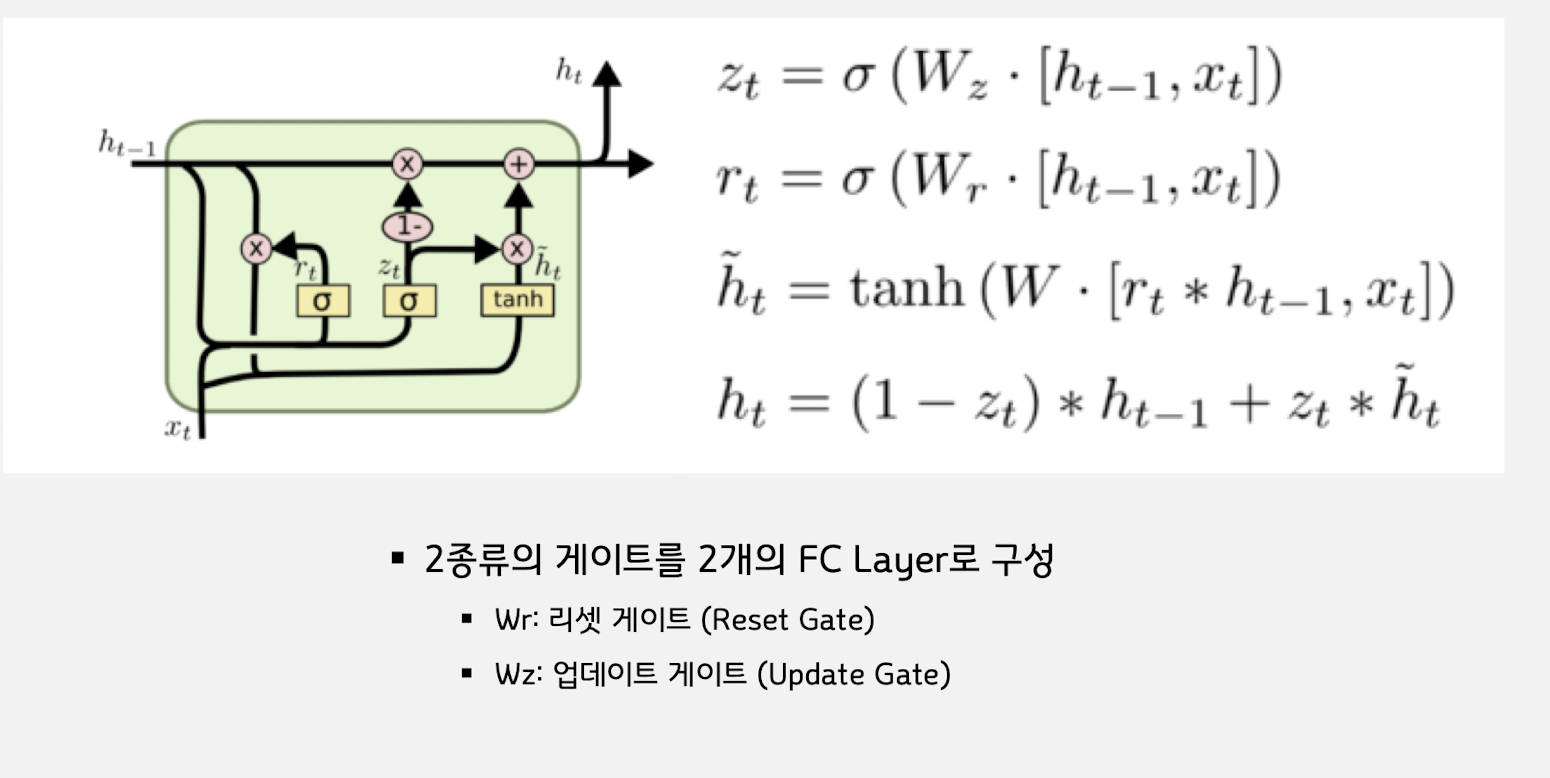

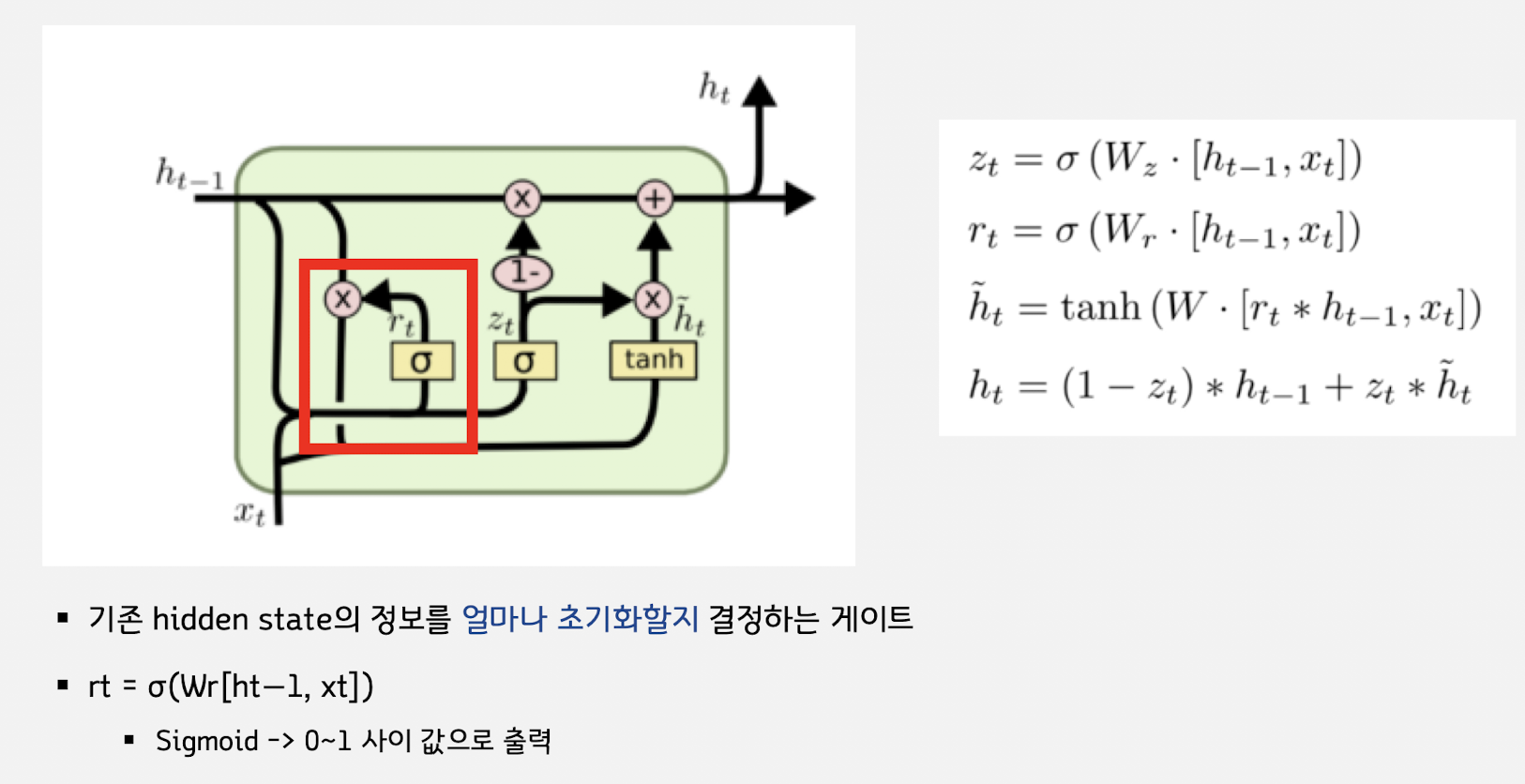

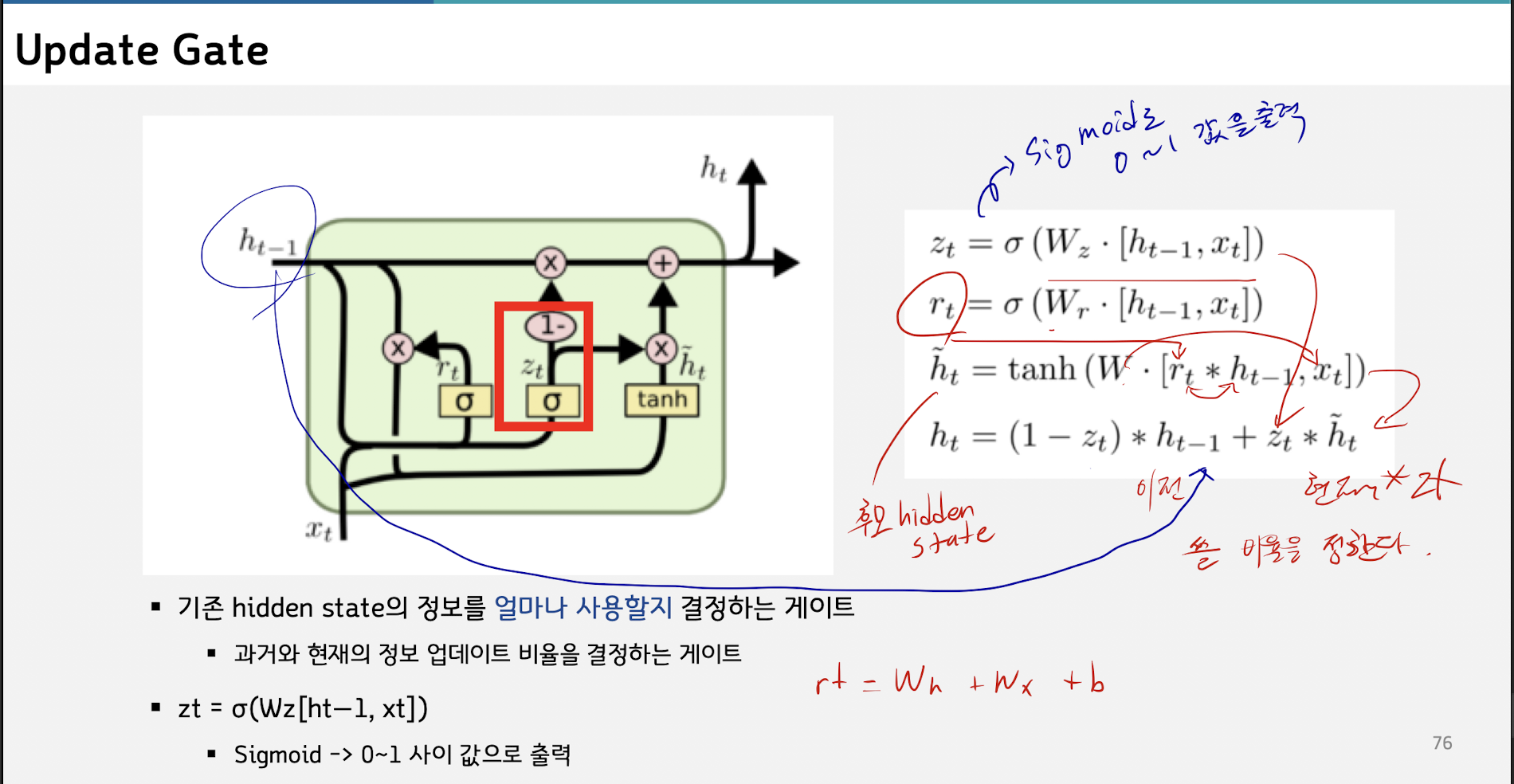

지난 히든스테이트와 이번 시점의 후보스테이트와 비중을 고려해서 ht를 만들었다는게 GRU 의 핵심이다.

Weight 갯수가 중간 단계다 Vanlia RNN < GRU < LSTM 웨이트 순이다

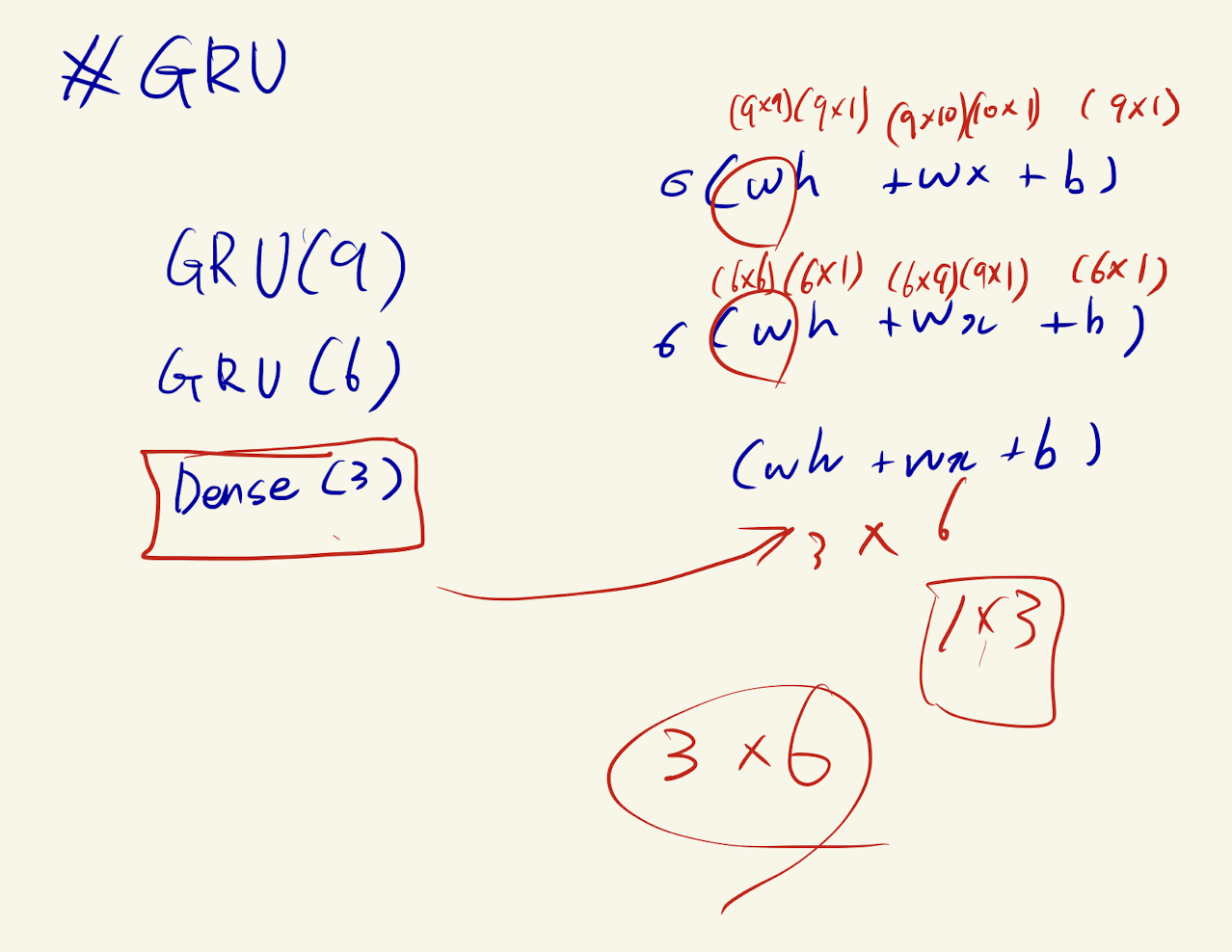

딥러닝 치트키인 웨이트 구하기로 이해해보자.

model = Sequential()

model.add(GRU(9, input_dim = 10, return_sequences=True, reset_after=False))

# reset_after : keras 구현을 하면서 병렬처리를 위해 공식을 수정(bias를 2개로 나눔)하였는데, 원래 논문에 나온 공식으로 계산하기 위해 False로 수정

model.add(GRU(6, reset_after = False))

model.add(Dense(3))

model.summary()W_reset : (num_units + input_dim + 1) num_units

W_update : (num_units + input_dim + 1) num_units

W_new : (num_units + input_dim + 1) * num_units

** GRU의 웨이트는 RNN의 3배다