Precision/Recall: 머신러닝에서 모델의 성능을 평가할 때 사용하는 평가지표

분류기의 예측 결과

1. TP (True Positive): 양성(긍정적 결과)이라고 예측한 것이 정답일 때

- 즉 실제로 Positive인 것을 잘 맞췄음2. TN (True Negative): 음성(부정적 결과)이라고 예측한 것이 정답일 때

- 즉 실제로 Negative인 것을 잘 맞췄음3. FP (False Positive): 양성(긍정적 결과)이라고 예측한 것이 오답일 때

- 즉 실제 Negative인 것을 Positive로 예측해서 틀렸음4. FN (False Negative): 음성(부정적 결과)이라고 예측한 것이 오답일 때

- 즉 실제 Positive인 것을 Negative로 예측해서 틀렸음

Precision (정밀도):

: Positive로 예측한 것 중에서 True Positive로 예측한 비율

: "아 그 분류기가 맛있다고 추천한 음식중에서 진짜 내가 좋아하는 음식의 비율을 알아보고 싶은데... Precision 지표를 보면 되겠구나"

Recall (재현율):

:실제 값이 Positive인 것중에서 True Positive로 예측한 비율

: "저 분류기가 내가 좋아하는 것에다가는 True 값을 반환했고, 내가 싫어하는 것은 False 라고 했네?? 저 중에서 내가 좋아하는 것을 얼마나 선택했을까?? Recall 지표를 보면 되겠구나!"

F1 score:

:Precision과 Recall의 조화 평균

- 조화 평균을 사용하여 구하기 때문에 Precision을 올리면 Recall이 줄고, 그 반대도 마찬가지임. 이를 Precision/Recall Tradeoff 라고 한다.

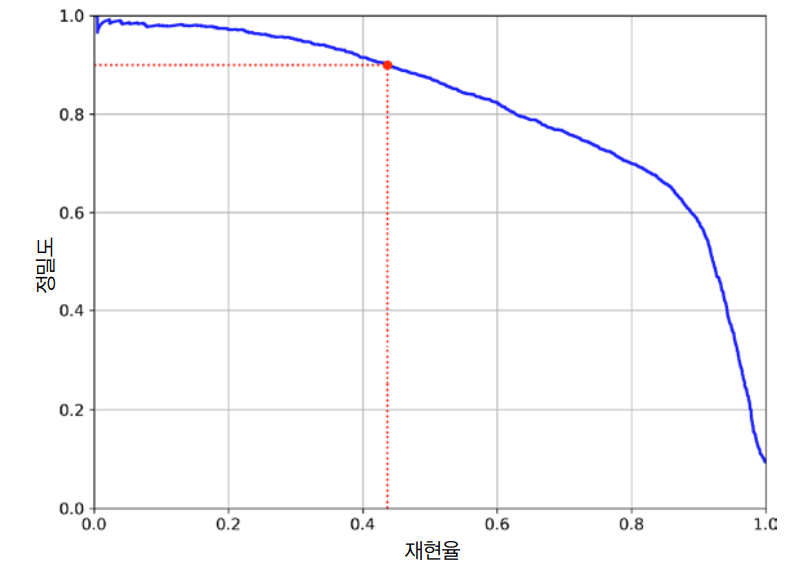

Precision Recall Curve

: x축을 recall, y축을 precision으로 하는 커브를 의미한다.

- 이 커브는 Precision이 1에서 시작하여 급격하게 떨어지는 지점까지 이어진다.

- 이때 급격하게 줄어드는 시점(하강점)의 직전에서 Precision, Recall의 값을 선택하는 것이 좋습니다.