분류 모델 성능 검증 confusion matrix, 정밀도(precision), 재현율(recall)에 대해서 알아보자.

회귀 모델(Regression)의 경우 정확도나 오차를 보면 되지만 분류 모델은 정밀도, 재현율, confusion matrix 등 머리 아픈 용어가 많다. 더 이상 머리 아프게 생각하지 말고 이번 기회에 정리해보자.

분류 모델 성능 검증

분류 모델은 confusion matrix를 통해 성능을 검증할 수 있다.

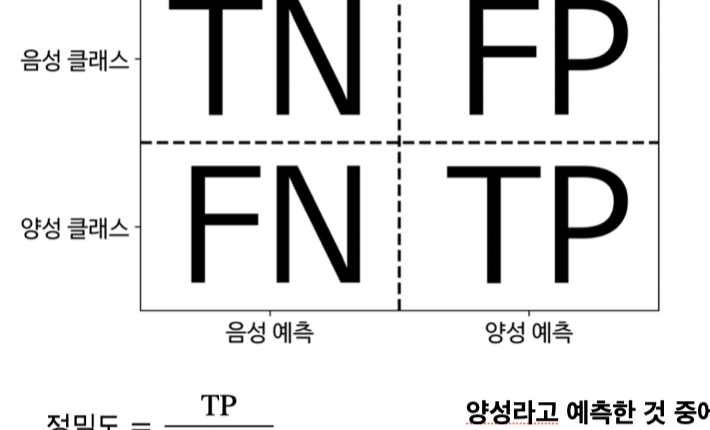

Confusion Matrix

위의 그림이 우리가 한번쯤 본 그림인데 봐도봐도 이해가 잘 되지 않는다. 조금 쉽게 생각해보면 우리가 예측한 측면과 실제 정답이 같은 경우와 다른 경우로 나눌 수 있다. 조금 더 들어가서 보면 제대로 예측한 것은 TN(True Negutive)와 TP(True Positive)이다. 각각의 의미는 아래 와 같다. 설명의 편의상 분류 모델을 양성 음성의 경우로 설명한다.

TN(True Negutive) : 음성이면서 음성을 예측 / 진짜 음성 (정답)

TP(True Positive) : 양성이면서 양성을 예측 / 진짜 양성 (정답)

FN(False Negutive) : 양성이면서 음성을 예측 / 가짜 음성 (오답)

FP(False Positive) : 음성이면서 양성을 예측 / 가짜 양성 (오답)

이제 아마 조금 정리가 될 것 같다. 그럼 본격적으로 분류 모델 성능 검증에 사용 되는 정밀도(precision), 재현율(recall)에 대해서 알아보자.

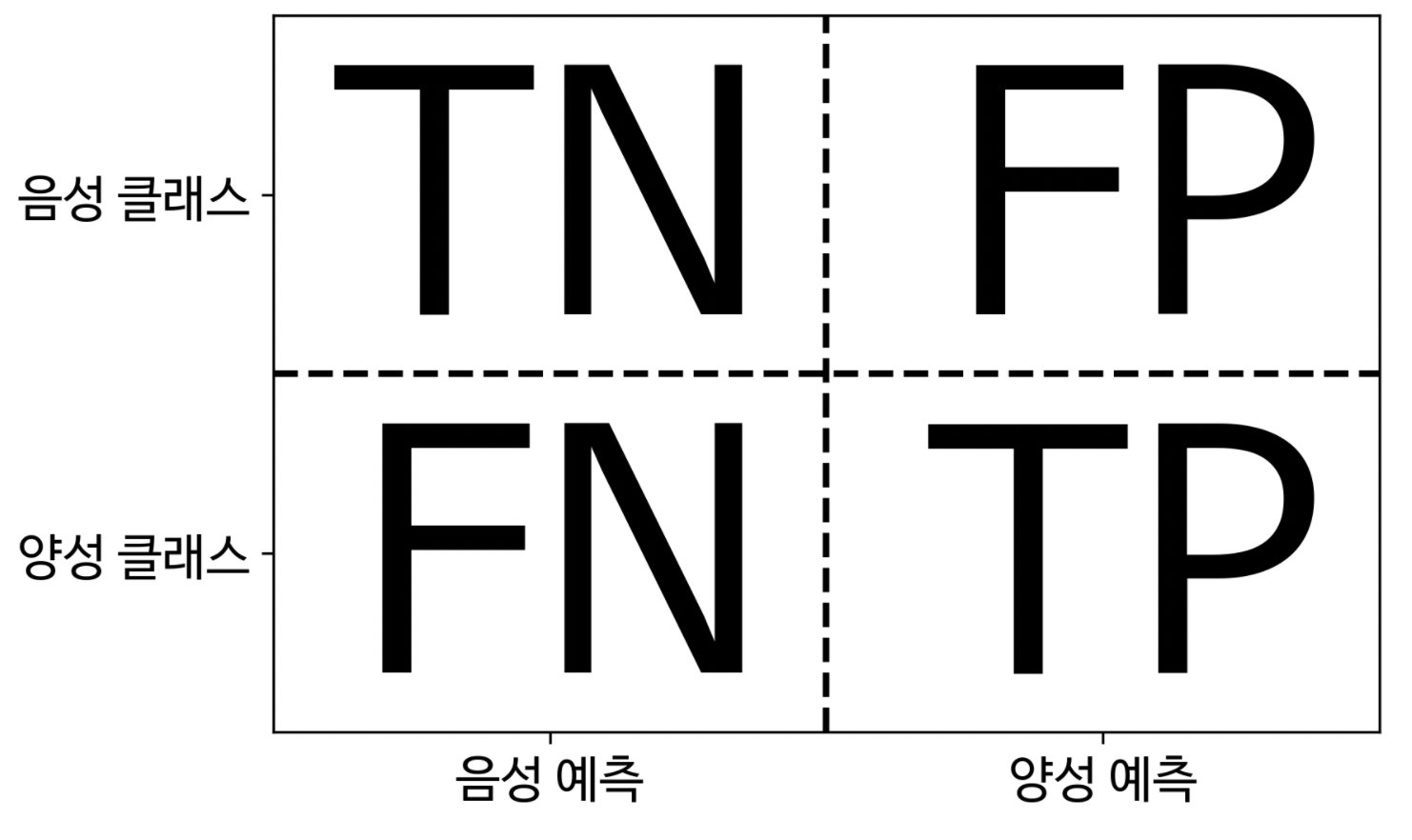

정밀도(Precision)

정밀도는 FP(가짜 양성)이 적어야 하는 분류모델에서 사용하면 좋다.

정밀도(precision)

= 진짜 양성 / 진짜 양성 + 가짜 양성

= 진짜 양성 / 양성으로 예측한 것

= 양성으로 예측 한 것 중에 진짜로 양성인 것

정밀도는 말 그대로 정밀함이 필요할 때 사용하면 좋다. 임상시험과 같이 비용이 많이 들어서 모델의 정밀도가 중요할 때 활용한다.

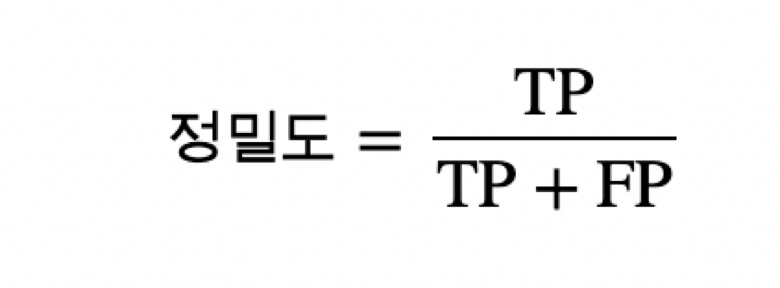

재현율(Recall)

재현율은 FN(False Negutive)가 적어야 하는 모델에 활용하면 좋다.

재현율(Recall)

= 진짜 양성 / 진짜 양성 + 가짜 음성(양성이면서 음성을 예측)

= 진짜 양성 / 양성인 것

= 양성인 것 중에 진짜 양성인 것

재현율은 양성이면서 음성을 예측할 가능성이 낮을 수록 좋은 점수가 나온다. 그래서 양성을 잘못 예측하면 안되는 암과 같은 큰 질병을 예측하는데 사용하면 좋겠다.

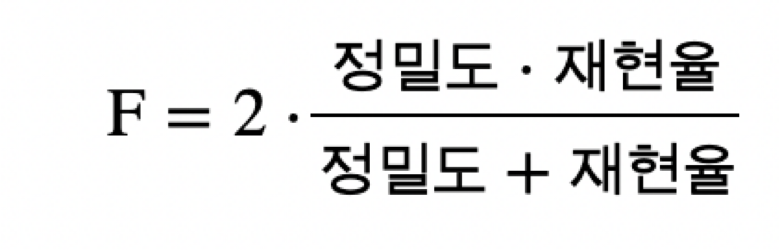

F1-score

F1-score는 가볍게 정밀도와 재현율 난 모르겠고 "그냥 분류 모델 성능이 어느정도 나오는지 알면 돼"라고 생각하는 경우에 활용하자.

F1-score vs Accuracy

그럼 정확도(Accuracy)와 F1-score 중 어느것을 활용하는게 좋은거야? 라고 할 수 있는데, T(True)가 중요할 때는 Accuracy, F(False)가 중요할 때에는 F1-score를 활용하는게 좋다.

정확도는

= TN(True Negutive) + TP(True Positive) / 전체

= 진짜라고 예측한 것 / 전체

= 전체 중에 실제로 진짜인 것