모수, 최대가능도 추정법(정규분포, 카테고리분포), 표본분포와 표집분포, 가능도

모수란?

- 통계적 모델링은 적절한 가정 위에서 확률분포를 추정하는것이 목표이고, 머신러닝과 통계학이 공통으로 추구하는 목표

- 유한한 데이터로 모집단의 분포를 정확하게 알아내는것은 불가능 -> 근사적으로 추정

- 데이터가 특정 확률분포를 따른다고 선험적(a priori)으로 가정한 후 그 분포를 결정하는 모수를 추정하는 방법이 모수적(parametric) 방법론

(모수란 모집단 전체를 설명하는 측도. 예를 들어, 정규분포에서는 평균, 분산) - 특정 확률분포를 가정하지 않고 데이터에 따라 모델의 구조 및 모수의 개수가 유연하게 바뀌면 비모수방법론(모수가 무한히 많거나 모수의 개수가 데이터에 따라 바뀌는 경우)이라 부름

- 대부분의 기계학습의 방법론은 비모수방법론에 속함

확률분포 가정

데이터가 2개의 값만 가지는 경우 → 베르누이분포

데이터가 n개의 이산적인 값을 가지는 경우 → 카테고리분포

데이터가 [0, 1] 사이에서 값을 가지는 경우 → 베타분포

데이터가 0 이상의 값을 가지는 경우 → 감마분포, 로그정규분포 등

데이터가 R 전체에서 값을 가지는 경우 → 정규분포, 라플라스분포 등

- 기계적으로 가정해서는 안되며 데이터를 생성하는 원리를 먼져 고려해야함

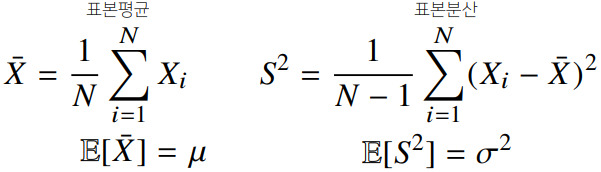

데이터로 모수 추정

- 통계량의 확률분포를 표집분포라 부름

중심극한정리(central limit theorem)

: 표본평균의 표집분포는 이 커질수록 정규분포 에 가까워짐

최대가능도 추정법(MLE, maximum likelihood estimation)

- 표본평균이나 표본분산은 중요한 통계량이지만 확률분포마다 사용하는 모수가 다르므로 적절한 통계량이 달라짐 -> 이론적으로 가장 가능성이 높은 모수를 추정하는 법 중 하나가 최대가능도 추정법

가능도(likelihood) 함수

- 가능도는 확률분포의 모수 가 어떤 확률변수의 표집값 와 일관되는 정도를 나타낸 값

로그가능도를 왜 사용하는가

- 컴퓨터는 수억 단위를 계산할 때, 오차가 커진다. 만약 데이터가 독립일 경우, 곱셈을 덧셈으로 바꿀 수 있으므로 데이터가 커도 컴퓨터로 연산이 가능해진다.

- 경사하강법으로 가능도를 최적화할 때, 미분 연산량이 에서 을 줄어든다.

- 보통 손실함수의 경우 경사하강법을 사용하므로 목적식을 최소화 시킨다. 하지만, 로그 가능도의 경우 극대값을 찾게 된다. 로그 가능도를 최소화시키는 목적식으로 변형하기 위해 음의 로그가능도(negative log-likelihood)를 최적화하게 된다.

- 정규분포

- 카테고리분포

유도식은 강의자료 참고

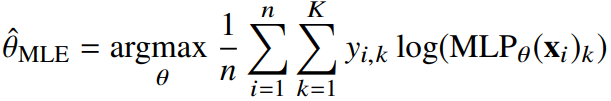

딥러닝에서 최대가능도 추정법

- 딥러닝 모델의 가중치를 라 표기했을 떄 분류 문제에서 소프트맥스 벡터는 카테고리분포의 모수를 모델링

- 원핫벡터로 표현한 정답레이블을 관찰데이터로 활용해 확률분포인 소프트맥스 벡터의 로그가능도를 최적화할 수 있음

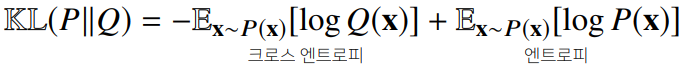

확률분포의 거리 구하기

- 기계학습에서 사용되는 손실함수들은 모델이 학습하는 확률분포와 데이터에서 관찰되는 확률분포의 거리를 통해 유도

- 두 확률분포 사이 거리를 계산하는 함수로

총변동 거리,쿨백-라이블러 발산,바슈타인 거리등이 있음

쿨백-라이블러 발산

- 분류 문제에서 정답레이블을 , 모델 예측을 라 하면 최대가능도 추정법의 손실함수가 크로스 엔트로피에 해당하게됨

- 최대가능도 추정법에서 로그가능도 효율을 최대화시키는 것과 와 사이의 거리

-> 쿨백-라이블러 발산을 최소화하는 것과 같음

참고

최대가능도 추정법

https://datascienceschool.net/02%20mathematics/09.02%20%EC%B5%9C%EB%8C%80%EA%B0%80%EB%8A%A5%EB%8F%84%20%EC%B6%94%EC%A0%95%EB%B2%95.html

출처 - 부스트캠프 AI tech 교육자료

[부스트캠프 AI Tech] Week 1 - Day 5