딥러닝에서 확률론이 왜 필요한가

딥러닝은 확률론 기반의 기계학습 이론에 바탕을 둔다.

- 기계학습에서 사용되는 손실함수(loss funtion)들의 작동 원리는 데이터 공간을 통계적으로 해석해서 유도하게 된다.

- 회귀 분석에서 손실함수로 사용되는 노름은 예측오차의 분산을 가장 최소화하는 방향으로의 학습을 유도

- 분류 문제에서 교차 엔트로피는 모델 예측의 불확실성을 최소화하는 방향으로의 학습 유도

👉 분산과 불확실성을 최소화하려면 측정하는 법을 알아야하고 이를 통계학에서 제공하기 때문에 기계학습을 이해하기 위해 확률론의 기본 개념을 알아야 한다.

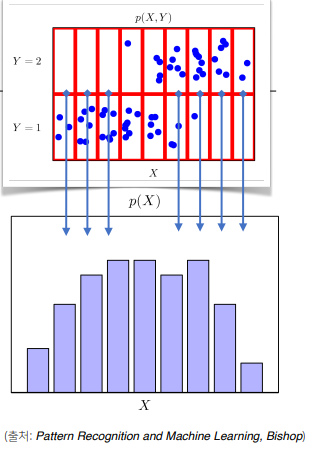

확률분포는 데이터의 초상화

데이터 공간을 라 표기하고 는 데이터 공간에서 데이터를 추출하는 분포

-

이산확률변수

: 확률변수가 가질 수 있는 모든 경우의 수를 고려하려 확률을 더해 모델링

-

연속확률변수

: 데이터 공간에 정의된 확률변수의 밀도 위에서의 적분을 통해 모델링

밀도는 누적확률분포의 변화율을 모델링

이산형이냐 연속형이냐는 확률분포 에 따라 결정된다.

- 파란색 점들은 데이터 공간상에서 관측한 데이터

- 이 데이터들을 추출할 때 확률변수를 사용하게 되고 추출한 데이터의 분포를 라 표기

- 결합분포 에서 각각 y와 x값의 범위에 따라 나눈 공간상에서 파란 점들이 분포되어 있는데 각각의 빨간 칸으로 나누면 이산확률분포로 생각할 수 있음

- 결합분포를 적분하여 주변확률분포 를 구할 수 있다.

조건부확률

- : 입력변수 x에 대해 정답이 y일 확률

- 연속확률분포의 경우 확률이 아니라 밀도로 해석

- 로지스틱 회귀에서 사용했던 선형모델과 소프트맥스 함수의 결합은 데이터에서 추출된 패턴을 기반으로 확률을 해석하는데 사용됨

- 회귀문제의 경우 조건부기대값 을 추정. 예측오차의 분산을 최소화하는 적절한 통계치로 사용

기대값(expectation) : 데이터를 대표하는 통계량이면서 대표적인 범함수(statiscal funtional)

몬테카를로 샘플링

- 기계학습의 많은 문제들은 확률분포를 명시적으로 모름

- 확률분포를 모를 때 데이터를 이용하여 기대값을 계산

- 독립추출만 보장된다면 대수의 법칙에 의해 수렴성이 보장된다.

- 변수 유형(이산형, 연속형)에 상관없이 사용 가능

출처 - 부스트캠프 AI tech 교육자료

[부스트캠프 AI Tech] Week 1 - Day 5