Multinomial classification

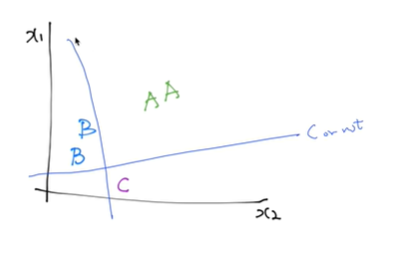

여러 개의 클래스가 있다.

우리가 전에 쓰던 Binary classification을 여러 개를 합쳐서 구현이 가능하다.

이런식으로 하나하나(예시: C인지 아닌지) 선을 그으면 됨.

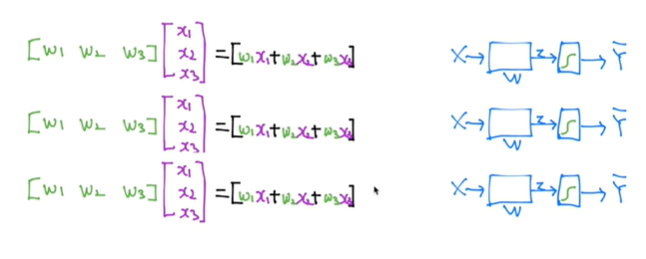

그럼 식이 이렇게 되는데 이걸 하나하나 계산하면 복잡하니까 합쳐서 행렬 벡터로 한번에 계산한다.

Sigmoid 함수의 활용

시그모이드 함수를 활용해서 각각 벡터의 값을 구한다. 그럼 0과 1사이의 값으로 나오게 되는데, 그걸 원-핫 인코딩(one-hot encoding)을 통해 1과 0의 값으로 변환하여 정답을 찾아낸다.

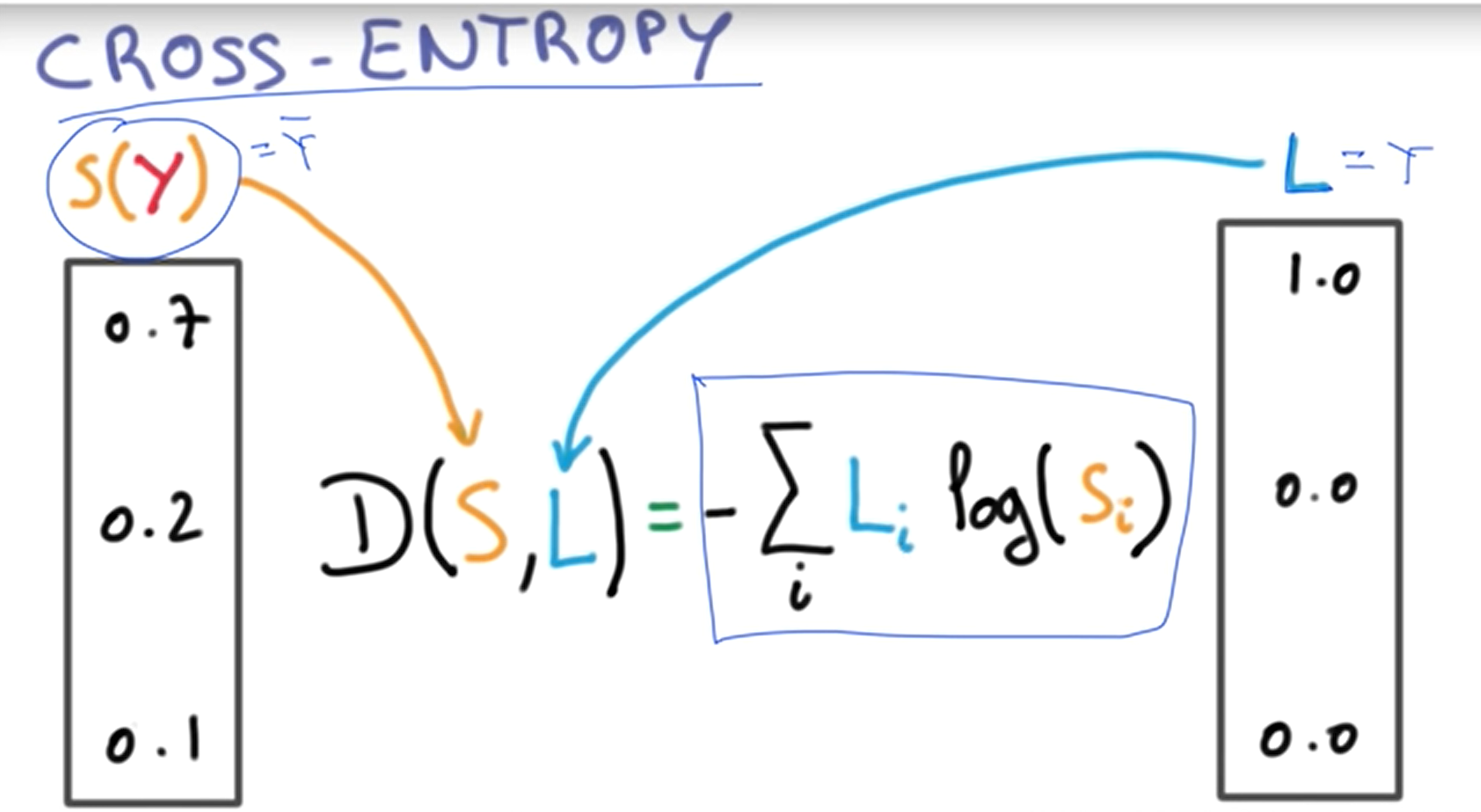

Cross-Entropy cost function

모델이 예측한 값(y^)과 정답 L(y, label)의 차이를 구하는 Cross-Entropy 식이다.

위의 그림에서 첫번째는 맞게 예측했을 때의 cross entropy이고 후자가 틀리게 예측했을 때이다.

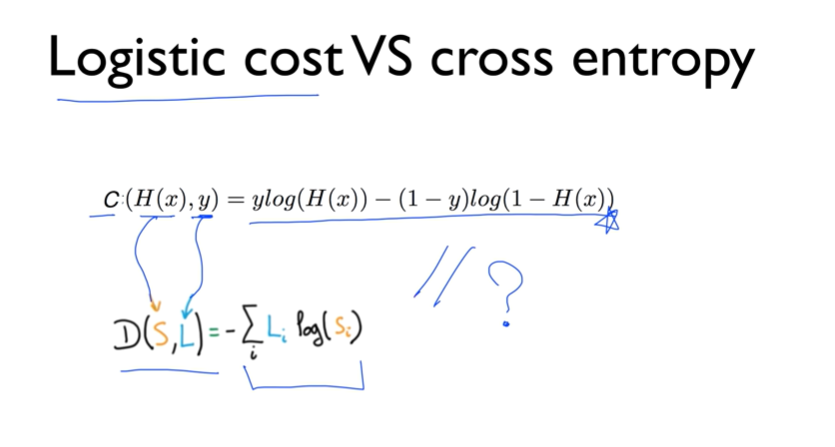

이것은 우리가 전에 배웠던 logistic cost와 결국 같은 말이다.