MLDLs

1.KL-Divergence Explained

entropy, cross-entropy를 공부하다가 KL-Divergence에 대해 좋은 글이 있어서 번역해보았다.출처: https://www.countbayesie.com/blog/2017/5/9/kullback-leibler-divergence-expla

2021년 3월 31일

2.다중공선성과 ML/DL problems

독립변수간의 상관관계가 매우 높을 때, 하나의 독립변수의 변화가 다른 독립변수에 영향을 미쳐, 결과적으로 모델이 크게 흔들리는 것을 의미한다. 모델의 결과는 불안정하며 작은 변화에도 변동이 크다. 이는 다음과 같은 문제를 야기시킨다: 1. 모델이 예측을 할 때마다,

2021년 5월 26일

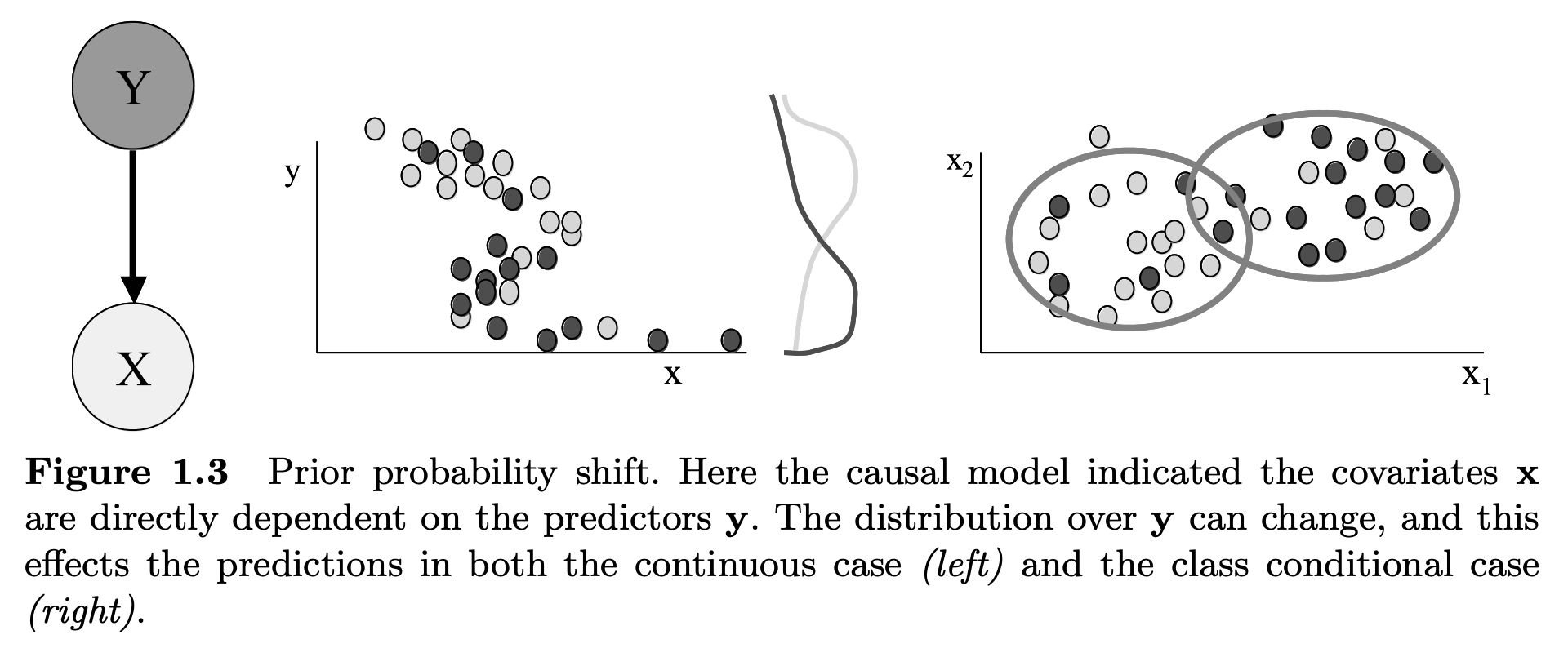

3.Understanding Dataset Shift

참고자료:https://www.analyticsvidhya.com/blog/2017/07/covariate-shift-the-hidden-problem-of-real-world-data-science/https://data-newbie.tistory.

2021년 6월 1일

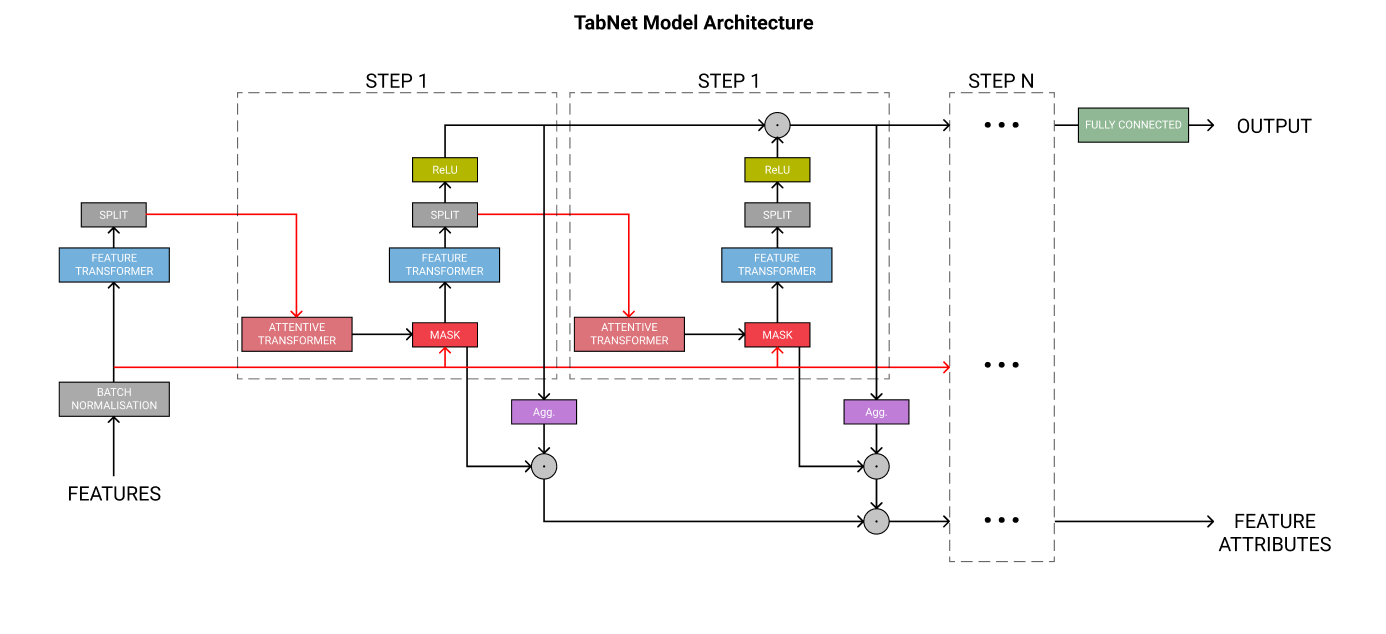

4.TabNet: Gradient Boosting의 종말?

https://towardsdatascience.com/tabnet-e1b979907694 를 읽고 흥미로워서 번역한 글입니다.XGBoost와 같은 gradient boosting model은 테이블 데이터에서 큰 성능을 보이고 있다. 그러나 2019년 구글의

2021년 7월 15일