NLP

1.[NLP] 한국어 자연어 전처리

한국어 자연어 전처리 과정 정리 영어 같은 경우는 , 전처리 과정이 생각보다 단순하였는데 한국어로 전처리를 하려니 생각보다 어려웠다 . 게다가 리뷰데이터같은 raw 데이터는 오타도 많고, 신조어 , 외래어 등등 처리해야할게 끝도 없는거같았다 ! 이제까지 시도& 정

2.[NLP] BERT 개념 정리

BERT (Bidirectional Encoder Representations from Transformers) 구글에서 개발한 NLP(자연어 처리) 사전 훈련 언어 모델 이며 총 3.3억의 단어의 코퍼스를 정제하고 , 임베딩하여 학습시킨 모델 BERT 모델 B

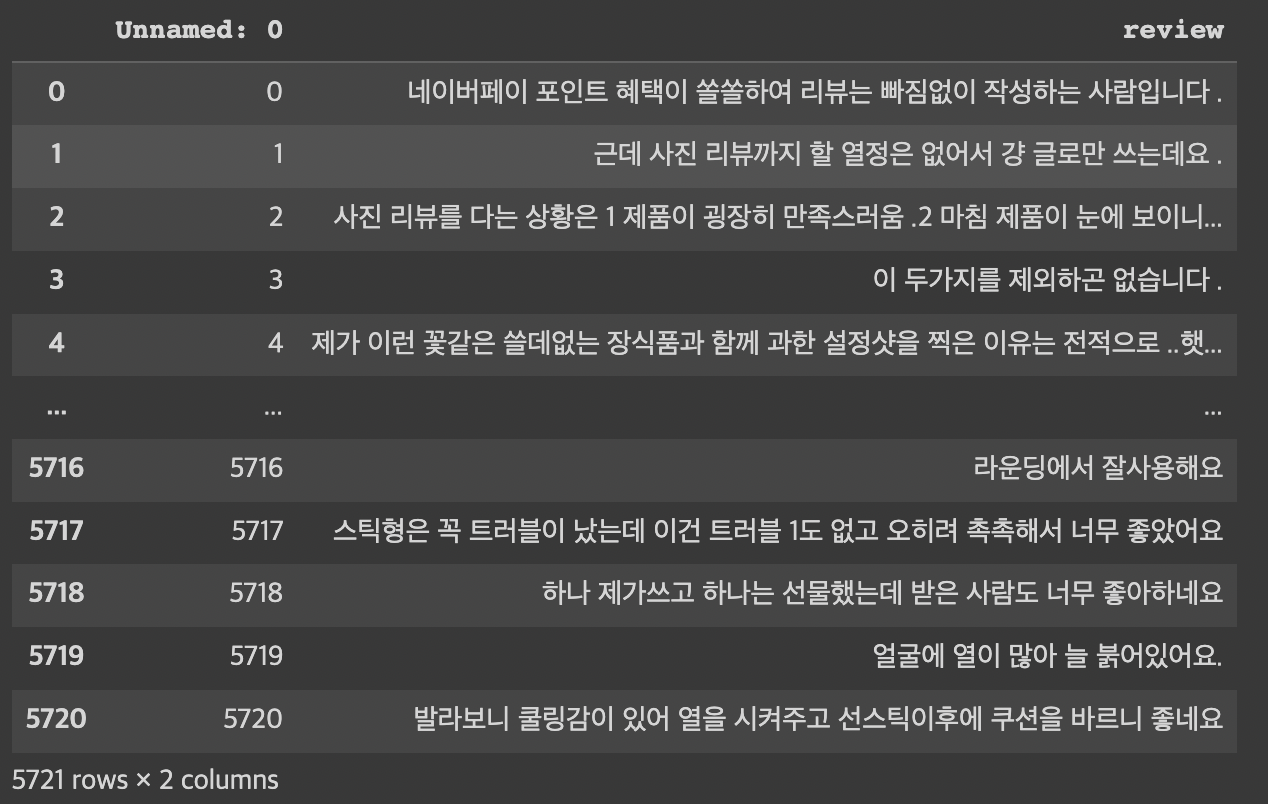

3.[NLP] 네이버 쇼핑 리뷰 데이터 분석

전처리를 완료한 리뷰데이터 분석을 진행하여 본다.한글의 문장은 문장간의 의미파악이 중요하기 때문에 단어 단어 사이의 의미 파악, 문장간의 관계를 파악하여 어떤 의미인지 임베딩시키는 학습이 중요하다 문장 임베딩 (Sentence Embedding)은 문장이 가지고 있는

4.Rouge Score (Text Summarization의 평가지표)

Rouge(Recall-Oriented Understudy for Gisting Evaluation)텍스트 요약 모델 성능 평가에 주로 사용되는 지표로 Label(사람이 만든 요약문)과 Summary(모델이 생성한 inference)를 비교해서 성능 계산 ROUGE -

5.[NLP] KeyBERT - 키워드 추출(Keyword extraction)

원본 문서를 가장 잘 나타내는 중요한 용어 또는 구문을 찾아내는 작업keyBERT란 토픽 모델링 중 키워드 추출을 위해 BERT를 적용한 오픈소스 파이썬 모듈이다.keyBERT는 텍스트 임베딩 단계에서 BERT를 사용하기 때문에 BERT-based 모델이다.KeyBER

6.[NLP] 워드 임베딩 (Word Embedding)

텍스트를 컴퓨터가 이해하고, 효율적으로 처리하기 위해서는 컴퓨터가 이해할 수 있도록 적절히 숫자로 변환해야 한다. 따라서 각 단어를 인공 신경망 학습을 통해 벡터화하는 워드 임베딩 방법이 많이 사용되고 있다.워드 임베딩(Word Embedding)은 단어를 벡터로 표현