인공지능(AI) 분야는 최근 몇 년간 급속한 발전을 이루며, 특히 대규모 언어 모델(LLM)의 성능 향상에 많은 주목을 받고 있다. 모두의 연구소에서 진행하는 강연을 들었을 때 전문가 혼합(MoE, Mixture of Experts)과 에이전트 혼합(MoA, Mixture of Agents)이라는 두 가지 접근법을 알게 되었고 꽤나 흥미로웠다.

LLM무새가 이걸 지나칠 수는 없지. 이번 블로그에서는 MoE와 MoA의 개념, 특징, AI 모델에 미치는 영향을 살펴보겠다 !!

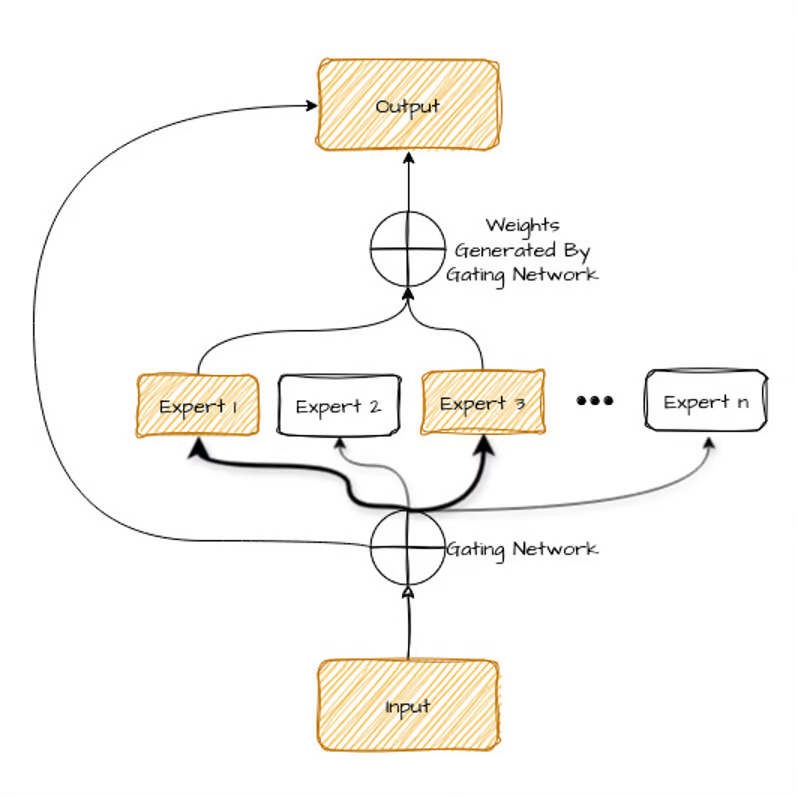

1. 전문가 혼합(MoE)이란 무엇인가?

여러 개의 '전문가' 모델을 활용하여 주어진 입력에 가장 적합한 전문가를 선택하고, 이를 통해 예측을 수행하는 아키텍처. 이러한 구조는 모델의 효율성을 높이고, 특정 작업에 대한 전문성을 강화하는 데 기여함.

🧐 주요 성질

-

전문가 모델: 다양한 전문 분야에서 탁월한 성능을 발휘하는 전문가 모델의 집합으로 구성

-

부분 활성화: 입력되는 질문이나 과제에 따라 일부 전문가만 활성화됨

-

층화 구조: 각 층에서 서로 다른 전문가들이 협력하여 문제를 해결해 복잡한 문제를 보다 효과적으로 처리

🧐 주요 특징

게이팅 네트워크: 입력에 따라 적절한 전문가를 선택하는 역할

효율성: 모든 전문가를 동시에 사용하는 것이 아니라, 선택된 일부 전문가만 활성화하여 계산 자원 절약

확장성: 전문가의 수를 늘려 모델의 용량 확장

MoE 모델은 특히 대규모 언어 모델의 성능 향상에 효과적이며, PyTorch와 같은 프레임워크를 통해 구현되고 있다.

🧐 활용 사례

GPT-3 및 GPT-4의 활용: 이들 모델은 MoE 기법을 통하여 다양한 질문응답(task)에서 뛰어난 성능을 발휘한다. 특정 작업에 대해 최적화된 모델만을 사용함으로써, 처리 시간을 단축하고 연산 비용을 절감함.

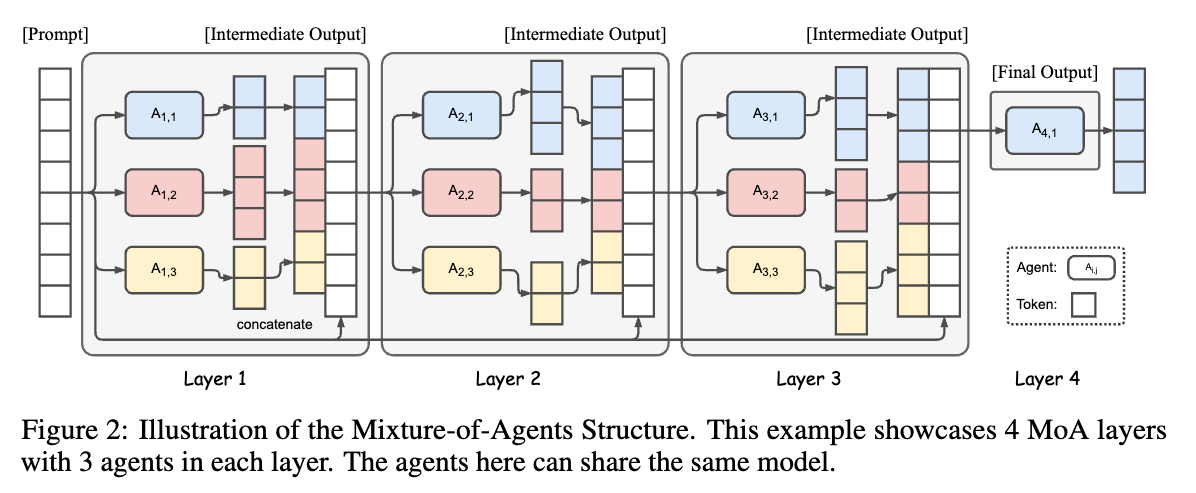

2. 에이전트 혼합(MoA)이란 무엇인가?

여러 개의 언어 모델(에이전트)이 협력하여 더 나은 성능을 도출하는 방법론. 각 에이전트는 계층 구조 내에서 상호 작용하며, 이전 계층의 출력을 기반으로 응답을 생성하여 최종 결과를 개선함.

🧐 주요 성질

-

협력적 구조: MoA는 다양한 LLM들이 서로의 출력을 참고하여 더 나은 결과 도출

-

계층적 접근: LLM은 여러 계층으로 구성되어 각 계층의 결과를 종합하여 최종 응답 생성

-

모델 다양성: 첫 번째 계층에서 생성된 출력은 다음 계층에서 개선(각 모델이 상호 보완적으로 작용함)

🧐 주요 특징

협력성: 여러 모델이 서로의 출력을 참고하여 최적의 응답 생성

계층 구조: 각 계층은 여러 에이전트로 구성되며, 단계별로 응답의 품질을 향상시킴

비용 효율성: 단일 대규모 모델보다 저렴한 비용으로 높은 성능 구현

MoA 기법은 LLM의 성능을 향상시키는 데 효과적이며, OpenPipe와 같은 플랫폼에서 이를 활용하여 GPT-4 수준의 성능을 더 낮은 비용으로 구현하고 있다.

🧐 활용 사례

여러 LLM의 활용: MoA 기법은 여러 대규모 언어 모델을 사용하여 각각의 장점을 극대화하는 작업에서 활용함. 이들은 서로 다른 출력 결과를 저렴한 비용으로 결합하여 보다 종합적이고 고품질의 결과를 제공함.

3. MoE와 MoA의 비교 및 활용

MoE와 MoA는 모두 AI 모델의 성능 향상을 목표로 하지만 접근 방식에서 차이가 있다.

MoE: 단일 모델 내에서 여러 전문가를 활용하여 특정 작업에 대한 전문성을 강화

MoA: 여러 모델 간의 협력을 통해 복잡한 문제에 대한 종합적인 해결책을 도출

MoE와 MoA 비교

| 특징 | MoE (Mixture of Experts) | MoA (Mixture of Agents) |

|---|---|---|

| 구조 | 여러 전문가 모델 중 입력에 따라 선택된 모델이 작업 처리 | 여러 LLM (또는 에이전트)이 협력하여 작업 수행 |

| 활성화 메커니즘 | 부분 활성화 (입력에 따라 필요한 전문가만 활성화) | 전체 활성화 (모든 참여 모델 사용) |

| 성능 최적화 | 자원 사용 효율성 극대화 | 응답 품질 향상 (협력적 요소 활용) |

| 운영 비용 | 비용 효율적 (일부 전문가만 사용) | 상대적으로 높은 비용 (다양한 모델 동시 활용) |

| 핵심 아이디어 | 입력에 특화된 전문가를 선택적으로 활용하여 효율성 증대 | 여러 모델의 강점을 결합하여 시너지 효과 창출 |

| 비유 | 여러 분야의 전문가에게 필요한 부분만 자문을 구하는 형태 | 여러 명의 전문가가 모여 협력하여 문제를 해결하는 형태 |

| 주요 장점 | 연산 효율성, 모델 확장 용이 | 높은 정확도 및 풍부한 정보 제공 가능성 |

| 주요 단점 | 전문가 선택의 어려움, 전문가 간 조정 문제 발생 가능성 | 높은 연산 비용, 복잡한 관리, 모델 간 충돌 발생 가능성 |

이 부분은 Gemini 2.0에서 추가적으로 설명해준 부분이다.

추가 설명

- MoE (Mixture of Experts):

- 입력 데이터에 따라 적절한 전문가를 선택하는 것이 핵심입니다.

- 게이팅 네트워크가 이 역할을 담당하며, 어떤 전문가를 사용할지 결정합니다.

- 각 전문가는 특정 유형의 입력 또는 작업에 특화되어 학습됩니다.

- MoA (Mixture of Agents):

- 여러 모델 또는 에이전트가 서로 협력하여 작업을 수행하는 방식입니다.

- 각 모델은 독립적으로 또는 협력적으로 작업을 수행하고, 결과를 종합하여 최종 결과를 도출합니다.

- 이 과정에서 합의, 투표, 조정 등의 메커니즘이 사용될 수 있습니다. "Aggregator"라는 용어를 사용하는 경우, 여러 모델의 출력을 종합하는 역할을 강조합니다.

4. 결론

전문가 혼합(MoE)과 에이전트 혼합(MoA)은 각각의 장점과 특성을 통해 대규모 데이터 처리 및 응답 생성에서 차별화된 성능을 발휘하여 AI 모델의 새로운 패러다임을 제시하며, 대규모 언어 모델의 성능을 한층 더 향상시키는 데 기여하고 있다.

각각의 상황에 맞는 적절한 기법의 선택은 효과적인 AI 기술 응용을 위한 중요한 기준이 된다.

이러한 혁신적인 접근법들은 앞으로의 AI 발전에 중요한 이정표가 될 것이다.

5. 개인적인 의견

저번 agent 관련 논문 리뷰도 그렇고 AI 자체가 "인간을 모방하는"에 초점이 맞춰져 있다보니 모델의 행동 양상도 비슷하게 만들어간다는 생각이 든다. 사람도 여러 관계가 있고 그에 따른 다양한 output이 있으니 agent의 결과값도 여러 방향이 나올 것 같다.

이건 좀 다른 이야기지만, 공부하겠다는 의지만 있으면 어디서든 배울 수 있다는 게 요즘 살아가면서 진짜 강점인거 같다. 다들 지식공유를 열심히 해주셔서 나같이 아무것도 모르는 사람도 이정도로 공부할 수 있기도 하고... (깊이 있는 내용이 많아서 기초적인 부분만 적는게 민망할 정도.) 좀 더 자세한 내용은 출처에 있는 사이트와 관련 논문을 둘러봐도 좋을 것 같다.

6. 출처 및 관련 논문

https://www.datacamp.com/blog/mixture-of-experts-moe

https://discuss.pytorch.kr/t/moa-mixture-of-agents-llm/4667

-

Mixture-of-Experts (MoE) 관련 논문

"Outrageously Large Neural Networks: The Sparsely-Gated Mixture-of-Experts Layer" (2017)

(Google Brain에서 제안. MoE의 기본 개념을 도입하며 특정 입력에 따라 일부 전문가만 활성화하여 계산 자원을 효율적으로 사용하는 방법을 설명)

"Mixture of Attention Heads: Selecting Attention Heads Per Token"

(MoE와 유사한 메커니즘인 Mixture of Attention Heads를 제안) -

Mixture-of-Agents (MoA) 관련 논문

"Mixture of Agents Enhances Large Language Model Capabilities" (2024)

(여러 LLM 에이전트가 계층 구조를 통해 협력하여 최종 응답을 점진적으로 개선하는 방식을 제안합니다. 다양한 벤치마크에서 GPT-4 Omni를 능가하는 성능을 보인 것으로 보고됨)

"MoA is All You Need: Building LLM Research Team using Mixture of Agents" (2024)

(금융 분야에서 MoA 기반의 검색 강화 생성 시스템을 제안. 여러 소형 언어 모델 에이전트를 통해 높은 품질의 결과를 제공하는 방법을 설명)