Average Precision (Object Detection)

Precision vs Recall

- Precision

모델의 예측 값에 집중해서 모델이 positive라고 예측한 것들 중에 실제로 얼마나 잘 검출했는가? 를 찾음

- Recall

실제 데이터 (ground-truth, 추천 시스템에선 실제 유저가 사용한 아이템)에 집중해서 실제 데이터 중에서 모델이 실제 positive 한걸 얼마나 positive하다고 잘 예측했는가?

(그냥 모프그리 - 모델 기준 프리시전, 그라운드 트루 기준 리콜 이라 외우자..)

Precision과 Recall은 보통 반비례 하는 성향을 갖고있다.

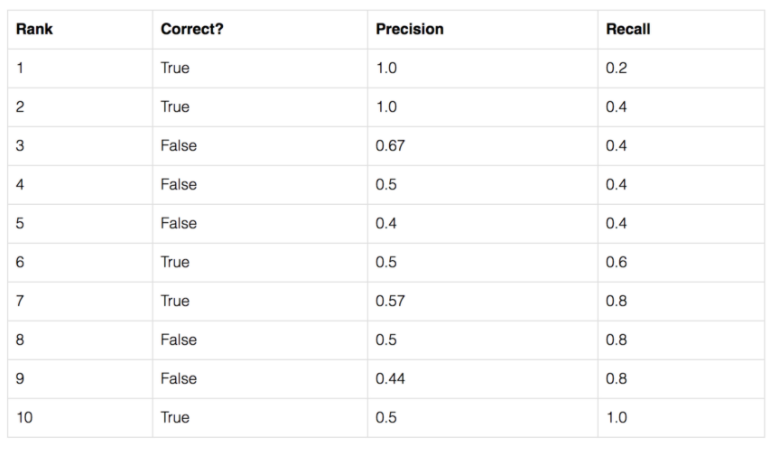

Average Precision

위의 두 개만으로는 어떤 알고리즘의 성능을 파악할 수는 있지만 정량적으로 비교할 수는 없다.

사과 10개에 대해 TP=5, FP=1 이라 하면,

, 이다

precision은 좋아보이지만, recall은 낮아보인다.

이 두개를 종합해서 알고리즘을 평가하는 것이 Average Precision이다.

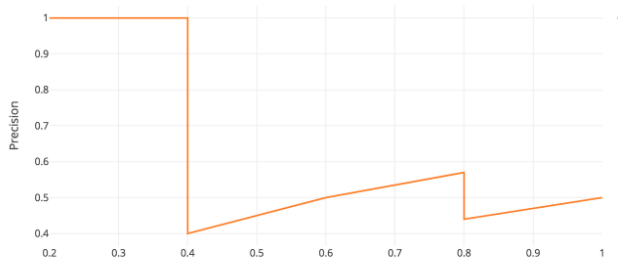

x축은 recall, y축은 precision 값으로 average precision은 해당 그래프의 아래 면적을 의미한다. 보통 아래와 같이 변환 후에 계산해준다.

MAP(mean Average Precision)

mAP은 이름 그대로 각각의 클래스에 대한 AP의 평균을 의미한다.

이것이 Object Detection의 평가 지표가 된다.

참고: