Ollama?

- Get up and running with large language models locally.

- 오픈소스 LLM 모델을 local에서 띄워서 구동하는 가장 손쉬운 방법

- windows, macos에서도 구동되기 때문에 너무나 간단하게 llama3, gemma, phi-3, command-r 등 어느정도 한글이 되는 모델들을 다운로드 받아서 구동시킬 수 있다

- 구동되면 langchain과도 바로 연결된다

설치

curl -fsSL https://ollama.com/install.sh | shQuickStart

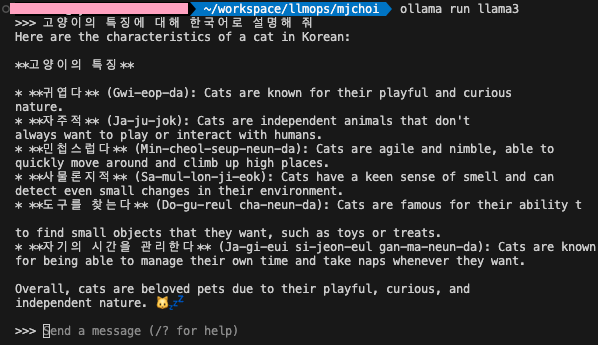

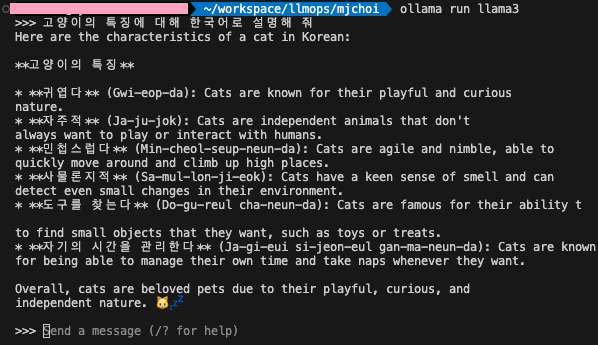

ollama run llama3테스트

Reference

https://github.com/ollama/ollama/tree/main

https://infoengineer.tistory.com/m/137