1. Gradien descent based learning

실제 값과 학습된 모델 예측치의 오차를 최소화 하는 것.

모델의 최적 parameter 찾는 것이 목적

y = ax+b

✔ ax+b(수학식) = 모델,

✔ a, b = parameter로 학습을 통해 알아야 하는 것,

✔ x, y = 기본적으로 주어지는 data

👉 Linear Regression의 가장 기본적인 방법 :

실제 값과 예측치의 오차를 더해서 값이 가장 적게 나오는 a,b를 찾아야 한다.

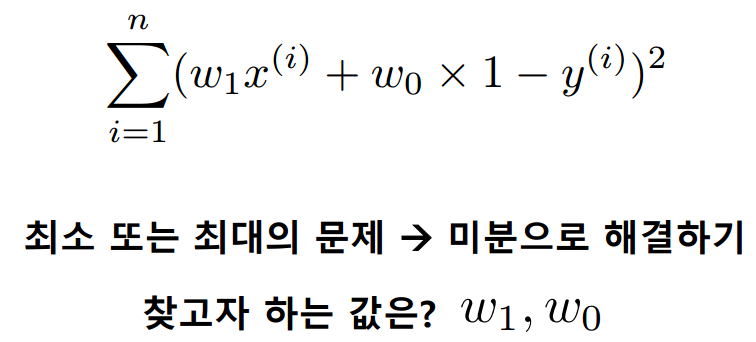

오차 제곱의 합을 사용한다.

Squared Error를 최소화 할 수 있는 weight 값 : w1, w0(ax+b에서 a,b와 같다)

2. Cost Function

예측 함수를 가설 함수라고 부른다.

θ : 찾아야 되는 w값

x : 입력값

ŷ : 출력값

Cost function : 실제 값과 가설함수의 차이

J는 w0, w1에 의해 결정된다.

J는 w0, w1에 의해 결정된다.

m : 전체 데이터 개수

ŷ-y^i : 예측치 - 실제값

Cost function에서 구하는 것 ⇒ cost function의 최소화를 위한 weight 값

w0에 관한 값으로 미분 → 나머지는 상수 취급

w0에 관한 값으로 미분 → 나머지는 상수 취급

3. weights의 최적값 컴퓨터가 찾는 방법

1) 연릭방적식 풀기(normal equation)

2) gradient descent