📌 Hive Meta Store

Spark DB & Table

-

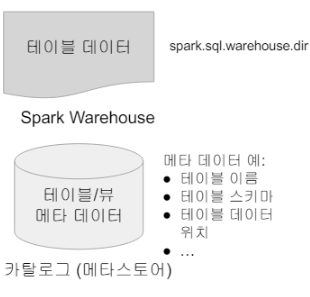

카탈로그 : 테이블과 뷰에 관한 메타 데이터 관리

- 기본으로 메모리 기반 카탈로그 제공 -> 세션이 끝나면 사라진다.

- Hive와 호환되는 카탈로그 제공 -> Persistent

-

Table 관리 방식

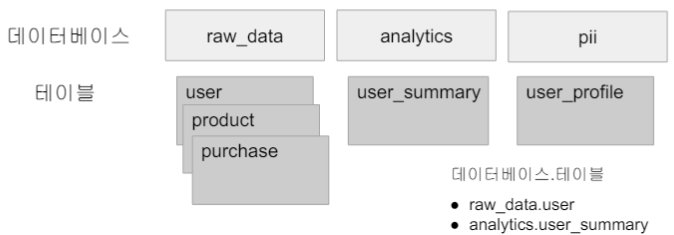

- 테이블들은 DB라 부르는 폴더와 같은 구조로 관리(2단계)

-

메모리 기반 Table & View -> 임시 테이블

-

스토리지 기반 테이블

- 기본적으로 HDFS와 Parquet 포맷을 사용한다.

- Hive와 호환되는 메타스토어 사용

- 두 종류의 테이블이 존재한다.(Hive와 동일한 개념)

- Managed Table

-> Spark이 실제 데이터와 메타 데이터를 모두 관리한다. - Unmanaged (External) Table

-> Spark이 메타 데이터만 관리한다.

- Managed Table

Spark SQL - 스토리지 기반 카탈로그 사용 방법

- Hive와 호환되는 메타 스토어 사용

- SparkSession 생성시 enableHiveSupport()호출

-> 기본으로 "default"라는 이름의 DB생성

from pyspark.sql import SparkSession

spark = SparkSession \

.builder \

.appName("Python Spark Hive") \

.enableHiveSupport() \

.getOrCreate()Spark SQL - Managed Table 사용 방법

-

두 가지 테이블 생성 방법

- dataframe.saveAsTable("Table Name")

- SQL 문법 사용(CREATE TABLE, CTAS)

-

spark.sql.warehouse.dir이 가리키는 위치에 데이터가 저장된다.

->PARQUET이 기본 데이터 포맷이다. -

선호하는 테이블 타입

-

SPARK 테이블로 처리하는 것의 장점(파일로 저장하는 것과 비교할 때)

-> JDBC/ODBC등으로 Spark을 연결해서 접근 가능하다.(태블로, 파워BI)

Spark SQL - External Table 사용 방법

-

이미 HDFS에 존재하는 데이터에 스키마를 정의해서 사용한다.

-> LOCATION이라는 프로퍼티를 사용한다. -

메타데이터만 카탈로그에 기록된다.

- 데이터는 이미 존재한다.

- External Table은 삭제되어도 데이터는 그대로이다.

CREATE TABLE table_name(

column1 type1,

column2 type2,

column3 type3

)

USING PARQUET

LOCATION 'hdfs_path';📌 유닛 테스트

-

코드 상의 특정 기능 (보통 메소드의 형태)을 테스트하기 위해 작성된 코드이다.

-

보통 정해진 입력을 주고 예상된 출력이 나오는지 형태로 테스트한다.

-

CI/CD를 사용하려면 전체 코드의 테스트 커버러지가 굉장히 중요해진다.

-

각 언어별로 정해진 테스트 프레임워크를 사용하는 것이 일반적이다.

- JUnit for Java

- NUnit for .NET

- unittest for Python