💡 참고할 만한 링크들

But what is a neural network? | Chapter 1, Deep learning

자습해도 모르겠던 딥러닝, 머리속에 인스톨 시켜드립니다.

💡 보통 정형데이터에서는 머신러닝이 좀 더 나은 성능을 보이기도 한다.

Fully Connected Network == Deep Neural Network (DNN)

🤔 Fully Connected Network에는 데이터를 1차원 형태로 주입해야 하는데 어떻게 비정형 데이터(표형태가 아니라 이미지, 음성, 텍스트 등)를 다룰까?

Fully Connected Network에는 데이터를 1차원 형태로만 주입이 가능하다.

전처리 레이어에서 이미지, 음성, 텍스트 등을 전처리 하는 기능을 따로 제공한다.

CNN, RNN 에서 전처리 기능을 제공하고 마지막에는 Fully Connected Network 를 통과하게 된다.

- CNN (주로 이미지), RNN (주로 텍스트)

💡 설명 가능한 인공지능 도구 중 하나: https://wandb.ai/site

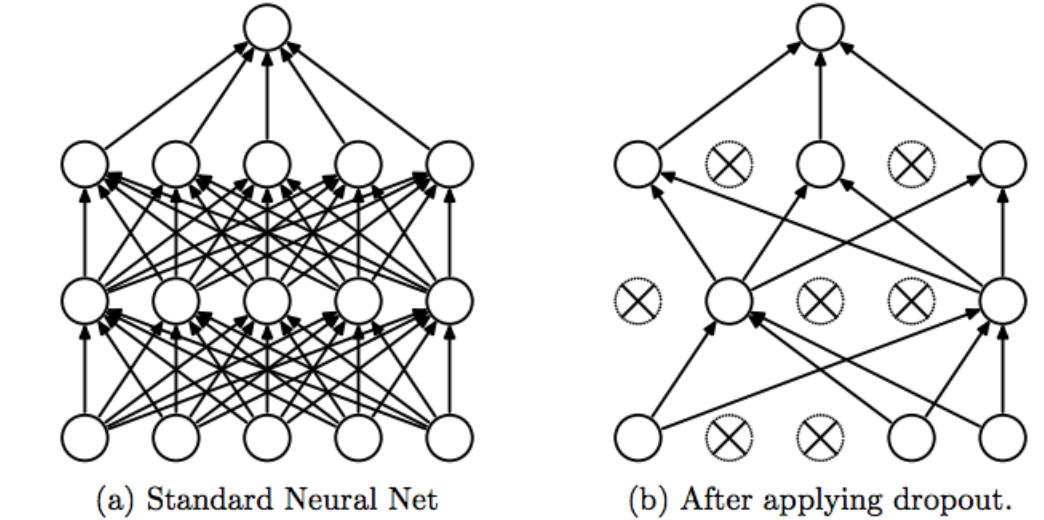

🤔 dropout은 무엇이고 왜 사용할까?

일부 노드를 제거하고 사용하는 것이며 과대적합을 방지하기 위해 사용

MNIST 손글씨 이미지 데이터셋 실습 (분류)

https://www.tensorflow.org/tutorials/quickstart/beginner

🤔 Dense layer란?

output = activation(dot(input, kernel) + bias)

출력 = 활성화함수(행렬곱(input, kernel) + 편향)

tf.keras.layers.Dense(units=128, activation='relu')💡 units(노드) 개수, 층(레이어)수는 하이퍼파라미터

# 실습

units == nodes ==

# 입력 - 은닉층 - 출력층으로 구성된 네트워크 모델

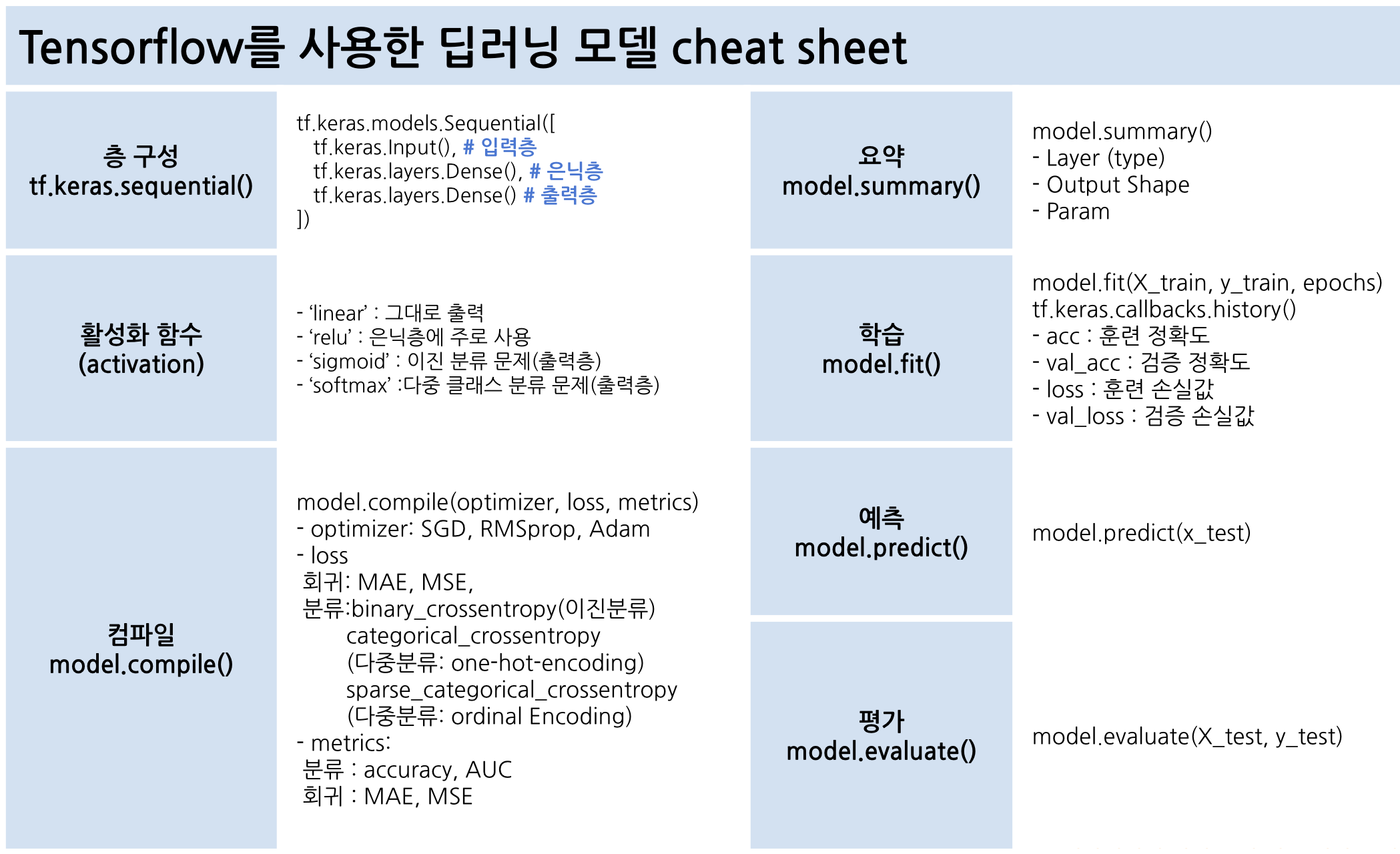

model = tf.keras.models.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)), # 입력층

tf.keras.layers.Dense(units=128, activation='relu'),

tf.keras.layers.Dropout(0.2), # 일부 노드 제거 (overfitting 방지)

# 활성화 함수. softmax는 확률값 반환

tf.keras.layers.Dense(10, activation='softmax')

])

# 신경망 모델을 만들려면 모델의 층을 구성한 다음 모델을 컴파일해야 함.

model.compile(optimizer='adam', # optimizer: 최적화 함수

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])- optimizer: 오차가 최소가 되는 지점을 찾기 위한 optimizer, 기울기, 방향, learning rate를 고려

- loss: 손실율 측정

- metrics: 평가지표

💡 epoch는 학습 횟수를 의미하고 epoch 한 번당 순전파와 역전파를 한 번씩 돌면서 loss값 출력

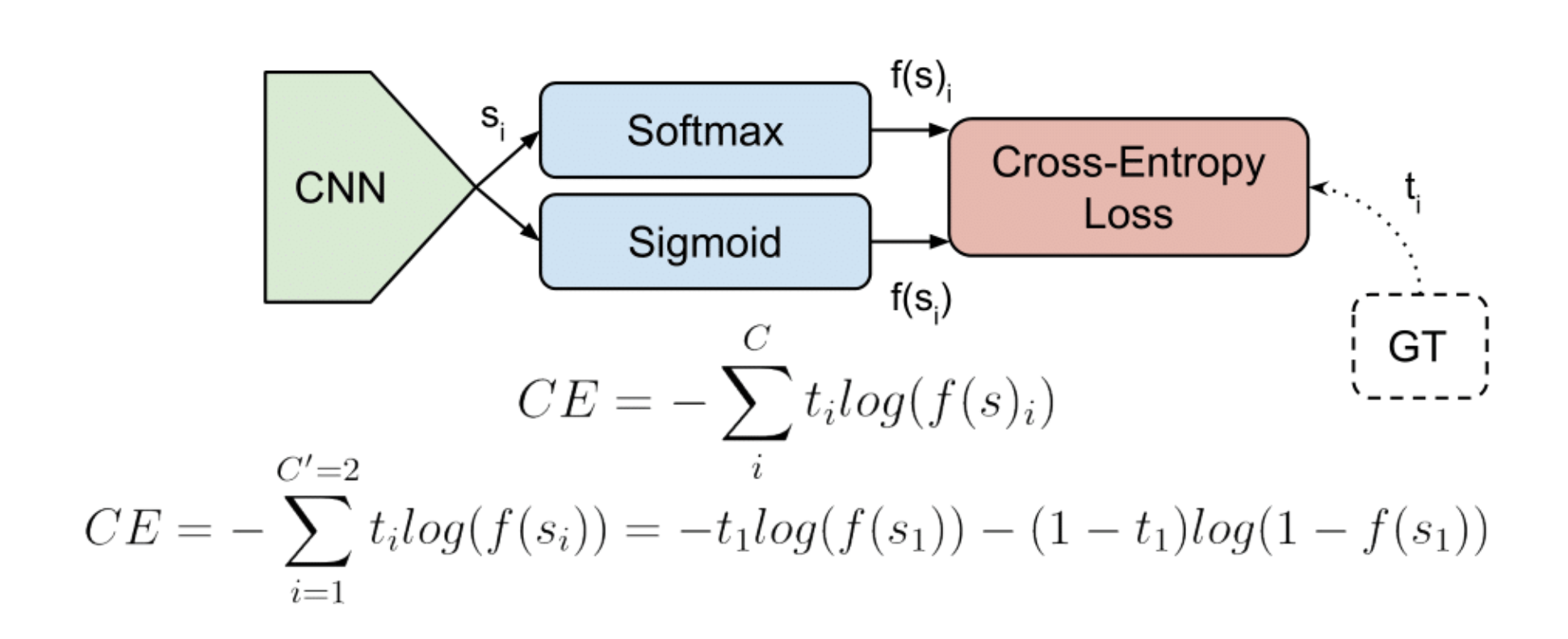

📌 분류의 손실 함수

분류에서는 보통 아래와 같이 사용:

- optimizer='adam'

- loss='sparse_categorical_crossentropy',

출처: https://gombru.github.io/2018/05/23/cross_entropy_loss/

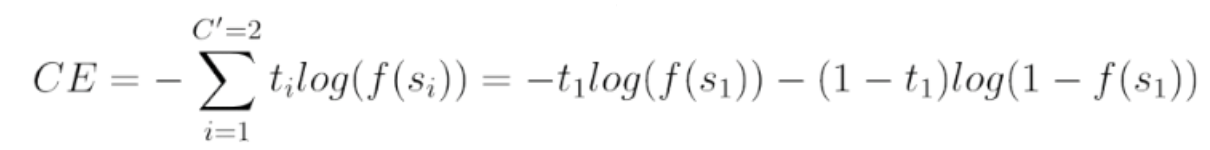

✅ Cross entropy

: 분류 결과의 품질을 측정하기 위한 Loss function

- 양수로 만들어주기 위해서 공식 앞에 마이너스를 붙인다.

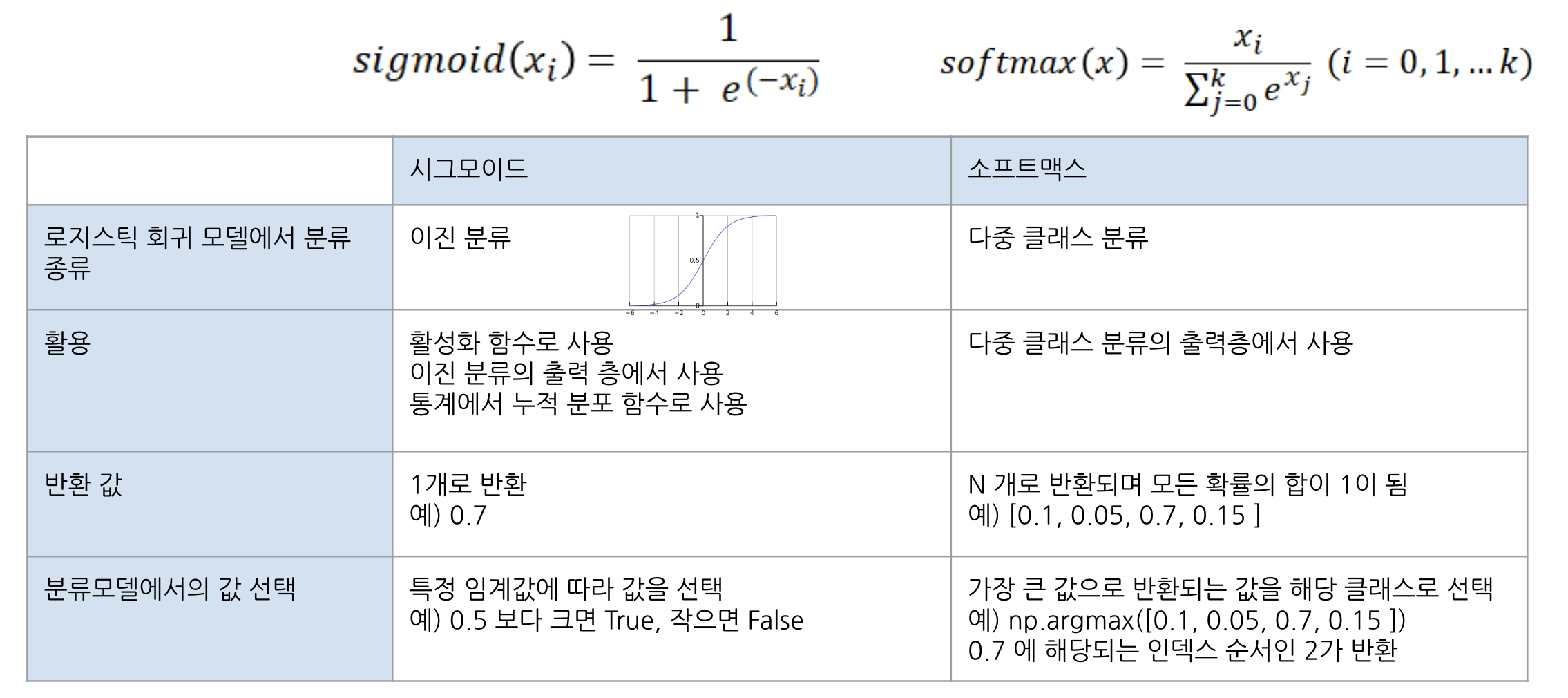

📌 Activation function - Sigmoid와 Softmax

출처: 멋쟁이 사자처럼 AI SCHOOL 박조은 강사님 수업 자료 15번째 ppt, p.69

🤔 특정 클래스에 대한 출력이 [0.1, 0.05, 0.7, 0.15] 이렇게 결과가 나왔다면 여기에서 예측값의 답을 무엇으로 하면 될까?

A: 2, softmax는 가장 큰 값을 반환하는데 2번 인덱스 (0.7)가 가장 큰 값이기 때문

🤔 특정 클래스에 대한 출력이 [0.1, 0.05, 0.7, 0.15] 이렇게 결과가 나왔다면 이 정답 클래스의 종류의 개수는 몇개일까?

A: 4, 4개 중에 하나를 분류하는 모델이기 때문

출처: https://jjeongil.tistory.com/977

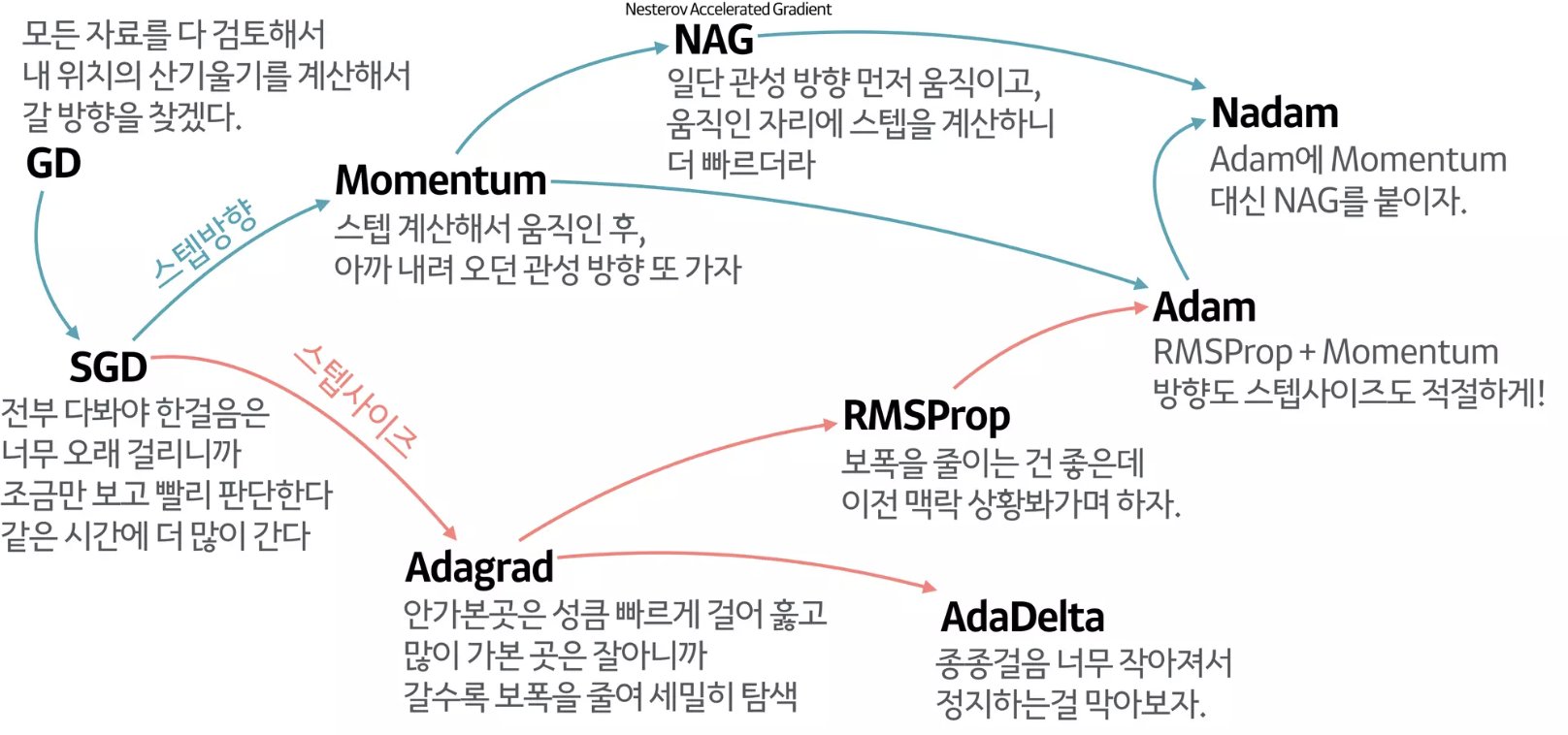

📌 최적화 함수 (Optimizer)

: 손실 함수를 최소화하는 방향으로 가중치를 갱신하는 알고리즘

: 모델이 인식하는 데이터와 해당 손실 함수를 기반으로 모델이 업데이트되는 방식

🤔 Optimizer를 사용하는 이유?

Local minimum에 빠져 global minimum를 찾지 못하는 것을 방지 하기 위해 사용 (= loss의 최솟값 찾기)

- 경사하강법에 기반을 둔 optimizer: SGD, RMSProp, Adagrad, Adam, etc.

- 경사하강법은 내려가는 방향을 찾는 법

- optimizer는 효율적(시간, 성능 고려)으로 탐색

Optimizer는 경사하강법 외 여러가지를 지정할 수도 있지만 adam에 비해 대부분 속도가 느린 편. 대체적으로 adam을 사용하면 속도도 빠르고 학습도 잘 하는 편이다.

출처: https://www.slideshare.net/yongho/ss-79607172/49

의류 이미지 분류 실습

https://www.tensorflow.org/tutorials/keras/classification

💡 plt.imshow(train_images[0]): sns.heatmap과 같이 matplotlib의 시각화 기능

# 모델 학습

model.fit(train_images, train_labels, epochs=10)- epoch가 증가할수록 loss가 줄어들고 accuracy가 올라간다.

- epoch가 증가할수록 loss가 감소하지 않고 accuracy가 나아지지 않는다면 더 이상 학습하지 않고 중단할 수도 있다 (using early_stop).

- loss는 cross entropy를 사용하는데 확률값이 얼마나 섞여있는지 확인

- 0에 가까울 수록 다른 확률값이 섞여있지 않은 것

출처: 멋쟁이 사자처럼 AI SCHOOL 박조은 강사님 수업 자료 15번째 ppt, p.81

loss 값을 보고 label 이 어떤 형태인지 알 수 있다. label 값이 binary, one-hot, oridinal encoding 이 되어있냐에 따라 loss값을 지정해야 한다.

📌 두 비정형 데이터 실습의 Summary

1) 다른 데이터에 적용한다면 층 구성을 어떻게 할것인가?

입력-은닉-출력층으로 구성

2) 예측하고자 하는 값이 분류(이진, 멀티클래스), 회귀인지에 따라 출력층 구성, loss 설정이 달라진다.

3) 분류, 회귀에 따라 측정 지표 정하기

4) 활성화함수는 ReLU를 사용, optimizer로는 adam을 사용하면 baseline 정도의 스코어가 나온다.

5) fit을 할 때 epoch를 통해 여러 번 학습을 진행

이 때,

- epoch 수가 많을 수록 대체적으로 좋은 성능을 내지만 overfitting이 될 수도 있다.

- epoch 수가 너무 적다면 underfitting이 될 수도 있다.

💡 텐서플로 VS 파이토치의 차이

: seaborn VS plotnine 처럼 라이브러리 도구의 API 차이 입니다.

시각화 할 때도 data, x, y, color(hue) 이런 용어를 알고 있다면 API 가 달라지더라도 비슷하게 사용할 수 있는 것과 유사합니다.

직접 딥러닝 모델을 밑바닥부터 짜서 구현할 수도 있지만, 기능들을 함수나 메서드로 감싸서 코드 여러 줄을 한 두줄의 API 를 호출해서 사용할 수 있게 만들어 놓은 도구 입니다.

0901 실습

💡 머신러닝 수업에서 실습 했던 당뇨병 데이터셋을 딥러닝으로 실습해보기

📌 딥러닝 레이어 만들기

1) 층 설정

- 신경망의 기본 구성 요소는 층(layer)입니다.

- 층은 주입된 데이터에서 표현을 추출합니다.

- 대부분 딥러닝은 간단한 층을 연결하여 구성됩니다.

- tf.keras.layers.Dense와 같은 층들의 가중치(parameter)는 훈련하는 동안 학습됩니다.

2) Dense Layer

- 밀집 연결(densely-connected) 또는 완전 연결(fully-connected) 층이라고 부릅니다.

- 첫 번째 Dense 층은 128개의 노드(또는 뉴런)를 가집니다.

- 마지막 층은 출력층 입니다.

- 소프트맥스 일 때 : n개의 노드의 소프트맥스(softmax) 층입니다. 이 층은 n개의 확률을 반환하고 반환된 값의 전체 합은 1입니다.

각 노드는 현재 이미지가 n개 클래스 중 하나에 속할 확률을 출력합니다. - 시그모이드 일 때 : 둘 중 하나를 예측할 때 1개의 출력값을 출력합니다. 확률을 받아 임계값 기준으로 True, False로 나눕니다.

3) 출력층

- 예측 값이 n개 일 때 : 출력층 노드 n개

tf.keras.layers.Dense(n, activation='softmax') - 예측 값이 둘 중 하나일 때 : 출력층 노드 1개

tf.keras.layers.Dense(1, activation='sigmoid')

# tf.keras.models.Sequential 로 입력-히든-출력(sigmoid) 레이어로 구성

model = tf.keras.models.Sequential([

# 🤔 출력층을 flatten 대신 dense를 사용한 이유?

# flatten 은 2차원을 1차원으로 만들어 주기 위한 것이기 때문에

# 1차원 데이터를 사용하는 해당 실습에서는 dense를 사용

tf.keras.layers.**Dense**(units=128, input_shape=[input_shape]), # 입력층

tf.keras.layers.Dense(128, activation='relu'), # 히든레이어

tf.keras.layers.Dropout(0.2),

tf.keras.layers.Dense(1, activation='sigmoid') # 출력층

])🤔 출력층을 flatten 대신 dense를 사용한 이유?

flatten 은 2차원을 1차원으로 만들어 주기 위한 것이기 때문

📌 모델 컴파일

: 모델을 훈련하기 전에 필요한 몇 가지 설정 추가하는 단계

- 옵티마이저(Optimizer): 데이터와 손실 함수를 바탕으로 모델의 업데이트 방법을 결정합니다.

- 지표(Metrics): 훈련 단계와 테스트 단계를 모니터링하기 위해 사용합니다. 다음 예에서는 올바르게 분류된 이미지의 비율인 정확도를 사용합니다.

- 손실 함수(Loss function): 훈련 하는 동안 모델의 오차를 측정합니다. 모델의 학습이 올바른 방향으로 향하도록 이 함수를 최소화해야 합니다. 최적의 가중치를 찾도록 해야함

- 회귀 : MSE, MAE

- 분류 :

- 바이너리(예측할 값의 종류가 둘 중 하나) :

- binary_crossentropy

- 멀티클래스(예측할 값의 종류가 2개 이상) :

- categorical crossentropy(one-hot형태의 클래스 예: [0, 1, 0, 0])

- sparse categorical crossentropy(정답값이 0, 1, 2, 3, 4 와 같은 형태일 때)

- 바이너리(예측할 값의 종류가 둘 중 하나) :

# 모델 컴파일

model.compile(optimizer='adam',

loss='binary_crossentropy', # 당뇨병 여부

metrics=['accuracy']) # 분류측정지표

# early_stop 설정

class PrintDot(tf.keras.callbacks.Callback):

def on_epoch_end(self, epoch, logs):

if epoch % 100 == 0: print('')

print('.', end='')

# val_loss 기준으로 값이 나아지지 않으면 멈추게 한다.

early_stop = tf.keras.callbacks.EarlyStopping(monitor='val_loss',

patience=10)🙋🏻♀️ 질문

Q: 28x28 이미지로 학습을 하는데 왜 입력에 784개가 들어갈까요?

A: 28 * 28 = 784

Fully Connected Network에는 2차원 형태를 그대로 넣을 수 없기 때문에 1차원으로 형태를 변환(평탄화)해야 한다.

Q: MNIST 실습과 FMNIST 실습의 차이점?

A: MNIST는 dropout을 해줬고, FMNIST에서는 출력층에서 softmax 안써주고 10만 써줬다. FMNIST는 결과를 시각화해서 보기가 좋았다. 확률값도 시각화해서 직관적이었다.

Q: 당뇨병 여부 예측 문제에서는 출력층을 어떻게 구성해야 할까요?

A: 시그모이드 (당뇨병 여부)

🦁 질문

Q: bias가 임계값 조절이 맞나요?

A: 임계값은 활성화 함수 == activation function 의 출력 기준이 됩니다.

Q: bias를 왜 더해주나요?

A: weight는 두번째 레이어가 선택하려는 뉴런의 픽셀 패턴을 알려주며 bias는 뉴런이 활성화되려면 가중치의 합이 얼마나 더 높아야 하는지를 알려줍니다.

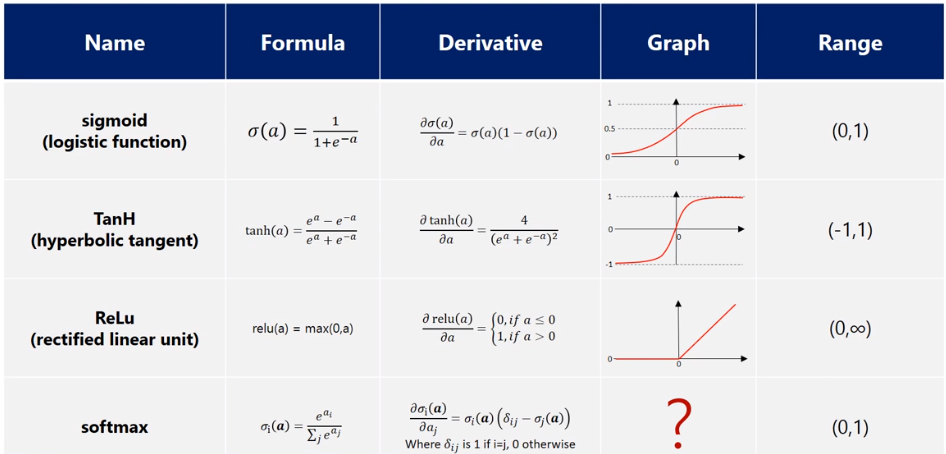

Q: Tanh도 기울기소실 문제를 해결하는 활성화 함수인가요?

A: sigmoid[0, 1]와 비슷하게 tanh[-1, 1] 로 범위가 좀더 넓습니다. 기울기 소실문제는 있지만 좀더 빠릅니다.

Q: tf.keras.layers.Dropout(0.2)

여기서는 딱 0.2 만 드랍아웃을 하는 건가요? 아니면 그 아래값도 다 dropout 하는 건가요?

A: 노드의 개수 * 0.2 만큼 (20%)의 수를 제거합니다. 그 아래 값은 출력층이라 상관 없어요. 해당 층에 있는 노드(units)만 제거합니다.

Q: 모델을 컴파일 해줄 때 마다 정답클래스가 다르게 나오는데 모델 성능이 안좋아서일까요?

A: 한 번만 학습을 했기 때문입니다. 여러번 학습하면 성능이 더 좋아집니다.

여러 번 학습하면 학습을 하며 weight와 bias값을 업데이트 하기 때문에 loss가 점점 줄어듭니다.

Q: 출력층 코드에 소프트 맥스가 없는데 디폴트가 소프트맥스인가요?

A: 네. 2개라도 기본이 softmax 이고 실습할 때는 바이너리 분류를 할 예정이라 sigmoid 로 지정할 예정입니다.

✏️ TIL

- 사실(Fact): MNIST, FMNIST와 0901 파일을 통해 딥러닝 기초에 대해 실습했다.

- 느낌(Feeling): 알 듯 말 듯 하다.

- 교훈(Finding): 꾸준히 공부하자!