Introduction to Machine Learning with Python

0801 실습

💡 사이킷런으로 인코딩하는 과정은 복잡하지만 numpy와 pandas의 데이터를 다루는 연습을 해볼 수 있다는 장점이 있다.

❗️ one-hot-encoding 후 train과 test의 행의 수가 일치 하는지 꼭 체크!!

🤔 왜 이번 실습에서는 Cross validation 대신 hold-out-validation 사용했을까?

- hold-out-validation은 속도가 cross validation에 비해 빠르다는게 장점이기 때문에 빠르게 확인해보기 위함

- cross validation에 비해 신뢰성은 떨어진다.

- valid를 만드는 이유는 제출해 보기 전에 어느정도의 스코어가 나올지 확인해보기 위함

✅ Summary:

- One-hot-encoding을 범주형 변수에 하고, 수치형 데이터와 합치는 과정을 실습했다.

- 수치형 데이터와 concat할 때 인덱스 값이 맞지 않으면 병합이 제대로 되지 않을 수 있기 때문에 인덱스 값에 유의 필요!

- 기존에는 cross validation 위주로 사용했는데, 여기서는 hold-out-validation을 사용했다.

- train, valid, test: train, test split은 train, test만 나누는데 이 실습에서는 train을 다시 train, valid로 나눠주었다.

- LinearRegression 모델을 사용했을 때 성능이 저조해서 RandomForest로 모델을 바꾸니 성능이 훨씬 좋았다.

- 이번 실습에서 LinearRegression 모델을 적용했을 때 특이하게 one-hot-encoding을 수치데이터를 제외하지 않고 모든 데이터를 인코딩 했을 때 성능이 더 잘 나왔다.

0802 실습

실습 목적: 다른 트리모델을 사용해보기 (GBT, ExtraTree)

💡 스코어를 따로 지정하지 않으면 회귀는 기본값이 R2 Score 이다.

1) GBT

from sklearn.ensemble import GradientBoostingRegressor

model_gbt = GradientBoostingRegressor(random_state=42)

2) ExtraTree

from sklearn.ensemble import ExtraTreesRegressor

model_et = ExtraTreesRegressor(random_state=42)- 배깅 방식은 부트스트래핑을 해서 트리를 병렬적으로 여러 개 만들기 때문에 오버피팅 문제에 좀 더 적합합니다.

- 개별 트리의 낮은 성능이 문제일 때는 이전 트리의 오차를 보완해 가면서 만들기 때문에 부스팅이 좀 더 적합니다.

🤔 선형회귀 (Linear Regression) 란?

: 종속 변수 y와 한 개 이상의 독립 변수 X와의 선형 상관 관계를 모델링하는 회귀분석 기법

💡 장점

1) 다른 모델들에 비해 간단한 작동 원리를 가지고 있어 이해하기 쉽다.

2) 학습 속도가 매우 빠르다.

3) 조정해줄 파라미터가 적다.

4) 데이터가 수치형 변수로만 이루어져 있을 경우, 데이터의 경향성이 뚜렷할 경우에 사용하기 좋다.

💡 단점

1) 트리모델에 비해 성능이 떨어진다.

2) 이상치에 매우 민감하다.

3) 수치데이터에 대해 전처리가 많이 필요하다.

4) 예측력이 떨어진다.

5) sns.regplot()을 그려보면 선형 그래프를 그리기 때문에 다른 모델 (e.g. RandomForest) 들에 비해 설명력이 떨어진다.

👀 선형 회귀 모델의 단점을 보완한 모델:

- Ridge, Lasso, ElasticNet 등

🤔 결정트리 (Decision Tree) 란?

💡 장점

1) 결과를 해석하고 이해하기 쉽다.

2) 자료를 가공할 필요가 거의 없다.

3) 수치 자료와 범주 자료 모두에 적용할 수 있다.

4) 화이트박스 모델을 사용한다.

5) 안정적이다.

6) 대규모 데이터셋에서도 잘 동작한다.

7) 각 특성이 개별적으로 처리되기 때문에 데이터 스케일에 구애받지 않는다.

8) 데이터 내 변수의 종류가 달라도 잘 동작한다.

💡 단점

1) 학습용 데이터에 과대적합된다.

👀 결정트리의 단점을 보완한 기법:

- Ensemble

🤔 RandomForest 란?

💡 장점

1) 성능이 뛰어나고 매개변수 튜닝을 많이 하지 않는다.

2) 결정 트리와 달리 시각화가 불가능해 비전문가는 이해하기 어려울 수 있다.

3) 데이터의 크기가 터지면 다소 시간이 걸릴 수 있다.

4) 랜덤성이 있기 때문에 random_state 변수를 지정하지 않으면 매번 결과가 달라진다.

5) 차원이 높고 희소한 데이터에는 잘 작동하지 않을 수 있다.

🤔 ExtraTree 란?

: 극도로 무작위화 (Extremely Randomised Tree) 모델. 강사

💡 ExtraTree와 RandomForest의 차이점

RandomForest와 같이 후보 기능의 무작위 하위 집합이 사용되지만 가장 차별적인 임계값을 찾는 대신 각 후보 기능에 대해 임계값이 무작위로 그려지고 무작위로 생성된 임계값 중 가장 좋은 것을 분할 규칙으로 선택

👉🏻 일반적으로 약간 더 큰 평향 증가를 희생시키면서 모델의 분산을 조금 더 줄인다.

💡 장점

1) 분기 지점을 랜덤으로 선택하기 때문에 RandomForest보다 속도가 빠르다.

2) 같은 이유로 RandomForest보다 더 많은 특성을 고려할 수 있다.

3) RandomForest와 동일한 원리를 이용하기 때문에 많은 특징을 공유한다.

4) RandomForest보다 성능이 약간 더 좋다.

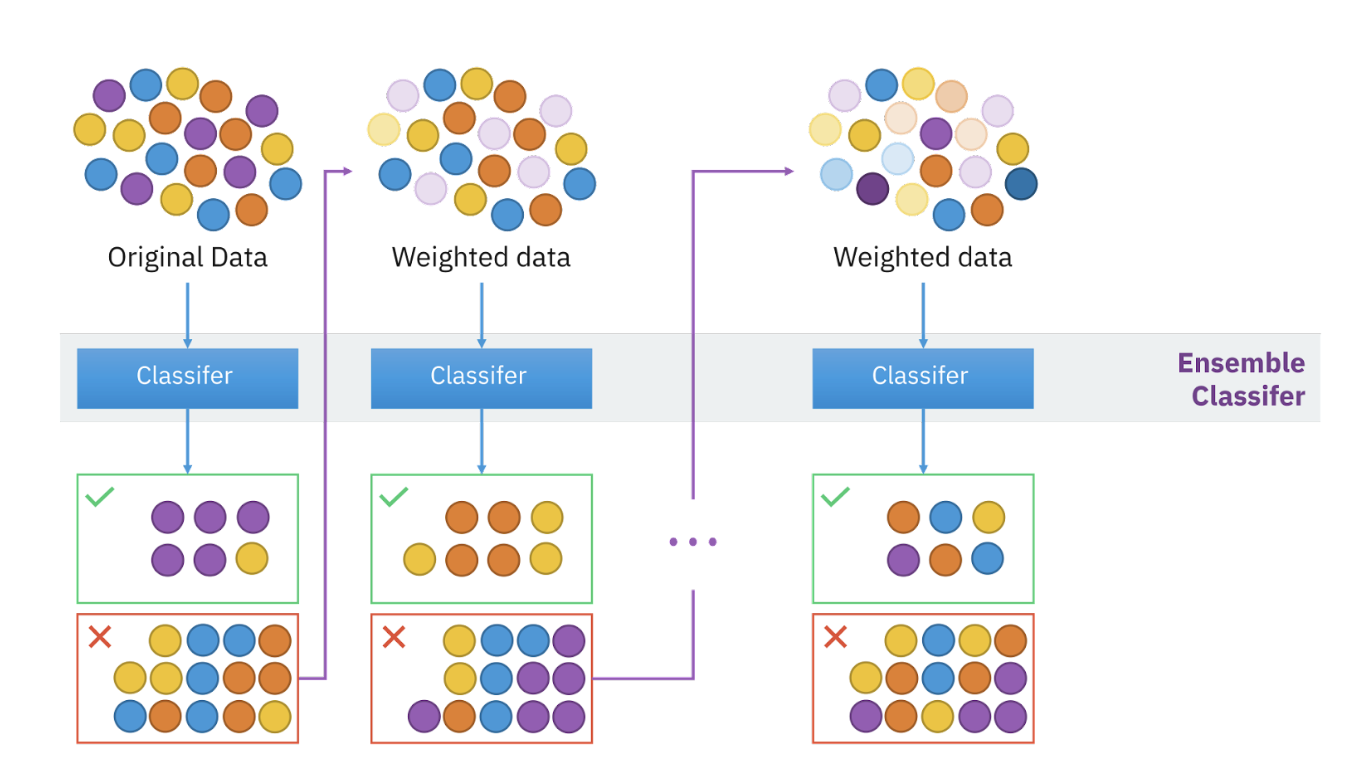

🤔 Boosting 이란?

: 이전 오차 (실수)를 보완해서 순차적으로 모델을 만들기 때문에 무작위성이 없다.

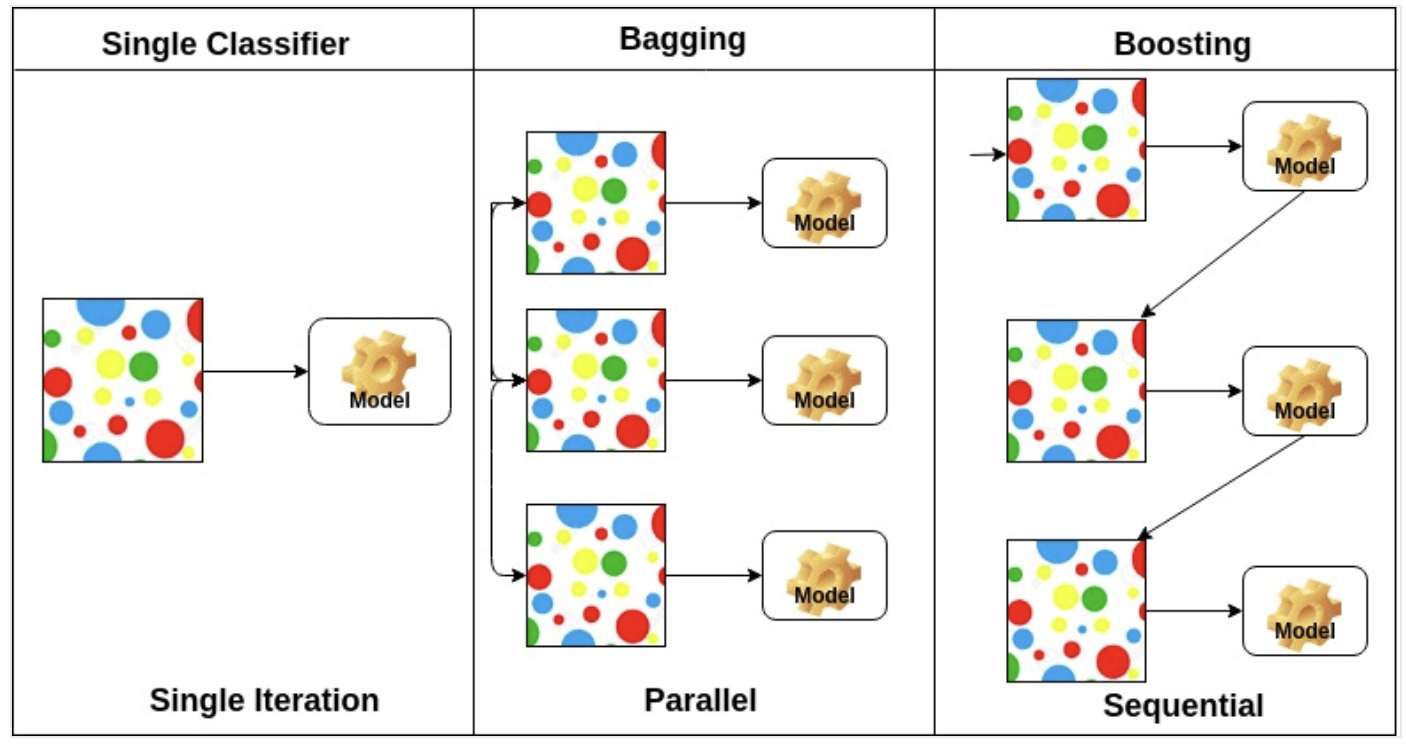

💡 Bagging과 Boosting의 차이

Bagging : 데이터 셋이 모델마다 독립적이다.

Boosting : 앞 모델이 데이터셋을 정해준다.

- 배깅은 훈련세트에서 중복을 허용해서 샘플링하여 여러개 모델을 훈련 하는 앙상블 방식입니다. 같은 훈련 샘플을 여러 개의 모델에 걸쳐 사용해서 모든 모델이 훈련을 마치면 앙상블은 모든 예측기의 예측을 모아서 새로운 샘플에 대한 예측을 만들게 됩니다.

- 부스팅은 약한 모델을 여러개 연결해서 강한 모델을 만들어 내기 위한 앙상블 방식입니다. 부스팅의 아이디어는 앞의 모델들을 보완해 나가면서 일련의 모델들을 학습시켜 나가는 것입니다.

🤔 GBT (Gradient Boosting Tree) 이란?

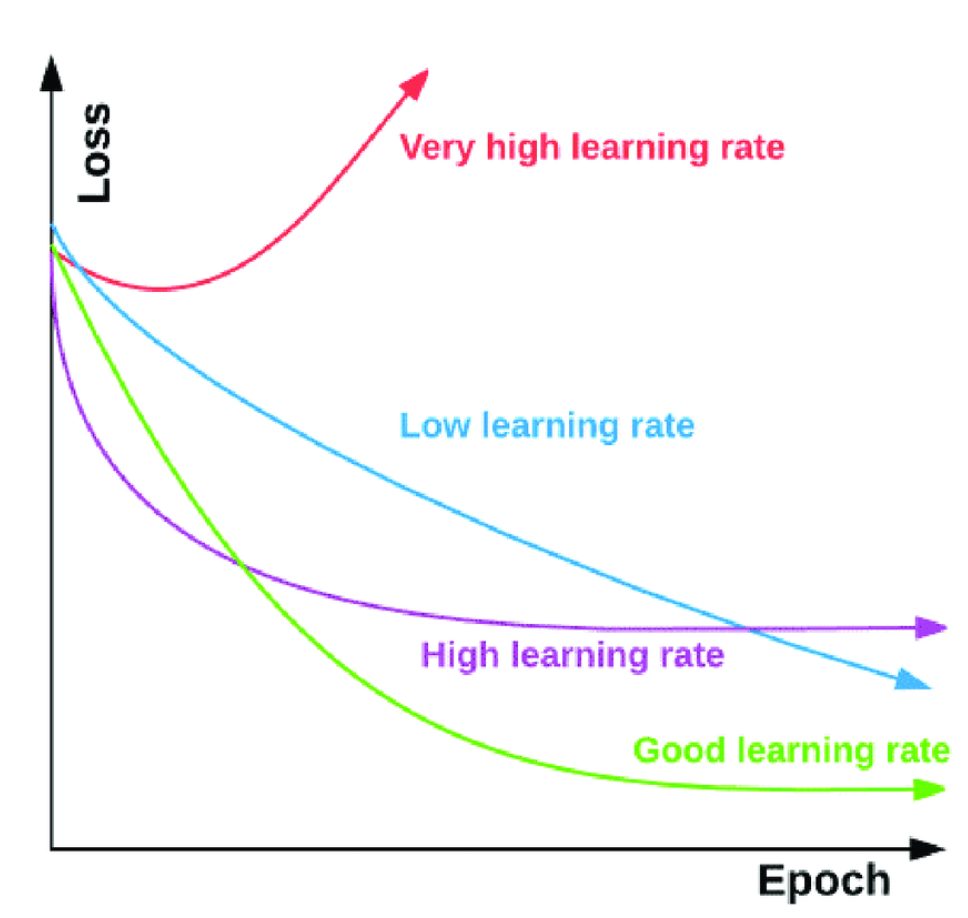

경사하강법(gradient descent): 손실이 가장 작은 지점을 찾기 위해서 기울기가 0인 지점을 찾아 경사를 점점 내려가는 방법

- 예측값과 정답값 사이에 손실이 최소화될수록 좋은 모델입니다.

- 경사하강법의 목적은 손실함수가 가장 작고, 예측을 잘 하는 모델의 파라미터를 찾기 위함입니다.

- epoch: 학습횟수

- n_estimators: n 번째 트리 (sequential한 tree, 이전 트리의 오차를 학습해 만들어진 트리)

- learning rate: 학습률을 의미하며 보폭이라고 번역되기도 한다.

💡 보폭이 너무 크면 손실을 대충 찾기 때문에 최솟점을 지나칠 수도 있다. 그래서 very high learing rate처럼 발산 하기도 한다.

🤔 GBM (Gradient Boosting Machine) 이란?

: 회귀 또는 분류 분석을 수행할 수 있는 예측 모델. 예측모형의 앙상블 방법 중 부스팅 계열에 속하는 알고리즘.

- ML 알고리즘 중 가장 예측 성능이 좋다.

💡 장점

1) RandomForest와 다르게 무작위성이 없다.

👉🏻 이전 오차 (실수)를 보완해서 순차적으로 모델을 만들기 때문에 무작위성이 없다. (오답노트와 같은 개념; 틀린 문제를 위주로 학습)

2) 데이터의 스케일에 구애받지 않는다.

💡 단점

1) 매개변수를 잘 조정해야하고 훈련시간이 길다.

2) 고차원의 희소한 데이터에 잘 작동하지 않는다.

💡 희소한 데이터란? 0이 많은 데이터

🤔 성능에 고려 없이 GBM 에서 훈련시간을 줄이려면 어떻게 하면 좋을까?

learing rate를 높인다.

: 보폭 (learning rate)을 크게하면 훨씬 빨리 걷게 되기 때문에 학습시간은 줄어들지만 제대로 된 loss가 0이 되는 지점을 제대로 찾지 못 할 수도 있다. (= 학습시간은 줄어들지만, 성능이 낮아질 수 있음)

🤔 XGBoost (Extreme Gradient Boosting)

: GBT에서 병렬 학습을 지원하여 학습 속도가 빨라진 모델

- 모든 가능한 트리를 나열하여 최적 트리를 찾는 것은 거의 불가능하기 때문에, 2차 근사식을 바탕으로 한 손실함수를 토대로 매 iteration마다 하나의 leaf로부터 가지를 늘려나가는 것이 효율적

- 손실 함수가 최대한 감소하도록 하는 split point(분할점)를 찾는 것이 XGBoost의 목표

💡 장점

1) GBT에 비해 더 효율적이다.

2) 다양한 종류의 데이터에 대응할 수 있으며 이식성이 높습니다.

3) GBM 대비 빠른 수행시간 (병렬처리)

4) 과적합 규제 (강한 내구성)

5) 분류와 회귀영역에서 뛰어난 예측 성능 발휘(광범위한 영역)

6) Early Stopping(조기 종료) 기능이 있다.

7) 다양한 옵션(Hyper Parameter)을 제공하며 Customizing이 용이하다.

💡 단점

1) 학습시간이 느리다.

2) Hyper Parameter 수가 많아 Hyper Parameter 튜닝을 하게되면 시간이 더욱 오래 걸린다.

3) 모델의 Overfitting 가능성

💡 민감하게 조정해야하는 것

- booster 구조

👉 gbtree: 의사결정기반모형, gblinear: 선형모형, dart - eval_metric(평가함수) / objective(목적함수)

- eta

- L1 form (L1 레귤러라이제이션 폼이 L2보다 아웃라이어에 민감)

- L2 form

💡 과적합 방지를 위해 조정해야하는 것

- n_estimators 높이기

- learning rate 낮추기

- max_depth 낮추기

- min_child_weight 높이기

- gamma 높이기

- subsample, colsample_bytree 낮추기

🤔 LightGBM (Light Gradient Boosting Machine)

: 결정 트리 알고리즘을 기반으로 하며 순위 지정 , 분류 및 기타 기계 학습 작업에 사용

- 트리 기반 학습 알고리즘을 사용하는 그래디언트 부스팅 프레임워크

💡 장점

1) 더 빠른 훈련 속도와 더 높은 효율성

2) 적은 메모리 사용량

3) 더 나은 정확도

4) 병렬, 분산 및 GPU 학습 지원

5) 대규모 데이터를 처리

💡 단점

1) overfitting에 민감하다.

2) 작은 데이터에 대해서 과적합되기 쉬움

💡 GOSS (Gradient based One Side Sampling) 기울기 기반 단측 샘플링

- 데이터에서 큰 Gradient를 가진 모든 인스턴스를 유지하고 무작위로 Sampling을 수행한다.

- 많이 틀린 데이터 위주로 샘플링한다. (행을 줄인다.)

- 대규모 데이터 인스턴스를 다루기 위한 것

💡 EFB (Exclusive Feature Bundling) 배타적 특성 묶음

- 희소한 행렬 (0인 값이 많은 데이터)를 합쳐주는 방법

- 대규모 feature 수를 다루기 위한 것 (열을 줄인다.)

💡 GBDT(Gradient Boosting Decision Tree)는 Feature차원이 높고 데이터 크기가 클 경우, 가능한 모든 분할 지점의 Information Gain을 추정하기 위해 모든 데이터 인스턴스를 탐색해야 될 때 많은 시간을 소비해야 한다는 문제가 있음

💡 GBM 계열의 트리 분할 방식

- 장점: 최대한 균형 잡힌 트리를 생성하면서 트리의 깊이를 최소화 할 수 있다.

- 단점: 과적합 문제에 더 강한 구조를 갖게 되지만 균형을 맞추기 위한 시간이 필요하다.

🤔 CatBoost

기존 알고리즘과 비교하여 순열 기반 대안을 사용하여 범주형 기능을 해결하려고 시도하는 그레디언트 부스팅 프레임워크를 제공프레임워크를 제공

- 범주형 데이터를 따로 인코딩할 필요가 없지만 모델 훈련시 어떤 데이터가 범주형인지 알려주어야 함.

- XGBoost 처럼 깊이별 트리 성장방식을 사용하지만 대칭적인 구조를 가짐

자체적으로 grid_search() 와 randomized_search()를 제공

💡 장점

1) 과적합을 극복하기 위해 부스팅 주문

2) 범주형 기능에 대한 기본 처리

3) 빠른 GPU 훈련

4) 모델 및 기능 분석을 위한 시각화 및 도구

5) 과적합을 극복하기 위해 순서가 있는 부스팅을 사용

6) 이름 그대로 범주형 특성을 잘 처리함

7) 더 빠른 실행을 위해 Oblivious Trees 또는 Symmetric Trees 사용

💡 단점

1) CatBoost 는 희소 행렬을 지원 하지 않음

2) 데이터 세트에 수치형 타입이 많을 때 CatBoost는 LightGBM보다 훈련하는 데 상대적으로 많은 시간이 소요

💡 특징

- 수평트리 (Level-wise Tree)

- 정렬된 부스팅 (Orderd Boosting)

- 임의 순열 (Random Permutation)

- 정렬된 대상 인코딩 (Ordered Target Encoding)

- 범주형 Feauture 조합 (Categorical Feauture Combinations)

- 원핫 인코딩 (One-hot Encoding)

- 최적화된 파라미터 튜닝 (Optimized Parameter tuning)

- 중복되는 범주형 변수 처리

: Class를 명확하게 구분할 수 있는 중복되는 변수가 2개 이상 존재한다고 할 때, 이를 하나의 변수로 통합해 처리 - 피처가 늘어나는 문제를 줄여 computing cost도 낮출 수 있다.

❗️ ML과 DL에 매우 중요한 개념

기울기 => 미분으로 loss의 크기나 방향(+, -)

학습률 => 보폭, 걸을 때 얼마의 보폭으로 걸으면 빨리 걸을 수도 있고 천천히 걸을 수도 있는데 학습할 때도 크면 빠르게 학습하지만 최저점을 지나칠 수 있다는 단점이 있습니다.

🙋🏻♀️ 질문

Q: GBM, XGBoost, LightGBM, 모델이름에 들어가는 G 는 무엇을 의미할까요?

A: 가중치 업데이트할 때 경사하강법(gradient descent) 사용하기 때문

Q: Gradient(경사, 기울기) 는 어떻게 사용할까요?

A: 손실함수 그래프에서 값이 가장 낮은 지점으로 경사를 타고 하강합니다. 머신러닝에서 예측값과 정답값간의 차이가 손실함수인데 이 크기를 최소화시키는 파라미터를 찾기 위해 사용합니다.

Q: GPU?

A: 그래픽카드이며 병렬계산처리에 용이합니다. 게임, 암호화폐, 인공지능 등에 사용됩니다.

Q: Residual 은 무엇일까요?

A: Residual == 잔차 (표본집단의 회귀식에서 예측된 값)

Q: 왜 absolute loss를 지원을 하는데 squared loss 를 더 많이 사용할까요?

A: 기울기가 +, - 방향에 따라 같은 기울기가 나오기 때문에 방향은 알 수 있지만 기울기가 같아서 미분을 했을 때 방향에 따라 같은 미분값이 나와서 기울기가 큰지, 작은지 비교할 수 없습니다. 그래서 squared loss 를 더 많이 사용합니다.

Q: 뾰족하게 나오게 되면 미분을 못하지 않나요?

A: 미분을 하면 기울기가 0이 되는 지점이 뾰족한 지점입니다.

Q: 미분을 하는 이유?

A: 기울기를 구하기 위해

Q: 왜 부스팅 계열 모델이 설치가 잘 되기도 하지만 설치에 실패하는 경우가 생길까요?

A: 다른 언어로 작성되었는데 파이썬 wrapper API 를 제공하고 있습니다. 구동하려면 다른 언어 환경이 함께 필요한 경우가 많습니다. 기존에 다른 도구를 설치하다가 해당 언어 환경 도구를 설치해 놨던 분들은 비교적 잘 설치가 되지만, 처음 설치할 때는 실패하는 경우가 많습니다. conda 는 비교적 패키징이 잘 되어 있어서 관련된 환경을 잘 구성해 줍니다. 그래서 되도록이면 conda로 설치해야 스트레스가 줄어듭니다.

🦁 질문

Q: shape 메소드는 행렬이면 다 쓸 수 있는건가요?

A: numpy array에서도 사용 가능

Q: 모델에 들어가는 X값은 numpy 배열이어도 상관이 없나요?

A: 모델에 들어가는 값은 원래 모두 numpy 배열

Q: 부스팅 계열 자체가 무작위성이 없나요?

A: 이전 오차 (실수)를 보완해서 순차적으로 모델을 만들기 때문에 무작위성이 없다.

Q: gbt 스코어는 0으로 가까울수록 성능이 좋다고 판단하는건가요?

A: R2 Score라 1에 가까울수록 잘 예측한 것이다.

Q: kaggle에서 제출하고 점수를 볼 때 public말고 private으로 보면 되나요?

A: 최종 결과는 private score로 결정됩니다.

- 대회마다 public score와 private score를 매기는 방식이 다 다르지만, 일반적으로 public score는 전체 데이터 중 일부만을 샘플링하여 채점하고, private score는 전체 데이터 중 더 많은 데이터를 대상으로 채점합니다.

- 참가자들이 얻은 public score는 리더보드에 공개되며 이를 바탕으로 현재 위치를 가늠할 수 있습니다.

Q: Gradient 가 경사라는 의미인데, 크다는 건 경사도가 높다, 경사가 급하다는 뜻이 아닌가요?

A: 실제값과 예측값의 차이가 크다라는 뜻이며 예측을 잘 못했다는 의미.

👉🏻 그래서 boosting 모델은 틀린 (예측을 잘 못한) 문제로 다음 모델을 만들어 학습하고 예측한다. 틀린 문제를 맞출 때 까지 풀어보게 한다.

Q: 발산의 우려가 높은 그래프를 가져가야 더 빠르게 예측할 수 있나요?

A: 속도는 빠르지만 손실 값은 클 수 있다. (성능이 낮을 수 있다.) 적당한 learning rate를 사용해야한다. 그렇다고 러닝레이트를 너무 작게 설정하면 학습이 오래 걸립니다.

✏️ TIL

- 사실(Fact): Gradient Boosting 모델에 대해 배웠다.

- 느낌(Feeling): 알아야 할 개념이 더 늘었다. 정신 바짝 차리지 않으면 못 따라갈 것 같다.

- 교훈(Finding): 중요한 개념 복습하기.. 두 번 하기..!