해당 강의는 미래연구소 15기에서 진행한 내용입니다 :)

https://futurelab.creatorlink.net/

1주차 내용 복습

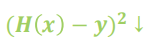

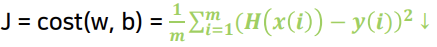

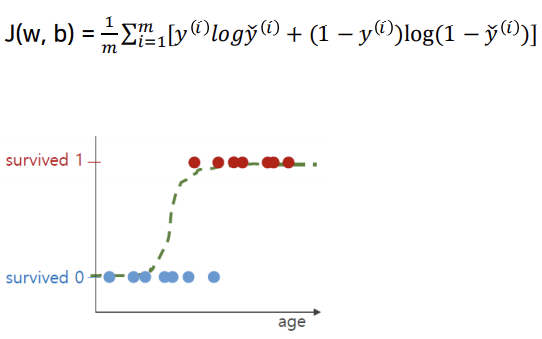

최적의 function

실제 output과 예측 output의 거리가 최소

data는 m개이며 거리의 평균인 cost를 최소로 만든다.

=> cost를 최소로 만드는 w와 b를 찾는 다 -> 최적의 function을 찾는다.

Gradient Descent

최소 cost를 가지는 function을 구하는 방법

Neural Network

Classification

Cat or Non-cat

input : image

RGB는 픽셀이 존재한다.

1. 점 하나 하나를 수치화 한다.

2. 3차원(빨강, 초록, 파랑) array -> Flatten (펴주는 작업이 필요.)

output : y=Cat or y=Non-cat -> y=1 or y=0

1. Initiallization

gradient descent를 시작할 w와 b를 초기화

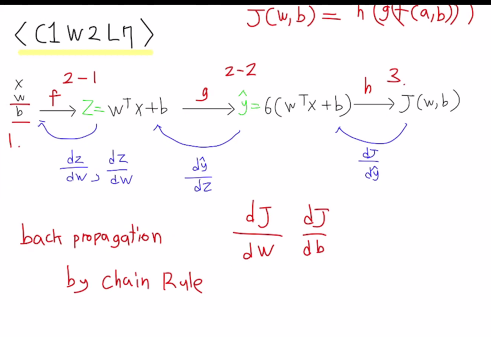

2. Forward Propagation

주어진 x, w, b로 y에 대한 예측값을 계산한다.

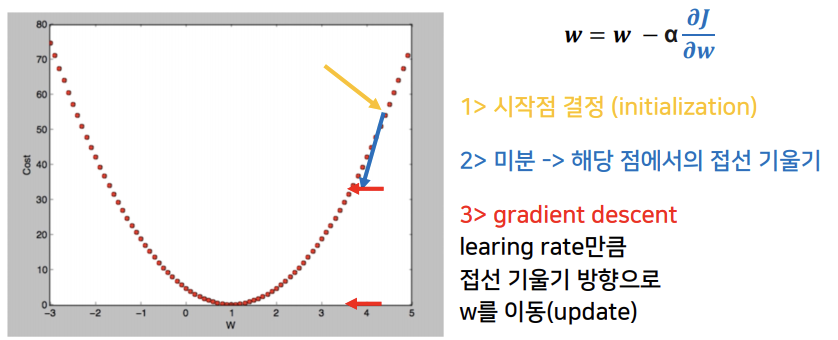

x는 nx 차원의 벡터

Output : 입력 x를 통해 선형 함수가 커지거나 음수 값을 가질 수 있다.

0 or 1로 만들어주는 sigmoid 함수를 적용.

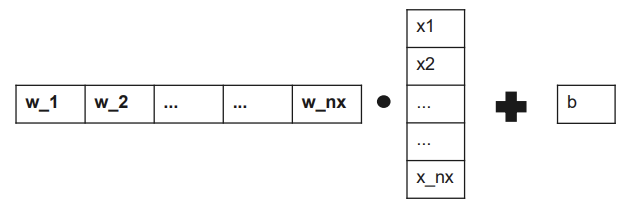

3. Compute Cost

MSE의 문제점 :

MSE는 단편적인 정확성만 보고 판단할 확률이 높아짐

-> binary cross entopy loss

4. Backward Propagation

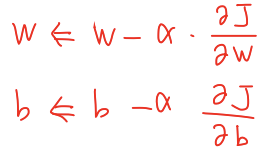

gradient descent에 parameter(w,b)를 update할 방향 구하기.

방향 = 접선 기울기

5. Gradient Descent

backpropagation에서 구한 gradient의 방향으로 learning rate 크기 만큼 parameter(w,b)를 update