해당 강의는 미래연구소 15기에서 진행한 내용입니다 :)

https://futurelab.creatorlink.net/

어느덧 딥러닝 스터디도 마지막을 향하고 있다.

후반부로 갈수록 다른 일에 치여 집중하지 못해 아쉬움이 남는다.

프로젝트도 많은 시간을 투자하지 못해 아쉽지만 남은 대회 기간 동안 더 노력해야 겠다.

Normalization Layers

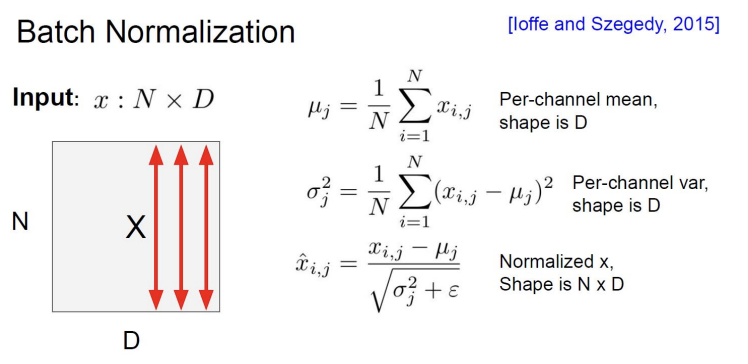

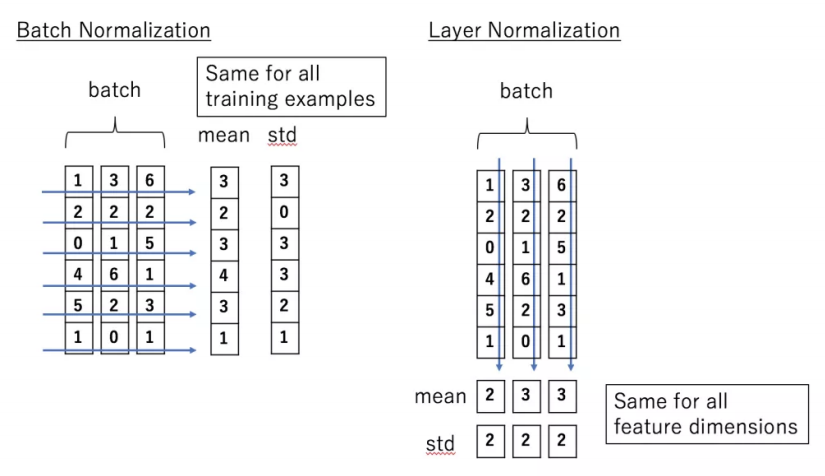

Batch Normalization

평균, 분산을 조정하는 과정이 NN 안에 포함되어 학습 시 평균과 분산을 조정하는 과정이 같이 조절. 미니배치의 평균과 분산을 이용하여 정규화 하고 scale 및 shift를 감마 값, 베타 값을 통해 실행한다.

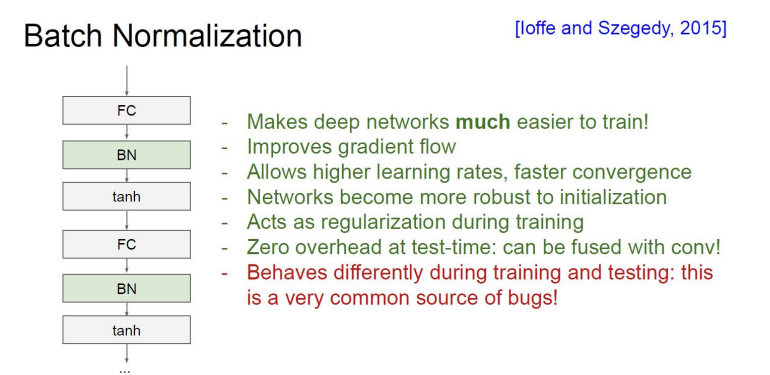

효과

단점

- batch_size가 작으면 평균, 분산이 너무 부정확.

- RNN은 같은 layer에서도 cell의 이동에 따라 다른 feature들을 받으므로 통계량이 매번 다르다.

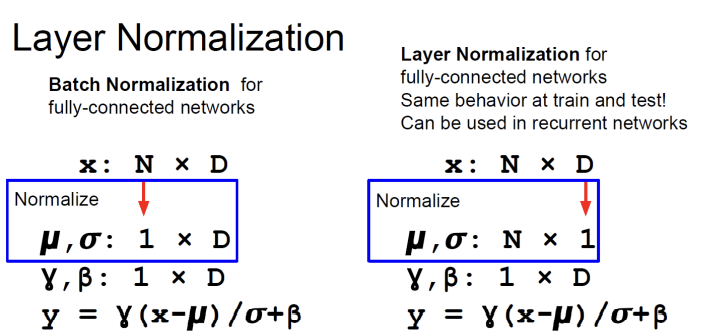

Layer Normalization

모든 feature의 dimensions가 같다.

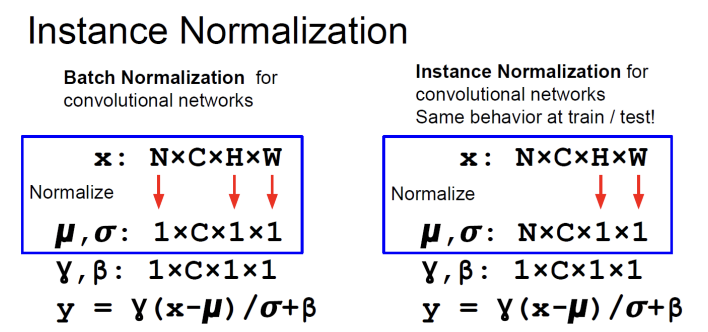

Instance Normalization

각 데이터마다 normalization을 따로 하고, 심지어 filter들의 종류와도 관계없이 다 따로 normalization을 진행한다.

Transfer Learning

Deep Learning의 한계

- Data가 많이 필요

- train에 소요되는 시간

종류

- Cifar 10

- VGG16

- ResNet50