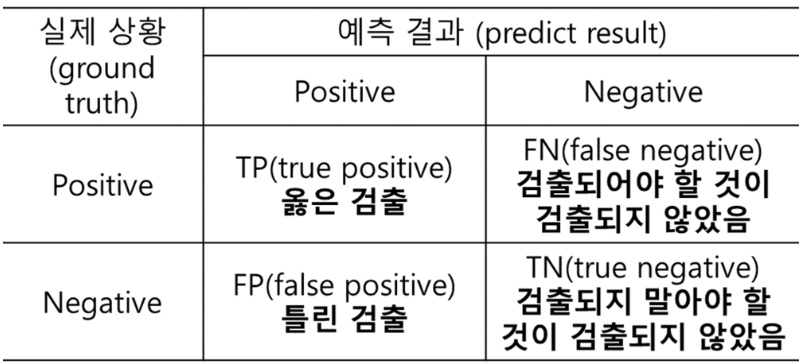

용어 정리

예측 결과

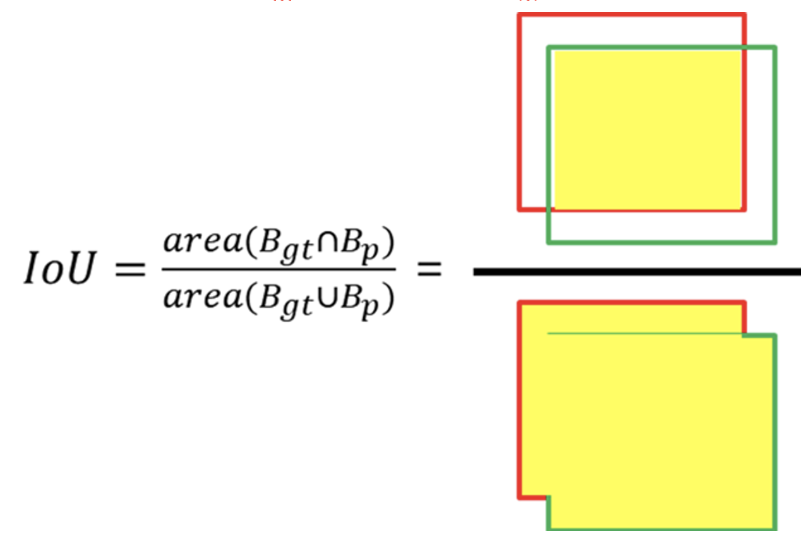

IoU(Intersection over Union)

- 검출한 Boundary Box가 맞는 지 틀린 지를 결정함

- 예측된 Boundary Box와 Ground Truth Boundary Box가 중첩되는 부분의 면적을 측정해서 중첩된 면적을 합칩합의 면적으로 나눔

- 0.5 이상이면 제대로 검출(TP), 0.5 미만이면 잘못 검출(FP)

Precision (정밀도)

- 모든 검출 결과 중 옳게 검출한 비율. 예측한 것 중에 정답의 비율

- 10을 검출하고 9개를 옳게 검출 : 0.9

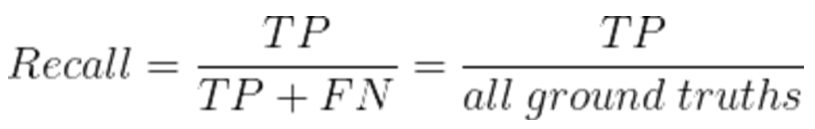

Recall(재현율)

- 검출해내야 하는 물체들 중에서 제대로 검출된 것의 비율

- 총 검출해야 하는 물체 10개 중 4개 옳게 검출 : 0.4

Precision-Recall 곡선

-

Precision 과 Recall은 반비례 하는 경향이 있음. 두 값을 종합해서 알고리즘의 성능 평가 필요

-

Confidence 레벨에 대한 threshold 값의 변화에 의한 모델의 성능을 평가하는 방법

💡 Confidence: 검출한 것에 대해 알고리즘이나 얼마나 확신이 있는 지를 알려주는 값

-

detect 할 때 Confidence 레벨에 대해 Threshold 값을 부여해서 특정값 이상이 되어야 검출된 것으로 인정

-

Confidence 레벨에 대한 Threshold 값의 변화에 따라 Precision과 Recall 값들도 달라지는 것을 그래프로 나타낸 것

Average Precision (AP)

- 성능을 하나의 값으로 표현한 것으로 Precision-Recall 곡선에서 그래프 선 아래 쪽의 면적으로 계산

- Average Precision 이 높으면 성능이 높다는 걸 의미

- mAP(mean Average Precision) : 물체 클래스가 여러 개인 경우 평균값으로 계산한 지표

- mAP@0.5 : IoU를 0.5 이상으로 했을 때의 지표

- mAP@0.95 : IoU를 0.95 이상으로 했을 때의 지표