Classification

- 기존에 배운 regression, binary classification -> output layer node 개수 : 1개

- multiclass classification

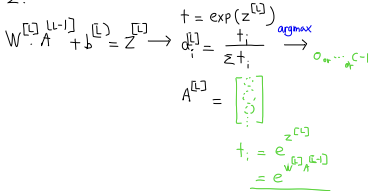

class 개수 = c = n[L] = output layer node 개수 -> output layer와 class는 연관이 있을 것이다.

class 개수가 10이면 output layer를 10으로 만들어야 한다. 출력되는 값은 y=0~9가 될 확률로 나열되는 것. -> softmox 사용! -> sigmoid에서 유도 ! - binary classification과 multiclass classification의 유사성 : output 자체는 binary classification과 multiclass classification과 유사함

multiclass classification

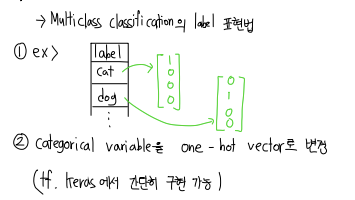

1. One-hot encoding

클래스 마다 다르게 표현하는 것 !

2. loss function

example ) 실제 데이터 y = 0,1,0,0 이런식으로, 예측 y는 0.3, 0.2 .. 이런식

이때 사용되는 것 entropy cross loss function !

binary classification과 유사함.

fit

- (상대적) train set error ↑ = underfit

optimal - trainig performance 가 클때 -> 1. try bigger network, 2. train longer - (상대적) dev set error ↑ = overfit

optimal - trainig performance 가 작고 trainig-vaild performance 가 클 때 -> 1. get more data, 2. regularization, 3. dropout, 4. others

데이터 기법

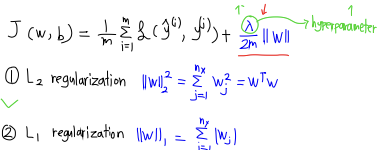

Regularization

model이 과도하게 복잡해지는 것 방지, 보통 L2 사용

1. L2 regularization

2. L1 regularization

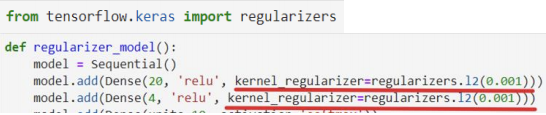

3. 구현

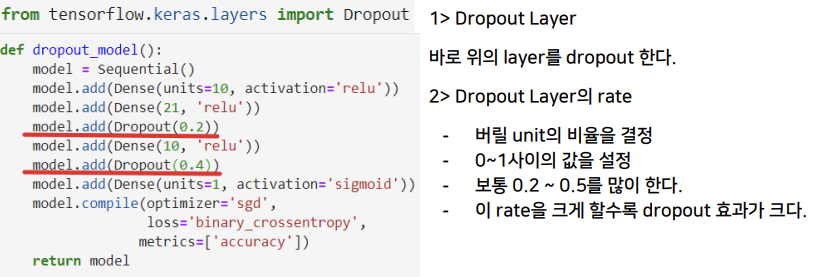

Dropout

- 매 학습마다 설정한 drop rate 만큼 random하게 node를 지워서 학습

- 매 학습마다 다른 node들이 지워졌다가 복원되었다가를 반복

- (구현) reqularizer 와 달리 dropout layer 가 따로 존재한다. (실질적인 layer X)