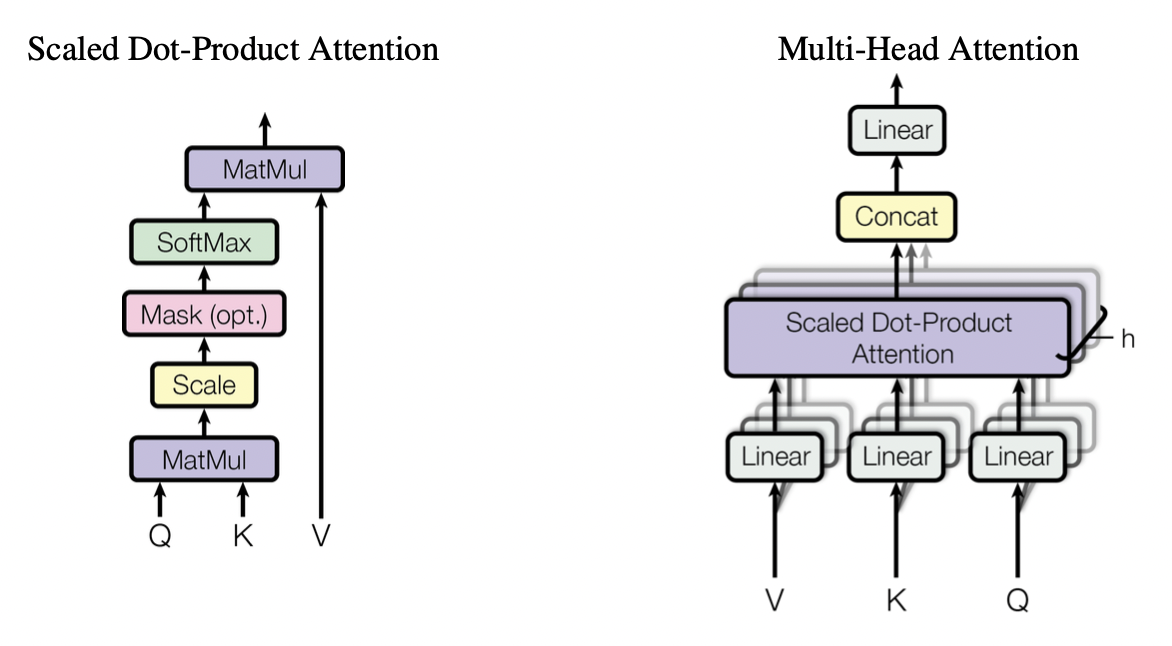

Attention

- Scaled Dot-Product Attention

- Multi-Head Attention

먼저 Transformer에서 사용되는 Attention인

Scaled Dot-Product Attention 과

Multi-Head Attention의 구현이다.

import numpy as np

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

def scaled_dot_product_attention(query, key, value, mask=None):

matmul_qk = tf.matmul(query, key, transpose_b=True)

d_k = tf.cast(tf.shape(key)[-1], tf.float32)

scaled_attention_logits = matmul_qk / tf.math.sqrt(d_k)

if mask is not None:

scaled_attention_logits += (mask * -1e9)

attention_weights = tf.nn.softmax(scaled_attention_logits, axis=-1)

output = tf.matmul(attention_weights, value)

return output, attention_weights

class MultiHeadAttention(layers.Layer):

def __init__(self, d_model, num_heads):

super(MultiHeadAttention, self).__init__()

self.num_heads = num_heads

self.d_model = d_model

assert d_model % self.num_heads == 0

self.depth = d_model // self.num_heads

self.wq = layers.Dense(d_model)

self.wk = layers.Dense(d_model)

self.wv = layers.Dense(d_model)

self.dense = layers.Dense(d_model)

def split_heads(self, x, batch_size):

x = tf.reshape(x, (batch_size, -1, self.num_heads, self.depth))

return tf.transpose(x, perm=[0, 2, 1, 3])

def call(self, query, key, value, mask):

batch_size = tf.shape(query)[0]

query = self.split_heads(self.wq(query), batch_size)

key = self.split_heads(self.wk(key), batch_size)

value = self.split_heads(self.wv(value), batch_size)

output, attention_weights = scaled_dot_product_attention(query, key, value, mask)

output = tf.transpose(output, perm=[0, 2, 1, 3])

concat_attention = tf.reshape(output, (batch_size, -1, self.d_model))

return self.dense(concat_attention)Positional Encoding

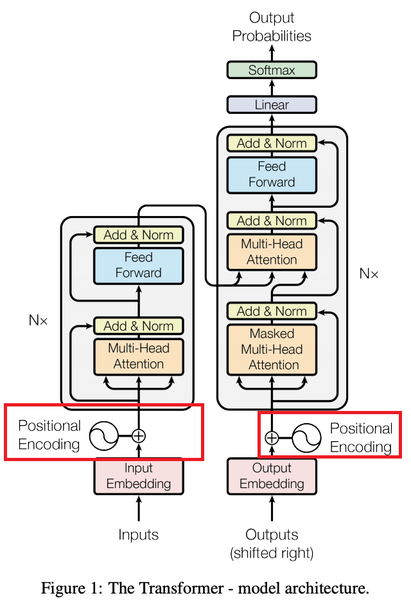

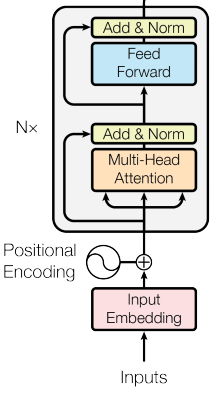

Transformer는 RNN, CNN을 사용하지 않아서 모델이 sequence의 순서를 참고하기 위해 sequence의 상대적, 절대적인 위치 정보를 담아 주어야함. 이를 위해 Positional Encoding을 사용한다.

def positional_encoding(position, d_model):

angle_rads = np.arange(position)[:, np.newaxis] / np.power(10000, (2 * (np.arange(d_model)[np.newaxis, :] // 2)) / np.float32(d_model))

angle_rads[:, 0::2] = np.sin(angle_rads[:, 0::2])

angle_rads[:, 1::2] = np.cos(angle_rads[:, 1::2])

pos_encoding = angle_rads[np.newaxis, ...]

return tf.cast(pos_encoding, dtype=tf.float32)Look-ahead masking

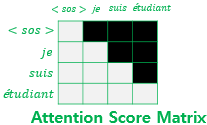

Transformer는 sequence 벡터 입력을 받으면 sequence의 모든 단어를 참조하여 다음 단어의 예측을 하는 방식이라, 다음 단어 예측을 위해 이전 단어들 뿐만이 아닌 이후의 단어들 까지 모조리 참조하여 예측을 하게되는 문제가 생긴다. 이를 방지하기 위해 예측 하고자 하는 현재 단어 이후의 단어들을 참조하지 못하도록 masking 을 사용한다.

def create_padding_mask(seq):

seq = tf.cast(tf.math.equal(seq, 0), tf.float32)

return seq[:, tf.newaxis, tf.newaxis, :]

def create_look_ahead_mask(x):

seq_len = tf.shape(x)[1]

look_ahead_mask = 1 - tf.linalg.band_part(tf.ones((seq_len, seq_len)), -1, 0)

padding_mask = create_padding_mask(x) # 패딩 마스크도 포함

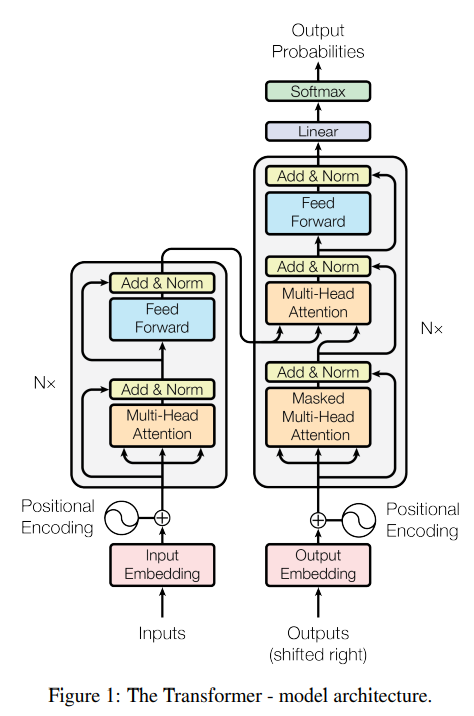

return tf.maximum(look_ahead_mask, padding_mask)Encoder

- Encoder Layer

인코더 레이어는 두개의 서브층으로 이루어 지는데 멀티 헤드 어텐션과 피드 포워드 신경망으로 이루어 져있다. 그런데 인코더의 입력 문장에 패딩 토큰이 있을 수 있어 이를 언텐션 하지 않도록 해주기 위해 Multi Head Attention의 Padding Mask(패딩 마스크)를 사용해준다.

def encoder_layer(dff, d_model, num_heads, dropout, name="encoder_layer"):

inputs = tf.keras.Input(shape=(None, d_model), name="inputs")

# 인코더는 패딩 마스크 사용

padding_mask = tf.keras.Input(shape=(1, 1, None), name="padding_mask")

# 멀티-헤드 어텐션 (첫번째 서브층 / 셀프 어텐션)

attention = MultiHeadAttention(

d_model, num_heads, name="attention")({

'query': inputs, 'key': inputs, 'value': inputs, # Q = K = V

'mask': padding_mask # 패딩 마스크 사용

})

# 드롭아웃 + 잔차 연결과 층 정규화

attention = tf.keras.layers.Dropout(rate=dropout)(attention)

attention = tf.keras.layers.LayerNormalization(

epsilon=1e-6)(inputs + attention)

# 포지션 와이즈 피드 포워드 신경망 (두번째 서브층)

outputs = tf.keras.layers.Dense(units=dff, activation='relu')(attention)

outputs = tf.keras.layers.Dense(units=d_model)(outputs)

# 드롭아웃 + 잔차 연결과 층 정규화

outputs = tf.keras.layers.Dropout(rate=dropout)(outputs)

outputs = tf.keras.layers.LayerNormalization(

epsilon=1e-6)(attention + outputs)

return tf.keras.Model(

inputs=[inputs, padding_mask], outputs=outputs, name=name)

- Encoder

인코더는 위의 인코더층을 num layers 개수만큼 쌓아서 만드는 구조 이다.

def encoder(vocab_size, num_layers, dff,

d_model, num_heads, dropout,

name="encoder"):

inputs = tf.keras.Input(shape=(None,), name="inputs")

# 인코더는 패딩 마스크 사용

padding_mask = tf.keras.Input(shape=(1, 1, None), name="padding_mask")

# 포지셔널 인코딩 + 드롭아웃

embeddings = tf.keras.layers.Embedding(vocab_size, d_model)(inputs)

embeddings *= tf.math.sqrt(tf.cast(d_model, tf.float32))

embeddings = PositionalEncoding(vocab_size, d_model)(embeddings)

outputs = tf.keras.layers.Dropout(rate=dropout)(embeddings)

# 인코더를 num_layers개 쌓기

for i in range(num_layers):

outputs = encoder_layer(dff=dff, d_model=d_model, num_heads=num_heads,

dropout=dropout, name="encoder_layer_{}".format(i),

)([outputs, padding_mask])

return tf.keras.Model(

inputs=[inputs, padding_mask], outputs=outputs, name=name)Decoder

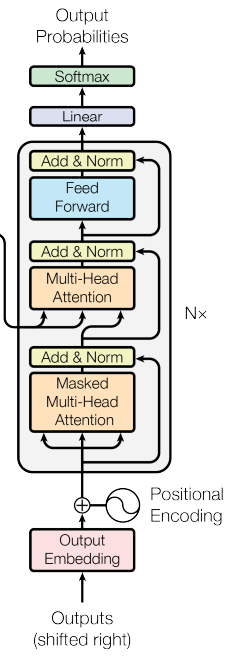

- Decoder Layer

디코더는 세 개의 서브층으로 구성된다. 첫번째, 두번째 층은 Multi Head Attention(멀티 헤드 어텐션)으로 이루어 져있는데, 위에서 말했듯이 첫번째 서브층에서는 현재 예측하고자 하는 단어 이후의 단어들을 참조하지 않게 하기 위해 mask의 인자값으로 look ahead mask(룩 어헤드 마스크)가 사용된다. 두번째 서브층은 mask의 인자값으로 encoder layer와 동일하게 padding mask가 사용된다. 그리고 세번째 서브층은 역시나 피드 포워드 신경망으로 이루어 진다.

def decoder_layer(dff, d_model, num_heads, dropout, name="decoder_layer"):

inputs = tf.keras.Input(shape=(None, d_model), name="inputs")

enc_outputs = tf.keras.Input(shape=(None, d_model), name="encoder_outputs")

# 룩어헤드 마스크(첫번째 서브층)

look_ahead_mask = tf.keras.Input(

shape=(1, None, None), name="look_ahead_mask")

# 패딩 마스크(두번째 서브층)

padding_mask = tf.keras.Input(shape=(1, 1, None), name='padding_mask')

# 멀티-헤드 어텐션 (첫번째 서브층 / 마스크드 셀프 어텐션)

attention1 = MultiHeadAttention(

d_model, num_heads, name="attention_1")(inputs={

'query': inputs, 'key': inputs, 'value': inputs, # Q = K = V

'mask': look_ahead_mask # 룩어헤드 마스크

})

# 잔차 연결과 층 정규화

attention1 = tf.keras.layers.LayerNormalization(

epsilon=1e-6)(attention1 + inputs)

# 멀티-헤드 어텐션 (두번째 서브층 / 디코더-인코더 어텐션)

attention2 = MultiHeadAttention(

d_model, num_heads, name="attention_2")(inputs={

'query': attention1, 'key': enc_outputs, 'value': enc_outputs, # Q != K = V

'mask': padding_mask # 패딩 마스크

})

# 드롭아웃 + 잔차 연결과 층 정규화

attention2 = tf.keras.layers.Dropout(rate=dropout)(attention2)

attention2 = tf.keras.layers.LayerNormalization(

epsilon=1e-6)(attention2 + attention1)

# 포지션 와이즈 피드 포워드 신경망 (세번째 서브층)

outputs = tf.keras.layers.Dense(units=dff, activation='relu')(attention2)

outputs = tf.keras.layers.Dense(units=d_model)(outputs)

# 드롭아웃 + 잔차 연결과 층 정규화

outputs = tf.keras.layers.Dropout(rate=dropout)(outputs)

outputs = tf.keras.layers.LayerNormalization(

epsilon=1e-6)(outputs + attention2)

return tf.keras.Model(

inputs=[inputs, enc_outputs, look_ahead_mask, padding_mask],

outputs=outputs,

name=name)

- decoder

위의 디코더층을 num layer 개수만큼 쌓아서 만드는 구조이다.

def decoder(vocab_size, num_layers, dff,

d_model, num_heads, dropout,

name='decoder'):

inputs = tf.keras.Input(shape=(None,), name='inputs')

enc_outputs = tf.keras.Input(shape=(None, d_model), name='encoder_outputs')

# 디코더는 룩어헤드 마스크(첫번째 서브층)와 패딩 마스크(두번째 서브층) 둘 다 사용.

look_ahead_mask = tf.keras.Input(

shape=(1, None, None), name='look_ahead_mask')

padding_mask = tf.keras.Input(shape=(1, 1, None), name='padding_mask')

# 포지셔널 인코딩 + 드롭아웃

embeddings = tf.keras.layers.Embedding(vocab_size, d_model)(inputs)

embeddings *= tf.math.sqrt(tf.cast(d_model, tf.float32))

embeddings = PositionalEncoding(vocab_size, d_model)(embeddings)

outputs = tf.keras.layers.Dropout(rate=dropout)(embeddings)

# 디코더를 num_layers개 쌓기

for i in range(num_layers):

outputs = decoder_layer(dff=dff, d_model=d_model, num_heads=num_heads,

dropout=dropout, name='decoder_layer_{}'.format(i),

)(inputs=[outputs, enc_outputs, look_ahead_mask, padding_mask])

return tf.keras.Model(

inputs=[inputs, enc_outputs, look_ahead_mask, padding_mask],

outputs=outputs,

name=name)Transformer

트랜스포머 구조 코드는 다음과 같이 구현된다.

def transformer(vocab_size, num_layers, dff,

d_model, num_heads, dropout,

name="transformer"):

# 인코더의 입력

inputs = tf.keras.Input(shape=(None,), name="inputs")

# 디코더의 입력

dec_inputs = tf.keras.Input(shape=(None,), name="dec_inputs")

# 인코더의 패딩 마스크

enc_padding_mask = tf.keras.layers.Lambda(

create_padding_mask, output_shape=(1, 1, None),

name='enc_padding_mask')(inputs)

# 디코더의 룩어헤드 마스크(첫번째 서브층)

look_ahead_mask = tf.keras.layers.Lambda(

create_look_ahead_mask, output_shape=(1, None, None),

name='look_ahead_mask')(dec_inputs)

# 디코더의 패딩 마스크(두번째 서브층)

dec_padding_mask = tf.keras.layers.Lambda(

create_padding_mask, output_shape=(1, 1, None),

name='dec_padding_mask')(inputs)

# 인코더의 출력은 enc_outputs. 디코더로 전달된다.

enc_outputs = encoder(vocab_size=vocab_size, num_layers=num_layers, dff=dff,

d_model=d_model, num_heads=num_heads, dropout=dropout,

)(inputs=[inputs, enc_padding_mask]) # 인코더의 입력은 입력 문장과 패딩 마스크

# 디코더의 출력은 dec_outputs. 출력층으로 전달된다.

dec_outputs = decoder(vocab_size=vocab_size, num_layers=num_layers, dff=dff,

d_model=d_model, num_heads=num_heads, dropout=dropout,

)(inputs=[dec_inputs, enc_outputs, look_ahead_mask, dec_padding_mask])

# 다음 단어 예측을 위한 출력층

outputs = tf.keras.layers.Dense(units=vocab_size, name="outputs")(dec_outputs)

return tf.keras.Model(inputs=[inputs, dec_inputs], outputs=outputs, name=name)

글이 너무 좋네요~ 제 블로그도 한번 들려보세요^^*