이전에 학습한 SSD 를 가지고 실습을 해보자. 우선 간단히 이미지와 비디오에 대해서 Inference 만 수행해보자!

SSD Inference

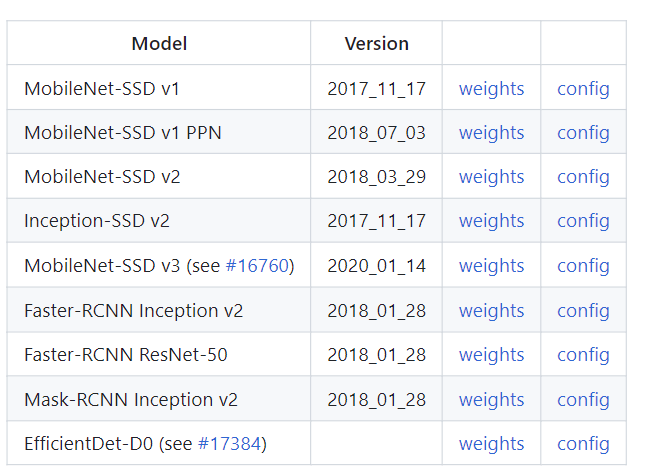

모델의 경우 Pretrained 된 Inference 모델과 환경파일을 다운로드 받아야 한다.

- https://github.com/opencv/opencv/wiki/TensorFlow-Object-Detection-API 여기에 해당 URL 이 있다.

- Weights 와 Config 를 사용하면 되는데, 모델의 경우 tar.gz 이며 압축을 한 번 해제해줘야 하고, 환경파일의 경우 pbtxt 에서 다운로드 받으면 된다.

!mkdir ./pretrained

!wget -O ./pretrained/ssd_inception_v2_coco_2017_11_17.tar.gz http://download.tensorflow.org/models/object_detection/ssd_inception_v2_coco_2017_11_17.tar.gz

!wget -O ./pretrained/ssd_config_01.pbtxt https://raw.githubusercontent.com/opencv/opencv_extra/master/testdata/dnn/ssd_inception_v2_coco_2017_11_17.pbtxt

!tar -xvf ./pretrained/ssd_inception*.tar.gz -C ./pretrained ✅ Inference 모델 로딩, 클래스명 지정

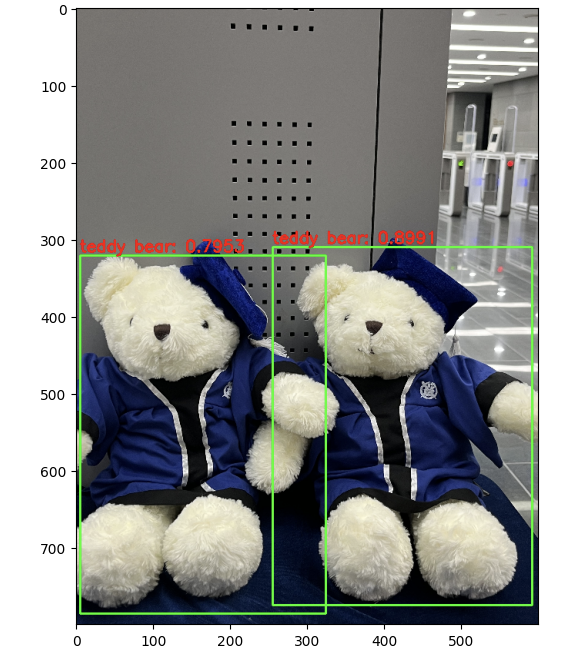

다운받은 모델을 로딩하고 클래스명을 지정한다. 이번에 다운받은 coco 데이터세트의 경우 클래스 ID 가 1번부터 시작하고 91까지 91개로 이루어져있다.

import cv2

cv_net = cv2.dnn.readNetFromTensorflow('/content/pretrained/ssd_inception_v2_coco_2017_11_17/frozen_inference_graph.pb',

'/content/pretrained/ssd_config_01.pbtxt')

labels_to_names = {1:'person',2:'bicycle',3:'car',4:'motorcycle',5:'airplane',6:'bus',7:'train',8:'truck',9:'boat',10:'traffic light',

11:'fire hydrant',12:'street sign',13:'stop sign',14:'parking meter',15:'bench',16:'bird',17:'cat',18:'dog',19:'horse',20:'sheep',

21:'cow',22:'elephant',23:'bear',24:'zebra',25:'giraffe',26:'hat',27:'backpack',28:'umbrella',29:'shoe',30:'eye glasses',

31:'handbag',32:'tie',33:'suitcase',34:'frisbee',35:'skis',36:'snowboard',37:'sports ball',38:'kite',39:'baseball bat',40:'baseball glove',

41:'skateboard',42:'surfboard',43:'tennis racket',44:'bottle',45:'plate',46:'wine glass',47:'cup',48:'fork',49:'knife',50:'spoon',

51:'bowl',52:'banana',53:'apple',54:'sandwich',55:'orange',56:'broccoli',57:'carrot',58:'hot dog',59:'pizza',60:'donut',

61:'cake',62:'chair',63:'couch',64:'potted plant',65:'bed',66:'mirror',67:'dining table',68:'window',69:'desk',70:'toilet',

71:'door',72:'tv',73:'laptop',74:'mouse',75:'remote',76:'keyboard',77:'cell phone',78:'microwave',79:'oven',80:'toaster',

81:'sink',82:'refrigerator',83:'blender',84:'book',85:'clock',86:'vase',87:'scissors',88:'teddy bear',89:'hair drier',90:'toothbrush',

91:'hair brush'}

# 1부터 91까지 91개 ID ✅ Object Detection 함수 생성

만든 함수는 이전과 완전히 같다.

import time

def get_detected_img(cv_net, img_array, score_threshold, is_print=True):

rows = img_array.shape[0]

cols = img_array.shape[1]

draw_img = img_array.copy()

cv_net.setInput(cv2.dnn.blobFromImage(img_array, size=(300, 300), swapRB=True, crop=False))

start = time.time()

cv_out = cv_net.forward()

green_color=(0, 255, 0)

red_color=(0, 0, 255)

# detected 된 object들을 iteration 하면서 정보 추출

for detection in cv_out[0,0,:,:]:

score = float(detection[2])

class_id = int(detection[1])

# detected된 object들의 score가 0.4 이상만 추출

if score > score_threshold:

# detected된 object들은 image 크기가 (300, 300)으로 scale된 기준으로 예측되었으므로 다시 원본 이미지 비율로 계산

left = detection[3] * cols

top = detection[4] * rows

right = detection[5] * cols

bottom = detection[6] * rows

# labels_to_names 딕셔너리로 class_id값을 클래스명으로 변경. opencv에서는 class_id + 1로 매핑해야함.

caption = "{}: {:.4f}".format(labels_to_names[class_id], score)

#cv2.rectangle()은 인자로 들어온 draw_img에 사각형을 그림. 위치 인자는 반드시 정수형.

cv2.rectangle(draw_img, (int(left), int(top)), (int(right), int(bottom)), color=green_color, thickness=2)

cv2.putText(draw_img, caption, (int(left), int(top - 5)), cv2.FONT_HERSHEY_SIMPLEX, 0.7, red_color, 2)

if is_print:

print('Detection 수행시간:',round(time.time() - start, 2),"초")

return draw_img

✅ Video Object Detection 함수생성

한 프레임씩 끊어 Object Detetction 한 것을 이으면 비디오에 대한 예측을 할 수 있다.

def do_detected_video(cv_net, input_path, output_path, score_threshold, is_print):

cap = cv2.VideoCapture(input_path)

codec = cv2.VideoWriter_fourcc(*'XVID')

vid_size = (round(cap.get(cv2.CAP_PROP_FRAME_WIDTH)),round(cap.get(cv2.CAP_PROP_FRAME_HEIGHT)))

vid_fps = cap.get(cv2.CAP_PROP_FPS)

vid_writer = cv2.VideoWriter(output_path, codec, vid_fps, vid_size)

frame_cnt = int(cap.get(cv2.CAP_PROP_FRAME_COUNT))

print('총 Frame 갯수:', frame_cnt, )

green_color=(0, 255, 0)

red_color=(0, 0, 255)

while True:

hasFrame, img_frame = cap.read()

if not hasFrame:

print('더 이상 처리할 frame이 없습니다.')

break

returned_frame = get_detected_img(cv_net, img_frame, score_threshold=score_threshold, is_print=True)

vid_writer.write(returned_frame)

# end of while loop

vid_writer.release()

cap.release()

do_detected_video(cv_net,'/content/data/나.mp4', '/content/data/나_.mp4', 0.4, False)프레임당 0.2-0.3 정도 걸려서 3,4,5 fps 정도가 나오는 것 같다.