Data-Efficient Multimodal Fusion on a Single GPU

본 논문의 Preview

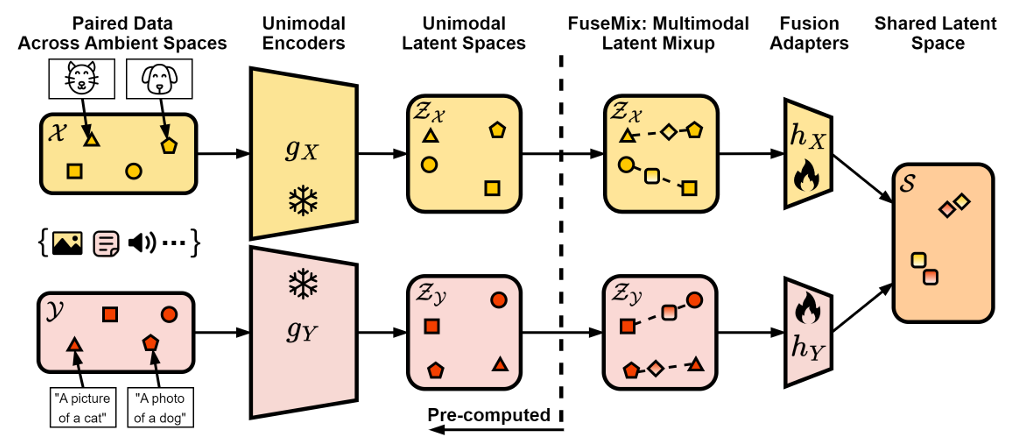

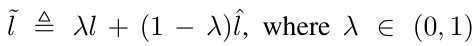

본 논문은 FuseMix라는 방법론을 제안합니다. 이는 기존의 단일 모달 인코더를 활용하여 멀티모달 모델을 구축하는 데 초점을 맞춘 데이터 효율적인 방법론이며, 대규모 데이터와 컴퓨팅 자원 없이도 멀티모달 정렬을 효과적으로 수행할 수 있는 방법을 제시합니다.

멀티모달 정렬의 주요 목표는 서로 다른 모달리티(예: 이미지와 텍스트) 간의 공통 latent space를 학습하는 것입니다. 이 과정에서 가장 강력한 모델들은 대규모 데이터셋과 많은 컴퓨팅 자원을 필요로 하는데, 이는 실제 적용에 있어 많은 비용과 자원이 드는 문제가 있습니다.

=> 본 논문에서는 이러한 문제를 해결하기 위해, 이미 대량의 단일 모달 데이터로 사전 훈련된 인코더를 활용하는 방안을 제안합니다. 이로 인해 멀티모달 모델을 훨씬 낮은 비용으로 구축할 수 있게 됩니다.

FuseMix는 이러한 멀티모달 정렬을 위한 데이터 증강 기법입니다. FuseMix는 단일 모달 인코더의 잠재 공간에서 작동하며, 모달리티 간 혼합 계수를 공유하는 방식으로 작동합니다. 이 방법을 통해 기존의 사전 훈련된 인코더들을 정렬시켜, 높은 경쟁력을 가진 멀티모달 모델을 얻을 수 있습니다.

실제로, FuseMix를 적용하면 CLIP 보다도 더 우수한 성능을 보여주기도 합니다. 예를 들어, Flickr30K 데이터셋에서 텍스트-이미지 검색 작업을 수행할 때, 약 600배 적은 GPU 자원과 약 80배 적은 이미지-텍스트 쌍을 사용하여도 CLIP보다 더 높은 성과를 기록할 수 있습니다.

또한, FuseMix는 텍스트-이미지 생성 모델을 오디오-이미지 생성 모델로 변환하는 데도 활용될 수 있음을 보여줍니다. 이는 제한된 멀티모달 데이터 쌍을 가지고도 높은 성과를 내는 데 중요한 데이터셋의 품질과 다양성이 필요하다는 점을 강조합니다.

Related Work

멀티모달 학습은 다양한 모달리티의 데이터를 동시에 처리할 수 있는 모델을 구축하는 것을 목표로 합니다. 이미지, 텍스트, 오디오, 비디오 등 서로 다른 유형의 데이터 스트림을 하나의 모델이 인식하고 처리할 수 있게 하는 것이죠. 일반적으로 멀티모달 모델을 구축하는 방법은 모든 모달리티의 데이터를 한 번에 학습시키는 것입니다.

하지만, 이렇게 모델을 처음부터 끝까지 훈련시키는 방식은 컴퓨팅 자원과 데이터의 양 측면에서 매우 비효율적입니다. 그래서 최근에는 사전 훈련된 단일 모달 네트워크를 기반으로 하는 방식이 더 실용적인 접근으로 주목받고 있습니다.

그러나, 많은 연구들이 여전히 Pretrained Model을 사용하면서도 backpropagation을 수행하고 있습니다. 이는 기본적인 단일 모달 네트워크의 크기가 큰 경우, 상당한 오버헤드(어떤 처리를 하기 위해 들어가는 간접적인 처리 시간 · 메모리 등)가 발생하게 됩니다. 네트워크의 크기가 커질수록 이 문제는 더욱 심각해집니다. 특히 CLIP과 ALIGN 같은 모델들은 대규모 이미지와 텍스트 쌍을 사용하여 멀티모달 정렬을 위한 공통 잠재 공간을 학습합니다. 이들은 이중 인코더 구조를 사용하여 텍스트와 이미지를 공동으로 임베딩시키며, contrastive objective를 통해 성능을 끌어올립니다.

이와 비교해 본 논문에서 제안하는 방법은 훨씬 더 효율적입니다. 본 논문은 freeze된 pretrained unimodal encoder를 사용하여 최소한의 멀티모달 데이터만으로도 멀티모달 모델을 구축합니다. 모든 실험은 단일 GPU로만 수행할 수 있게 설계되었습니다.

FuseMix는 데이터 증강 기법의 일환으로 제안되었습니다.

데이터 증강은 데이터셋의 크기와 다양성을 인위적으로 증가시키기 위해 도입된 방법입니다. 예를 들어, 자연 이미지 도메인에서는 가로 뒤집기, 랜덤 크롭, 색상 조정 등이 자주 사용됩니다.이 기법들은 이미지의 의미 정보를 변경하지 않도록 설계되었죠.

하지만 이러한 증강 기법은 각 도메인에 맞춰 세심하게 설계되어야 하며, 특정 도메인에서는 오히려 중요한 정보를 파괴할 수도 있습니다. 예를 들어, 의료 이미지에서 색상 조정을 무작위로 적용하면 암 분류 같은 중요한 작업에 필요한 정보를 잃어버릴 수 있습니다.본 논문에서는 이러한 문제를 해결하기 위해, Mixup에서 영감을 받은 멀티모달 데이터 증강 기법을 제안합니다. 이 기법은 latent space에서 작동하며, 다양한 모달리티에 걸쳐 공통적으로 적용될 수 있는 장점이 있습니다. 이를 통해 FuseMix는 데이터가 제한된 상황에서도 효과적인 멀티모달 학습을 가능하게 합니다.

3. Problem Setting and Background

3.1. Multimodal Fusion as Alignment

멀티모달 퓨전, 특히 본 논문에서 다루는 멀티모달 정렬은 서로 다른 모달리티의 데이터를 하나의 공통 잠재 공간으로 학습하는 작업으로 정의됩니다. 예를 들어, 이미지()와 텍스트()라는 두 가지 모달리티가 있다고 할 때, 각각의 모달리티를 공통된 잠재 공간 로 임베딩하는 두 개의 네트워크 : → 와 : → 를 학습하는 것이 목표입니다.

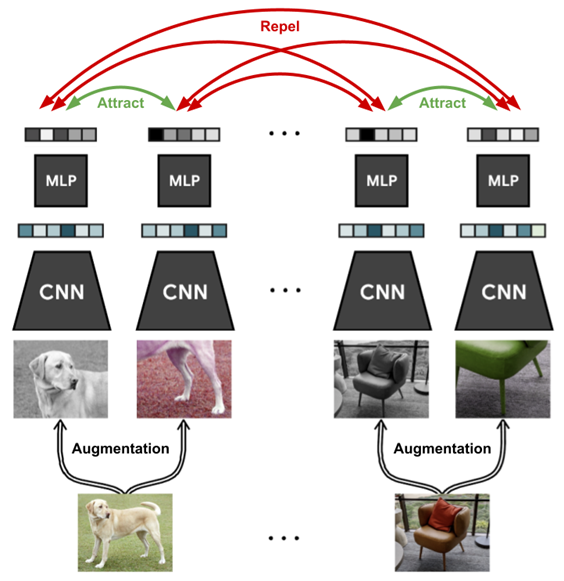

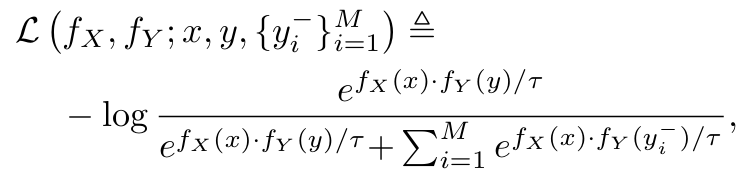

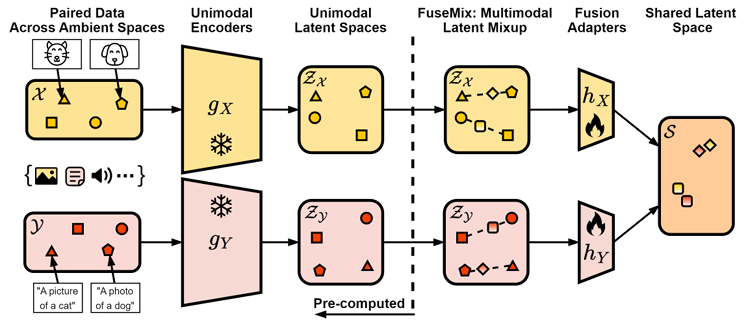

최근 멀티모달 정렬에서 중요한 학습 목표로 부각된 것이 바로 대조 학습(contrastive learning)입니다. 이 방법은 의미적으로 유사한 멀티모달 입력이 가까운 위치에 임베딩되도록 하고, 반대로 의미적으로 다른 입력은 서로 멀리 떨어지도록 학습합니다. 이를 위해서는 의미적으로 유사한 멀티모달 입력 쌍(positive pairs)과 의미적으로 다른 입력 쌍(negative pairs)이 필요합니다. 예를 들어, 이미지와 그에 대응하는 텍스트 캡션이 positive pair이고, 관련 없는 이미지와 텍스트가 negative pair가 됩니다. 대조 학습에서는 이런 positive pair를 얻기 위해 모달리티 와 의 결합 분포 에서 샘플을 얻어야 합니다. 반면, negative pair는 각 모달리티의 marginal distributions 와 에서 샘플링하여 생성합니다.

이러한 대조 학습은 InfoNCE 손실 함수로 표현됩니다. 이 함수는 주어진 positive pair 와 negative pairs 에서 아래와 같이 정의됩니다.

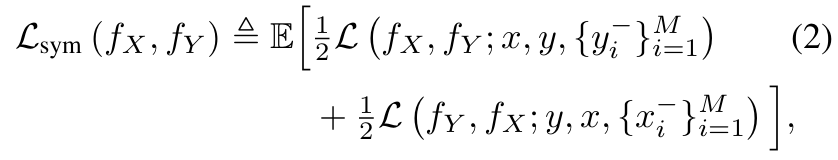

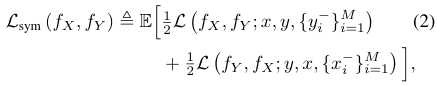

이후, InfoNCE 목표의 대칭 버전을 적용하여 최종 목표를 설정합니다:

이 식에서 기대값은 positive pair 와 M개의 negative pair 에 대해 계산됩니다.

이러한 대조 학습 기반의 정렬 방법은 다양한 멀티모달 다운스트림 작업으로 제로샷 전이(zero-shot transfer)를 가능하게 하며, 이해 기반 및 생성 기반 작업을 포함한 여러 멀티모달 설정에서 성능을 개선할 수 있습니다. 이 접근 방식은 또한 상호 정보량 최대화 관점에서도 이론적인 동기부여가 됩니다.

결국, 본 논문에서 제안한 멀티모달 정렬 기법은 높은 효율성을 가지며, 단일 GPU로도 복잡한 멀티모달 작업을 수행할 수 있는 가능성을 열어줍니다.

- 여기서 zero shot transfer에 관하여

제로샷 전이(zero-shot transfer)는 학습된 모델이 특정 작업에 대해 직접 훈련되지 않았음에도 불구하고, 그 작업을 수행할 수 있는 능력을 의미합니다. 즉, 모델이 새로운 데이터나 작업에 대해 이전에 보지 못한 상태에서도 어느 정도 성능을 발휘하는 것을 말하죠.

대조 학습 기반의 정렬 방법에서는 서로 다른 모달리티의 데이터를 공통된 잠재 공간에 임베딩합니다. 이 과정에서, 의미적으로 유사한 멀티모달 쌍(예: 이미지와 그에 해당하는 텍스트)은 잠재 공간에서 서로 가깝게 위치하게 되고, 의미적으로 다른 쌍은 멀리 떨어지도록 학습됩니다.

이렇게 학습된 잠재 공간은 단순히 학습 데이터에만 의존하는 것이 아니라, 데이터의 의미적 유사성과 차이를 반영하여 일반화된 표현을 학습합니다. 이러한 일반화된 표현 덕분에, 모델은 학습 시 사용되지 않은 새로운 멀티모달 데이터 쌍이나 작업에 대해서도 유의미한 결과를 도출할 수 있게 됩니다. 이게 바로 제로샷 전이가 가능한 이유입니다.

예를 들어, 이미지-텍스트 쌍에 대해 학습된 모델이 있다고 할 때, 이 모델은 새로운 이미지와 그에 대한 설명이 주어졌을 때, 학습되지 않은 이미지-텍스트 쌍에 대해서도 적절한 예측을 할 수 있습니다. 더 나아가, 이미지-텍스트로 학습한 모델을 텍스트만 있는 상황에서 이미지와 매칭하는 작업에 사용해도 성능이 나쁘지 않을 수 있습니다. 이는 학습된 잠재 공간이 단순히 기존 데이터에만 한정되지 않고, 데이터 간의 의미적 유사성을 잘 반영하기 때문입니다.

즉, 대조 학습 기반의 정렬 방법은 모델이 여러 모달리티를 통합하여 학습하는 과정에서, 새로운 작업이나 데이터에 대해서도 효과적으로 대응할 수 있는 강력한 일반화 능력을 제공합니다. 이는 실제 환경에서의 적용 가능성을 크게 확장시켜 주죠.

3.2 Mixup

Mixup이라는 데이터 증강 기법은 원래 지도 학습에서 사용되는 일반적인 방법입니다. 본 논문에서는 이 개념을 멀티모달 학습에 적용했죠. Mixup의 기본 아이디어는 간단합니다.

두 개의 데이터 쌍 과 이 주어졌을 때, 각각의 데이터 와 , 그리고 그에 해당하는 레이블 과 을 사용해 새로운 샘플을 생성하는 것입니다. 이때, 새로 생성된 데이터는 아래와 같은 형태로 만듭니다.

여기서 λ는 0과 1 사이의 값으로, 주로 Beta 분포 에서 샘플링됩니다. 와 는 이 분포의 하이퍼파라미터로, 이 값에 따라 샘플링된 λ의 분포가 결정됩니다.

이렇게 생성된 새로운 데이터 쌍은 원래 데이터 쌍 대신에 모델을 훈련하는 데 사용됩니다.

즉, 모델의 손실 함수는 원본 데이터가 아니라 이렇게 만들어진 새로운 데이터 쌍을 기반으로 최적화되죠. Mixup은 모델의 강건성(robustness)과 일반화 능력(generalization)을 향상시키는 데 효과적이며, 모델의 출력이 더 잘 조정(calibration)되도록 돕는다는 연구 결과들이 있습니다.

본 논문에서는 Mixup의 개념을 멀티모달 학습에 적용하는 것을 제안합니다. 특히, 기존 연구에서는 레이블이 없는 경우에도 유사한 방법을 통해 대조 학습에 Mixup을 확장하는 시도가 있었고, 최근에는 CLIP 모델을 미세 조정하는 데에도 Mixup 전략이 사용되었습니다. 그러나 이 방법은 이미 정렬된(shared latent space) 잠재 공간을 전제로 하기 때문에, 본 논문에서 제시한 설정에는 바로 적용할 수 없습니다.

본 논문에서는 이러한 Mixup 아이디어를 멀티모달 학습 환경에서 효과적으로 활용할 수 있는 방법을 제시하고 있습니다. 특히, 단일 GPU로도 다양한 모달리티를 효과적으로 결합하여 고성능의 모델을 구축할 수 있는 가능성을 탐구합니다.

- Mixup에서 베타 분포가 쓰이는 이유?

Mixup에서 Beta 분포가 사용된 이유는 주로 두 가지입니다: 가변성과 유연성입니다.

- 가변성

Beta 분포 는 두 개의 양의 실수 매개변수 와 로 정의되며, 이 값들에 따라 분포의 모양이 다양하게 변할 수 있습니다. 예를 들어, 인 경우 Beta 분포는 균등 분포와 같아지며, 값이 0과 1 사이에서 고르게 샘플링됩니다. 반면, 와 의 값이 달라지면 가 0 또는 1에 가까운 값으로 샘플링될 확률이 더 높아집니다. 이렇게 다양한 분포 모양을 가지기 때문에, Mixup의 interpolation 계수 를 제어하기에 적합합니다.

- 유연성

Beta 분포는 [0, 1] 구간에서만 정의되며, 이 구간 내에서 다양한 형태의 분포를 만들어낼 수 있습니다. 이는 Mixup에서 생성된 새로운 샘플이 원본 데이터 쌍의 범위를 벗어나지 않도록 보장해 줍니다. 예를 들어, 가 0.5에 가까운 값을 가지면 두 데이터 쌍이 거의 동일한 비율로 섞이게 되고, 가 0이나 1에 가까운 값을 가지면 한 데이터 쌍에 더 가깝게 섞이게 됩니다. 이런 식으로, Beta 분포를 사용함으로써 생성된 샘플들이 원본 데이터에서 크게 벗어나지 않도록 조절할 수 있습니다.이러한 이유들로 인해 Mixup에서는 Beta 분포를 사용하여 값을 샘플링하며, 이를 통해 데이터 간의 혼합 비율을 효과적으로 조절하고, 모델의 일반화 성능을 높이기 위한 데이터 증강을 수행하게 됩니다.

- 짚고갈 내용 : 본 논문에서 제시한 설정?

본 논문에서 제시한 설정은 효율적인 멀티모달 융합(multi-modal fusion)을 단일 GPU로 수행하는 것입니다. 이 설정은 기존의 멀티모달 학습 방법들이 주로 많은 양의 데이터와 대규모의 계산 자원을 필요로 했던 것과는 다릅니다.

기존의 방법들은 대규모의 멀티모달 데이터셋과 수많은 GPU를 사용해 여러 모달리티 간의 관계를 학습했습니다. 반면, 본 논문은 이러한 대규모 자원이 없는 환경에서도 멀티모달 융합이 가능하도록 사전 학습된 단일 모달리티 모델들(unimodal encoders)을 활용하는 접근 방식을 제안합니다.

즉, 이미 단일 모달리티(예: 이미지, 텍스트, 오디오 등)에 대해 잘 학습된 모델들이 있으니, 이 모델들의 잠재 공간(latent space)을 활용하여 서로 다른 모달리티 간의 관계를 학습하자는 것입니다. 이를 통해 기존 모델의 사전 학습된 지식을 활용하여 새로운 멀티모달 모델을 학습시키는 데 필요한 데이터와 계산 자원을 크게 줄일 수 있습니다.

이 설정의 핵심은 대조 학습(contrastive learning)을 사용해 모달리티 간의 정렬을 수행하면서, Mixup 기법을 적용한 데이터 증강을 통해 모델의 성능을 높이는 것입니다. 중요한 점은, 새로운 멀티모달 모델을 학습하는 과정에서 기존 모델들의 파라미터를 고정(freeze)시킨 채로 진행한다는 것입니다. 이를 통해 계산 비용을 줄이면서도 효율적인 학습이 가능하게 됩니다.

- 이전 Mixup 활용 내용, 현재 상황과 다른이유

최근에도 CLIP 모델을 미세 조정하는 데에도 Mixup 전략이 사용되었습니다. 그러나 이 방법은 이미 정렬된(shared latent space) 잠재 공간을 전제로 하기 때문에, 본 논문에서 제시한 설정에는 바로 적용할 수 없습니다.

=> why?

CLIP 모델을 미세 조정하는 데 Mixup 전략이 사용된다는 내용은, 멀티모달 학습의 성능을 향상시키기 위해 CLIP 모델과 같은 사전 학습된 모델을 활용하는 과정에서 Mixup 기법이 어떻게 적용되는지를 말합니다.

Mixup은 원래 지도 학습에서 데이터 증강을 위한 기법으로, 두 샘플을 섞어서 새로운 샘플을 만드는 방법입니다. 이를 통해 모델이 다양한 데이터 분포를 학습하고, 일반화 성능을 향상시킬 수 있습니다.

이러한 Mixup 전략을 사용하면, 기존의 CLIP 모델이 새로운 데이터나 다양한 환경에서도 더 유연하게 작동하도록 조정될 수 있습니다. 이는 특히 데이터가 제한적이거나 특정 환경에서 모델을 사용해야 할 때 유용할 수 있습니다.

이는 위에서 언급한 바와 같이 여기서의 전제 조건은 잘 정렬된 shared latent space를 만든 상태이며, 이 상황에서 Mixup 방법론을 적용하는 것 입니다.

하지만 저희는 각 단일 모달에서 학습된 독립적인 두 개 이상의 모델을 가진 상황에서의 Mixup 방법론을 사용하는 방안이기에 이 새로운 본 논문의 방법론을 적용해야 하는 것 입니다.

4. Motivation

본 논문에서는 멀티모달 퓨전(multimodal fusion)에서 흔히 발생하는 여러 가지 중요한 문제점들을 다루고 있습니다. 이러한 문제점들은 크게 세 가지로 나눌 수 있는데, 각각의 문제점과 그 해결 방안에 대해 자세히 설명 드리겠습니다.

-

높은 연산 비용

최근 딥러닝 연구에서 모델의 성능을 높이는 가장 중요한 요소 중 하나는 모델의 규모를 확장하는 것입니다. 모델이 커질수록 성능이 향상되지만, 동시에 연산 비용도 크게 증가합니다. 특히, 멀티모달 모델의 경우 이러한 연산 비용은 더욱 문제가 됩니다. 왜냐하면 멀티모달 퓨전에서는 두 가지 이상의 다른 네트워크를 함께 학습해야 하기 때문입니다. 예를 들어, 이미지와 텍스트 데이터를 처리하는 두 네트워크 와 를 학습할 때, 이 두 네트워크 모두에 대해 역전파(backpropagation)를 수행해야 합니다. 이 과정에서 많은 메모리와 계산 자원이 필요하게 됩니다. 그래서 본 논문에서는 이런 높은 연산 비용을 줄일 수 있는 효율적인 멀티모달 퓨전 프레임워크를 제안하고 있습니다. -

고품질 쌍(pair) 데이터의 부족

멀티모달 학습에서 중요한 점 중 하나는 서로 다른 모달리티(예: 이미지와 텍스트) 간의 쌍(pair) 데이터를 확보하는 것입니다. 이러한 쌍 데이터는 두 모달리티의 공동 분포 샘플링된 것으로, 학습에 중요한 역할을 합니다. 하지만 현실에서는 고품질의 쌍 데이터를 확보하기가 어렵고, 이는 비용 문제로 이어집니다. 반면, 각각의 모달리티에 대해 단일한 데이터(예: 이미지 또는 텍스트 데이터)만을 확보하는 것은 비교적 쉽고 저렴합니다. 본 논문에서는 이러한 단일 모달리티 데이터를 최대한 활용하여 멀티모달 쌍 데이터의 부족 문제를 해결하고자 합니다. -

Tight Coupling From End-to-End Fusion

일반적으로 멀티모달 퓨전에서는 와 를 처음부터 끝까지 함께 학습하게 됩니다. 이렇게 학습된 모델은 의미적으로 잘 정렬된 잠재 공간을 형성할 수 있지만, 이로 인해 두 네트워크가 긴밀하게 결합되어 버립니다.

이러한 결합은 연구 개발에 있어 여러 문제를 야기할 수 있습니다. 예를 들어, 어떤 하나의 네트워크에 변화를 주고 싶을 때, 두 네트워크를 모두 처음부터 다시 학습해야 하는 상황이 발생할 수 있습니다. 이는 시간과 자원, 환경적인 측면에서 큰 비용을 수반합니다. 따라서 본 논문에서는 이러한 문제를 해결하기 위해 플러그 앤 플레이(plug-and-play) 방식의 프레임워크를 제안하고 있습니다. 이 프레임워크에서는 각 구성 요소를 최소한의 오버헤드로 쉽게 교체할 수 있어, 멀티모달 모델이 단일 모달리티의 발전 속도에 발맞출 수 있도록 설계되었습니다.

이와 같이, 본 논문은 높은 연산 비용, 고품질 쌍 데이터의 부족, 긴밀한 결합 문제를 해결하는 방안을 제시하고 있으며, 이를 통해 멀티모달 퓨전을 보다 효율적이고 유연하게 구현할 수 있는 방법을 모색하고 있습니다.

5. Method

5.1. Towards Efficient Multimodal Fusion

본 논문에서는 멀티모달 퓨전에서 중요한 문제들을 해결하기 위한 새로운 프레임워크를 제시하고 있습니다. 이 프레임워크는 연산 효율성, 데이터 효율성, 모듈화된 구조라는 세 가지 핵심 목표를 달성하기 위해 설계되었습니다.

-

효율적인 멀티모달 퓨전의 첫 걸음

먼저, 본 논문에서는 두 가지 인코더를 사용하여 멀티모달 데이터를 처리하는데, 이를 각각 와 로 정의합니다.

여기서 와 는 중간 잠재 공간으로 데이터를 매핑하는 역할을 하고, 와 는 퓨전 어댑터(fusion adapters)로, 두 잠재 공간을 하나의 공통 잠재 공간 로 매핑합니다.

이 구조에서 중요한 점은, 와 를 사전 학습된 단일 모달리티 인코더로 설정하고, 이 인코더들은 학습 과정에서 고정된다는 것입니다. 즉, 실제로 학습되는 부분은 퓨전 어댑터 와 만이 됩니다. -

연산 효율성의 개선

이제, 이전에 소개된 대조적 학습 손실 함수(Equation 1)를 새로운 방식으로 작성할 수 있습니다:

이를 통해, 대조적 목적 함수(Equation 2)를 다음과 같은 방식으로 표현할 수 있었습니다.

여기서 가장 중요한 점은 단일 모달리티 인코더는 단지 잠재 공간에서 샘플을 제공하기 위해 필요할 뿐, 역전파(backpropagation) 과정에서는 사용되지 않기 때문에 학습 중에는 메모리에 저장할 필요가 없다는 것입니다.

=> 이렇게 하면 멀티모달 퓨전 과정에서 필요한 메모리와 연산 자원을 크게 줄일 수 있습니다. 실제로, 본 논문에서는 모든 실험에서 단일 GPU만으로도 충분한 성능을 낼 수 있음을 보여줍니다.

-

데이터 효율성의 향상

와 를 사전 학습된 단일 모달리티 인코더의 잠재 공간으로 설정함으로써, 이미 잘 학습된 모달리티별 의미 정보를 활용할 수 있습니다. 이러한 정보는 멀티모달 퓨전에서 처음부터 학습하는 것보다 훨씬 더 효율적입니다.

다시 말해, 사전 학습된 단일 모달리티 인코더를 활용함으로써 대규모 멀티모달 쌍 데이터가 필요하지 않게 됩니다. 이는 일종의 단일 모달리티 잠재 공간에서 common latent space로의 knowledge distillation로 해석될 수 있으며, 이는 대조적 학습 목표를 통해 효과적이라는 것이 입증되었습니다. -

Plug-and-PlayFramework

마지막으로, 본 논문에서 제안하는 모듈화된 접근 방식은 단일 모달리티 인코더 와 의 선택과 기저 모달리티 와 에 무관하게 작동합니다. 이는 단일 모달리티 학습과 멀티모달 퓨전을 분리할 수 있게 해주며, 단일 모달리티 인코더가 발전함에 따라 새로운 인코더를 쉽게 결합하여 멀티모달 퓨전에 적용할 수 있습니다. 이렇게 함으로써, 최신의 단일 모달리티 기술을 멀티모달 퓨전에 효율적으로 활용할 수 있는 플러그 앤 플레이 방식의 프레임워크를 구현할 수 있습니다.

이처럼, 본 논문에서는 연산 자원을 절약하고 데이터 효율성을 높이며, 최신 기술을 쉽게 적용할 수 있는 멀티모달 퓨전 방법을 제안하고 있습니다.

5.2.FuseMix : Multimodal Latent Mixup

본 논문에서는 멀티모달 퓨전을 더 효율적으로 수행하기 위해 새로운 데이터 증강 방법인 FuseMix를 제안하고 있습니다. 이 방법은 특히 FuseMix: Multimodal Latent Mixup이라는 개념을 통해, 최소한의 멀티모달 쌍 데이터만으로도 효과적인 멀티모달 퓨전을 가능하게 합니다.

- FuseMix: 멀티모달 잠재 공간에서의 데이터 증강

멀티모달 데이터는 다양한 형태의 데이터를 포함하기 때문에 직접적으로 데이터 증강을 하는 것이 어렵습니다. 예를 들어, 이미지와 텍스트를 어떻게 의미 있게 조합할 수 있을까요?

이런 이유로, 본 논문에서는 중간 잠재 공간인 와 에서 데이터 증강을 수행하는 방법을 선택했습니다.

여기서 중요한 점은, 와 는 이미 사전 학습된 단일 모달리티 인코더를 통해 얻어진 잠재 공간이라는 것입니다. 이러한 공간은 이미 각 모달리티의 의미 정보를 잘 반영하고 있기 때문에, 이 공간에서의 증강은 원본 데이터 공간에서의 증강보다 훨씬 더 의미 있는 조합을 만들어낼 수 있습니다.

- FuseMix의 핵심 아이디어

FuseMix의 기본 아이디어는 간단합니다. 사전 학습된 인코더의 잠재 공간에서 두 샘플을 선형 보간(linear interpolation)하는 것입니다.

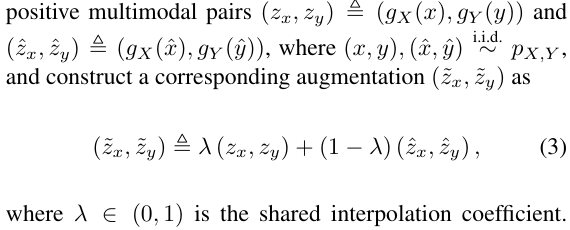

이 방법은 Mixup에서 영감을 받아, 데이터 쌍 와 를 가지고 라는 새로운 증강 샘플을 생성하는데, 이때 각 모달리티의 잠재 공간에서 보간을 수행합니다.

수식으로 표현하면 다음과 같습니다:

이 수식을 통해 생성된 는 여전히 의미 있는 positive pair을 유지하게 됩니다. 이렇게 함으로써, 증강된 샘플도 원래의 데이터와 일관성을 유지할 수 있게 됩니다.

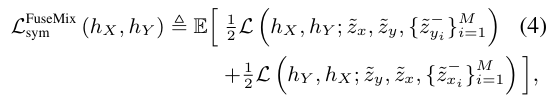

- FuseMix의 대조적 학습 손실 함수

FuseMix를 사용하면, 대조적 학습 손실 함수도 변형됩니다. 본 논문에서는 다음과 같은 대칭적인 대조적 학습 손실 함수를 제안하고 있습니다:

여기서 기대값(expectation)은 양성 쌍 와 를 사용하여 얻은 증강된 양성 쌍 에 대해 계산됩니다. 또한, 음성 쌍에 대해서도 동일한 방식으로 증강이 이루어지며, 그 결과도 의미 있는 negative pair을 형성하게 됩니다.

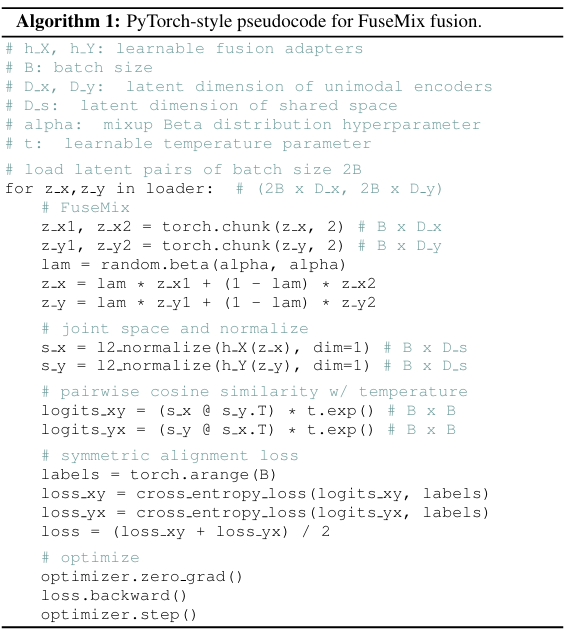

- FuseMix의 간편한 구현

마지막으로, FuseMix는 매우 간단하게 구현할 수 있습니다.

이처럼, FuseMix는 복잡한 멀티모달 데이터를 다루면서도 연산 자원과 데이터의 효율성을 극대화할 수 있는 강력한 도구입니다. 본 논문에서는 FuseMix를 통해 최소한의 데이터와 연산 자원으로도 효과적인 멀티모달 퓨전을 달성할 수 있음을 보여줍니다.

정리 및 결론

본 연구에서는 컴퓨팅 효율성과 데이터 효율성을 모두 고려한 멀티모달 융합 프레임워크를 제안했습니다.

이 프레임워크는 임의로 사전 훈련된 단일 모달 인코더를 효과적으로 활용할 수 있습니다. 특히, FuseMix라는 간단하면서도 효과적인 멀티모달 증강 기법을 도입했습니다. 이 기법은 mixup에서 영감을 받아 잠재 공간(latent space)에서 작동합니다.

하지만 본 방법은 강력한 단일 모달 인코더를 활용할 수 있지만, 이들 인코더가 이전에 학습한 의미적 정보에 제한을 받습니다. 따라서, 융합 과정에서 단일 모달 인코더를 효율적으로 미세 조정(fine-tuning)하는 방법을 적용하는 것이 흥미로운 미래 연구 방향이 될 수 있습니다. 다만, 이러한 방법은 추가적인 오버헤드를 발생시킬 수 있습니다.

또한, 본 프레임워크는 본질적으로 단일 모달 인코더를 블랙 박스 모델로 취급합니다. 즉, 인코더의 최종 전 단계 레이어에서 얻은 latent encoding만을 사용합니다. 이러한 접근 방식은 API를 통해서만 접근할 수 있는 인코더를 사용하는 멀티모달 융합 응용 프로그램을 수행할 수 있는 흥미로운 가능성을 열어줍니다.