Radon Inversion via Deep Learning

Abstract & Introduction

라돈 변환은 물리 및 생명 과학에서 널리 사용되며, 그 중요한 응용 중 하나는 현대 건강 검진에서 중요한 역할을 하는 X선 컴퓨터 단층 촬영(CT)입니다. 기존에는 재구성 과정이 해당 라돈 역방향을 근사하기 위해 여러 가지 단계로 처리되어왔습니다.

FBP 알고리즘은 X-ray 노출로 얻은 라돈 투영을 이용하여 기존 물체를 재구성하는 방법입니다. 하지만 저용량 X-ray CT(LdCT) 촬영에서는 FBP 알고리즘의 재구성 결과, 심한 noise-induced artifacts를 종종 확인할 수 있습니다.

본 논문에서는 라돈 역방향에 대한 새로운 통합 프레임워크를 제안합니다. 라돈 역방향을 여러 단계로 순차적으로 처리하는 대신 제안된 프레임워크를 사용하여 엔드-투-엔드 방식으로 근사합니다.

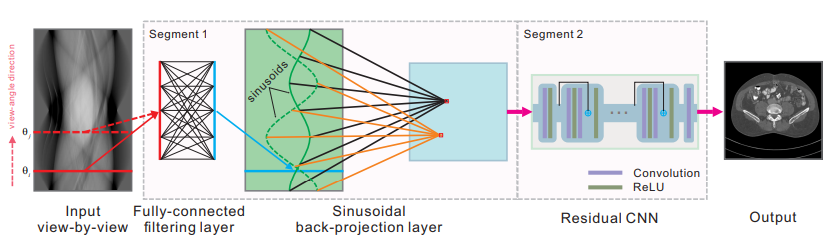

이 신경망의 아키텍처는 두 개의 세그먼트로 나눌 수 있습니다.

1st segment) learnable FC filtering layer를 사용하여 radon projection들을 필터링하고, 이 필터링된 라돈 투영을 이미지로 변환하는 learnable Sinusoidal back-projection layer가 이어집니다.

2nd segment) 이후 Residual CNN을 거치게 되는데, 이는 이미지 도메인에서 재구성 성능을 더욱 향상시키기 위한 일반적인 신경망 아키텍처입니다. iRadonMap은 ImageNet 데이터베이스의 대량의 일반 이미지를 학습하여 전반적으로 최적화됩니다. iRadonMap의 성능을 평가하기 위해 임상 환자 데이터가 사용됩니다.

Methodology

기존의 방법론은 아래의 내용을 참고 부탁 드립니다.

1) CT Reconstruction - Backprojection

2) CT Reconstruction - Fourier Slice Theorem

3) CT Reconstruction - Filtered Backprojection

이제 본 논문의 방법론을 살펴보겠습니다.

Network Architecture

네트워크 아키텍처는 두 단계로 나눌 수 있습니다.

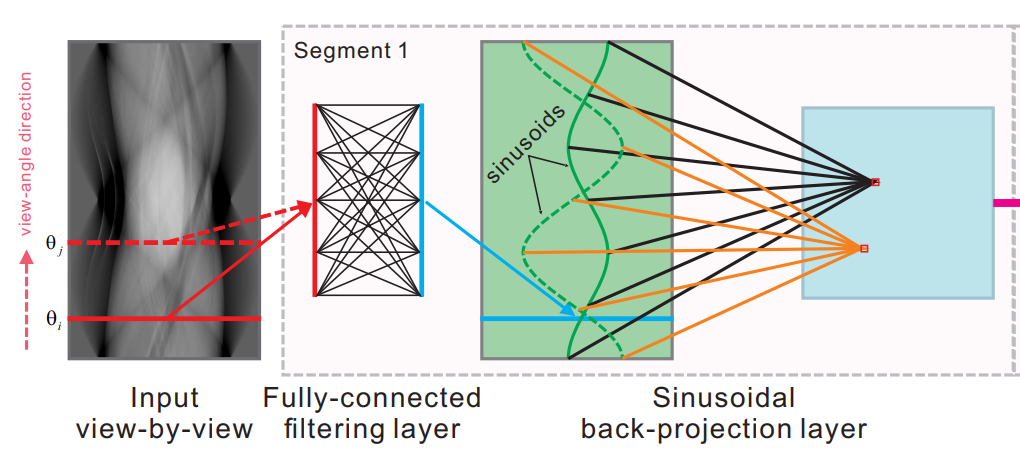

* 1st segment

FBP 알고리즘의 필터링 작업과 역투영을 각각 시뮬레이션하기 위해 두 개의 학습 가능한 적합한 네트워크 레이어를 사용합니다. FBP 알고리즘에서의 필터링 작업은 view와 angle 방향으로 라돈 투영에 적용됩니다. 이러한 필터링 작업을 만들기 위해 iRadonMap에서는 learnable FC layer를 사용합니다.

여기서 한 번 살펴볼 점은 FBP 알고리즘의 역투영을 분석하면, 특정 재구성 지점은 소수의 라돈 투영 점에만 관련되어 있음을 알 수 있습니다. 이는 더 적은 매개 변수를 사용하여 역투영을 진행하기 위한 적합한 구성을 할 수 있음을 의미합니다. 이것은 Sinusoidal back-projection layer로 표시됩니다.

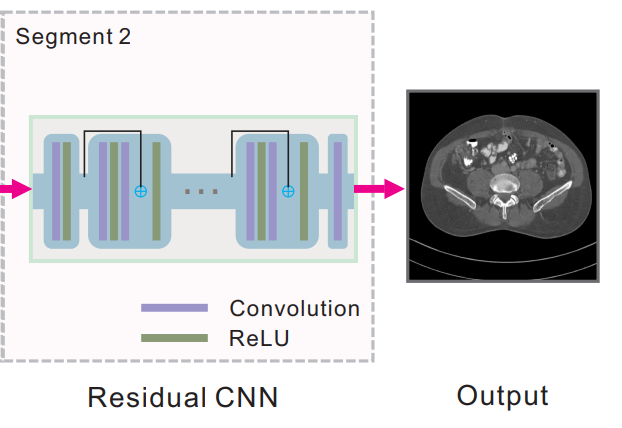

* 2nd segment

두 번째 segment에서는 iRadonMap의 재구성을 강화하기 위해 residual CNN을 사용합니다. 본 논문에서는 ResNet을 사용했으며, ResNet과는 달리 배치 정규화를 사용하지 않습니다.

두 번째 segment의 네트워크는 오토인코더, U-net 등으로도 사용할 수 있습니다.

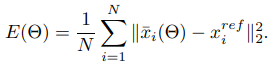

Network Training

iRadonMap은 평균 제곱 오차(MSE)를 최소화하여 전반적으로 최적화됩니다.

x bar : iRadonMap의 최종 출력

x ref : reference 이미지

N : 트레이닝에 사용되는 이미지 쌍의 수

Θ : iRadonMap의 learnable parameter

RMSProp

미니배치 크기 : 2

학습률 : 0.00002

모멘텀 : 0.9

가중치 감소 : 0.0Datasets

iRadonMap의 트레이닝 데이터셋은 ImageNet의 다수의 범용 이미지로 구성되어 있습니다. 본 연구에서는 총 62,899개의 RGB 컬러 이미지를 수집했습니다.

이를 회색 이미지로 변경한 후 중심을 기준으로 512 × 512 픽셀로 크롭했습니다.

각 이미지에 대한 라돈 투영은 ASTRA Toolbox를 사용하여 parallel geometry로 생성했으며, 크기는 1160 × 736입니다.

=> 즉, 이 연구에서는 1160 × 736 크기의 라돈 투영 맵이 iRadonMap으로 입력되어, 512 × 512 크기의 재구성된 이미지가 출력됩니다.

iRadonMap의 테스트 데이터셋은 Mayo Clinic에서 제공 및 승인된

실제 임상 환자 데이터로 구성되어 있습니다.

또한 iRadonMap의 일반화 능력을 증명하기 위해,

트레이닝 단계에서는 임상 환자 데이터를 사용하지 않았으며, 테스트에만 사용되었습니다.Results & Conclusion

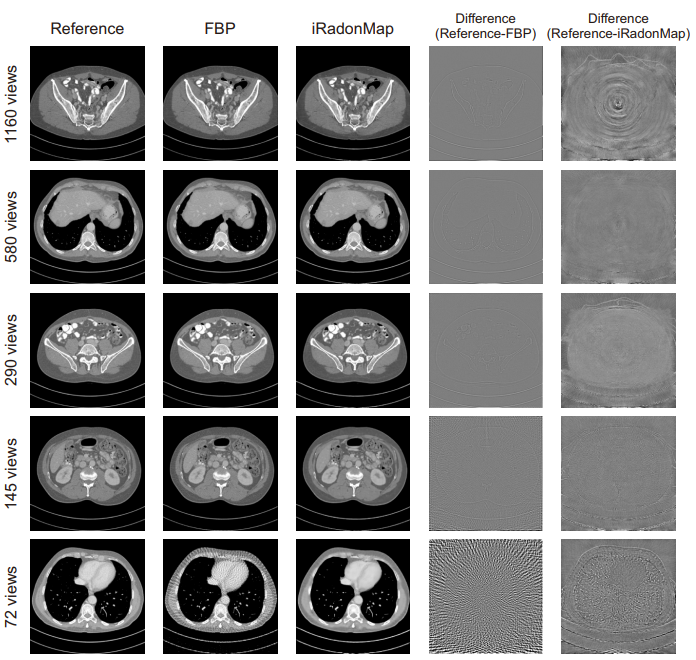

ASTRA Toolbox를 통해 각 각도별로 만들어 낸 데이터들을 이용하여 테스트를 진행하였습니다. (1160, 580, 290, 145, 72)

첫 번째 행부터 세 번째 행까지 iRadonMap과 FBP의 재구성 결과를 비교해보면, iRadonMap의 성능이 FBP와 유사하다는 것을 알 수 있습니다.

이에 반해 4번째와 5번째 열의 다른 이미지를 비교하면, iRadonMap이 FBP보다 더 많은 가장자리 세부 정보를 보존할 수 있다는 것을 확인해 볼 수 있습니다. 또한 4번째와 5번째 행에서는 FBP 알고리즘이 적은 view-angle 라돈 투영으로 인해 심각한 아티팩트를 가지고 있다는 것을 볼 수 있으며, iRadonMap의 재구성 성능은 더 적은 아티팩트를 가지고 있습니다.

결론적으로 본 논문에서는 Radon inversion via deep learning을 위한 새로운 프레임워크인 end-to-end iRadonMap을 제안합니다.

이는 두 가지 segment로 구성된 신경망으로

1) FC flitering layer와 sinusoidal back-projection layer로 첫 번째 segment를 구성하고

2) ResNet을 사용한 CNN 아키텍처를 통한 residual network를 만들었습니다.이 모델은 end-to-end로 질적 측정 측면에서 우수한 성능을 보임을 알 수 있었습니다.