느낀점

- LG AI 논문인데 이 정도 프로젝트를 지원하고 밀어주는 것이 부럽...

- 좋은 평가를 위해 공수를 꽤나 많이 투입해서 괜찮은 평가 지표

- 결국 새로운 과제가 등장했을 때 같은 과정을 거치여 하는 노동력?

- 언어 모델 저지 항상 의심스러운 느낌

- 인간이 개입하고 크로스체크 했지만 여전히 인간 개입도가 높은 느낌

Abstract

언어 모델이 다양한 작업을 처리할 수 있게 되면서 평가가 개발만큼이나 어려워지고 있습니다.

현재 대부분의 LLM 벤치마크는 유용성, 무해성과 같은 추상적인 평가 기준을 사용하여 평가하며 이는 인간 평가의 유연성과 세밀함을 포함하지 못하고 있습니다.

이러한 벤치마크는 instruction following과 같은 특정 능력에 불균형적으로 초점을 맞추는 경향이 있어 평가 범위에 편향이 발생합니다.

이러한 한계를 극복하기 위해 77개의 다양한 작업에 걸쳐 LM의 9가지 고유한 능력을 철저히 평가하도록 설계된 원칙 기반의 벤치마크인 BIGGEN BENCH를 소개합니다.

BIGGEN BENCH의 핵심 특징은 인간 평가의 미묘한 판단을 밀접하게 반영하는 인스턴스별 평가 기준을 사용한다는 것입니다.

이 벤치마크를 사용하여 5개의 평가 LM을 통해 103개의 최첨단 LM을 평가했습니다.

Introduction

언어 모델의 특정 능력을 체계적으로 어떻게 판단할 수 있을까요?

이러한 능력을 정확하게 측정하는 것은 LLM의 한계를 정확히 파악하고 개선할 영역을 식별하는 데 매우 중요합니다.

주된 접근 방식은 LM의 "유용성"과 같은 요약 측정값을 모든 능력의 대리 지표로 사용하거나, 객관식 질문과 같이 쉽게 측정할 수 있는 대리 작업을 사용하는 것이었습니다.

그러나 유용하다고 여겨지는 것에 대한 인식은 사람마다 다를 수 있으며, 분류 작업에서 높은 성능을 보이는 것이 반드시 언어 모델이 원하는 능력에 부합하는 유창한 텍스트를 생성할 수 있는 능력을 갖추고 있음을 나타내는 것은 아닙니다.

우리는 특정 능력과 관련하여 언어모델이 자유 형식 출력을 직접 평가하는 데 관심이 있습니다.

그러나 출력이 "좋은지" 판단하는 것은 평가의 주관적인 특성 때문에 어려운 문제입니다.

인간은 맥락에 따라 창의성, 어조 및 문화적 민감성과 같은 핵심 요소를 쉽게 구별할 수 있지만 특정 벤치마크가 이러한 미묘한 차이를 체계적으로 평가하는 것은 어려운 과제입니다.

효과적인 인터뷰 수행 시 정확한 평가 기준의 중요성을 강조하는 인간 연구에서 영감을 받아 각 특정 인스턴스에 맞춰 세밀하게 조정된 평가 기준을 사용하여 언어 모델을 평가하도록 설계된 원칙 기반의 생성 벤치마크인 BIGGEN BENCH를 소개합니다.

응답의 미묘한 뉘앙스와 상세한 가변성을 포착할 수 있습니다.

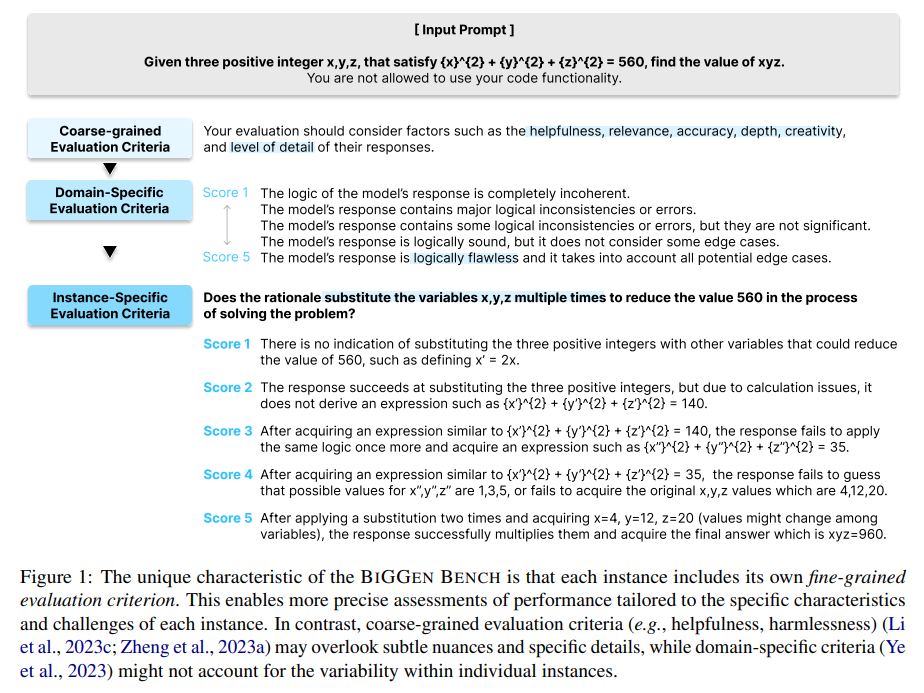

그림 1에서 볼 수 있듯이 수학 문제에 대한 추론을 평가할 때 단순하게 유용성 점수를 할당하는 것보다 추론이 변수 대체를 논리적으로 다루는지 여부를 검토하는 것이 더 유익합니다.

BIGGEN BENCH는 77개의 작업과 765개의 인스턴스에 걸쳐 명령어 추종, 기반 지식, 계획, 추론, 개선, 안전성, 마음 이론, 도구 사용 및 다국어 능력의 9가지 핵심 LM 능력을 평가합니다.

주로 좁은 범위의 능력(예: 명령어 추종)을 검사하는 기존 생성 벤치마크와 비교하여 저희의 접근 방식은 통합된 평가 파이프라인에서 광범위한 능력에 걸쳐 평가 언어 모델을 활용하는 최초의 노력 중 하나입니다.

5개의 서로 다른 평가 언어 모델을 사용하여 10억 개에서 1410억 개 파라미터에 이르는 103개의 최첨단 LM과 14개의 독점 LM을 평가합니다.

이 논문은 주로 세 부분으로 나뉩니다.

3장에서는 모든 인스턴스가 인간-루프 방식으로 제작되었음을 언급하며 BIGGEN BENCH의 평가 프로토콜 및 구축 과정을 설명합니다.

4장에서는 103개 언어 모델의 평가 결과를 공유합니다. 세밀한 평가를 통해 능력별 성능 변화가 모델 크기 확장에 따라 부드럽고 예측 가능하게 나타남을 시사합니다. 사전 학습된 언어 모델과 post-trained된 언어 모델 사이, post-trained 언어 모델과 독점 LM 사이의 추론 및 도구 사용 능력 격차가 좁혀지지 않지만 명령어 추종 능력 격차는 크게 좁혀짐을 확인했습니다.

5장에서는 평가 언어 모델에서 얻은 점수가 신뢰할 수 있는지 연구합니다. 이를 위해 평가 모델과 인간 평가자 간의 점수 상관관계를 측정합니다. 연구 결과는 모든 능력에서 상관관계가 통계적으로 유의미함을 나타냅니다. 부록 E에서는 공정하고 접근 가능한 평가를 목표로 오픈 소스 평가 모델을 GPT-4만큼 효과적으로 평가할 수 있도록 향상시키는 다양한 방법을 탐구합니다. 최첨단 언어 모델 발전에 대한 추가적인 통찰력을 제공하기 위해 두 개의 대화형 웹사이트를 운영합니다. 하나는 103개의 평가된 LM의 출력을 점수와 한계를 강조하고 개선 영역을 제안하는 상세한 구두 피드백과 함께 표시합니다. 다른 하나는 각 능력별 점수와 평균 점수를 보여주는 리더보드를 제공합니다

BIGGEN BENCH: The BiG Generation Benchmark

BIGGEN BENCH는 "능력 - 과제 - 인스턴스 - 평가 기준" 계층 구조를 유지하며 원칙적인 하향식 방식으로 구축되었습니다. 이 섹션에서는 BIGGEN BENCH의 평가 프로토콜 및 구축 과정을 설명합니다. 9가지 능력과 77가지 과제에 대한 설명, 그리고 각 능력 내 인스턴스별 평가 기준의 역할은 부록 A에 제공됩니다.

Evaluation protocol

각 인스턴스는 시스템 메시지, 입력, 참조 답변, 채점표를 포함합니다.

채점표는 1부터 5까지의 점수 범위에 대한 평가 기준과 설명을 포함합니다.

시스템 메시지, 입력, 평가 대상 LLM("Answer LLM"으로 표기)이 주어지면 먼저 응답을 얻습니다.

응답 LLM이 명령어 튜닝 또는 RLHF를 통해 학습된 사후 학습 LM인 경우 제로샷 프롬프팅을 사용합니다.

응답 LLM이 사전 학습 LLM인 경우 cross-task 3-shot 데모를 포함하는 URIAL 프롬프트를 사용합니다.

초기 실험에서 기본 LLM이 프롬프트가 비영어 응답을 요구할 때에도 종종 영어로 응답을 생성하는 현상, 즉 "우발적 번역"(Xue et al., 2020; Li and Murray, 2023)을 발견했습니다. 따라서 다국어 과제의 경우, 사후 학습 LM만 평가하기로 결정했으며, 다른 모든 능력에서는 사전 학습 및 사후 학습 LM 모두를 평가합니다.

심판 역할을 하는 LLM("평가 LLM"으로 표기)은 응답 LM으로부터 단일 응답을 받아 5점 척도 리커트 점수를 생성합니다.

새로운 응답 LLM을 기존 응답 LLM 세트와 비교할 필요 없이 개별적으로 추가할 수 있기 때문에 쌍별 순위 지정 형식 대신 직접 평가 형식을 선택합니다. 평가자 LLM을 프롬프트할 때 Prometheus의 템플릿을 활용합니다.

평균 성능 점수를 계산할 때, 사전 학습 LLM은 다국어 능력에 대해 평가되지 않으므로 해당 점수는 포함하지 않습니다.

하이퍼파라미터, 103개의 응답 LM 목록, 5개의 평가자 LM 목록, URIAL 프롬프트, Prometheus 템플릿은 부록 F 및 G에 포함되어 있습니다.

Construction process

Step 1: Hand-crafting instances 18명의 공동 저자가 각각 하나의 능력을 담당하여 5개의 과제에 걸쳐 25개의 인스턴스를 만드는 것으로 프로세스를 시작했습니다.

한국어, 카자흐어, 벵골어, 스페인어, 인도네시아어, 독일어, 프랑스어, 아랍어, 러시아어, 태국어에 능통한 10명의 원어민 주석자에게 다국어 능력 내 10개의 과제에 걸쳐 각각 10개의 인스턴스를 주석하도록 요청했습니다.

초기에는 첫 번째 저자가 과제를 설계한 후 모든 주석자와의 논의를 통해 개선했습니다.

주석자들은 관련 연구 논문을 참고하도록 지시받았습니다.

첫 번째 저자는 문법 오류를 수정하고, 유창성을 높이며, 주로 혼란스럽거나 쉽지 않은 인스턴스를 포함하는 과제를 제거하기 위해 내용을 검토하고 수정했습니다.

검토 과정에서 23개의 과제가 제거되어 최종적으로 77개의 과제와 총 385개의 인스턴스가 확정되었습니다.

Step 2: Augmenting new instances with human demonstrations 품질과 다양성에 중점을 두고 GPT-4-0125를 사용하여 인스턴스 수를 확장했습니다.

새로운 인스턴스를 제로샷 방식으로 생성하는 대신 각 과제에 대해 1단계에서 수동으로 제작한 인스턴스를 컨텍스트 내 데모로 활용하여 높은 품질을 유지했습니다.

다양성을 위해 각 새로운 인스턴스에 대해 5개의 후보를 생성하고, BertScore로 측정했을 때 의미적 유사성이 가장 낮은 것을 선택하는 과정을 5번 반복했습니다.

마지막으로, 3단계에 자세히 설명된 바와 같이 인스턴스를 검증하고 품질이 낮은 것은 폐기하거나 수정하여 총 77개의 과제에 걸쳐 770개의 인스턴스를 얻었습니다.

Step 3: Cross validation 18명의 공동 저자에게 자신이 주석하지 않은 인스턴스를 검증하도록 할: 각자 2개의 능력, 10개의 과제, 50개의 인스턴스를 검토했습니다.

한 명의 주석자가 플래그를 지정한 인스턴스는 수정하고 두 명 모두에 의해 잘못되었거나 참조 또는 채점표가 좋지 않다고 확인된 인스턴스는 제거했습니다.

5개의 인스턴스가 제거되어 총 77개의 과제에 걸쳐 765개의 인스턴스가 남았습니다.

Step 4: Gathering human judgments 평가자 LLM의 평가 결과의 신뢰성을 검증하기 위해 인간 평가를 수집합니다.

103개의 Answer LLM 평가에서 4개의 LLM을 선택하여 인간 주석자에게 응답을 채점하도록 요청합니다.

다국어 능력의 경우, 6개의 LLM의 응답에 대한 인간 점수를 얻습니다.

신뢰할 수 있는 인간 평가를 보장하기 위해 모집 단계, 자격 부여 단계, 주요 평가 단계의 3단계 파이프라인을 사용합니다.