느낀점

- 라마4가 챗봇 아레나 점수와 공개 모델을 다르게 해서 생긴 문제

- 소수 모델이 선택 안 되는 느낌은 느낌이 아니고 사실

- 공정한 벤치가 되어 정성을 평가할 수 있는 좋은 벤치가 됐으면 좋겠음

Abstract

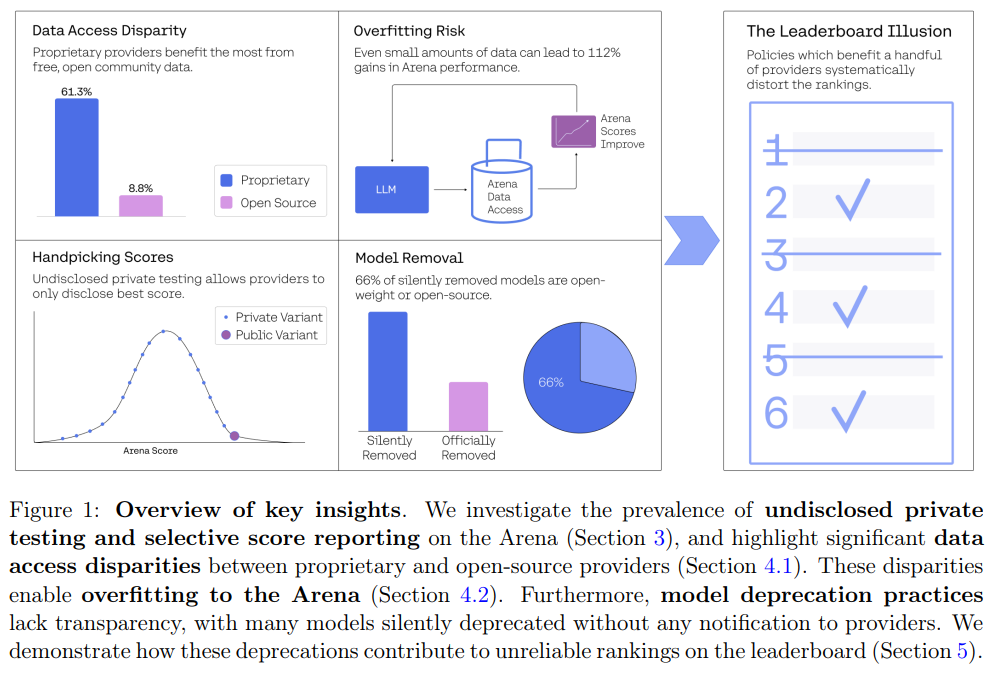

좌상단: 데이터 불균형 더 많은 노출

우상단: 아레나 점수에 오버핏

좌하단: 최고 점수만 노출

우하단: 최고 점수를 제외한 모델 제거

과학 분야의 발전에 있어 능력을 측정하는 것은 매우 중요합니다.

벤치마크가 점점 더 중요한 역할을 수행함에 따라 왜곡될 가능성 또한 커지고 있습니다.

챗봇 아레나는 가장 뛰어난 AI 순위를 매기는 데 있어 가장 중요한 리더보드로 부상했습니다.

그러나 본 연구에서 여러 문제들을 발견했으며 이는 경쟁의 장을 왜곡시키는 결과를 낳았습니다.

공개되지 않은 비공개 테스트 관행이 소수의 제공업체들에게 유리하게 작용한다는 것을 발견했습니다.

소수 제공업체는 모델을 공개하기 이전에 여러 변형 모델을 테스트하고 원할 경우 점수를 철회할 수 있습니다.

제공업체들이 최고의 점수를 선택할 수 있다는 점은 선택적 공개로 인해 편향된 아레나 점수로 이어진다는 것을 확인했습니다.

극단적인 예로 메타가 Llama-4 출시를 앞두고 27개의 비공개 LLM 변형 모델을 테스트한 것을 확인했습니다.

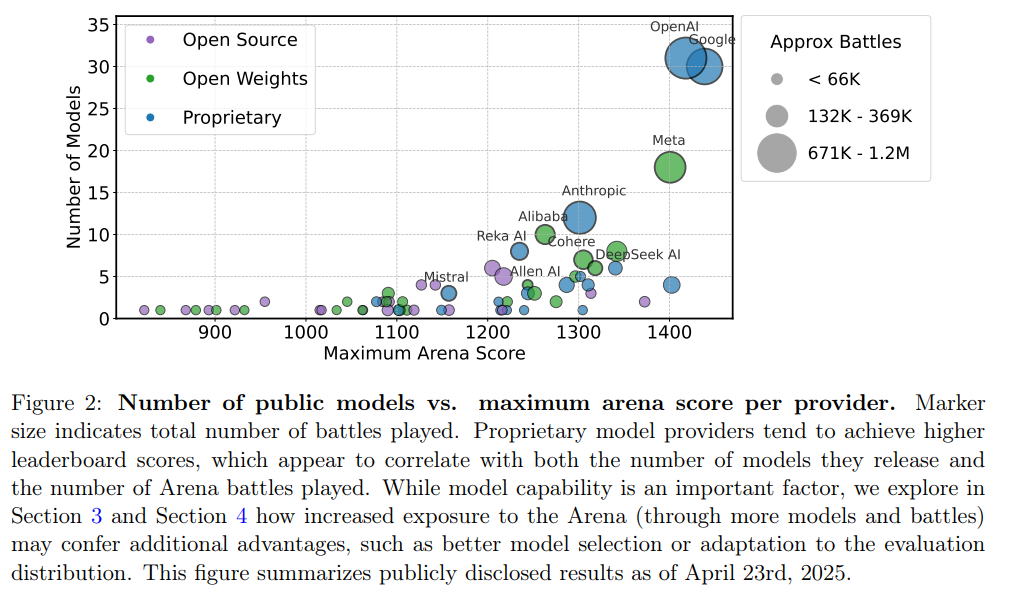

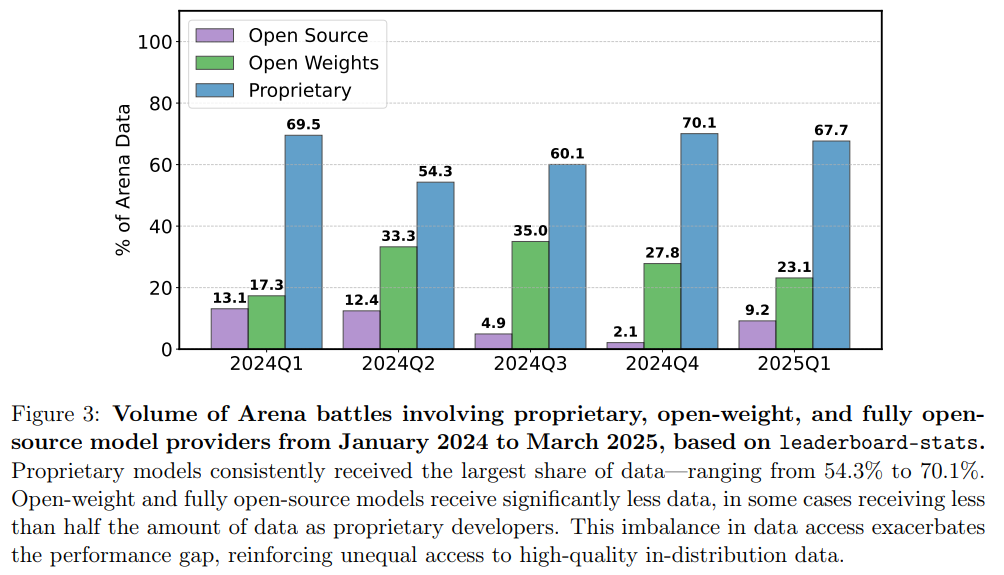

폐쇄형 모델이 오픈 소스보다 더 높은 비율(배틀 수)로 샘플링되고 아레나에서 제거되는 모델 수도 적다는 것을 확인했습니다.

이러한 정책들은 시간이 지남에 따라 상당한 데이터 접근 불균형을 초래합니다.

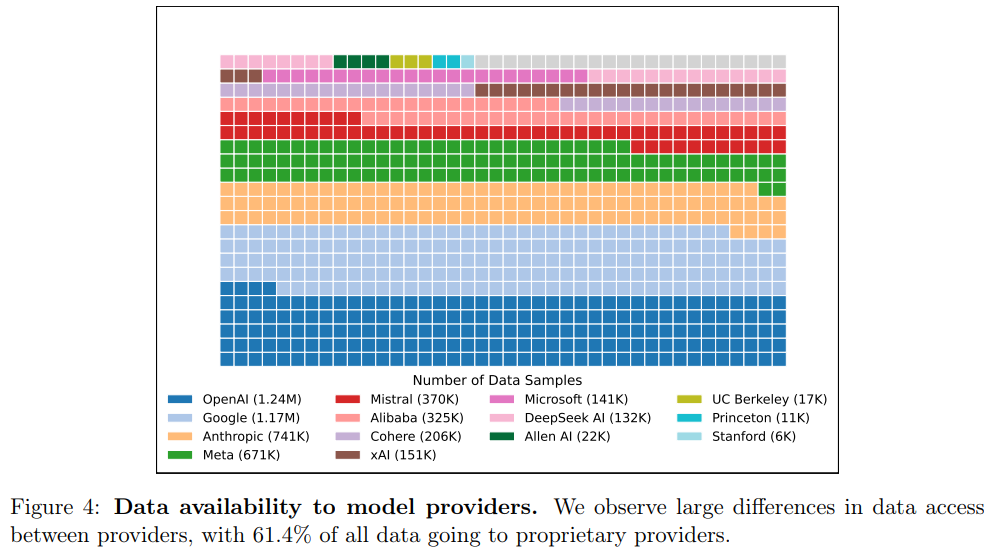

구글과 OpenAI와 같은 제공업체들은 아레나 전체 데이터의 각각 19.2%와 20.4%를 차지하는 것으로 추정됩니다.

83개의 오픈 웨이트 모델을 합쳐도 전체 데이터의 29.7%에 불과합니다.

챗봇 아레나 데이터에 대한 접근성이 상당한 이점을 제공한다는 것을 보여줍니다.

보수적인 추정치에 따르면 제한적인 추가 데이터만으로도 아레나 분포에서 최대 112%의 상대적 성능 향상을 가져올 수 있습니다.

이러한 역학 관계는 전반적인 모델 품질보다는 아레나 특정 역학 관계에 대한 과적합을 초래합니다.

아레나는 평가 플랫폼을 유지 관리하는 주최측과 공개 커뮤니티의 상당한 노력에 기반을 두고 있습니다.

챗봇 아레나의 평가 프레임워크를 개선하고 공정하고 투명한 벤치마킹을 촉진하기 위한 실행 가능한 권장 사항을 제시합니다.

Introduction

Chatbot Arena는 생성형 AI 모델 비교를 위한 표준으로 자리매김했으며, 언론, 산업, 학계에 막대한 영향력을 행사하고 있습니다.

2023년에 만들어진 Chatbot Arena는 사용자가 프롬프트를 제출하고 익명의 두 모델 응답을 비교하여 순위를 매기는 방식으로 LLM을 평가합니다.

Chatbot Arena는 기술 변화의 시기에 중요한 평가 공백을 메워주었기 때문에 빠르게 부상했습니다.

생성형 AI 기술이 빠르게 강력해짐에 따라 기존의 학술적인 객관식 평가는 이러한 모델들이 현재 사용되고 있는 실제 개방형 활용 사례를 제대로 반영하지 못했습니다.

새로운 질문이 매일 제기될 수 있는 역동적인 사용자 주도 평가 프레임워크인 Chatbot Arena는 적어도 원칙적으로는 모델 성능 발전과 함께 진화할 수 있습니다.

더욱이, 개방형 상호 작용 방식은 모델 개발자가 처음 예상하지 못했던 새로운 실제 활용 사례를 포착할 수 있습니다.

단일 리더보드에 대한 의존은 제공업체가 기술을 실질적으로 발전시키기보다는 리더보드 성능의 특정 측면에 과적화될 위험이 있습니다.

Goodhart’s Law에서 알 수 있듯이 측정 기준이 목표가 되면 더 이상 좋은 측정 기준이 되지 못합니다.

본 연구에서는 소수의 제공업체의 의도적인 참여와 Chatbot Arena의 동일한 소규모 그룹에 대한 우대 정책이 혁신적인 발전 대신 게임화의 가능성을 증폭시켰음을 보여줍니다.

Chatbot Arena에 대한 체계적인 검토는 2백만 건의 배틀을 포함하는 데이터 소스를 통합하고 고정된 기간(2024년 1월 - 2025년 4월) 동안 42개 제공업체와 243개 모델을 감사하는 방식으로 진행되었습니다.

포괄적인 분석을 통해 장기간에 걸쳐 소수의 선호하는 제공업체가 데이터 및 테스트에 불균형적으로 접근 권한을 부여받았음을 밝혀냈습니다.

특히 소수의 선호하는 모델 제공업체가 최고의 성능을 보이는 체크포인트만 출시하기 전에 여러 모델 변형을 비공개로 테스트할 수 있도록 허용하는 비공개 Chatbot Arena 정책을 확인했습니다.

Arena 데이터를 사용하여 이러한 전략이 결과에 유리한 편향을 일으켜 전체 Arena 순위를 왜곡하는 방식을 시뮬레이션하고 입증합니다.

독점 모델 제공업체, 오픈 웨이트 모델 제공업체, 오픈 소스 모델 제공업체에 제공되는 피드백 데이터 양에 상당한 비대칭성이 있음을 발견했습니다.

이는 불균등한 샘플링 비율(모델이 Chatbot Arena 배틀에 나타나는 빈도)과 더 이상 사용되지 않는 모델에 대한 정책(어떤 모델이 Arena에서 제외되는지)의 조합으로 인해 발생합니다.

이러한 차이가 왜곡되고 신뢰할 수 없는 Arena 순위를 결정하게 되고 제공업체가 일반적인 모델 품질보다는 Arena 특정 역학 관계에 과도하게 적합화될 수 있는 조건을 조성함을 보여줍니다.

광범위한 분석을 통해 다음과 같은 결과를 제시합니다.

Preferential treatment around private testing and retraction: Chatbot Arena는 일부 제공업체가 여러 제출물을 병렬로 테스트할 수 있도록 허용하는 비공개 정책을 가지고 있습니다. 특정 모델 개발업체(Meta, Google, OpenAI 및 Amazon)가 광범위한 비공개 테스트의 혜택을 받았음을 보여줍니다. 한 달 동안 Meta에서 llama 4 출시를 앞두고 Chatbot Arena에서 비공개로 테스트된 모델이 27개나 되는 것을 관찰했습니다. Chatbot Arena는 제출된 모든 모델을 공개하도록 요구하지 않으며, 공개 리더보드에 나타나는 버전이 공개적으로 사용 가능한 API와 일치한다는 보장이 없습니다. N개의 모델 중에서 최고 점수를 받은 변형을 선택할 수 있는 능력이 Arena 등급을 체계적으로 조작할 수 있게 함을 실제 실험 및 시뮬레이션을 통해 보여줍니다.

Far more data is released to proprietary model providers: Chatbot Arena는 일반 사용자가 제공하는 무료 크라우드소싱 피드백의 이점을 누리는 커뮤니티 기반 리더보드입니다. 그러나 독점 모델 제공업체는 다른 제공업체보다 훨씬 더 많은 테스트 프롬프트와 모델 배틀 결과를 수집합니다. Google과 OpenAI는 Arena의 전체 테스트 프롬프트 중 각각 19.2%와 20.4%를 받은 것으로 추정됩니다. Arena에서 다양한 제공업체의 모델이 수행한 총 배틀 수의 비율을 기반으로 추정한 것입니다. 대조적으로, 총 41개의 완전한 오픈 소스 모델은 전체 데이터의 8.8%만을 집단적으로 받은 것으로 추정됩니다.

Chatbot Arena data access drives significant performance gains: 제공업체 간의 데이터 접근 격차는 중요합니다. Chatbot Arena 데이터로 학습함으로써 모델 순위를 크게 향상시킬 수 있다고 추정합니다. 통제된 실험 환경에서 Arena 학습 데이터 비율을 (0% → 70%)로 늘리면 ArenaHard에서의 승률이 23.5%에서 49.9%로 두 배 이상 증가하는 것을 관찰했습니다. 일부 제공업체는 비공개 API 데이터에 불균형적으로 접근할 수 있으며, 이를 활용하면 훨씬 더 큰 성능 향상을 얻을 수 있다는 점에서 이는 보수적인 추정치라고 생각합니다.

Deprecations can result in unreliable model rankings: 그림 17에서 볼 수 있듯이, 243개의 공개 모델 중 205개가 폐기되었습니다. Chatbot Arena의 백엔드 코드베이스인 FastChat에서 공식적으로 폐기된 것으로 나열된 47개의 모델보다 훨씬 많은 수치입니다. 모델 폐기는 Arena 점수 산정의 기반이 되는 Bradley-Terry 모델의 핵심 가정을 위반하여 리더보드 순위의 신뢰성을 저하시킬 수 있음을 보여줍니다. 오픈 소스 모델이 폐기될 가능성이 훨씬 높고 따라서 신뢰할 수 없는 평가를 받을 가능성이 높다는 것을 발견했습니다. 폐기된 모델 중 66%가 오픈 소스 모델입니다.

Our role in both participating in the leaderboard and providing an overview of its limitations: 본 연구의 저자 중 일부는 Chatbot Arena에 여러 오픈 웨이트 모델을 제출했음을 인정하는 것이 중요합니다: command-r, command-r-plus, aya-expanse , aya-vision, command-a. 이 연구는 리더보드 제출 경험에서 비롯되었습니다. Aya Expanse를 테스트를 위해 제출하는 동안 저희의 오픈 모델이 독점 모델에 비해 현저하게 과소 샘플링되는 것을 관찰했습니다. 이러한 불일치는 그림 3, 4, 5에 더욱 명확하게 반영되어 있습니다. 이에 대응하여 2024년 11월에 Chatbot Arena 주최측에 이러한 차이에 대해 문의했습니다. 논의 과정에서 일부 제공업체가 여러 변형 모델을 비공개로 테스트하고 있으며 이러한 관행이 일부 모델 제공업체에 대해서만 선택적으로 공개되고 제한된다는 것을 알게 되었습니다. 초기 문의가 부분적으로 Chatbot Arena가 2024년 12월에 모델 전반에 걸쳐 일관된 샘플링 비율을 약속하는 벤치마킹 정책을 자세히 설명하는 공개 블로그 게시물을 발표하도록 촉발했다고 생각합니다. 그러나 이후에도 지속적인 샘플링 불균형에 대한 일화적 관찰과 비공개 별칭을 가진 수많은 모델의 존재는 보다 체계적인 분석을 수행하도록 동기를 부여했습니다. 여러 제출 및 철회의 이점을 추정하기 위해 비공개 변형 모델을 출시했습니다.

본 연구는 Chatbot Arena의 심각한 한계점과 신뢰성 문제를 지적하지만 Chatbot Arena가 학술적으로 후원되는 리더보드로 시작하여 기계 학습 커뮤니티에 중요한 의미를 갖게 되었다는 점을 인정하는 것이 중요합니다.

리더보드를 조정하는 데는 상당한 노력이 필요하며 Arena 주최측은 다양한 모델 제공업체의 모델 추가 지원으로 인해 종종 많은 시간적 부담을 겪었습니다.

따라서 현재 Chatbot Arena의 체계적인 문제를 지적하는 동시에 이러한 문제 중 일부는 일련의 설계 결정과 특정 대형 제공업체에 대한 양보가 누적되어 신뢰성을 저하시키면서 점진적으로 발생했을 수 있다고 생각합니다.

주최측이 과학적 정확성을 회복하고 리더보드에 대한 신뢰를 회복하기 위해 합리적인 개입을 할 수 있다고 믿습니다.

본 연구를 발표하기 전에 저희의 권장 사항을 Chatbot Arena에 직접 공유했습니다.

키플레이어 모델에 확실한 편향이 들어나는 모습

Critical Recommendations to Restore Trust to the Chatbot Arena

챗봇 아레나의 공정성, 투명성 및 신뢰성을 회복하기 위해 다음과 같은 다섯 가지 변경 사항을 제안합니다.

변경 사항들은 실행 가능하고, 구현하기 쉬우며, 과학적 무결성을 회복하는 데 시급하고 필수적이라고 판단합니다.

점수 제출 후 철회 금지: 비공개 모델 변형을 포함한 모든 모델 평가 결과는 제출 시 영구적으로 공개되어야 하며 점수를 철회하거나 선택적으로 숨길 수 있는 옵션은 없어야 합니다. 이는 리더보드에 대한 신뢰를 회복하는 데 중요하고 필수적인 요구 사항입니다. 소수의 선호하는 제공업체가 선택적으로 결과를 공개하는 것을 허용해야할 합리적인 과학적 근거가 없습니다. 실제로 우리는 이런 점이 아레나 점수를 상향 편향시키고 소수의 선호하는 제공업체가 리더보드를 조작할 수 있도록 허용한다고 생각합니다.

제공업체에 따라 비공개 모델 수에 대한 투명한 제한 설정: 비공개 테스트를 제공할 타당한 이유는 개발 중인 모델을 챗봇 아레나 커뮤니티가 테스트하는 동시에 출시 전 필요한 익명성을 유지할 수 있도록 하기 때문입니다. 그러나 일부 제공업체는 다른 제공업체보다 훨씬 더 많은 비공개 테스트를 수행하고 있습니다. 이는 순위 조작에 영향을 미칠 뿐만 아니라 선호하는 제공업체가 공개 커뮤니티 프로젝트로부터 훨씬 더 많은 데이터를 얻는다는 것을 의미합니다. 메타는 Llama 4 출시를 앞두고 27개의 변형 모델을 테스트했습니다. 이는 커뮤니티 리소스의 데이터 접근을 매우 불균형하게 만듭니다. 엄격하고 공개적으로 명시된 제한(예: 제공업체당 동시에 테스트할 수 있는 최대 3개의 모델 변형)을 시행하는 것이 중요합니다. 이는 리더보드를 왜곡하는 과도한 테스트 실행을 방지하고 모든 사용자를 위한 공정하고 투명한 벤치마킹을 보장합니다. 비공개 테스트가 계속된다면 투명한 제한과 모든 점수 공개가 병행되어야 합니다.

독점 모델, 오픈 웨이트 모델 및 오픈 소스 모델에 동일하게 제거될 수 있도록 보장: 우리는 모델 제거가 오픈 소스 모델에 불균형적으로 영향을 미쳐 시간이 지남에 따라 데이터 접근에 큰 비대칭성을 야기한다는 것을 발견했습니다. 아레나 운영진은 오픈 웨이트 제공업체에 불이익을 주는 비대칭적인 데이터 접근을 방지하기 위해 독점, 오픈 소스 라이선스 그룹별로 동일한 비율로 모델을 제거할 것을 강하게 요청합니다. 합리적이고 투명한 정책은 독점, 오픈 웨이트, 오픈 소스 모델 그룹의 하위 30%를 폐기하는 것입니다.

공정한 샘플링 구현: 우리 연구는 샘플링 비율에서 독점 모델에 대한 큰 편향을 발견했습니다. OpenAI, Google 모델의 최대 일일 샘플링 비율이 최대 34%인 반면, Allen AI와 같은 제공업체의 최대 샘플링 비율은 10배 더 낮다는 것을 관찰했습니다. 우리는 아레나 운영진 스스로 제안한 활성 샘플링 방법으로의 복귀를 제안합니다. 이 방법은 실제로 구현되지 않는 것으로 보입니다. 이 공식은 단순히 대규모 독점 제공업체를 선호하는 것을 피하고 대신 평가가 부족하고 분산이 큰 쌍에 효과적으로 우선순위를 둡니다. 이는 일부 제공업체를 선호하는 대신 순위의 불확실성을 신속하게 줄이는 목표에 따라 투표를 집중시킵니다.

리더보드에서 제거되는 모델에 대한 투명성 제공: 우리는 많은 수의 모델이 공식적으로 폐기된 모델 목록에 추가되지 않고 조용히 폐기되었다는 것을 발견했습니다. 243개의 공개 모델 중 47개만이 공식적으로 폐기된 것으로 등재되어 있지만, 205개의 모델이 제공업체에 알리지 않고 운영진에 의해 조용히 제거되었다는 것을 측정했습니다. 투명성을 확보하고 폐기 정책이 공정하게 시행되도록 하기 위해서는 리더보드에서 제거된 모든 모델의 포괄적인 목록이 있어야 합니다.