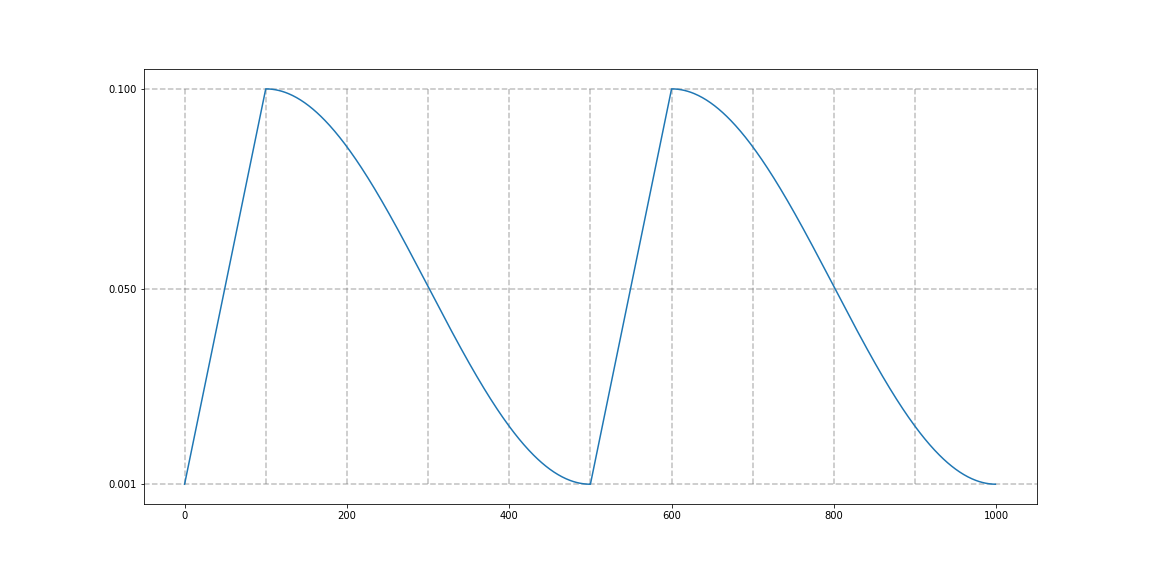

learning rate scheduler중에 대표적으로 사용하는 것 중 하나인 cosine-annealing-with-warmup 방법이 있다.

또 스튜핏한 짓을 해버렸는데, epoch이 10짜리인 훈련에서 scheduler step을 epoch으로 가져가 버렸다.

그러면 당연히 epoch마다 lr이 고정돼있으니, 이게 하나 마나이지 않은가 ??

그러니 꼭 사용하기 전에, iteration단위로 decay를 줄지, 아니면 epoch단위로 줄지 정하고 하자..

아래 링크의 cosine annealing을 사용했다.

https://github.com/katsura-jp/pytorch-cosine-annealing-with-warmup/tree/master