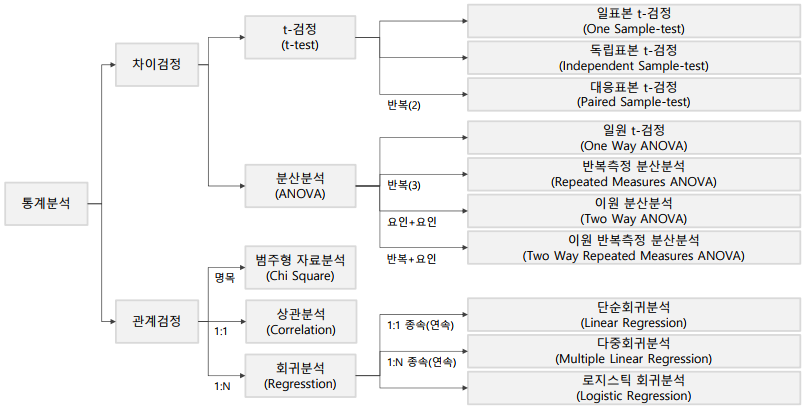

Chapter 2 기초통계-심화과정

범주형자료분석

적합도 검정

-

범주형 자료: 관측된 결과를 어떤 속성에 따라 몇 개의 범주로 분류 시켜 도수로 주어진 데이터

-

범주형 자료 분석(categorical data analysis)

-> 범주형 자료에 대한 통계적 추론 방법

-> 범주형 자료 분석은 카이제곱 검정으로 추론 -

t-test는 연속형, 카이제곱 검정은 명목형

-

적합도 검정(goodness of fit test): 관측된 값들이 추론하는 분포를 따르고 있는지 검정, 한 개의 요인을 대상으로 검정

-

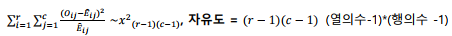

독립성 검정(test of independence): 관측된 값을 두 개의 요인으로 분할하고 각 요인이 다른 요인에 영향을 끼치는지(독립)를 검정

-

독립성 검정(test of independence): 관측된 값을 두 개의 요인으로 분할하고 각 요인이 다른 요인에 영향을 끼치는지(독립)를 검정

-

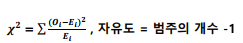

카이제곱 분포

-> O는 관찰 빈도(observed frequency): 데이터로 부터 수집된 값

-> E는 기대 빈도 (expected frequency): 기대값과 비슷한 개념

-> 기대빈도는 예를 들어 남녀 1000명의 데이터에서 각 성별의 기대 빈도는 500명임, 주사위 120번을 던졌을 때 각 눈이 나오는 기대빈도는 20번임

독립성 검정

- 독립성 검정(test of independence): 관측된 값을 두 개의 요인으로 분할하고 각 요인이 다른 요인에 영향을 끼치는지(독립)를 검정

동질성 검정

- 동질성 검정(test of homogeneity): 서로 다른 모집단에서 관측된 값들이 범주내에서 동일한 비율을 나타내는지 검정

상관분석

-

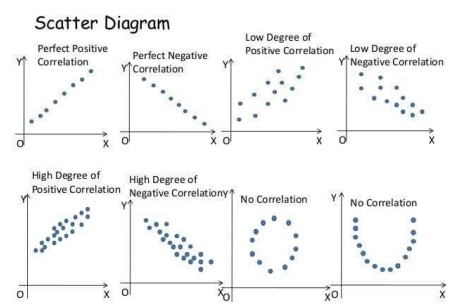

상관관계(correlation coefficient): 두 변수간의 함수 관계가 선형적인 관계가 있는지 파악할 수 있는 측도가 상관계수

1) 상관계수 −1 <= t <= 1

2) 상관계수가 1에 가까울 수록 양의 상관계가 강함

3) 상관계수가 -1에 가까울 수록 음의 상관관계가 강함

4) 상관계수가 0에 가까울 수록 두 변수 간의 상관관계가 존재하지 않음

5) 상관계수가 0이라는 것은 두 변수 간에 선형 관계가 존재 하지 않는 다는 것 -

표본상관관계(sample correlation coefficient)

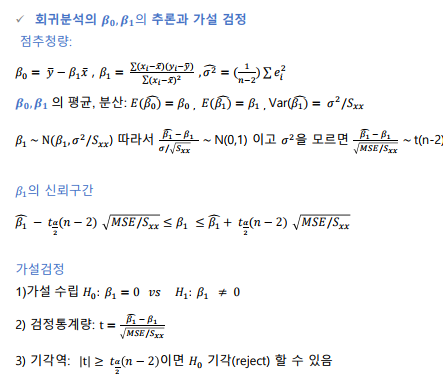

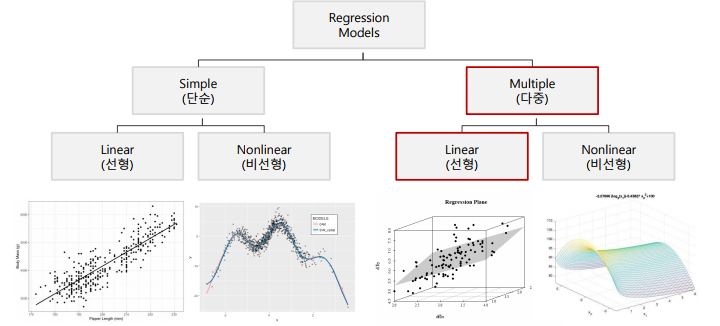

회귀분석

단순 회귀 분석

-

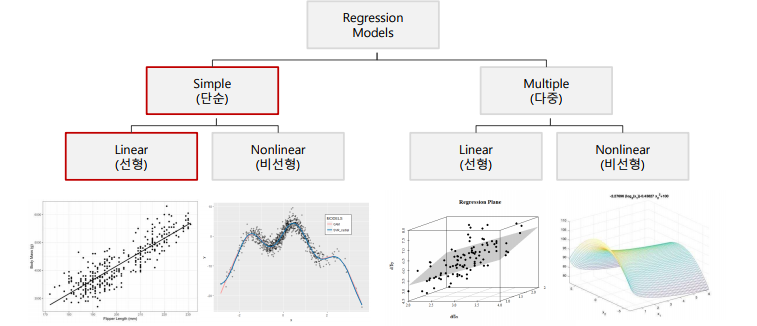

회귀 분석(regression analysis):

-> 변수들간의 함수적 관계를 선형으로 추론하는 통계적 분석 방법으로 독립변수를 통해 종속변수를 예측하는 방법

-> 비선형인 함수적 관계일 경우 비선형회귀 (nonlinear regression)를 사용

-> ex) 마케팅 비용에 따른 매출액을 예측 -

종속 변수(dependent variable): 다른 변수의 영향을 받는 변수로 반응변수라 표현 하기도 하며, 예측을 하고자 하는 변수

-

독립 변수(independent variable): 종속변수에 영향을 주는 변수로 설명변수라 표현하기도 하며, 예측 하는 값을 설명해주는 변수

-

단순 회귀분석(simple regression analysis): 하나의 독립변수로 종속변수를 예측하는 회귀 모형을 만드는 방법

-

다중 회귀분석(multiple regression analysis): 2개 이상의 독립변수로 종속 변수를 예측하는 회귀 모형을 만드는 방법

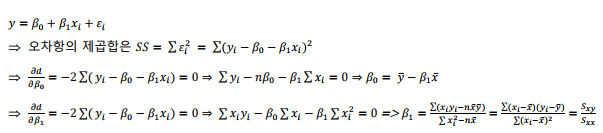

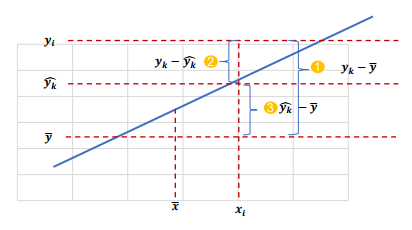

- 단순 회귀분석에서는 회귀선으로부터 각 관측치의 오차를 최소로 하는 선을 찾는 것이 핵심

최소 제곱법

- 회귀 모형의 모수 , 을 추정하는 방법중 하나를 최소 제곱법이라고 하며, 회귀 모형의 모수를 회귀 계수라고 함

- 최소 제곱법을 통해 구한 추정량을 최소제곱추정량(LSE)라고 하며, 최소제곱법을 통해 회귀모형의 모수를 추정하는 것을 OLS(Ordinary Least Square) 라고 함

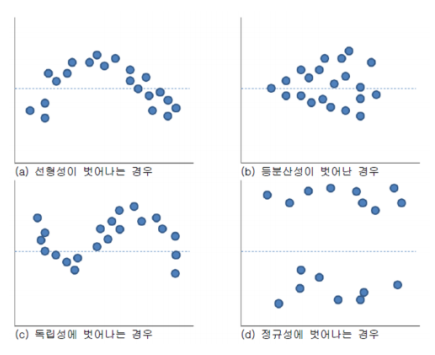

- 회귀 모형의 오차에 대하여 기본 가정이 있음

1) 정규성 가정: 오차항은 평균이 0인 정규 분포를 따름

2) 등분산성 가정: 오차항의 분산은 모든 관측값 에 상관없이 일정함

3) 독립성 가정: 모든 오차항은 서로 독립임

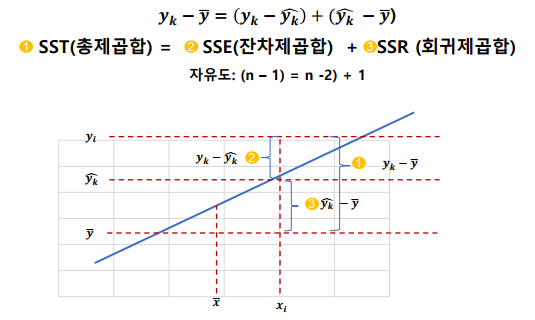

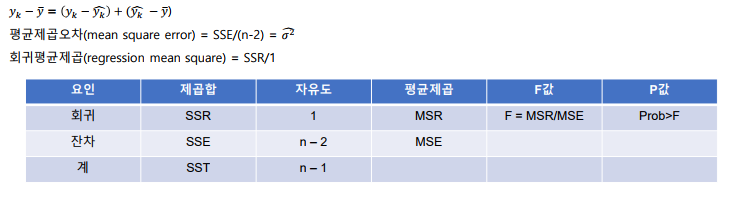

분산분석표

-

추정된 회귀식에 대한 유의성 여부는 분산분석을 통해서 회귀식의 유의성을 판단 할 수 있음

-

제곱합을 각각의 자유도로 나눈 값을 평균제곱이라고 함

- 결정계수(Coefficient of determination): 추정된 회귀식이 얼마나 전체 데이터에 대해서 적합한지(설명력이 있는지)를 수치로 제공하는 값

-> 0과 1사이에 값으로 1에 가까울수록 추정된 모형이 설명력이 높다고 할 수 있음

-> 0이라는 것은 추정된 모형이 설명력이 전혀 없다고 할 수 있음

- 수정 결정계수(Adjust )

-> 결정계수는 유의하지 않은 변수가 추가되어도 항상 증가됨(다중회귀)

-> 수정 결정 계수는 특정 계수를 곱해 줌으로서 가 항상 증가하지 않도록 함

-> 보통 모형 간의 성능을 비교할 때 사용함

잔차분석

a) 선형성을 벗어나는 경우

-> 종속변수와 독립변수가 선형 관계가 아님

b) 등분산성이 벗어난 경우

-> 일반적인 회귀모형 사용 불가능

-> 등분산성 가정 위배

c) 독립성에 벗어나는 경우

-> 시계열 데이터 또는 관측 순서에 영향을 받는 데이터 에서는 독립성을 담보 할 수 없음(Durbin-Watson test 실행)

d) 정규성을 벗어 나는 경우

-> Normal Q-Q plot으로도 확인

-> 잔차가 -2 ~ +2 사이에 분포 해야 함

-> 벗어나는 자료가 많으면 독립성 가정 위배

다중 회귀분석

-

다중 회귀분석(multiple regression analysis): 2개 이상의 독립변수로 종속 변수를 예측하는 회귀 모형을 만드는 방법

-

로지스틱 회귀분석(Logistic regression analysis): 반응 변수가 범주형(이진수)인 경우 사용하는 모형 (불량예측, 신용도 등에서 활용)

-

다항 회귀분석(polynomial regression): 독립 변수가 k개이고 반응 변수와 독립변수가 1차 함수 이상인 회귀 분석

변수 선택법

- 전진선택법(forward selection): 독립변수를 1개부터 시작하여 가장 유의한 변수들부터 하나씩 추가하면서 모형의 유의성을 판단하는 방법

- 후진 제거법(backward selection): 모든 독립변수를 넣고 모형을 생성한 후, 하나씩 제거하면서 판단하는 방법

- 단계접 방법(stepwise selection): 위의 두가지 방법을 모두 사용하여 변수를 넣고 빼면서 판단하는 방법

더미 변수(dummy variable)

- 값이 ‘0‘ 또는 ‘1’로 이루어진 변수

- 회귀분석에서 범주형 변수를 사용하기 위해서는 더미변수가 필요함

- 예를 들어 사는 지역을 ‘1’, ‘2’, ‘3’으로 사용하면 연속형 변수여서 정확한 변수로 사용할 수 없음

- 범주형 변수를 0과 1의 조합으로 표현 할 수 있도록 더미 변수를 생성함

- 예시) 최종 학력: 고졸, 대졸, 석사, 박사 4가지로 표현 한다면 필요한 더미의 개수는 4-1 = 3개

다중공선성(Multicollinearity)

- 상관관계가 높은 독립변수들이 동시에 사용될 때 문제가 발생

- 로지스틱 회귀분석에서는 고려할 필요 없음

- 결정계수값은 높아 회귀식의 설명력은 높지만 독립변수의 P-value 커서 개별 인자들이 유의하지 않는 경우 의심할수 있음

- 일반적으로 분상팽창요인 (Variance Inflation Factor: VIF)이 10 이상이면 다중공선성이 존재함

- 해결 방안

1) 다중공선성이 존재 하지만 유의한 변수인 경우 목적에 따라서 사용할 수 있음

2) 변수 제거

3) 주성분분석으로 변수를 재조합

이 글은 제로베이스 데이터 취업 스쿨의 강의 자료 일부를 발췌하여 작성되었습니다