sshfs

- NFS는 UID, GID 미스매치 문제, nfs v4 kerberos 로 id map 등 너무 귀찮은게 많은데, server와 ssh 연결이 되어 있다면 그냥 sshfs 사용!

- Ubuntu sshfs install

$ sudo apt install sshfsserver

- 서버에 공유용 디렉토리를 만든다.

$ mkdir sshfs_workspaceclient

- server 디렉토리를 마운트 할 디렉토리를 만든다.

$ mkdir dhyang_workspace- mount

$ sshfs -o reconnect -o [allow_other | IdentityFile='id_rsa'] User@HostName:<Server>/<Absolute>/<Directory> <MyDir Path>

$ sshfs -o reconnect -o IdentityFile=~/.ssh/id_rsa dhyang@10.177.227.41:/home/dhyang/sshfs_workspace ~/dhyang_workspace

- umount

$ umount <Dir>

/etc/fstab등록

dhyang@10.177.227.41:/home/dhyang/sshfs_workspace /home/markyang/dhyang_workspace fuse.sshfs defaults,_netdev,delay_connect,allow_other,uid=1000,gid=1000,IdentityFile=/home/markyang/.ssh/id_rsa,defaults 0 0| option | description |

|---|---|

defaults | 설정되지 않은 값에 대해서는 기본 설정을 따릅니다. |

_netdev | 네트워크 드라이브임을 의미하며, 마운트 시도 전 네트워크가 올바르게 설정되어 있는지 검사합니다. |

delay_connect | 부팅 과정에서 아직 네트워크 설정이 끝나지 않아 마운트를 하지 못하는 경우에 대비하여 시간을 지연하여 연결합니다. |

allow_other | 마운트된 디렉토리에 일반 유저의 접근을 허용합니다. |

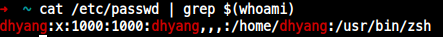

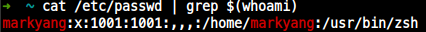

uid, gid | 마운트된 디렉토리의 소유(Ownership)을 지정합니다. 특정 유저의 uid및 gid는 'id {username}'명령으로 확인할 수 있습니다.markyang (uid=1001, gid=1001)dhyang (uid=1000, gid=1000) |

IdentifyFile | 인증에 사용할 Key를 지정합니다. 마운트는 root권한으로 실행되므로 Key가 root의 홈디렉토리에 존재하지 않는 경우 이렇게 수동으로 지정해 줘야 합니다. |

NFS

- Client - Server VFS(Virtual File System)

- 프로그램이 NFS 파일 시스템을 사용할 경우

- VFS 인터페이스를 통해 NFS 클라이언트로 접근하여 이 요청을 NFS 서버에 전달, 이 때 NFS 클라이언트 요청은 먼저 RPC/XDR 프로토콜에 전달한다. 이 요청에는 NFS 서버의 이름과 공유된 디렉토리의 정보를 포함한다.

- RPC는 한 컴퓨터의 프로그램이 다른 컴퓨터에서 실행 중인 프로그램의 프로시저를 직접 호출해서 두 프로그램 사이에 직접 통신을 연결하는 프로토콜이다. 이 때 RPC는 연결된 TCP/IP를 통해 stub 모듈을 사용하여 클라이언트의 요청 파라미터를 서버에게 전달하고, 서버의 실행 결과를 다시 되돌려준다. NFS나 Ceph처럼 RPC는 분산 처리 기능을 제공하는 프로그램에서 주로 사용되며, 클라이언트에서 요청하는 프로그램이 서버 프로시저의 프로그램에서 주로 사용되며, 클라이언트에서 요청하는 프로그램이 서버 프로시저의 처리 결과가 반환 될 때까지 일시적으로 정지 상태에 이르는 동기식(synchronous) 방식을 사용한다. 현재 이러한 RPC는 NFS 서비스가 제공하는

rpcbind대몬에 의해 제어된다. - XDR(eXternal Data Representation)은 선 마이크로시스템즈에서 개발한 프로토콜로서 이기종 간에 컴퓨터의 데이터 표현 방식이 서로 다른 경우 한 컴퓨터에서 XDR 형식으로 데이터를 변환하고, 다른 컴퓨터에서 변환된 데이터를 해당 컴퓨터에서 사용하는 데이터 방식으로 변환한 뒤에 사용할 수 있게 도와주는 역할을 한다.

- RPC, XDR은 이 요청을 TCP/IP를 통해 NFS 서버에게 전달하는데, NFSv2, NFSv3는 이 때 UDP와 TCP 중에서 선택해서 사용할 수 있지만, NFSv4는 TCP 포트 2049번을 사용한다.

NFSv4의 경우 TCP 포트 2049번을 통해 요청받은 NFS 서버는 리눅스 파일 시스템에 접근하기 위해 VFS 인터페이스를 통해 파일 시스템에 접근하고, 다시 구체적으로rpc.mountd대몬을 통해 로컬 디스크를 NFS 클라이언트에게 전달함으로써 클라이언트 시스템이 서버의 로컬 디스크를 마치 자신의 로컬 파일 시스템처럼 사용할 수 있게 제공한다.

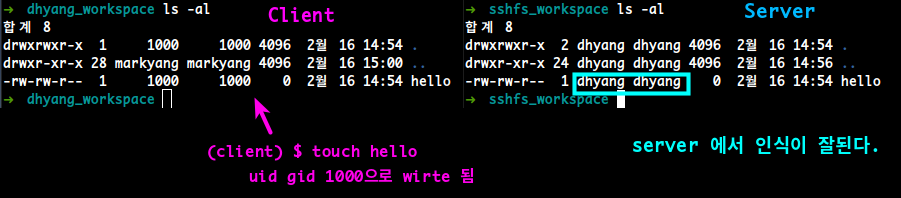

NFS uid, gid 문제

- NFS server는 클라이언트를 UID로 인식하기 때문에 UID가 일치하지 않으면 write X

- Server UID: 1000

- Client UID: 1001

- Server UID: 1000

NFS v4 설치

Ubuntu 20.04.03 LTS

- NFS v4 출처: https://jjeongil.tistory.com/1620

- 호스트 제공자가 개인 IP 주소를 제공하지 않는 경우 공용 IP 주소를 사용하고, 신뢰할 수 있는 소스에서만 Port 2049의 트래픽을 허용하도록 서버 방화벽을 구성할 수 있다.

NFS Server IP: 10.177.227.41

NFS Client IP: 10.177.227.40NFS 서버 설치

$ sudo apt install nfs-kernel-server

NFS 버전확인

$ sudo cat /proc/fs/nfsd/versions

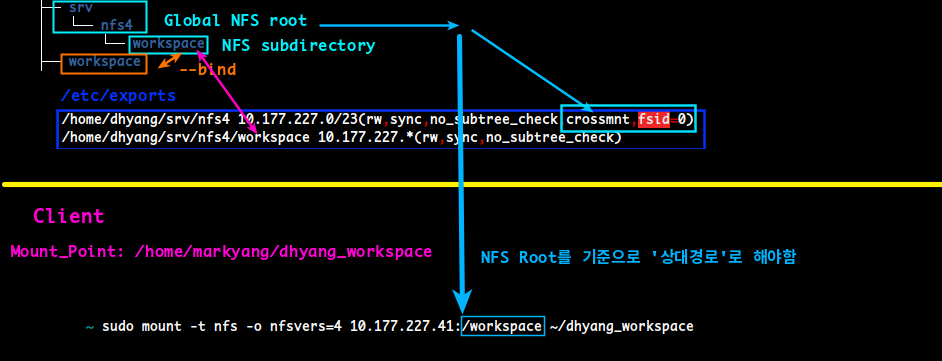

NFSv4 파일 시스템 생성

- NFSv4 서버를 구성할 때는 Global NFS root 디렉토리를 사용하고, 실제 디렉토리를 공유 마운트 지점에 바인딩하는 것이 좋다.

- NFS root 설정:

~/srv/nfs4- subdirectory:

~/srv/nfs4/workspace

- subdirectory:

$ mkdir -p ~/srv/nfs4

$ mkdir -p ~/srv/nfs4/workspace

$ chmod 777 ~/srv/nfs4/workspace- NFS root 는 NFSv4 에서 도입된 개념인데, client에서 mount 할 때, 매우 중요하다!

- client에서 mount 할 때, 이 NFS root 에서 상대 경로로 지정해야 NFSv4 가 사용된다.

- 실제디렉토리:

~/workspace

$ mkdir -p ~/workspace- 실제 디렉토리를 바인드&마운트

$ sudo mount --bind ~/workspace ~/srv/nfs4/workspace/etc/fstab에 영구 등록

/home/dhyang/workspace /home/dhyang/srv/nfs4/workspace none bind 0 0NFS 설정

/etc/exports

/home/dhyang/srv/nfs4 10.177.227.0/23(rw,sync,no_subtree_check,crossmnt,fsid=0)

/home/dhyang/srv/nfs4/workspace 10.177.227.*(rw,sync,no_subtree_check)

- Global NFS root은 crossmnt,fsid=0 옵션을 주자.

- corssmnt는 내보낸 디렉토리의 하위 디렉토리를 공유한다.

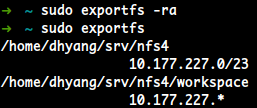

$ sudo exportfs -ra /etc/exports 파일을 수정할 때매다 위 명령을 실행하여 반영시 문제가 없는지 체크한다.

/etc/exports 파일을 수정할 때매다 위 명령을 실행하여 반영시 문제가 없는지 체크한다.

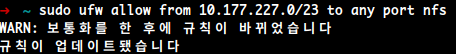

방화벽 설정

- 아직 방화벽 개념에 익숙치 않다면, 넘어가자

$ sudo ufw allow from 10.177.227.0/23 to any port nfs- 확인

$ sudo ufw statusNFSv4 클라이언트 설정

- Ubuntu

$ sudo apt install nfs-common- CentOS/Fedora

$ sudo yum install nfs-utilsNFS 디렉토리 생성

- Client에서 NFS mount 할 디렉토리:

/home/markyang/dhyang_workspace

$ mkdir ~/dhyang_workspace★ mount ★

- 아무리 Server에서 설정 잘 했어도, 클라이언트에서 잘 못 마운트하면

nfsver=3로 된다.- NFS v3 :

HostName:<절대경로>$ sudo mount -t nfs -o vers=4 10.177.227.41:/home/dhyang/srv/nfs/workspace /home/markyang/dhyang_workspace- 아무리

vers=4를 명시 했어도,HostName:<절대경로>로 지정했기 때문에nfsver=3로 강제 마운트된다.

- 아무리

- NFS v4 :

HostName:<NFS_root를 root로 하는 상대경로>$ sudo mount -t nfs -o vers=4 10.177.227.41:/workspace /home/markyang/dhyang_workspace

- NFS v3 :

- 영구 등록은

/etc/fstab에서 한다.

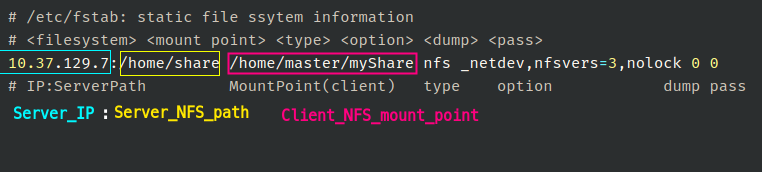

# /etc/fstab

10.177.227.41:/workspace /home/markyang/dhyang_workspace nfs nfsvers=4,defaults,_netdev 0 0

| 추가옵션 | 설명 |

|---|---|

port=<PORT> | 포트번호 지정 |

_netdev | nfs등을 사용할 때 사용되는 옵션. 이 옵션이 없으면 mount가 네트워크 연결보다 먼저 일어나기 때문에 시스템 시작 시, 자동 마운트 되지 않는다. 심한 경우 무한 블록된다. 즉, _netdev 옵션은 '네트워크에 연결후 마운트' 하라는 옵션이다. |

NFS Server <= ver.3

설치

sudo apt install nfs-kernel-server

공유폴더 생성

/home/share에 생성 하겠음

$ sudo mkdir /home/share

$ sudo chmod -R 777 /home/shareNFS server 셋팅

/etc/exports

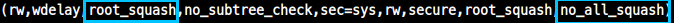

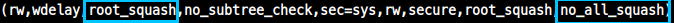

/etc/exports에서 설정

- 이 것만 써도, 자동으로 여러 옵션이 들어간다.

NFS 옵션

| NFS 옵션 | description |

|---|---|

rw | client가 서버 디렉토리에 읽기, 쓰기 모두 허용 |

ro | client가 NFS 서버 디렉토리에 read-only만 허용(기본 값) |

sync | client가 NFS 서버에 write 작업을 하면 바로 반영(기본 값) |

async | client가 NFS 서버에 write 작업을 하면 바로 반영X 서버에 문제가 발생했을 때, 데이터 불일치가 발생할 수 있다. |

root_squash | client가 uid/gid 0(root)로 접속해도 서버에서는 이를 anonymous uid/gid로 취급한다 (가지고 있는 권한이 없음) |

no_root_squash | client가 root권한을 사용할 수 있다. 즉, 클라이언트의 root와 서버의 root를 일치시킨다. |

all_squash | 모든 사용자를 nobody로 매핑 즉, 이 옵션이 set 되어 있으면 nfsnobody 소유로 파일 생성된다. |

no_all_squash | 서버의 사용자와 클라이언트의 사용자를 일치 시킨다. 헷갈리지 말자.. 서버와 클라이언트의 UID를 매칭 시키는 것이 아니고, 각자의 이름을 사용할 수 있게하는 것 |

anonuid | anonymous 계정의 uid를 해당 값으로 설정한다.예: anonuid=1001 |

anongid | anonymous 계정의 gid를 해당 값으로 설정한다.예: anongid=1001 |

nohide | 일반적으로 서버가 두 개의 파일 시스템을 제공하는 경우, nohide 옵션은 파일 시스템이 hidden 상태가 되지 않게한다.예를 들어, 하나의 명백한 파일 시스템에서 두 개의 파일이 동일한 아이노드 번호를 가질 수 있다. nohide 옵션은 현재 single host exports에게만 적용된다. 넷 그룹, 서브넷 또는 와일드카드 export에서는 안정적으로 작동하지 않는다. |

crossmnt | 이 옵션은 nohide와 비슷하지만, 클라이언트가 crossmnt로 표시된 파일 시스템에서 마운트된 exported 파일 시스템으로 이동할 수 있다. 따라서 하위 파일 시스템 "B"가 상위 "A"에 마운트 되었을 때, crossmnt를 설정하는 것은 nohide를 "B"에 설정하는 것 과 같다. |

fsid=(num│root│uuid) | NFS는 export되는 각 파일 시스템을 식별할 필요가 있다. 일반적으로 파일 시스템에 대해 UUID나 파일 시스템을 보유하고 있는 device number(파일 시스템이 장치에 저장되어 있는 경우)를 사용한다. 모든 파일시스템이 device에 저장되는 것이 아니며 모든 파일 시스템에 UUID가 있는 것도 아니기 때문에 NFS에 파일 시스템을 식별하는 방법을 명시적으로 알려줘야 하는 경우가 있다. 이 작업은 fsid= 옵션으로 수행된다. NFSv4의 경우 export한 모든 파일 시스템의 루트인 고유 파일 시스템이 있다. 다른 파일 시스템은 작은 정수 또는 32개의 16진수 및 임의 구두점을 포함해야하는 UUID로 식별할 수 있다. Linux 커널 버전 2.6.20 이하에서는 UUID 설정을 이해하지 못하므로 이러한 커널에 대해 fsid 옵션을 설정해야하는 경우 작은 정수를 사용해야 한다. 이전 커널과 새커널에서 모두 작동하도록 동일한 구성을 만들 수 있도록 작은 숫자와 UUID를 모두 설정할 수 있다. |

no_subtree_check | 이 옵션은 하위 트리 검사를 중지하여 보안에 상당한 영향을 끼치지만, 경우에 따라 안정성이 향상될 수 있다. 파일 시스템의 하위 디렉토리를 export 했지만 NFS 요청이 도착할 때마다, 전체 파일 시스템을 export하지는 않는 경우, 서버는 액세스한 파일이 적절한 파일 시스템에 있는지(쉽지만) 검사해야 할 뿐만 아니라 export된 트리에도 있는지 (더 어려움) 검색해야 한다. 이것이 이 검사를 수행하려면 서버는 클라이언트에 제공된 'filehandle"에 파일 위치에 대한 일부 정보를 포함해야한다. 이로 인해 클라이언트가 열려 있는 동안 이름이 변경된 파일에 액세스 하는데 문제가 발 생 할 수 있다. (대부분의 경우는 여전히 작동한다.) subtree check는 또한 파일 시스템이 no_root_squash로 export된 경우에만 루트만 액세스 할 수 있는 디렉토리 내부의 파일에 액세스할 수 있는지 확인하는 데 사용된다. 일반적으로 루트에서 내보내고 많은 파일 이름을 볼 수 있는 홈 디렉토리 파일 시스템은 subtree check를 사용하지 않는 상태에서 export해야한다. 대부분이 읽기전용이며 적어도 많은 파일 이름(e.g., /usr, /var)이 표시되지 않고 하위 디렉토리를 내보낼 수 있는 파일 시스템은 하위트리 검사를 사용하도록 설정하여 내보내야 한다. subtree check는 그 가치보다 더 많은 문제를 일으키는 경향이 있으므로, nfs-utils release 1.1.0 부터는 no_subtree_check가 default이다. 어느 옵션도 넣지 않으면, exportfs에서 변경사항이 보류중임을 경고한다. |

insecure | 옵션을 사용하면 NFS용으로 예약된 포트를 사용하지 않는 클라이언트도 사용허가한다. |

주의!! /etc/exports에 썼다고 내용 적용되는 것이 아니다!

1. NFS 대몬을 restart 해야 적용된다.

2. $ sudo exportfs명령을 사용해 잘 적용되는지 체크하라!

anonuid, anongid

- 이 옵션은

anonymous의 계정의 uid를 해당 값으로 설정한다. - 이 옵션은 user의 모든 요청을 표시하려는 PC/NFS 클라이언트에 주로 유용하다.

- 예를 들어, 아래 예제에서

/home/joe대한 export 항목을 고려하세요. - 이 항목의 모든 요청은

uid 150(user: joe)에 매핑한다.

- 예를 들어, 아래 예제에서

# sample /etc/exports file

1. / master(rw) trusty(rw,no_root_squash)

2. /projects proj*.local.domain(rw)

3. /usr *.local.domain(ro) @trusted(rw)

4. /home/joe pc001(rw,all_squash,anonuid=150,anongid=100)

5. /pub *(ro,insecure,all_squash)

6. /srv/www -sync,rw server @trusted @external(ro)

7. /foo 2001:db8:9:e54::/64(rw) 192.0.2.0/24(rw)

8. /build buildhost[0-9].local.domain(rw)- 1 번째 줄은 전체 파일 시스템을 master 및 trusty로 내보낸다.

rw, no_root_squash

- 2 번째 줄과 3 번째 줄은 wildcard hostnames, netgroups ('@trusted')의 예를 보여준다.

- 4 번째 줄은 위에서 설명한 PC/NFS 클라이언트에 대한 항목을 보여준다.

- 5 번째 라인은 public FTP direcoty를 every host에게 exports한다. 모든 nobody account에 대해 요청을 실행한다.

insecure옵션을 사용하면 NFS용으로 예약된 포트를 사용하지 않는 클라이언트도 사용허가한다.

- 6 번째 라인은 디렉토리 읽기/쓰기 및 @trusted netgroup을 machine 'server'로 r/w권한을 갖게 export한다. '@external' netgroup은 ro권한으로 한다.

- 7 번째 라인은 디렉토리를 IPv4, IPv6 서브넷으로 내보낸다.

- 8 번째 라인은 와일드카드 사용을 나타낸다.

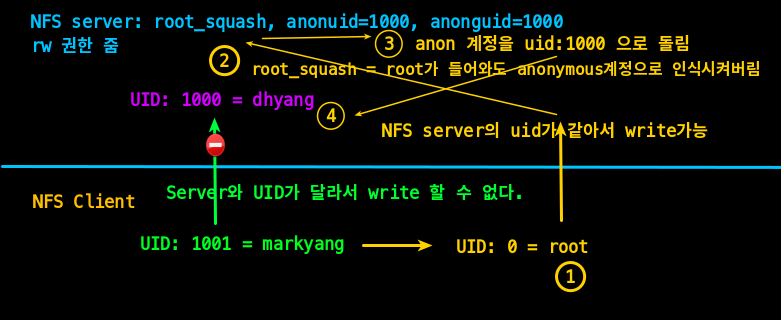

(no_|)root_squash

- Server: root_squash, anonuid=1000, anongid=1000 시

clinet에서 root로 접근 시, rootsquash 때문에, anonymous로 인식되어 UID가 매칭됨

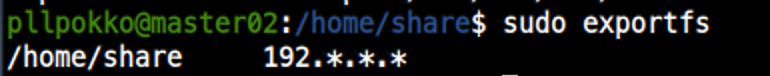

nfs 운영($ exportfs)

- exportfs (

sudo): NFS 서버 대몬을 다시 시작하지 않고도 공유 목록(/etc/exports) 파일의 변경된 내용 적용시킬 수 있음

$ sudo exportfs [option]

option:

-a 설정 파일(/etc/exports)을 읽어들인다. (처음 한번 사용)

-r 설정 파일(/etc/exports) 파일을 다시 읽어 들인다. = service nfs restart

-v 현재 공유되는 디렉토리 목록 출력

-u IP주소:경로 경로로 지정한 디렉토리를 익스포팅하고 IP주소로 지정한 클라이언트의 접속을 허용한다.

e.g.,:

exportfs

exportfs -v

exportfs -o rw 10.10.10.1:/home/pub주의!! /etc/exports에 썼다고 내용 적용되는 것이 아니다!

1. NFS 대몬을 restart 해야 적용된다.

2. $ sudo exportfs명령을 사용해 잘 적용되는지 체크하라!

- NFS 대몬이 잘 시작되어 있으며, 설정내용이 잘 적용되면 뜬다.

- 만약 변경 사항이 보이지 않으면, 아래의 NFS Daemon restart 하거나,

$ sudo exportfs -ra

NFS server 적용

$ sudo exportfs -rarpc기반 동작 nfs프로그램들이 사용하는 포트 확인

- rpc기반 동작 nfs 프로그램들이 사용하는 포트 확인

$ sudo rpcinfo -pNFS Client

설치

$ sudo apt install nfs-common

- client에서는 따로 대몬을 실행할 필요 없다.

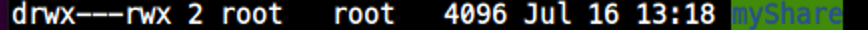

NFS client mount

- client에서 공유할 폴더 만들기:

~/myShare - NFS 공유

$ sudo mount -t nfs [SERVER HOSTNAME]:[NFS DIRECTORY PATH] [CLIENT DIRECTORY PATH]

- client 에서 만들어진 NFS 공유 디렉토리는 NFS server에서의 권한임

client to server 확인

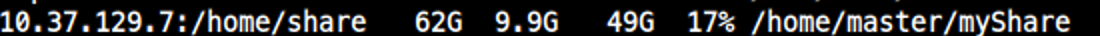

df 명령어로 확인해보면 연결된 정보 확인 가능

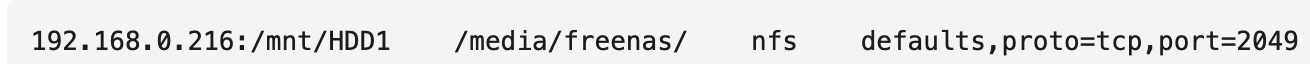

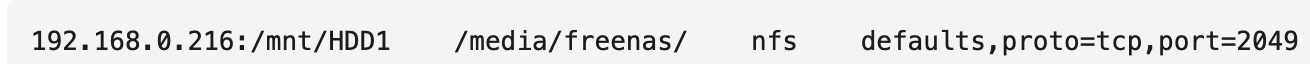

/etc/fstab에 계속 마운트

/etc/fstab에 위와같이 NFS 설정을 작성해 계속 마운트 시킨다.

/etc/fstab, nfs option | Description |

|---|---|

port=<PORT> | 포트번호 지정 |

_netdev | nfs등을 사용할 때 사용되는 옵션. 이 옵션이 없으면 mount가 네트워크 연결보다 먼저 일어나기 때문에 시스템 시작 시, 자동 마운트 되지 않는다. 심한 경우 무한 블록된다. 즉, _netdev 옵션은 '네트워크에 연결후 마운트' 하라는 옵션이다. |

nfsvers=3 | nfs 버전 명시. 앞과 같은 경우는 version 3 |

nolock | block x |

fg | 첫 번째 NFS 마운트 시도에서 타임아웃이 발생하면, 마운트 시도를 즉시 중단한다. (기본 값) |

hard | 타임아웃이 발생하면 Server not responding이라는 메시지 출력하고 무한정 재시도한다.주의!! 이 때문에, 시스템이 부팅못할 수도 있다. |

soft | 타임 아웃이 발생하면 프로그램에 오류를 보고하고 부팅을 진행 |

| timeo=n | This sets the time (in tenths of a second) the NFS client will wait for a request to complete. The default value is 7 (0.7 seconds). What happens after a timeout depends on whether you use the hard or soft option. |

| hard | Explicitly mark this volume as hard-mounted. This is on by default. This option causes the server to report a message to the console when a major timeout occurs and continues trying indefinitely. |

| soft | Soft-mount (as opposed to hard-mount) the driver. This option causes an I/O error to be reported to the process attempting a file operation when a major timeout occurs. |

/etc/fstab수정 후, 바로 Mount 적용 시키려면$ sudo mount -a

nfs 버전 체크

- server

$ nfsstat -s

...

Server nfs v4

...- client

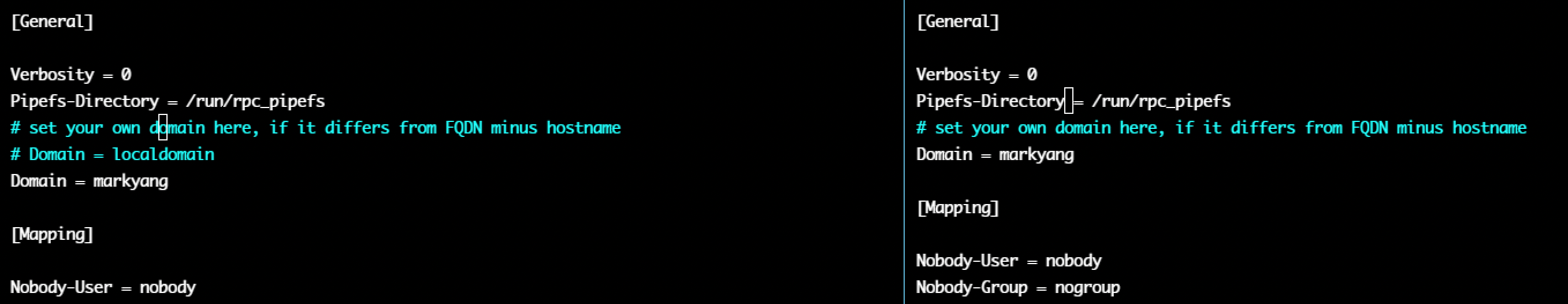

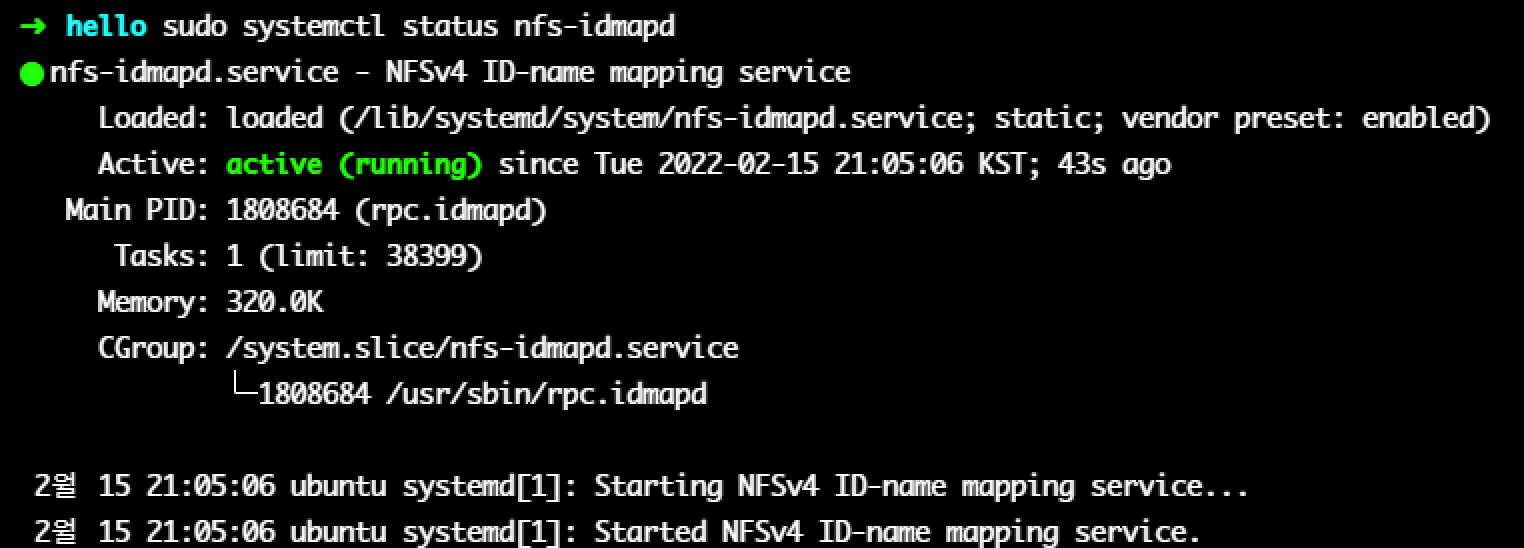

$ nfsstat -cNFS id map

server

/etc/idmapd.conf

- Mapping 부분 설정 의미는 '파일 서버'에 있는 계정이

- 마운트해서 사용하는 Client에서 계정정보가 존재하지 않을 때, 로컬에 있는 어떤 계정으로 매핑 시켜줄지 정하는 것이다.

- 만약 'test'로 해두었으면, 로컬에 test계정이 있어야햐는데, 없으면 오류

Samba

server: linux

client: win

server: win

client: linux

Linux 에서 Samba-Server 설치

$ sudo apt install samba

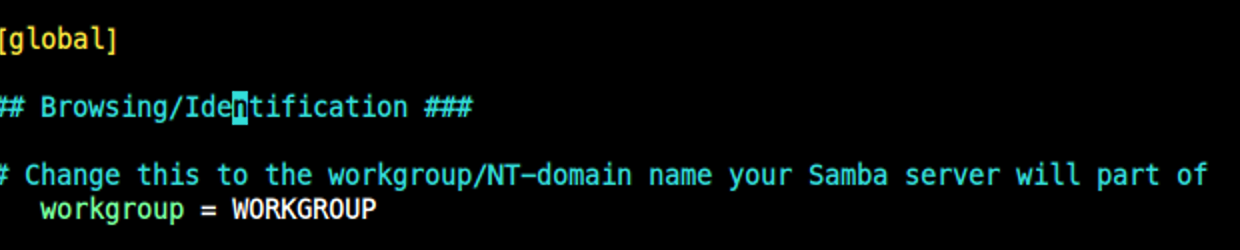

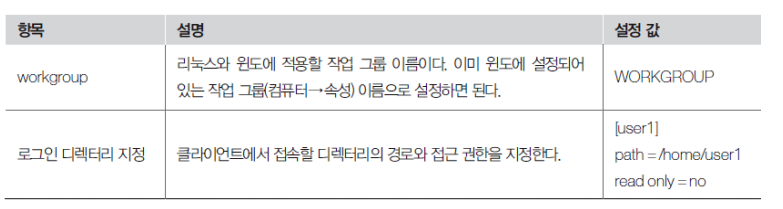

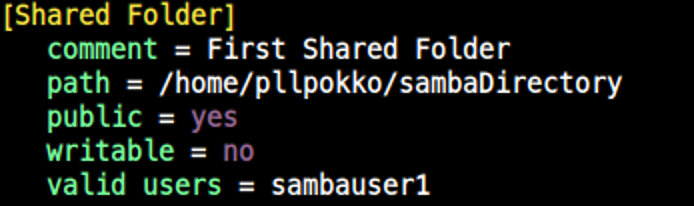

Samba-server 설정

- Samba Shared용 디렉토리 만들기

$ mkdir $HOME/sambaDirectory

$ chmod 777 $HOME/sambaDirecotry- Samba용 Linux user 만들기

$ sudo useradd sambauser1

$ sudo passwd sambauser1

새 암호:

새 암호 재입력:

passwd: 암호를 성공적으로 업데이트 했습니다.- Samba용 Linux user -> Samba password 설정

$ sudo smbpasswd -a sambauser1

New SMB password:

Retype new SMB password:

Added user sambauser1.- samba용 설정파일

/etc/samba/smb.conf