Question

1.그래프 데이터 증강은 왜하는가?

2.GNN을 실제 적용한 사례는?

그래프 신경망(Graph Neural Networks, GNN)은 그래프 구조 데이터를 처리하기 위해 설계된 신경망 모델입니다. GNN은 노드, 엣지, 전체 그래프의 구조와 속성을 효과적으로 활용하여 다양한 문제를 해결할 수 있습니다. GNN의 적용 사례는 매우 다양하

3.GNN을 잘 이해하고 있는가?

4.GCN에 교차검증을 사용해봤는가?

5.GCN은 훈련, 검증 데이터 셋을 어떤 기준으로 나눌수 있는가?

torch geometric 에있는 부분 논문 설명 찾아보기

6.배치 정규화가 뭔가?

7.model의 train과 eval의 차이

8.Structured Dropout 이란?

드롭아웃의 변형된 방식. 임의로(randomly) 개별 뉴런을 Drop(비활성화)하는 대신, 모델의 특정 구조나 패턴에 따라 더 큰 단위의 뉴런 그룹을 드롭하는 방법각 뉴런을 랜덤하게 비활성화 하여 과적합을 방지하는 데 중점을 둔다. 특정 구조적 단위(ex: chann

9.fine tuning이 뭐지?

파인튜닝(Fine-tuning)은 이미 학습된 모델을 기반으로 추가적인 학습을 통해 성능을 더 개선하는 과정을 말합니다. 일반적으로 사전 학습된 모델(pre-trained model)을 특정 작업이나 데이터셋에 맞추어 세부적으로 조정할 때 사용됩니다. 파인튜닝은 새로운

10.그래프 신경망에서 훈련, 검증, 테스트 데이터셋을 나누는 기준이 20개, 10%, 80% 인 이유는?

표준 실험설정

11.그래프신경망에서 전이학습?

전이학습(Transductive Learning): 학습데이터와 테스트 데이터가 함께 주어졌을 때, 학습된 모델이 테스트 데이터의 레이블을 추론하는 방식. 특히 그래프 신경망에서 많이 사용되며, 전체 그래프의 구조를 이용해 학습과 추론을 수행하는데 적합하다.즉, 논문간

12.보통 쌓는 레이어의 개수는?

13.GNN 레이어는 몇개를 쌓을까?

일반적인 구조는 2-3개첫번째 레이어는 각 노드의 이웃 노드의 정보를 통합하여 노드의 임베딩을 학습두번째 레이어는 더 벌리 있는 도드들 간의 관계를 학습하는데 도움을 줌더 쌓지 않는 이유오버스무딩 문제over smoothing : GNN이 너무 많은 레이어를 쌓았을 때

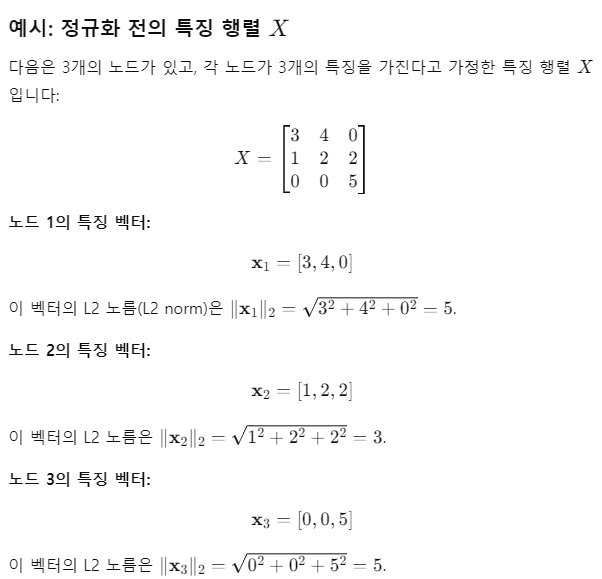

14.Cora 데이터셋을 불러올때, 노드의 특징벡터를 정규화해서 불러온다.

L2 정규화는 특징 벡터가 서로 다른 스케일을 가지는 문제를 해결하는 데 유용합니다. 이를 통해 모델이 다양한 범위의 입력값을 쉽게 학습할 수 있게 되며, 특히 다음과 같은 장점을 가집니다:수렴 속도 향상: 정규화된 특징을 사용하면 모델이 더 안정적으로 학습할 수 있고

15.추천시스템 학회

Recommender System (추천 시스템)RecSysThe ACM Conference Series on Recommender SystemsRecSys 2020 accepted papers매년 9~10월 개최2007년부터 시작되었으며, 음악, SNS, 이커머스 등

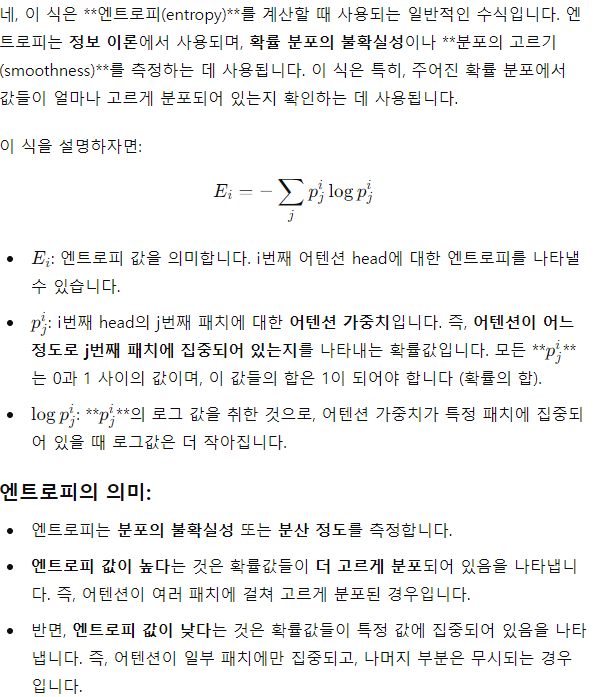

16.엔트로피를 이용하여 확률이 고르게 분포되었는지 확인하는 방법은?

17.Imagenet으로 Pretraining된 모델을 Fine Tuning 해보는 것을보며 Fine Tuning에 대해 이해하기

ImageNet으로 사전 학습된 모델을 fine-tuning하는 방법은, 사전 학습된 모델을 새로운 데이터셋에 맞춰 조정하는 과정입니다. 사전 학습된 모델이 ImageNet과 같은 대형 데이터셋에서 이미 학습된 가중치를 사용하기 때문에, fine-tuning은 더 작은

18.기존 Transformer의 입력에서는 입력값에 Normalization을 안하는데 Vision Transformer에서는 특히 Normalization을 하는 이유가 있을까?

Vision Transformer(ViT)에서 Normalization(주로 Layer Normalization)을 사용하는 이유는 이미지 데이터의 특성과 Transformer 구조의 차이에 기인합니다. 기존 Transformer에서 입력값에 직접적으로 Normaliz

19.Vision Transformer에서 Linear Projection을 하는 이유는?

고정된 차원의 임베딩 벡터로 변환하여, 일관된 입력을 제공하기 위해서Linear Projection은 주로 입력 데이터를 고정된 차원의 임베딩 벡터로 변환하기 위해 사용됩니다. 이를 통해 다양한 차원이나 구조를 가진 데이터를 Transformer와 같은 신경망 모델에서

20.ViT에서 Linear Projection은 결국 one layer Neural Network가 아닌가?

네, 맞습니다! Linear Projection은 본질적으로 하나의 층을 가진 신경망(one-layer neural network)와 같은 역할을 합니다. 이를 조금 더 구체적으로 설명하면:수학적 구조:Linear Projection은 선형 변환을 통해 입력 벡터를 다

21.활성화 함수가 없으면 미분이 불가능한가?

활성화 함수가 없더라도 미분은 가능합니다. 그러나 활성화 함수가 없는 신경망은 단순히 선형 변환만을 수행하는 모델이 되어, 비선형성을 잃게 됩니다. 이 경우, 신경망의 각 레이어는 하나의 선형 방정식으로 나타낼 수 있으며, 레이어가 아무리 깊어져도 결국 하나의 선형 변

22.logit이 뭐야?

로짓(logit)은 소프트맥스(Softmax) 또는 시그모이드(Sigmoid) 함수에 입력되는 원시 예측 값입니다. 로짓은 모델의 마지막 레이어에서 나오는 값으로, 아직 확률로 변환되지 않은 상태의 점수입니다. 쉽게 말해, 로짓은 소프트맥스나 시그모이드 함수에 들어가기

23.GNN에서 logit을 임베딩 벡터로 보는 이유는?

네, GNN(Graphe Neural Network)에서 소프트맥스 전에 나오는 로짓(logit) 값을 임베딩 벡터로 볼 수 있습니다. 특히 GNN 모델의 출력은 각 노드에 대한 예측 값으로, 이 로짓은 노드의 임베딩을 나타낸다고 할 수 있습니다.왜 GNN에서 로짓을

24.텐서는 3D차원만 입력으로 받는가?

PyTorch에서 입력 오류는 주어진 모델이나 연산이 특정 차원을 필요로 할 때 발생할 수 있습니다. 그러나 3D 텐서가 아니라고 해서 반드시 오류가 발생하는 것은 아닙니다. PyTorch에서는 모델의 구조와 레이어에 따라 요구되는 입력 텐서의 차원이 다릅니다.Full

25.배치 사이즈 선택 기준

배치 크기 선택의 기준:일반적으로 32, 64, 128과 같은 크기가 많이 사용되며, 문제의 크기, 데이터의 양, 모델 구조, 하드웨어(GPU/TPU) 등의 요소에 따라 적절한 배치 크기를 선택해야 합니다.작은 배치 크기는 더 나은 일반화 성능을 얻을 수 있지만, 큰