Introduction

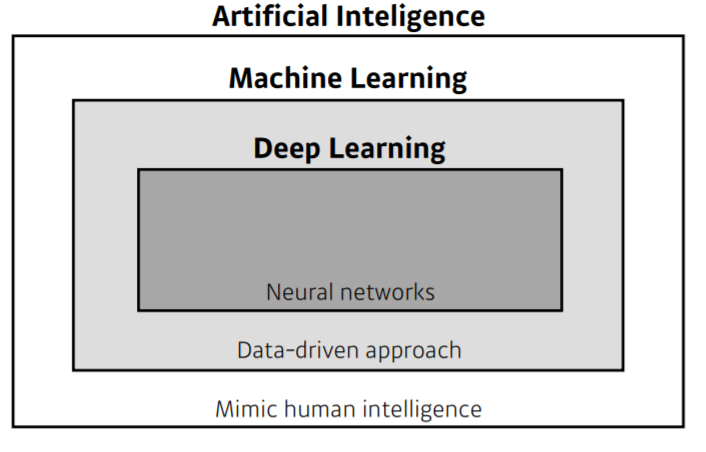

AI, ML, DL 차이

- AI가 ML과 DL을 포함하는 개념

- 자동 분류 등은 Machine Learning에 포함

- Neural Network(NN)을 사용하는 것 부터 Deep Learning이라고 함

Key Components of Deep Learning

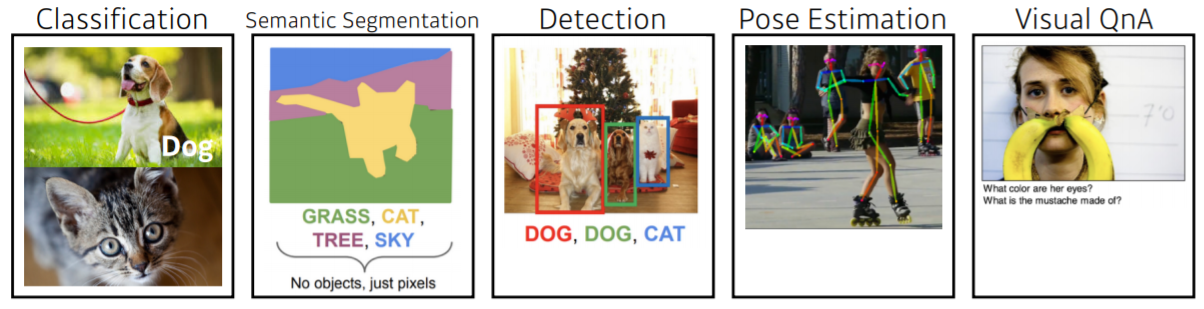

The data that the model can learn from

- 자연어, 코퍼스, 비디오, 개/고양이 image...

- Data는 풀고자 하는 문제에 따라 다름

The model how to transform the data

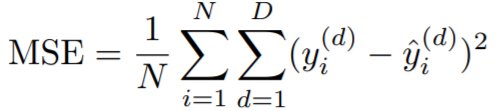

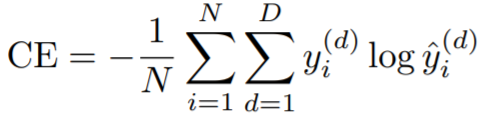

The loss function that quantifies the badness of the model

- 모델, data가 정해져 있을 때 모델을 어떻게 학습할지?

- The loss function is a proxy of what we want to achieve

- loss function 값이 줄어든다고 해서 우리가 원하는 값을 항상 이룰 것이라는 보장은 없다.

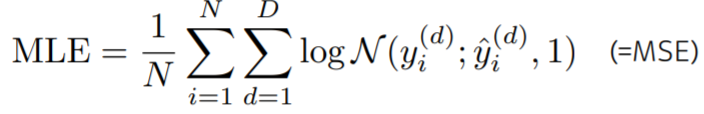

- Regression Task

- Classification Task

- Probabilistic Task

The (optimization) algorithm to adjust the parameters to minimize the loss

- Dropout

- Early stopping

- k-fold validation

- Weight decay

- Batch normalization

- MixUp

- Ensemble

- Bayesian Optimization

Historical Review

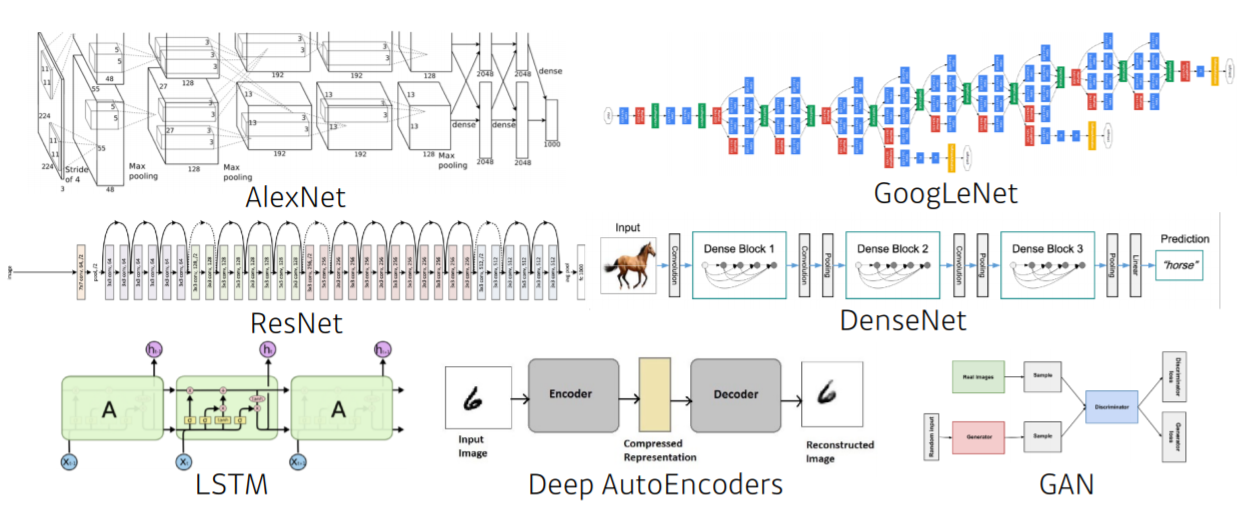

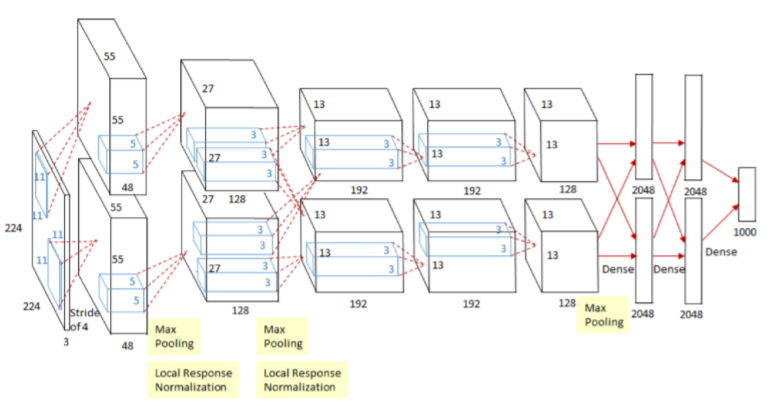

2012 - AlexNet

- Imagenet 대회에서 처음으로 딥러닝이 1등 함

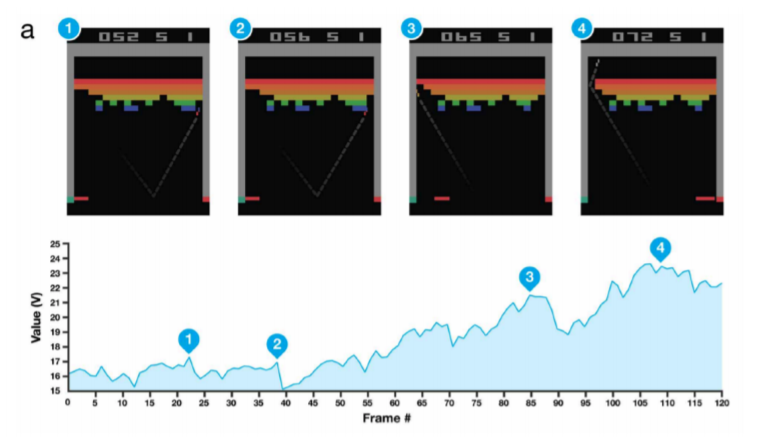

2013 - DQN

- Q-Learning을 딥러닝에 접목

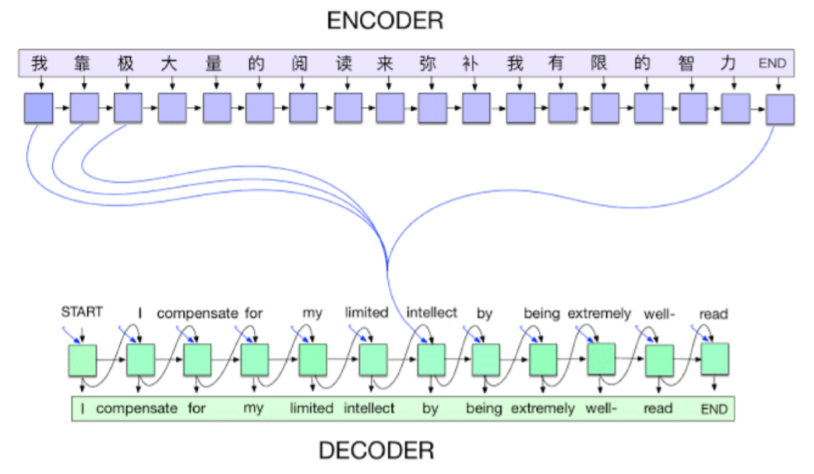

2014 - Encoder / Decoder

- NMT(Neural Machine Translation)을 풀기 위하여 등장 (단어의 연속 -> 또 다른 단어의 연속으로)

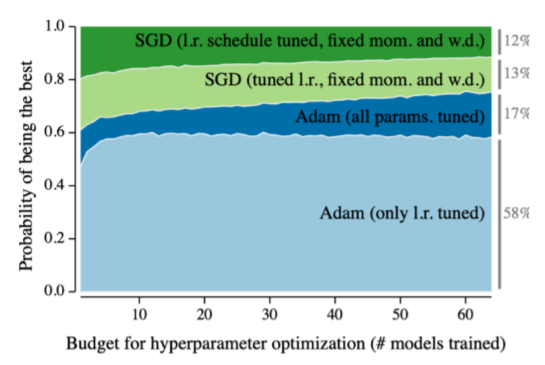

2014 - Adam Optimizer

- 결과가 잘 나옴..

"웬만하면"

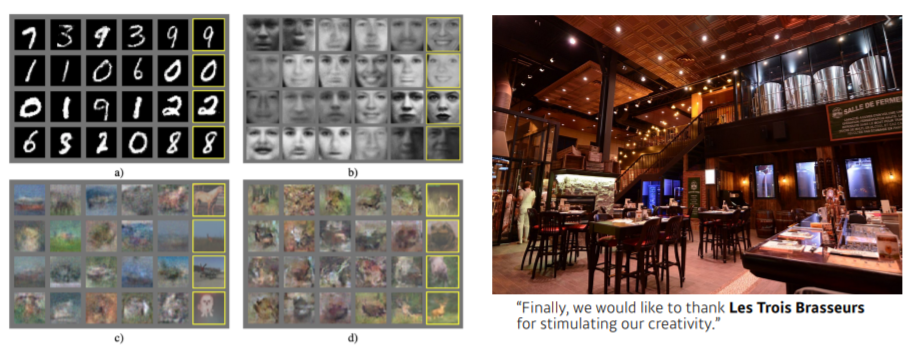

2015 - Generative Adversarial Network (GAN)

- Generator, Discriminator을 두고 서로 경쟁시켜서

그럴듯한결과를 만들어내는 기술

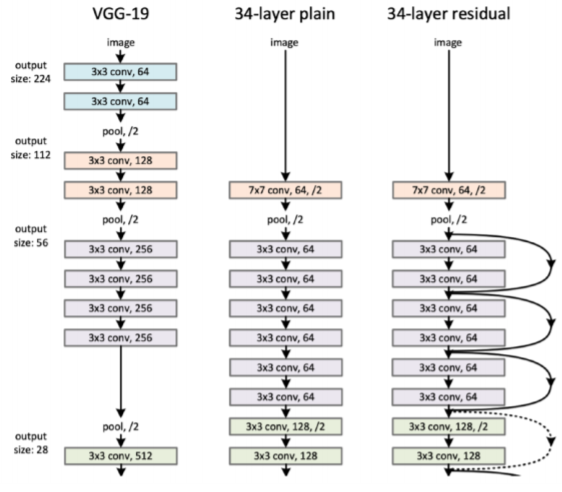

2015 - Residual Networks

- 깊게 Neural Network를 쌓을 수 있게 해준 모델

- 이전까지는 너무 깊으면 test에 잘 적용되지 않는 문제 있었음

- ResNet에 등장

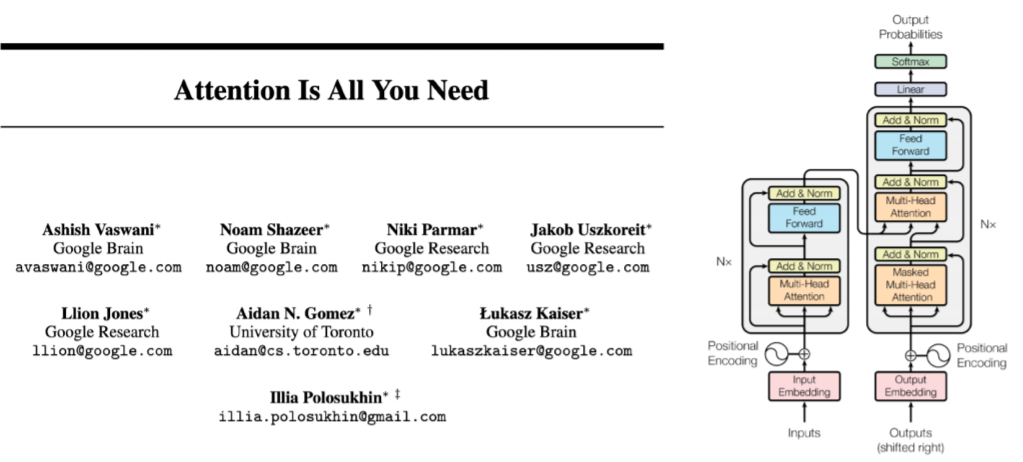

2017 - Transformer

- CNN, RNN 등의 대부분의 방법을 대체하면서 Vision(Vit)까지 적용되는 추세임

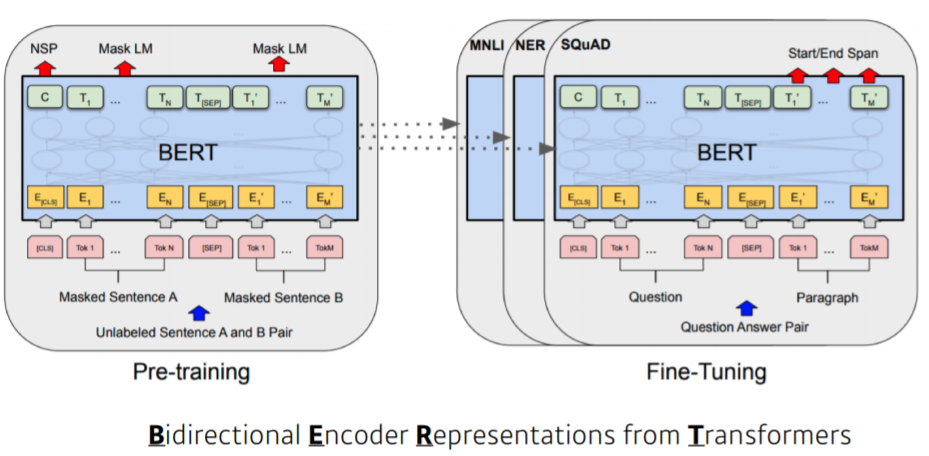

2018 - BERT

- fine-tuned NLP models

- 큰 Data, 일반적 문장으로 Pre-training -> 소수의 Data에 Fine-tuning

2019 - BIG Language Models

- OpenAI의 GPT-3 : 1750억개의 parameter을 가지고 있음

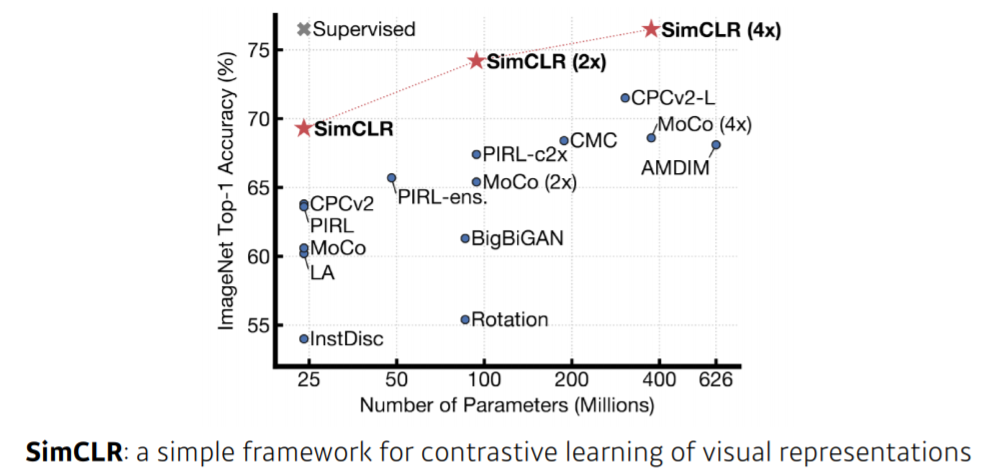

2020 - Self Supervised Learning

- 학습 Data + unsupervised data