(한양대학교 박서연 교수님의 딥러닝 수업을 청강 하면서 정리한 내용을 바탕으로 교수님의 허락을 받고 작성하였습니다.)

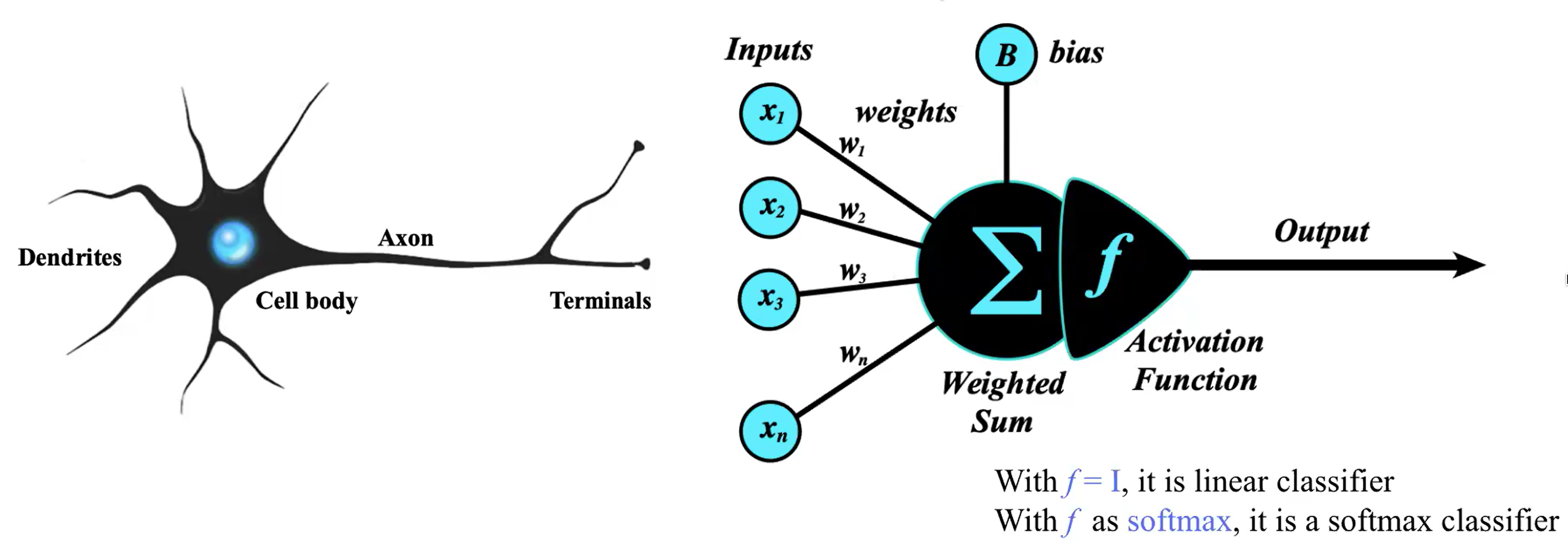

Perceptron

- Perceptron (The simplest Neural Network) : 가장 간단한 Neural Network

- Activation Function전에 사실상 output이 나옴

- input과 output의 dimension을 먼저 확정한 후, Weight Matrix를 정해야함 (일반적인 정의)

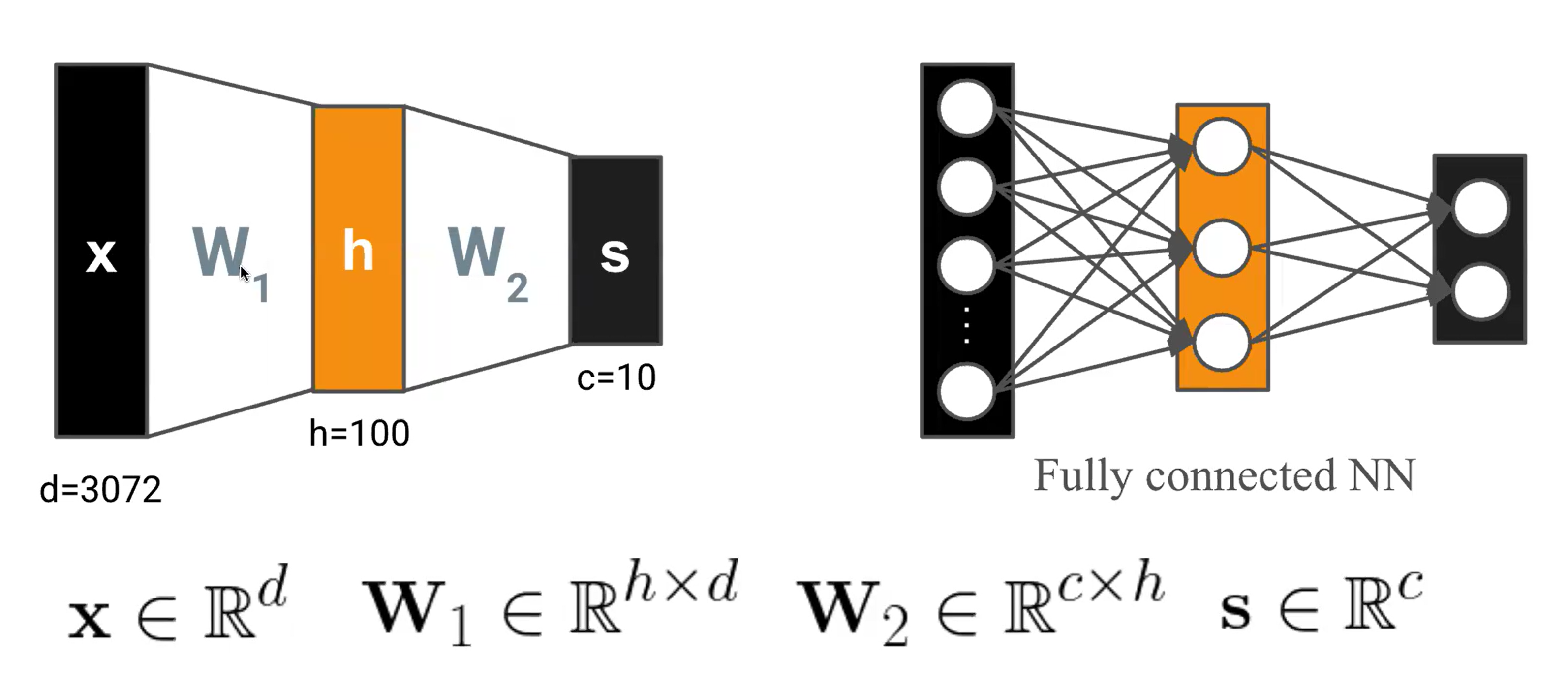

Multilayer Perceptron (MLP)

- layer의 개수는 여러개로 늘릴수있음

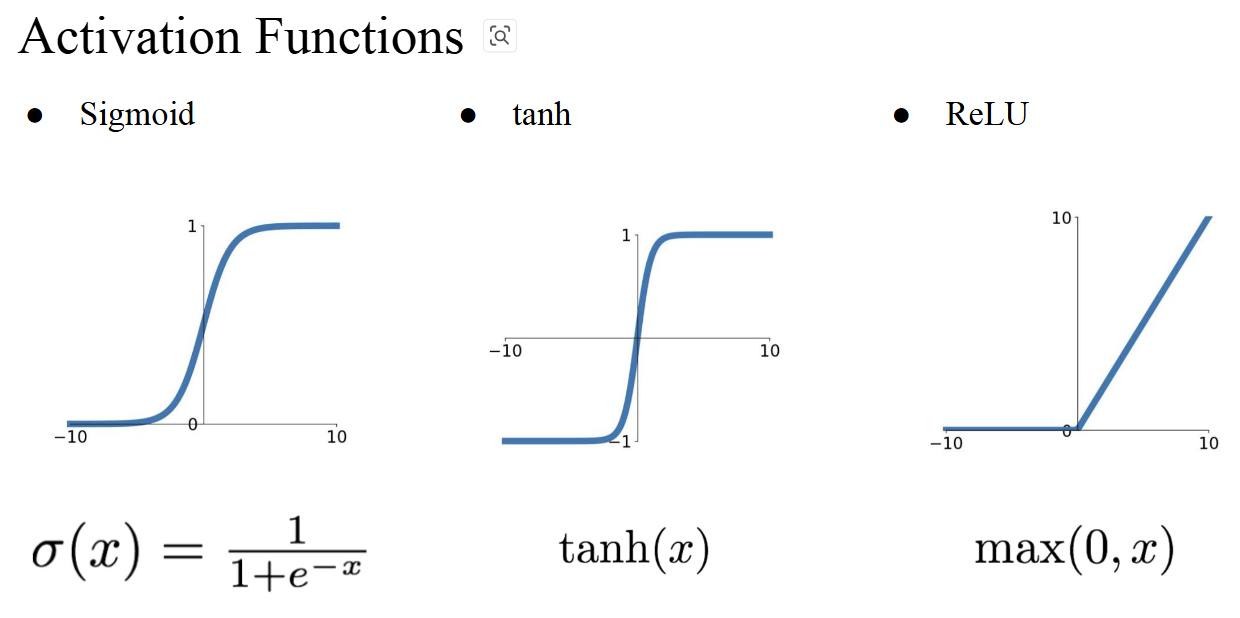

- how can we add non-linearity? > Add Activation functions!

- Sigmoid : 이진분류 (로지스틱 회귀)

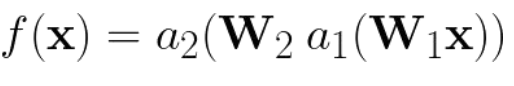

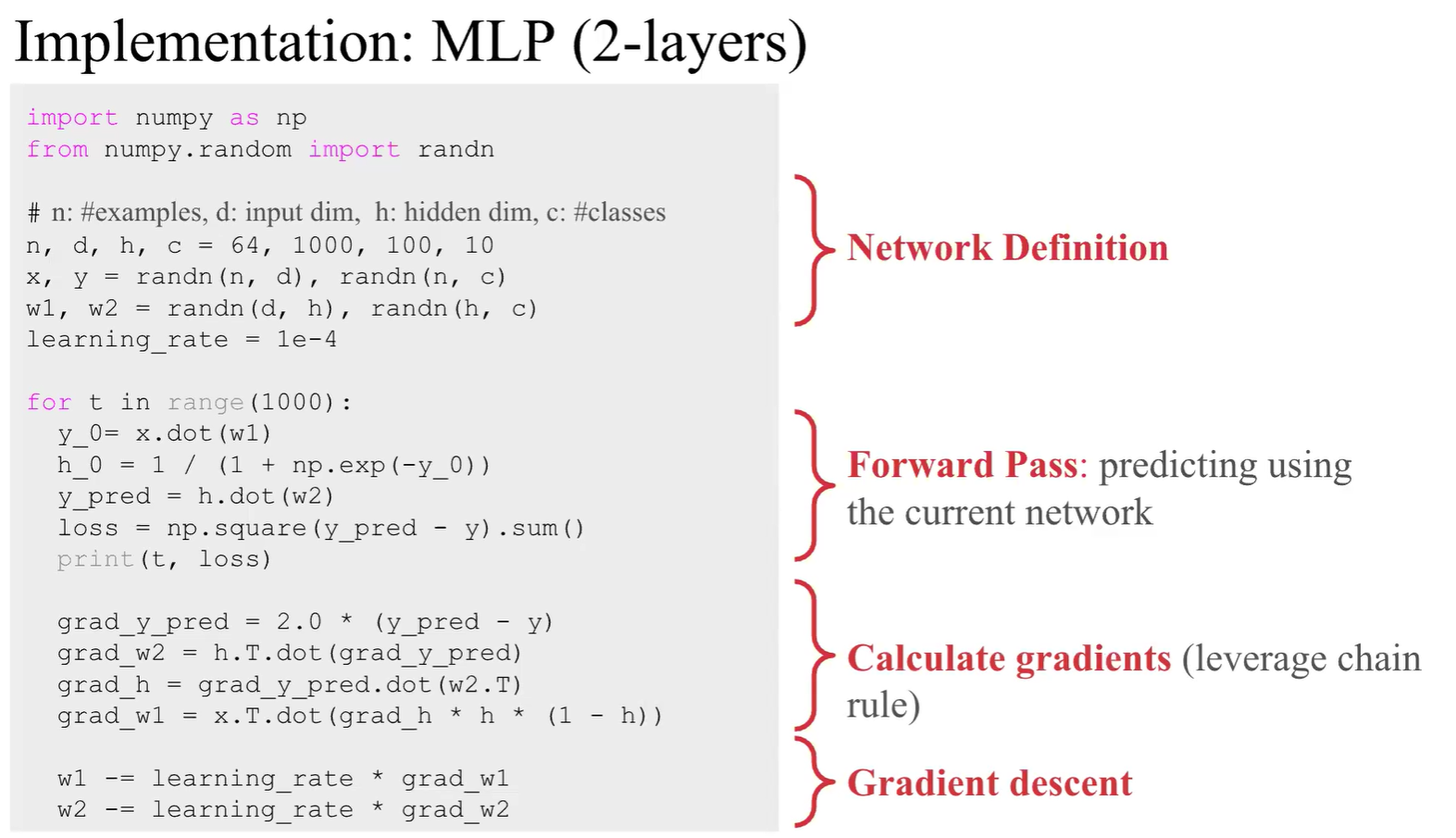

- Computing Gradients for MLP (2-layers) and Backpropagation

- 모델을 definition 할때, forward function에서 input이 들어왔을때 어떻게 처리할것인 가에 대해 definition함

- output를 가지고 Loss를 계산함 > 이후 계산된 Loss를 통해 Weight Matrix를 update하는 것이 Backpropagation 과정

- LLM은 쿼리 입력 후 output 얻는데, LLM이 outdated가 되어서 옛날 지식을 통해 trained 되다보니, 새로 검색해서 data를 가지고 사용자의 입력에 같이 넣으면 성능이 오른다 -> RAG의 정의

- 기존엔 새로운 data를 입력해도 내부의 Weight 기반으로 대답을 함 -> 즉, 이 context를 처리하는 뉴런을 알아내서 Weight를 증폭시키면 model의 performance가 올라감

- 참고자료

IRCAN: Mitigating Knowledge Conflicts in LLM Generation via...