Black-Box Tuning for Language-Model-as-a-Service

ICML 2022

분야 및 배경지식

- text prompt vs. continuous prompt

- 텍스트 프롬프트란, 사람이 이해할 수 있는 자연어로 작성된 프롬프트로 hard prompt라고도 함

- 연속 프롬프트란, 자연어가 아닌 숫자로 표현된 프롬프트로 soft prompt라고도 함

- 더욱 큰 차원의 정보를 담을 수 있어 일반적으로 텍스트 프롬프트보다 성능이 좋다고 알려짐

- Language-Model-as-a-Service (LMaaS)

- 거대한 사전학습 언어모델의 학습된 파라미터를 공개하지 않고, API 형태로 서비스만 제공하는 형태

- 해당 논문에서 처음으로 제안한 시나리오

- Derivative-free optimization (DFO)

- gradient를 활용할 수 없는 상황에서 사용할 수 있는 최적화 방식

- 일반적으로 샘플링-업데이트의 구조를 따름

- e.g. 진화 알고리즘(evolutionary algorithm), 베이지안 최적화(Bayesian opt.)

- intrinsic dimensionality

- 만족할만한 결과를 얻기 위해 필요한 최소 수의 파라미터

- 거대한 사전학습 모델은 일반적으로 굉장히 낮은 intrinsic dimensionality를 가진다고 알려져있는데, 이는 다시 말해 전체 파라미터 공간을 최적화하는 것만큼 효과적인 가장 낮은 차원의 reparameterization이 존재함을 의미

문제

- 거대한 사전학습 언어모델을 API로 사용할 수 있는 현재 상황에서, 손으로 작성한 텍스트 프롬프트(text prompt)는 많은 경우 좋은 성능을 내기 어려움

- 모델이 공개되어 있지 않는 상황에서 gradient를 기반으로 한 최적화는 사용할 수 없음

해결책

Black-Box Tuning (BBT)

- DFO를 활용한 연속 프롬프트 튜닝방식

- 일반적으로 사전학습 모델은 낮은 intrinsic dimensionality를 가지고 있기 때문에, DFO로도 충분히 최적화가 가능하다고 주장

- CMA-ES (Covariance Matrix Adaptation Evolution Strategy) 활용

- loss는 1) negative accuracy, 2) cross entropy, 3) hinge loss를 사용

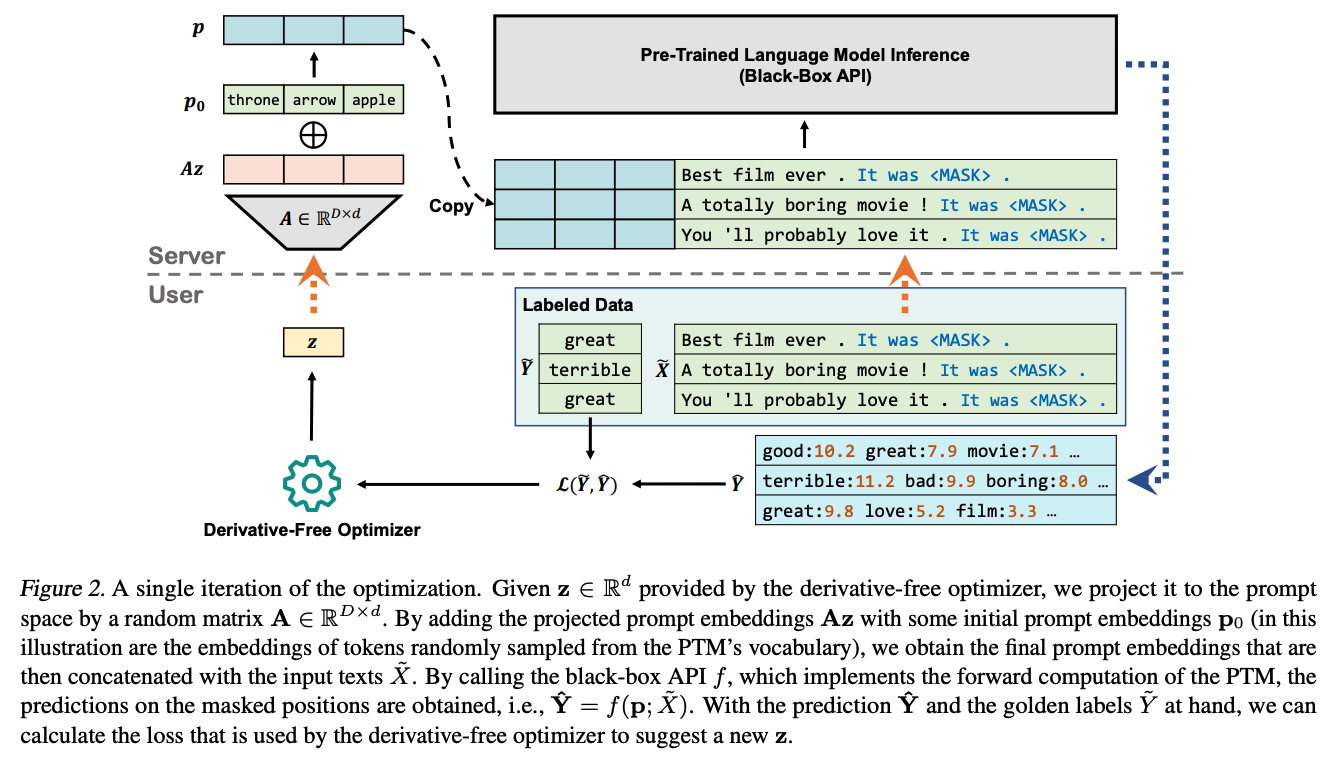

- DFO를 통해 얻은 z를 랜덤 행렬 A에 투영(project)시키고 초기의 프롬프트 임베딩 p_0를 더함; 이 값을 prompt로 활용

- p_0: NLI의 경우 MNLI로 초기화한 값, 다른 태스크의 경우 모델의 vocab에서 임의의 값

평가

- 데이터셋

- 감정분석

- 주제 분류

- 자연어추론 (NLI)

- 의역 (paraphrase)

- 모델

- RoBERTa-large

- gradient-based, gradient-free 방식들을 다양하게 비교하였을 때 가장 좋은 성능을 낸다고 주장

의의

- LMaaS라는 최근 등장한 새로운 시나리오를 바탕으로 효과적인 프롬프트를 구축하는 방법을 제시 (novelty)

한계

- p_0를 사전학습 모델의 단어사전을 이용해 초기화하거나, 사전학습된 프롬프트를 사용해 초기화한다는 점에서 진정한 LMaaS를 지원한다고 보기 어려움

- 최근 프롬프팅은 GPT와 같이 decoder-based model에서 각광받고 있는 실정이나, 실험의 경우 encoder 기반의 RoBERTa에만 한정해 실효성이 있을지 의문