Context-faithful Prompting for Large Language Models

arXiv 2023

분야 및 배경지식

- Parameteric knowledge

- 언어모델이 사전학습 과정에서 거대한 코퍼스를 통해 학습한 지식

- 언어모델이 파라미터에 내재화한 지식으로, internal knowledge라고 칭하기도 함

- 반대되는 개념으로는 retrieval 등을 통해 언어모델에 문맥(context)을 제공하는 external knowledge가 있음

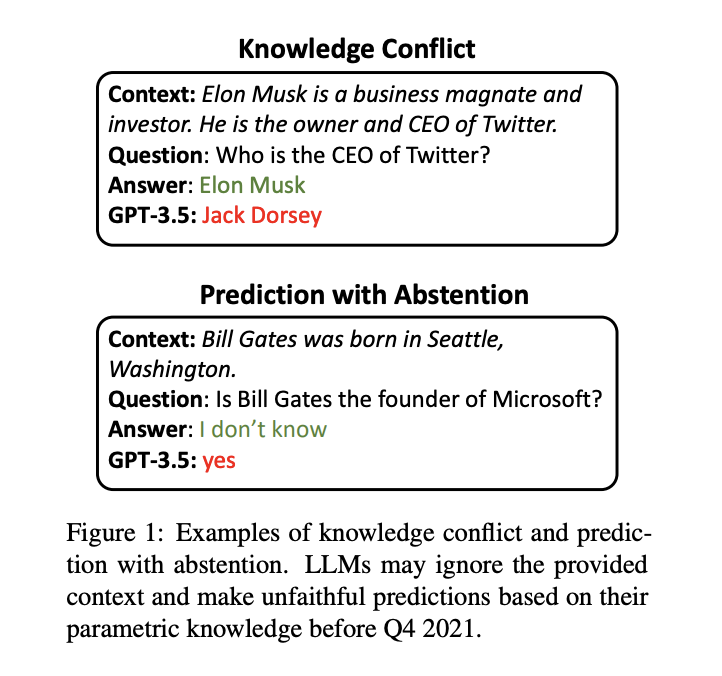

문제점

- 언어모델이 파라미터 내에 학습한 지식은 문맥으로부터 주어지는 힌트를 무시하게 만들어 모델이 잘못된 예측을 하게 만들기도 함

- 모델이 미리 학습한 지식은 시간이 지남에 따라 변할 수 있으며 (obsolete) 학습 과정에서 오개념을 학습했을 수도 있음 (misconception)

- 주어진 문맥이 주어진 태스크에서는 언어모델이 문맥에 기반해 예측해야 함

해결책

- 언어모델로 하여금 문맥에 대한 충실성(faithfulness)을 높일 수 있도록 하는 프롬프팅 방법 제시

- 지식 충돌(knowledge conflict), 즉 언어모델이 파라미터에 내재한 지식과 문맥으로 주어진 외부 지식이 다를 때 문맥에 기반한 예측을 하도록

- 예측 기권(predictino with abstention), 즉 언어모델이 주어진 문맥을 통해서 답을 예측할 수 없을 때 거짓을 응답하는 것이 아니라 모른다고 응답하도록

의견 기반 프롬프트 (opinion-based prompt)

- 문맥을 서술자의 문장으로, 질문을 서술자의 의견을 묻는 문장으로 형태 변경

- 이러한 형태 변경을 통해 문맥에 더욱 집중할 수 있도록 (인간의 사고과정을 모사)

- e.g. 기본 프롬프트 - {문맥} Q: {질문}? Options: {선택지} A:

- e.g. 의견 기반 프롬프트 - 밥이 말했다: "{문맥}" Q: 밥의 의견에서 {질문}은? Options: {선택지} A:

- e.g. 설명 기반 프롬프트 - Instruction: {설명} {문맥} Q: {질문}? Options: {선택지} A:

반사실적 예시 (counterfactual demonstration)

- 반사실적(counterfactual) 예시란, 문맥 속 사실 정보가 가짜 정보로 대체된 예시들을 의미

- 테스트 예시와 반사실적 예시들 중 cosine similarity가 높은 예시들을 선정해서 사용

평가

- 태스크

- 기계 독해 (machine reading comprehension)

- natural questions, RealTime QA

- 관계 추출 (relation extraction)

- Re-TACRED

- 기계 독해 (machine reading comprehension)

- 모델

- InstructGPT

- 평가기준

- Exact Match, Accuracy/Brier score (MRC)

- F1 (RE)

- 의견 기반 프롬프트와 설명 기반 프롬프트를 합친 경우 가장 효과적

- 그 다음으로는 의견 기반 프롬프트만 사용되었을 때 가장 효과적

- few-shot일 경우 (=예시가 존재할 경우) 반사실적 예시가 있을 때 더욱 효과적

- 원래의 예시가 사용되었을 때 항상 성능이 높아지진 않았음. 즉, 예시들이 언제나 LLM 추론 성능의 일반화를 개선시켜주는 것은 아님

한계

- 확인한 모델이 한정적

- GPT-4 혹은 다른 오픈소스 LLM을 함께 확인해봤으면 좋았을 듯

- 해결 방법이 다소 heuristic

의의

- 언어모델의 knowledge conflict, prediction with abstention이라는 중요한 문제를 프롬프팅을 통해 비용효율적으로 해결하고자 함