Editing Factual Knowledge in Language Models

EMNLP 2021

분야 및 배경지식

- Language Model, Factual Knowledge

- 대량의 데이터셋으로 학습한 Language Model은 세상에 대한 많은 factual knowledge를 가지고 있고, 이러한 지식이 downstream task에 유용함이 밝혀짐

- 하지만 factual knowledge는 끊임없이 변화하기 때문에 이를 어떻게 수정할 수 있는가에 대한 연구가 지속

- ... pre-trained language models recall factual knowledge without fine-tuning, which they do by feeding specific prompts to LMs. ... large models can be fine-tuned to access their internal memories to answer questions in natural language without any additional context and with surprisingly high accuracy (closed-book question answering)

문제

- Language Model이 갖고 있는 Factual Knowledge는 시간이 지남에 따라 obsolete되거나 부정확하게 유도될 수 있음

- LM의 지식을 수정하는 것은 challenging

해결책

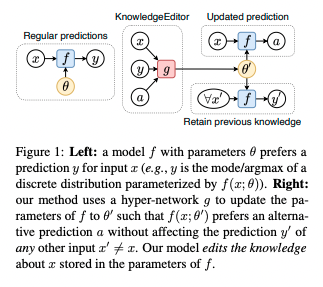

KnowledgeEditor

- hypernetwork

- a model that predict the new parameters conditioned on an atomic fact to be modified

- LM에서 업데이트 되어야 할 a subset of parameters를 모델이 학습을 통해 알아서 선택하고 update하도록 learn

- constrained optimization

- KL divergence 이용해 수정이 필요하지 않은 부분에 있어서는 original one과 predicted output distribution이 동일하도록

- Lp norm의 경우 parameter space만 고려하고 function space는 미고려, 한계 있다고 주장

의의

- Generality

- 지식을 수정하기 위해 LM을 특별하게 pretrain할 필요 없음

- Reliability

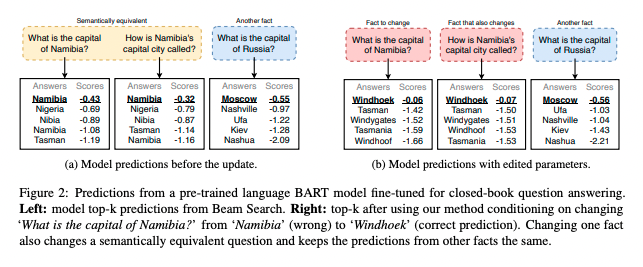

- 다른 acquired knowledge에 대한 영향을 최소화하면서 원하는 특정 사실만 update 가능

- Consistency

- 동일한 사실을 다르게 표현한 문장들에 대해서도 일관된 성능을 보임

- consistent across equivalent formations of a fact

- The best subset of parameters to update is the first layer

- knowledge manipulation seems to be achieved by primarily modifying parameters affecting the shape of the attention distribution, rather than values

한계

- ethical consideration (윤리적 고려사항)

- milicious use of knowledge editor is possible

- 한 번에 하나의 지식만 수정이 가능하며, 새로운 지식 수정을 위해서는 기존 모델로 돌아가야 함(원복)

- 여러 개의 모델을 한꺼번에, 혹은 연속적으로 수정하는 실용적인 경우는 미고려