P-Tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks

parameter-efficient-finetuning

목록 보기

5/7

P-Tuning v2: Prompt Tuning Can Be Comparable to Fine-tuning Universally Across Scales and Tasks

ACL 2022

분야 및 배경지식

- 프롬프트

- 언어모델로 하여금 별도의 파인튜닝 없이도 주어진 태스크를 수행할 수 있게 하는 일종의 템플릿

- 최근에는 일반적으로 설명(instruction), 예시(demonstrations), 템플릿(e.g. The answer is) 등을 모두 포함하여 지칭

- 위에서 설명한 discrete prompt와는 다르게, 학습 가능한 벡터로 이루어진 continuous prompt 또한 존재

- 프롬프트 튜닝

- 언어모델의 파라미터는 사전학습된 상태로 고정

- 연속적인(=continuous) 프롬프트만 학습

- NLU (자연어이해) 태스크

- 단순한 분류 태스크

- 주어진 레이블에 대해 분류하는 태스크

- e.g. GLUE, SuperGLUE, ...

- 어려운 시퀀스 레이블링 태스크

- 일련의 토큰에 대해 분류하는 태스크

- e.g. extractive question answering, named entity recognition

- 단순한 분류 태스크

문제점

- 프롬프트 튜닝은 일반적인 크기의 사전학습 모델에서는 잘 작동되지 않음

- 태스크 보편성이 떨어짐

hard sequence labeling task에서는 잘 작동하지 않음

해결책

P-tuning v2

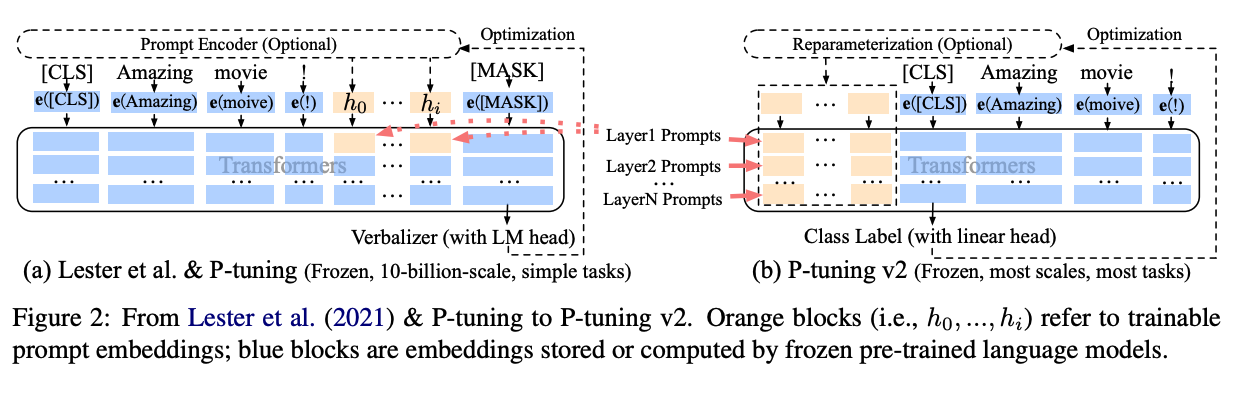

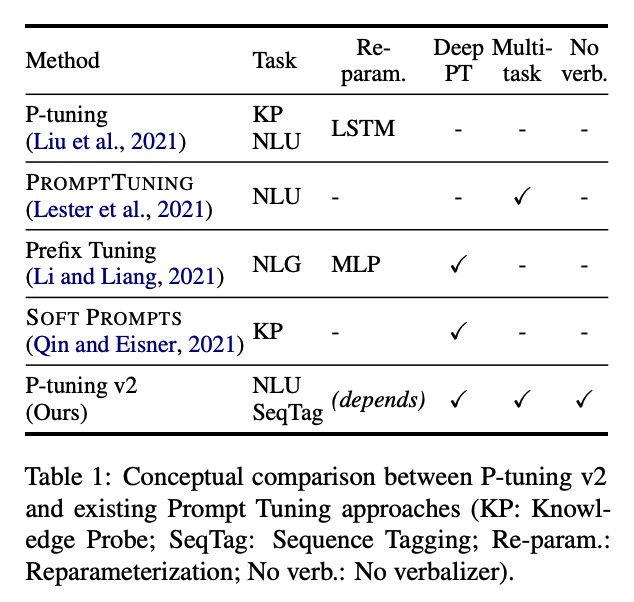

- Deep prompt tuning

- 단순히 인풋 레이어에만 연속적인 프롬프트를 더하는 것이 아니라, 사전학습 모델의 모든 층에 연속적인 프롬프트를 적용

- 튜닝 가능한 파라미터의 수가 증가해 더 풍부한 표현력을 가질 수 있음

- 인풋 임베딩은 모델의 예측에 상대적으로 간접적인 영향만 미칠 수 있었는데, 이러한 제한을 해결함

- Reparameterization

- 일반적으로 재파라미터화를 위한 인코더를 사용하나, 이의 유용성은 태스크와 데이터셋마다 다름

- 프롬프트 길이

- 단순한 분류 태스크는 짧은 프롬프트(20 이하)가 좋음

- 어려운 시퀀스 레이블링 태스크는 긴 프롬프트(약 100)가 좋음

- 멀티태스크 학습

- 멀티태스크 학습을 통해 좋은 초기화(initialization)를 만들어주는 것이 성능 향상에 유리

- classification head

- 일반적으로 Language modeling head를 사용하나, 해당 연구에서는 랜덤하게 초기화된 classification head를 사용

평가

- 데이터셋

- SuperGLUE

- named entity recognition

- extractive question answering

- semantic role labeling

- 모델

- BERT-large

- RoBERTa-large

- DeBERTa-xlarge

- GLM-xlarge/xxlarge

한계

- 핵심적인 방법론인 Deep prompt tuning이 Prefix-tuning에서 이미 제안한 방법과 유사

- multitask-learning, classification head 등 차별화를 두고자 하였으나 이를 통해 novelty를 주장하기는 어려움

- 인코더 기반의 모델 위주로 테스트

- 디코더 기반의 모델 중 GPT 계열 모델들에 대한 성능 향상 효과가 궁금

의의

- 300M ~ 10B에 이르는 다양한 파라미터 크기의 모델에서 좋은 성능을 보임

- 어려운 시퀀스 태깅 태스크에서도 좋은 성능을 보임