GPT Understands, Too

arXiv 2021

분야 및 배경지식

- NLU, NLG

- NLU(Natural Language Understanding)이란 자연어 이해 태스크를 의미

- 전통적으로 BERT 계열의 bidirectional model이 잘하는 태스크

- NLG(Natural Language Generation)이란 자연어 생성 태스크를 의미

- 전통적으로 GPT 계열의 unidirectional model이 잘하는 태스크

- NLU(Natural Language Understanding)이란 자연어 이해 태스크를 의미

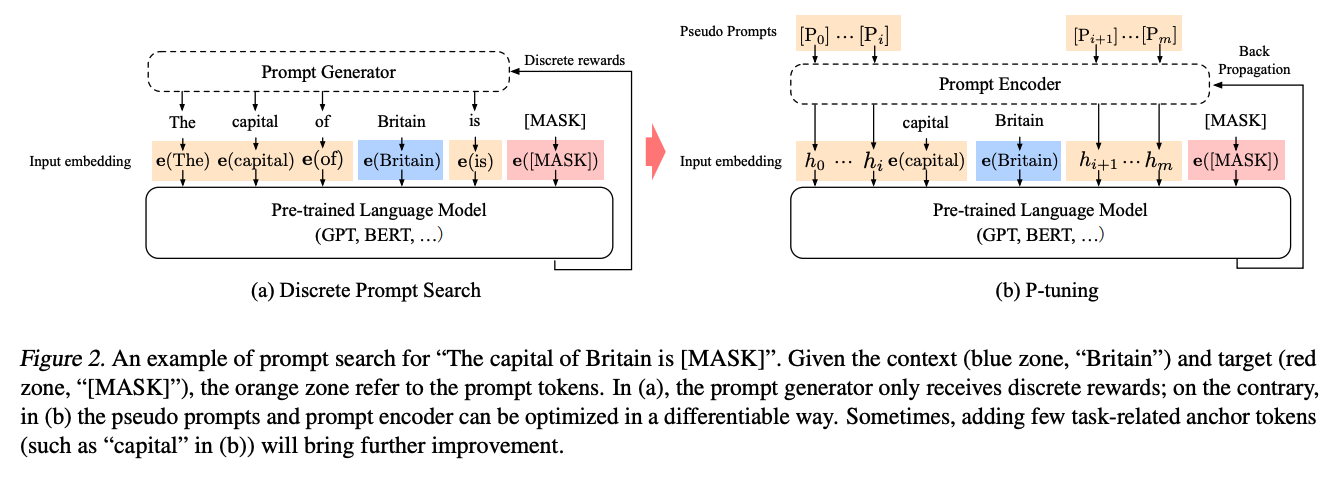

- prompt 종류

- continuous, soft prompt

- 임베딩, 벡터 형태로 이루어진 학습 가능한 프롬프트

- discrete, hard prompt

- 자연어로 이루어진 프롬프트

- continuous, soft prompt

문제점

- GPT 계열 모델은 BERT에 비해 자연어 이해 태스크에서 낮은 성능을 보임

- 좋은 성능을 내는 프롬프트를 직접 만들어내는 것은 하늘의 별따기

- 손으로 작성한 프롬프트는 작은 변화에도 민감 (성능 차이가 심함)

해결책

P-tuning

- 학습 가능한 연속적인 프롬프트 임베딩(텐서)

- 일련의 인풋 토큰들을 인풋 임베딩으로 매핑하여 사용

- 미분 가능한 연속적인 공간에서의 프롬프트를 탐색함으로써 자동으로 최적화 가능

- prompt encoder

- 프롬프트 임베딩을 최적화할 때 발생할 수 있는 두 가지 문제

- discreteness: 기존의 임베딩이 사전학습 이후 이미 discrete해져 local minima로 빠질 수 있음

- association: 프롬프트 임베딩의 값이 상호 독립적이기보다 의존적이어야 함

- 이를 해결하기 위해 prompt encoder(LSTM)를 도입

- 프롬프트 임베딩을 최적화할 때 발생할 수 있는 두 가지 문제

평가

- 데이터셋

- LAMA (지식 조사; Knowledge Probing)

- SuperGLUE (NLU)

- 데이터가 많지 않은 Low-resource setting일 때 유리

- 파인튜닝은 catastrophic forgetting (이전에 학습한 지식을 까먹음) 문제가 발생할 수 있음

- P-tuning은 사전학습 파라미터는 변경하지 않고 (freeze) 연속적인 프롬프트만을 학습하고 사용, 모델이 학습한 지식을 더욱 잘 불러올 수 있음

한계

- 비교적 단순한 methodology

의의

- GPT 계열의 모델이 NLU 태스크에서 BERT와 유사하거나 더 좋은 성능을 낼 수 있게 함

- BERT 계열의 모델에서도 일부 성능 향상을 이끌어냄