TemporalWiki: A Lifelong Benchmark for Training and Evaluating Ever-Evolving Language Models

1

knowledge-edit

목록 보기

6/15

TemporalWiki: A Lifelong Benchmark for Training and Evaluating Ever-Evolving Language Models

EMNLP 2022

분야 및 배경지식

- Temporal misalignment

- 언어모델(LM)이 학습 과정에서 보지 못했던, 혹은 학습 과정에서 배웠던 정보와 다른 최신의 factual knoweldge를 필요로 하는 태스크에 대해 낮은 성능을 보이는 현상

- 이의 원인으로는 언어의 역동적인 특성(dynamic nature of language)과 사실적 정보의 갱신(update of factual knowledge)이 꼽힘

문제

- 사실적 지식(factual knowledge)은 자주 변경, 추가, 삭제되어 temporal misalignment와 같은 현상이 발생하나, 이에 대한 LM의 적응성을 판단하는 일관된 데이터셋이 부재 (기존 데이터셋은 정적(static))

해결책

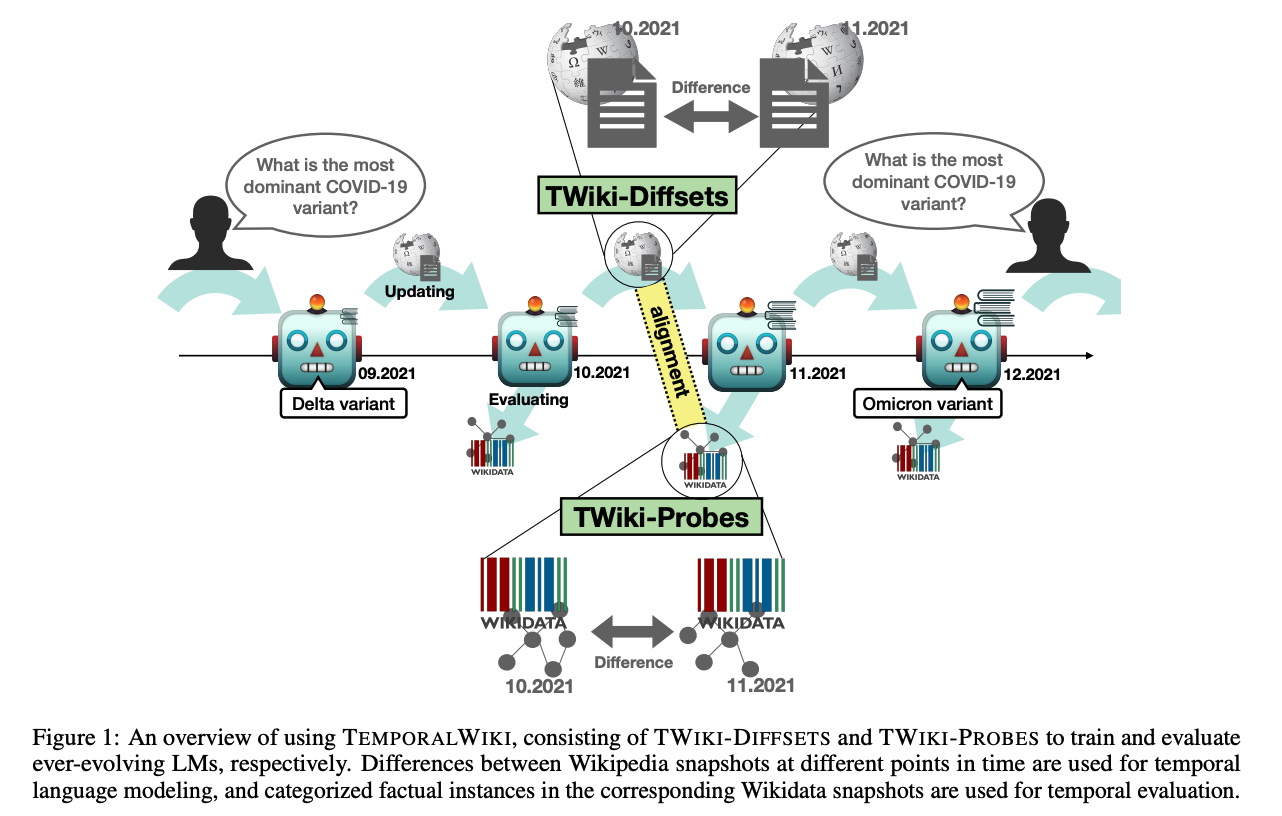

TemporalWiki

- 계속 진화하는(ever-evolving) LM을 평가할 수 있는 lifelong benchmark

- LM이 시간에 따라 이전의 지식을 잘 유지하고 새로운, 갱신된 지식을 잘 취득하는지를 판단할 수 있는 기준을 제공

- TWIKI-DIFFSETS

- 연속적인 영어 위키피디아의 스냅샷을 이용해 오직 바뀐 정보만을 취득, training에 활용

- TWIKI-PROBES

- 위키데이터 스냅샷과 위키피디아 스냅샷을 비교해 바뀐 정보와 바뀌지 않은 정보를 분류, evaluation에 활용

- 데이터 수집 후 TWIKI-DIFFSETS와의 정렬(alignment), 발견적 필터링(heuristic filtering)을 통해 품질을 통제

의의

- automated, lifelong

- 달마다 생기는 위키피디아, 위키데이터 스냅샷을 이용해 연속해서 자동으로 새로운 데이터셋을 생성

- continually training only on the updated portion

- 위키피디아 전체 데이터셋이 아니라 단지 바뀐 부분에 대해서만 학습하는 것이 계산 효율성과 stability(unchanged)-plasticity(changed; updated or new) trade-off에 있어 유리

- continual learning

- 연속학습 방법들을 사용했을 때 forgetting을 경감시킬 수 있었으며, stability와 plastibility 개선에 도움을 준다는 사실을 실험을 통해 밝힘

한계

- 위키피디아, 위키데이터를 사용해 general world knowledge를 활용하고자 하였으나 해당 데이터가 실제 세상의 변화를 제대로 반영하였는지 여부를 항상 보장할 수는 없음

- 지식의 삭제(knowledge deletion)에 대해서는 미고려

- Continual Learning의 memory-based, regularization-based, architecture-based 방법을 탐구하였으나 특정 모델/방법의 선택에 대한 충분한 설명이 미비

- GPT를 이용해 실험을 진행

- memory-based(=rehearsal)에서는 Mix-review를 사용하였는데, GPT 기반에서 SOTA인 LAMOL을 사용하지 않고 해당 모델을 선택한 이유가 궁금

- architecture-based(=parameter-expansion)에서는 K-Adapter를 선택했는데, 해당 연구는 성능이 그리 뛰어나지 않았고 BERT 기반에서 구축된 모델임에도 GPT 기반 실험에서 해당 모델을 선택한 연유가 충분히 설명되지 않았음