Perceiver IO: A General Architecture for Structured Inputs & Outputs

최근 DeepMind에서 소개된 모델인 Perceiver는 여러 도메인에서 좋은 성능을 얻었다. 그와 동시에 컴퓨팅과 메모리 부분에서는 input size에 따라 선형적으로 확장할 수 있다.

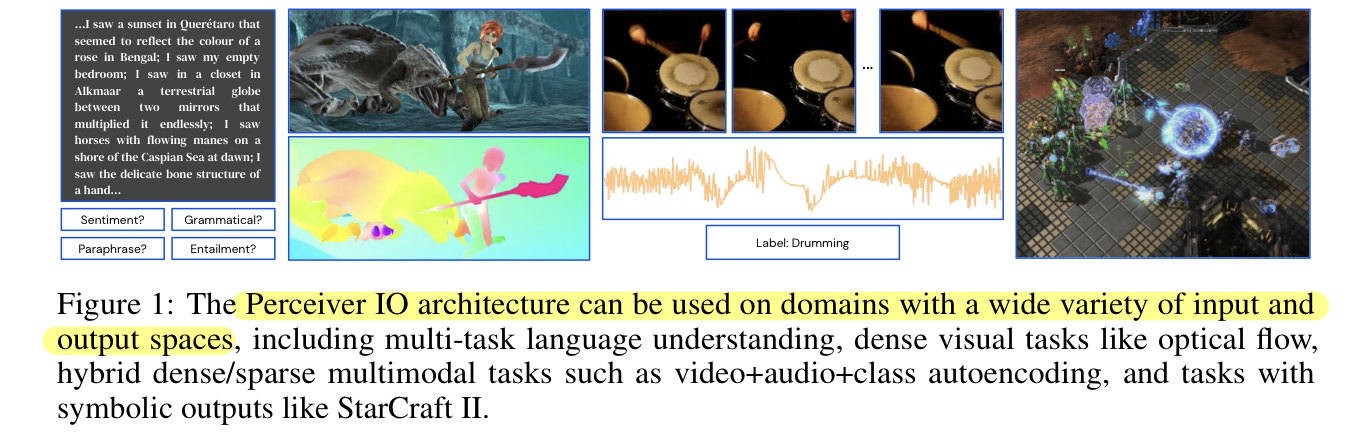

Perceiver는 다양한 종류의 input들을 지원하며, 쉽게 output을 얻을 수 있다. 이러한 Perceiver IO는 기존의 트랜스포머 모델이 보여주는 장점들의 희생 없이 기존에 가지고 있던 제한 사항들을 극복했다. 제한사항들은 다양한 쿼리에 대해 학습하는 방법을 통해 극복하였으며, 임의의 크기를 가진 output을 얻기 위해 모델들의 latent space을 query로 유연하게 학습했다.

PerceiverIO는 여전히 데이터 사이즈에 따른 모델의 깊이를 분리하며, 데이터 사이즈에 따라 선형적으로 확장하지만 input과 output size 모두에 대해 확장할 수 있다.

완전한 PerceiverIO의 모델을 NLP, Visual understranding, StarCraft, Multi-task, Multi-modal들에서 좋은 성능을 얻었다. 주목할만한것을 PerceiverIO가 input tokenization없이 GLUE 벤치마크에서 BERT와 같은 성능을 보였다. 그리고 Sintel optical flow estimation에서 SOTA를 달성했다.

Introduction

사람이나 동물들은 목적에 맞게 다양한 입력들을 매끄럽게 처리한다. 하지만 현재의 딥러닝 모델들은 특정한 입력과 특정한 태스크들에서만 동작며, input이나 output의 종류가 증가하면 그 복잡도는 급격하게 증가한다.