1. Task

- 발생한 사고 정보(ID,발생일시, 사고 인지 시간, 날씨, 기온, 습도, 공사종류, 연면적, 층 정보, 인적사고, 물적사고, 공종, 사고객체, 작업프로세스, 장소, 부위 총 15가지의 정보)를 통해 재발방지대책 및 향후조치계획을 텍스트로 생성

2. 데이터 정보

- Train data: 23422건

- Test data: 964건

3. 답변 정보

가. 정답 예시

- 자재 정리 시 주변 통제를 철저히 하고 재발 방지 교육을 실시하는 방안

- 동 주변 근로자 이동구간 지반정리 및 TBM 시 사고사례 전파와 근로자 이동통로 정비.

- 작업방법 및 순서에 관한 교육 실시.

나. 정답 포맷

- 정답은 개조식으로 작성되었으며, 문장의 길이도 짫은 편

- 평가의 용이성 때문일까? 문장에서 접속사, 조사, 부사 등의 사용이 거의 없음

4. 간략한 데이터 탐색

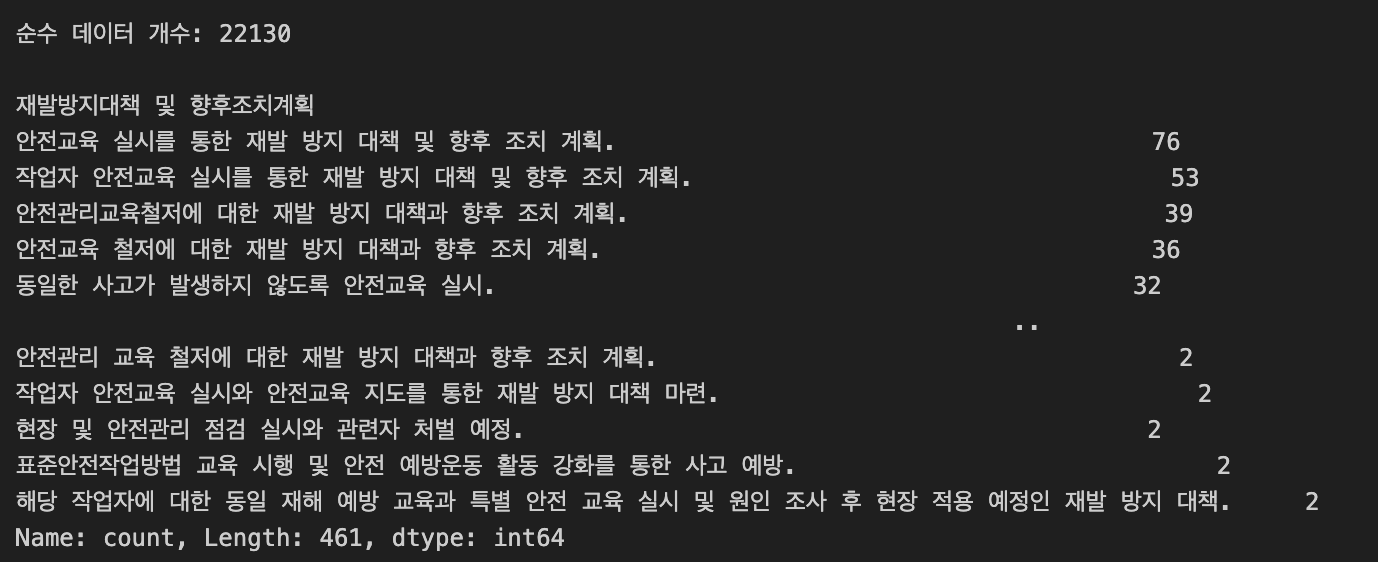

Q: 데이터를 눈대중으로 쭉 훑어보다가 답변이 같은 행을 몇 개 발견, 중복으로 정답이 사용되는 경우를 한번 확인해보자

A: 중복으로 사용된 답변이 461개나 있었지만, 중복을 제외한 나머지 데이터는 22130개로 중복 정답을 고려할 이유는 없어보인다

5. Base model

- LLM 사용 X

- 쿼리문과 유사한 질문 검색해서 해당 질문에 대한 정답을 그대로 선택

- ko-sbert-nli

- top-1

6. 리더보드

- 데이콘에서 제공한 베이스라인 : 0.30582

- 내가 처음 만든 베이스라인 : 0.42483

- 현재 1등 : 0.5

6. 회고

top-1로 설정했음에도 유사도가 상당히 높게 나왔다.

임베딩으로 문서를 쿼리하는 경우 일반적으로 1로 설정하면 검색 정확도가 낮다는 것을 감안하자.

훈련 데이터에 있는 정답을 그대로 가져다 쓰는 방식은 유지.

검색 문서를 3또는 5로 조정

gpt-4o-mini를 통해 여러 문서 중 하나를 선택해서 정답으로 뽑게 하기

lexical search model 적용해서 fusion rank로 문서 뽑기

일단, train에 있는 정답을 최대한 정확하게 뽑는 것를 최우선 목표로 두고,

성능 향상이 정체되면 제공된 문서를 통한 데이터 추가 생성이 차후 목표가 될듯