Review

Orthogonality of vector

깊이 고민해볼 것은 vector subspace가 서로 수직이라는 것이다.

Orthogoanlity of Subspaces

for any XV, and for any y W in

V, W라는 vector space가 n차원 공간의 벡터라고 할 때, 그 공간에 속하는 어떤 벡터 X, Y를 선택해도 그 둘은 서로 수직한다. 즉 수직한 벡터공간 각각에 들어있는 모든 벡터를 내적하면 서로 수직이다.

Basis (vectors) to span the Vector Space

basis vector는 임의의 X,Y를 구현할 수 있는 기본 벡터이다. 그러면 다음과 같이 linear combination으로 표현할 수 있다.

subspace가 서로 수직인 것을 말하고자 하면, 모든 벡터가 수직인 것을 확인해야 한다. 각 basis vector는 V.S에 대해서 unique하지 않지만, basis vector를 각 V.S에서 찾을 수는 있다.(linearly independent한 해당되는 개수만큼 찾을 수 있다.)

for any basis vector and for any

이때 는 내적하면 0이 되므로

정리하면 V.S가 서로 수직이다하면 linearly independent한 basis vector를 구해서 서로 수직임을 보여주면, V.S는 서로 수직이 된다. 왜냐하면 X, y같은 임의의 vector는 basis vector의 linear combination으로 만들어지기 때문에 각 basis vector가 서로 수직이면 V.S 또한 서로 수직이 된다.

꼭 기억해야 할 점은

Orthogonal vectors Linearly independent vectors basis vectors

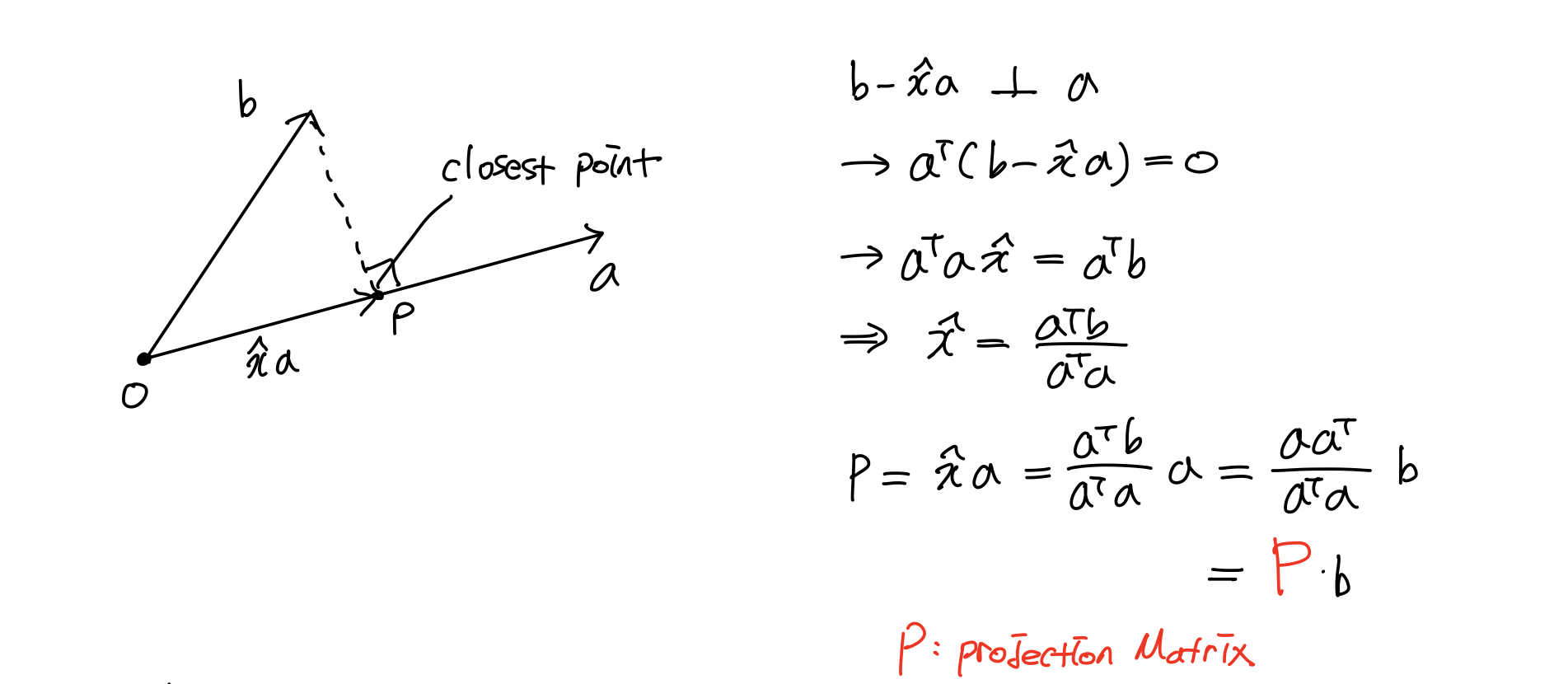

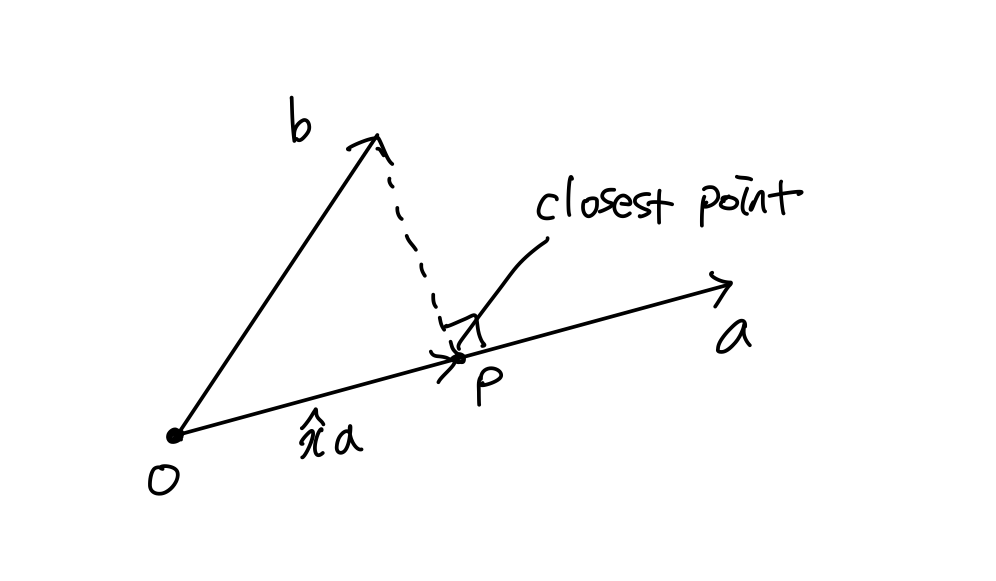

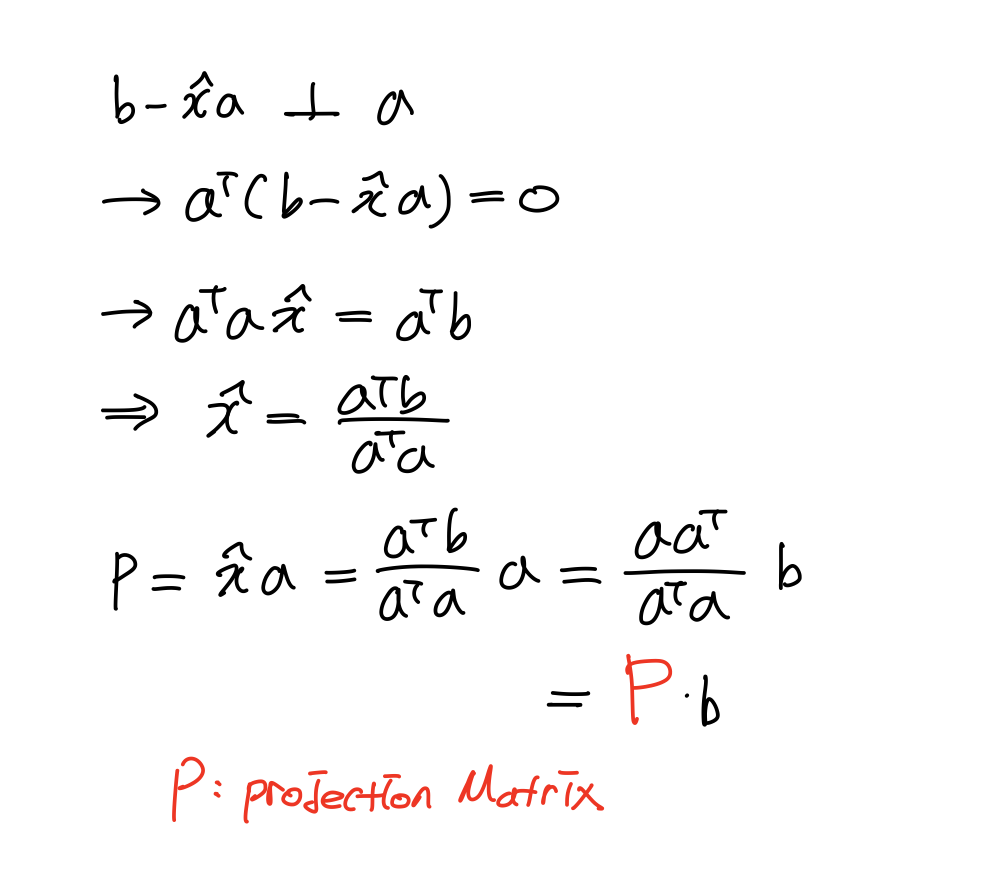

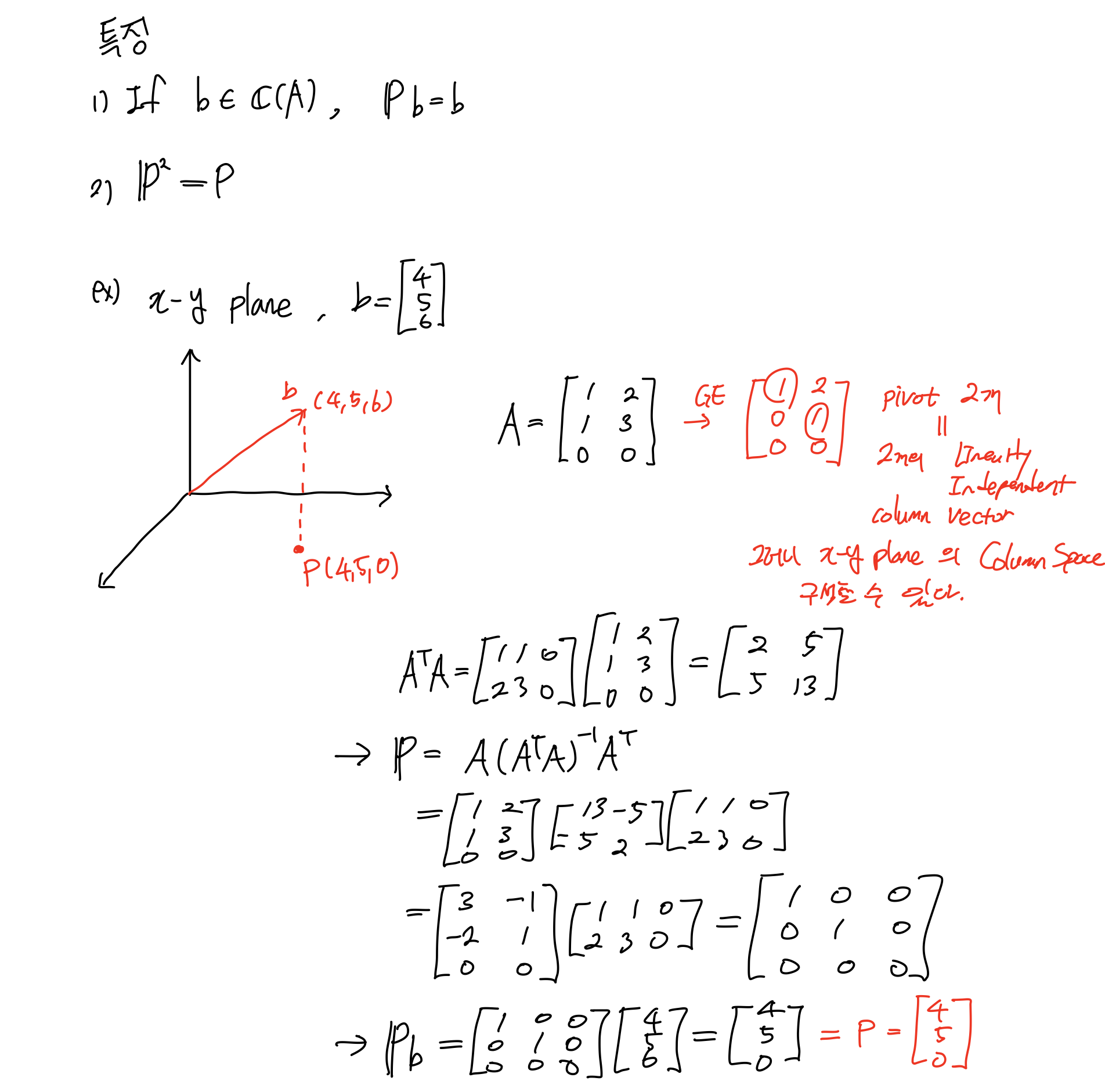

Projection onto line

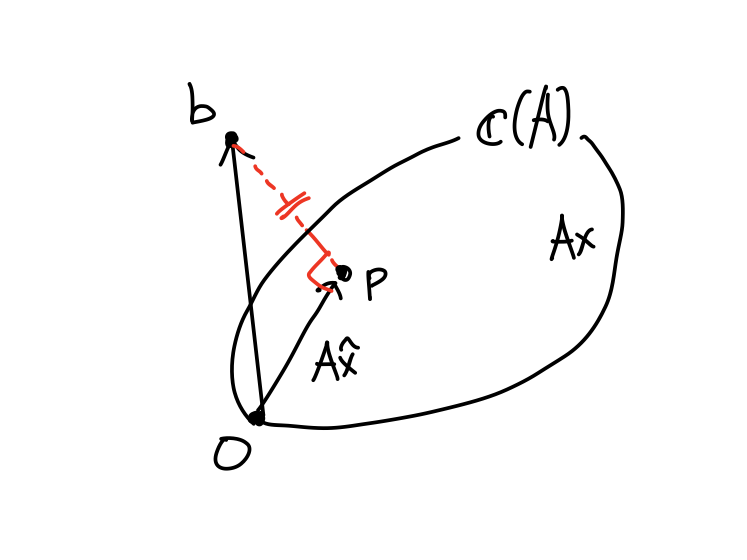

projection은 기하학적으로 직선a상의 좌표 중에서 b와 가장 가까운 한점 p를 구하는 것이다. 이를 확장하면 3차원 공간상에 존재하는 평면과 평면 밖의 한점과 가장 가까운 점을 구할 수 있다. 이것이 Projection이다.

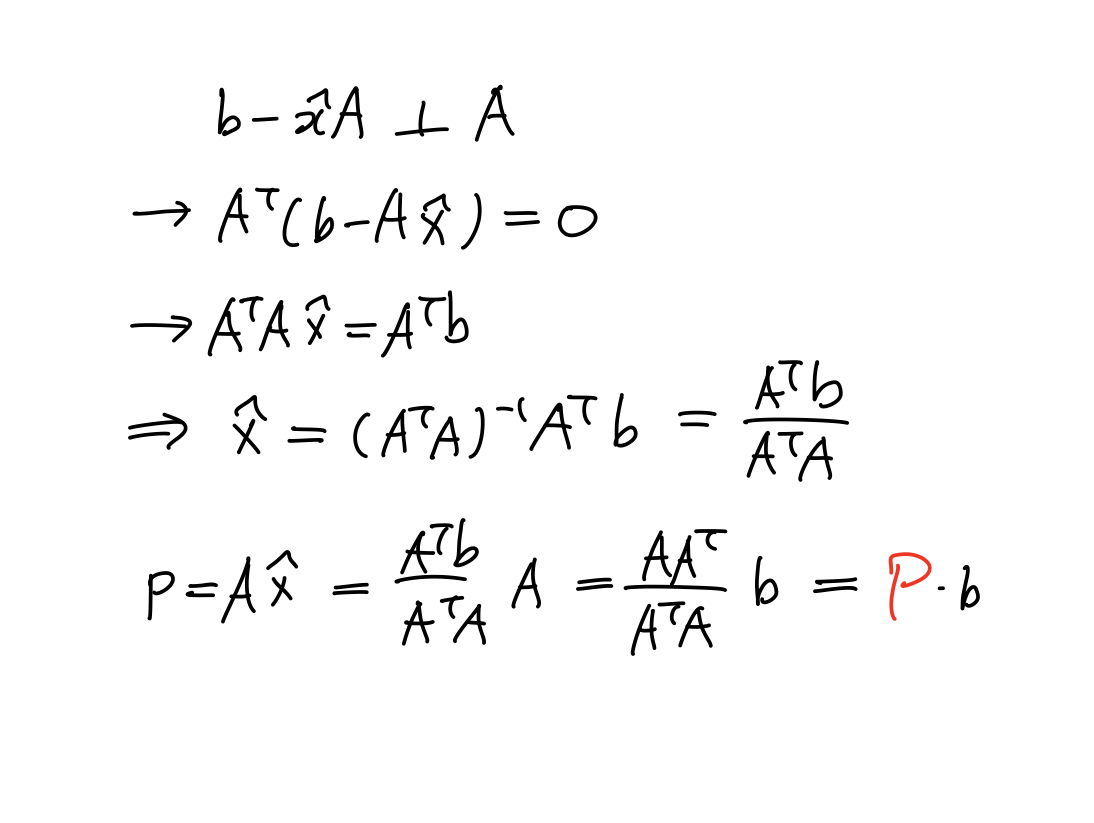

직교의 특성을 이용하면,

과 Projection matrix P를 구할 수 있다.

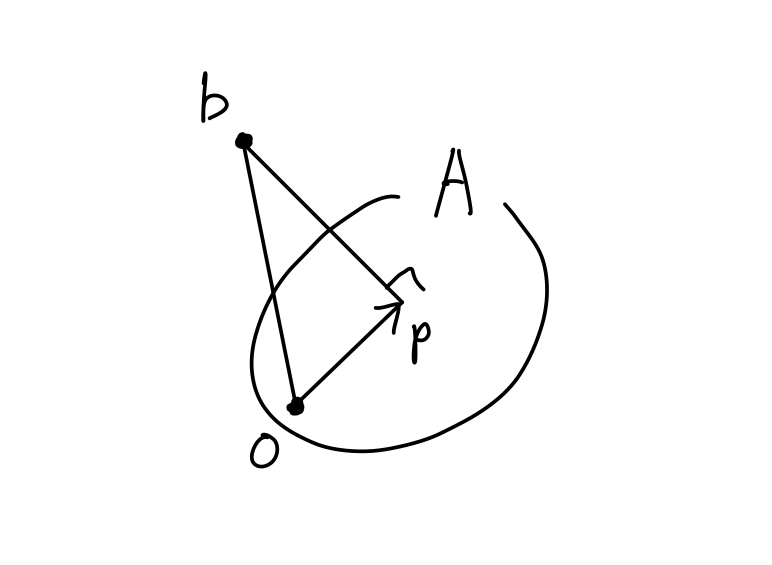

이 개념을 더 확장해보자. 직선이 아닌 V.S를 생각해보자.

linearly independent한 vector(basis vector)가 있고, 이는 행렬A로 표현이 된다. 행렬A로 쓰면 column vector에 의해서 만들어지는 vector, 즉 column space가 V.S이다.

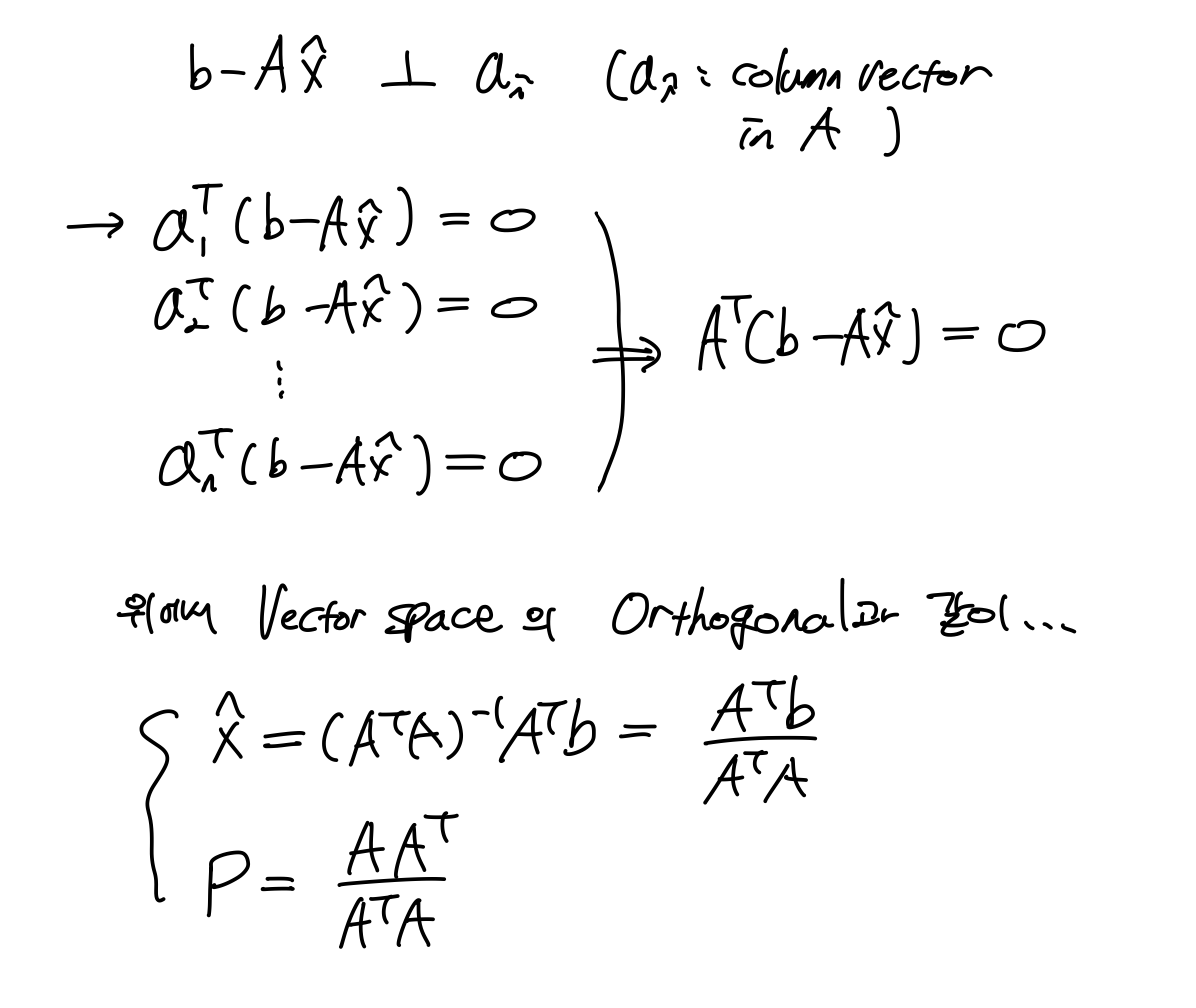

V.S A에 들어있지 않은 vector b가 있다고 하자. b를 A에 projection하자. 직선에 점을 projection한것과 같이. 그럼 다음과 같이 정리할 수 있다.

3.3 Projection and Least Squares

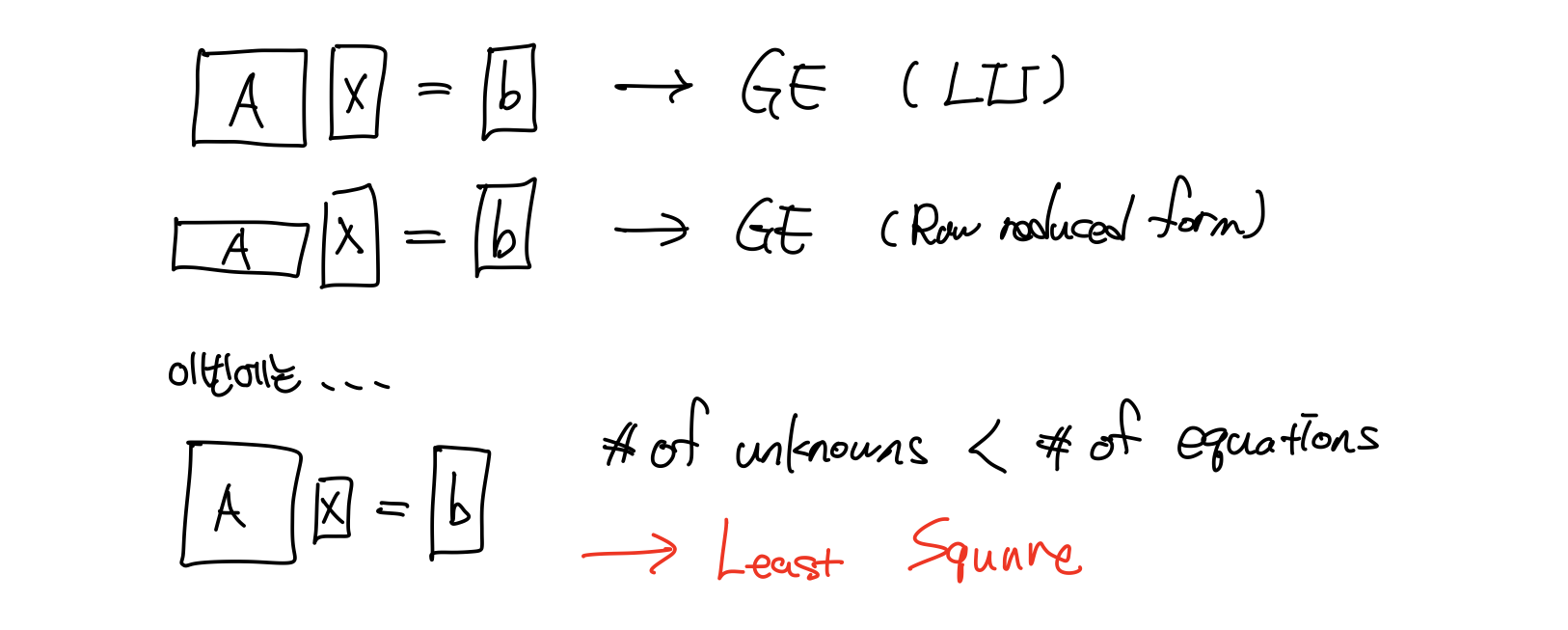

우리는 지금까지 1) 미지수 = 식 2) 미지수 > 식 두 경우에 대해 해를 구하는 방법을 알았다. 이번에는 3) 미지수 < 식 경우를 살펴보자.

이 경우는 사실 등호(Ax=b)가 성립할 수 없다. 즉 solution이 없다. 무한히 많거나, unique 하다 그런게 아니라 진짜 없다. 그러면 오토케? 이렇게 생각해보자

difference에 해당하는 vector의 길이가 minimum이 되도록 해보자. Ax-b는 벡터연산이니 연산결과의 각 element의 quare 합이 될거다. 그래서 이름이 Least Square!!!(두둥!!!)

그런데 말입니다...Projection과는 어떤 연관이 있는걸까요?

Ax는 column vector의 linear combination이다. 즉, 이다.

원점을 포함하는 column space A(C(A))가 있다고 하자. 그러면 Ax는 C(A)에 포함된다. vector b는 등호가 성립하지 않으니 C(A)에 포함되지 않는다. linearly independent한 vector의 linear combination으로 구성된 벡터 를 vector p라고 하자. 이는 C(A)에 있다. b와 의 거리가 minimum하려면 수직, 즉 projection되어야 한다. 그러면 distance가 minimum된다.

그러면 다음이 성립된다.

이전에 어느 vector가 V.S와 수직이 되려면 V.S를 이루는 모든 basis vector와 수직이면 된다고 했다. 따라서 basis vector는 행렬A의 column vector인 와 수직이면 된다. 단, 이때 의 역행렬이 존재해야 위의 식이 성립된다.

Example

행렬A는 x-y plane이라는 V.S를 표현하는 어떤 형식이어도 상관없다. 단, x-y 평면을 표현할 수 있는 linearly independent한 column vector 2개로 구성된 행렬A를 찾아주어야 한다.

3차원 공간 상에 존재하는 어떠한 평면이 있다고 하자.

평면 밖의 어떤 점과 평면 사이의 가장 짧은 거리가 되는 평면 상의 좌표를 구할 때, 평면에 대한 linearly independent vector로 이루어진 행렬A를 찾아야 한다.

위에 임의로 정한 행렬A의 column vector가 linearly independent한지 알아보려면, G.E 적용하고 pivot 수가 2개가 나오는지 보면 된다. 이 행렬을 가지고 projection vector도 구하고 좌표도 구할 수 있다. 단, 평면은 항상 원점을 지나야 한다. 만약 평행이동 되어있다면 원점에 있다고 가정하고 평행이동된 만큼 구한 좌표도 평행이동하면 된다.

이제 Least Square가 어디에 적용되는지 알아보자.

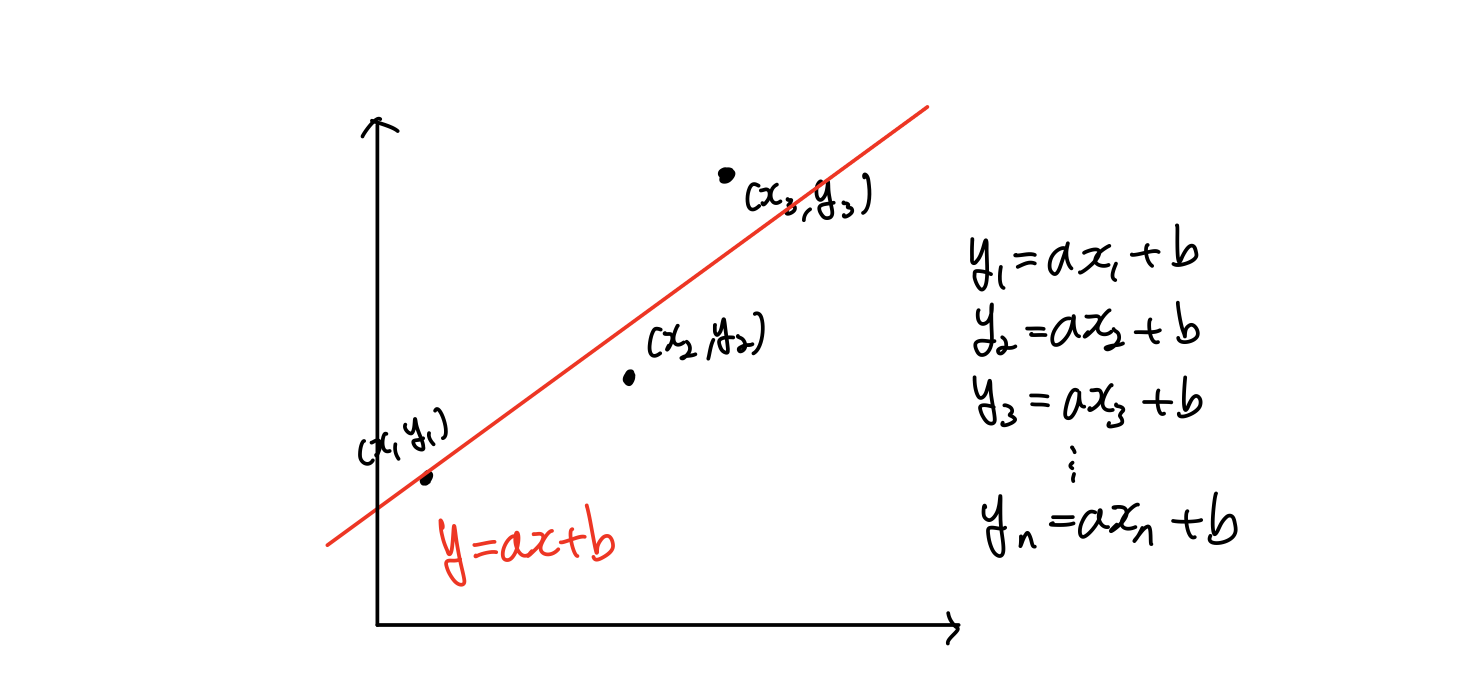

Least Square for line fitting

한 평면 상에 데이터가 주어져있다고 하자. 그 데이터를 하나의 직선으로 근사화(approximation)하려 한다. 직선이기 때문에 기울기 a와 y절편 b만 구하면 된다.

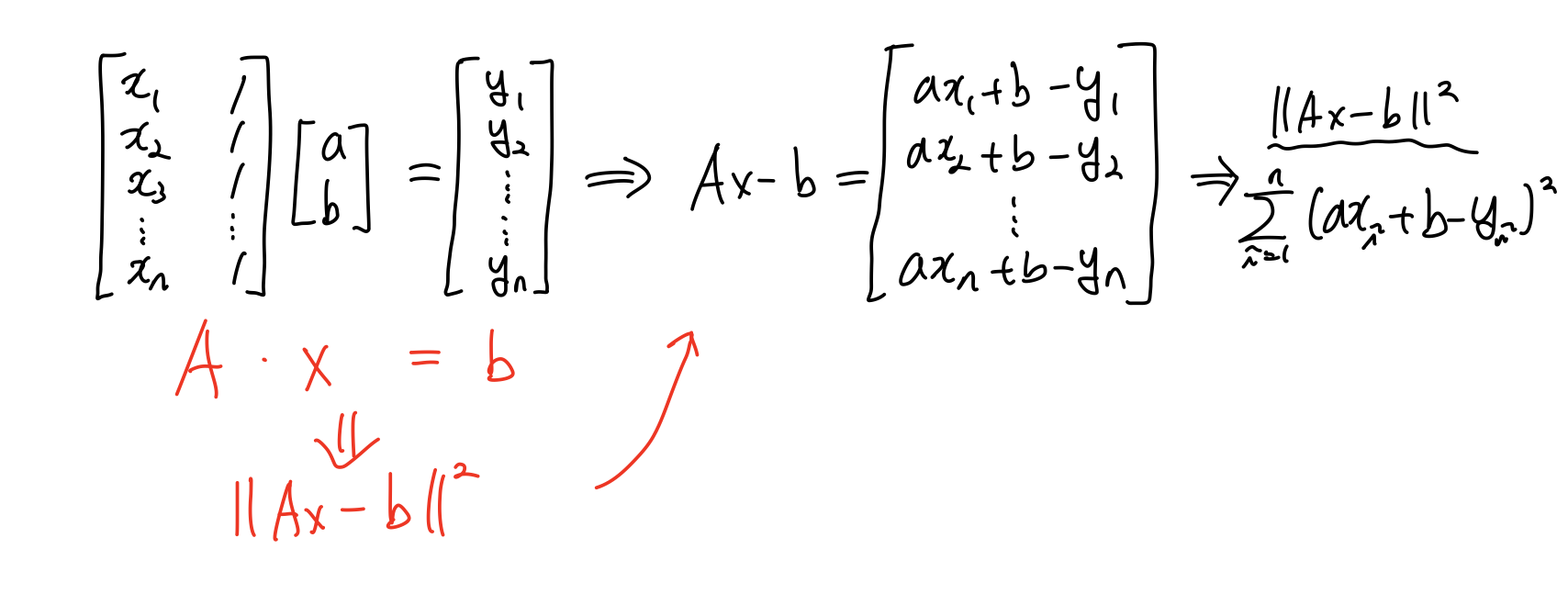

만약 주어진 데이터에 noise도 있고 측정에 error가 존재한다면, 두 점만을 가지고 fitting하는 것은 큰 오류를 범할 수 있다. 따라서 여러 데이터가 필요하지만, 모든 직선을 만족하는 것을 구할 수 없다. 그래서 이를 행렬로 정리하면,

A와 b는 주어진 데이터를 통해 만들어 낼 수 있다. 미지수 x만 구하면 되는 연립방정식이 된다. 미지수보다 식이 더 많은 3번째 케이스 문제가 된다. 이것을 풀기 위해 Least Square가 필요하다.

Ax와 b의 차이를 나타내는 Least Square는 각 데이터와 차이의 제곱의 합이 minimum이 되는 직선을 구한 것이다.

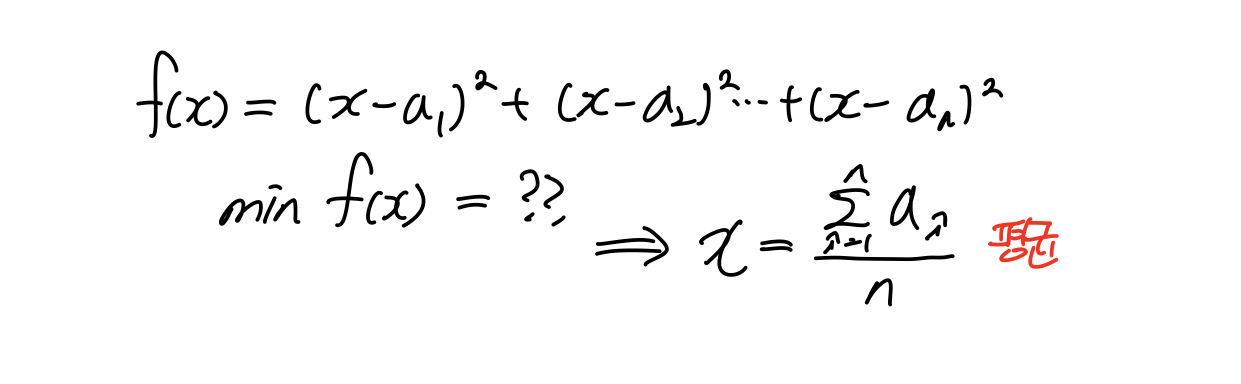

함수 f가 위와 같을 때, 함수 f를 minimum하게 하는 x는 a의 평균이다. 함수f가 각 a와 거리의 제곱의 합이다. 위에서 Least Square에서 본 형태와 같다. minimum에 해당하는 꼭지점의 좌표가 평균인 것이다. 즉, Least Square로 solution을 구하면 우리가 최소한의 갯수로 unique하게 구할 수 있는 solution의 평균값으로 수렴한다.

여러 데이터를 approximation하는 직선은 임의의 두 점을 이은 직선들의 평균으로 수렴한다는 말이다.