신경망 모델 학습 시 모델의 층이 깊어질수록 학습 결과가 좋다.

하지만 층을 또 너무 깊게 쌓아버리면 문제가 생긴다.

멀리서 말하는 사람의 목소리가 잘 안들리듯이, 모델이 깊어질수록 모델의 학습을 위한 gradient가 사라지는 현상이 발생한다.레이어의 가중치가 반복돼서 곱해지는데 1보다 작을때는 0에 가까워지고, 1보다 클 때는 그 값이 기하급수적으로 커지기 때문이다.

이를 Vanishing Gradient & Exploding Gradient라고 한다.

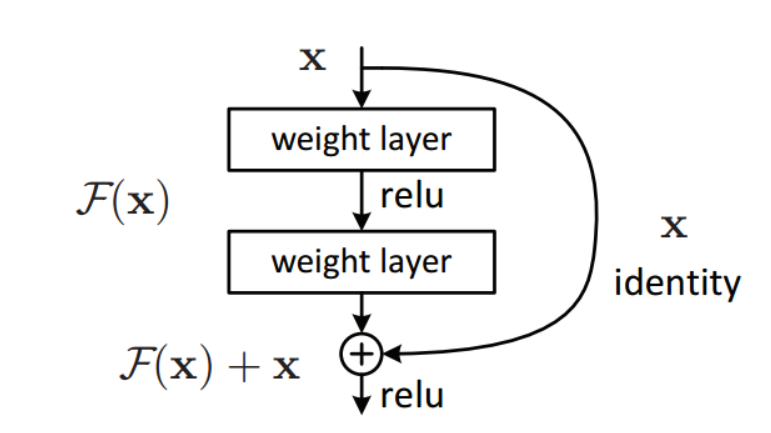

위의 문제를 해결하기위해 skip connection을 적용한다.

skip connection은 이전 층의 정보를 이용하기 위해 이전 층의 정보를 연결한다는 개념이다.

레이어와 skip connection이 있는 블럭을 residual block이라고 한다.

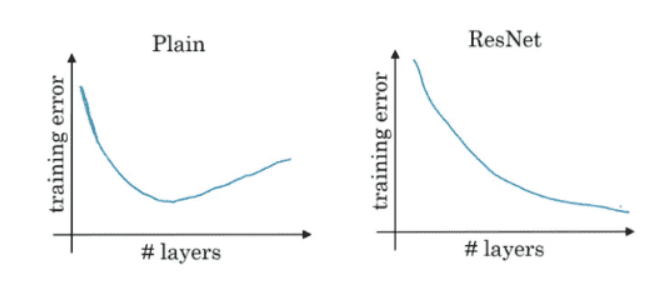

skip connection을 적용하여 레이어를 더욱 깊게 쌓을 수 있다.

plain은 레이어를 쌓을수록 error가 줄어들지만 더욱 깊게 쌓을수록 다시 error가 커지는 것을 볼수있다. 반면에 skip connection을 적용한 ResNet모델의 error는 이상적으로 줄어드는 것을 확인할 수 있다.