- sequence labeling 할 때, 이제는 HMM 안쓴다! RNN으로 다 할 수 있다!

RNNs for POS

- To make a prediction for y, RNNs condition on all input seen through time t

- But knowing something about the future can help -> BiRNN

- BiRNN 을 가지고 POS를 수행한다.

- data 가 최소 10만 개 정도 labeled 되어 있으면 RNN 이 더 강력해진다.

- softmax 를 사용한다.

[참고] - OOV 같은 경우는?

- OOV, unseen, unknown, word embedding 이 없다 ... 다 같은 의미

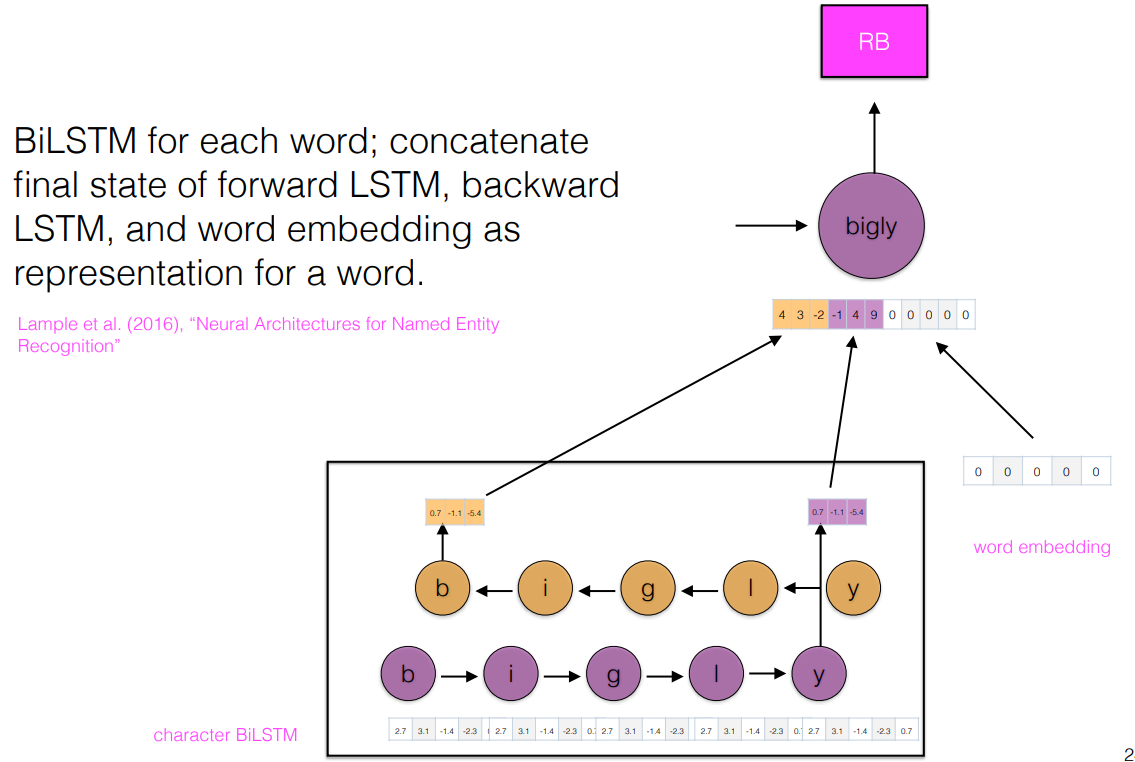

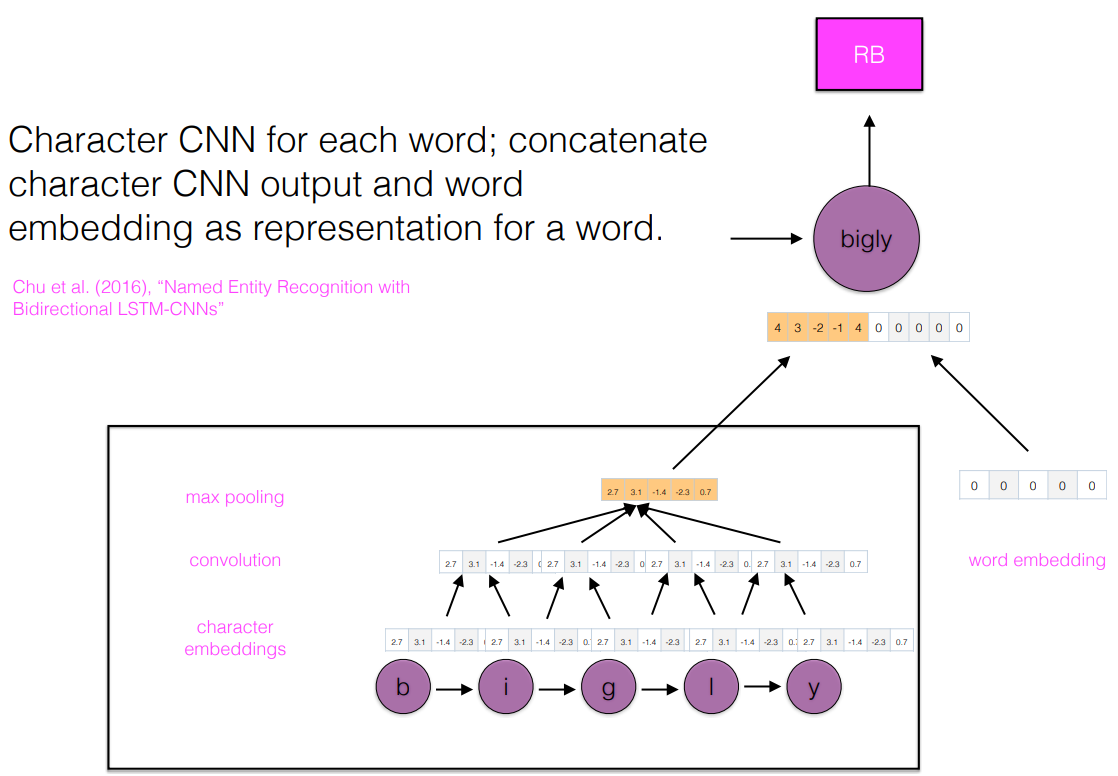

- We saw Subword information used for creationg embedding

- Another alternative is to use standard word embeddings and reason about subword information within a model.

RNNs for POS

-

"amazon and spotify's streaming services are going to devour apple and its music purchasing model

-

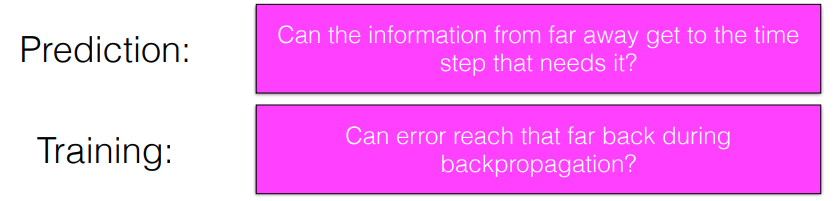

문장에서 멀리 있는 information 이 효과적으로 전달될 수 있나?

-

error 가 다시 맨 앞까지 잘 전달될 수 있나?

-

Recurrent networks are deep in that they involve on layer for each time step -> error 가 모든 곳에 다 전달되어야 한다.

-

Vanishing gradient problem : as error is back propagated through the layers of a deep netword, they tend toward 0. -> layer가 많고 깊을 수록 error 가 0에 수렴 ( 기울기 소멸 문제 )

Long short - term memory network (LSTM)

- RNN 의 변형